Mens vi skrider frem mod den moderne teknologiske verden, skal du behandle automatisering ved hjælp af Kunstig intelligensudvikling og Udvikling af maskinlæring er blevet rygraden i forskellige industrier, da den lover effektivitet, hastighed og omkostningseffektivitet. På den anden side er automatiseringsbias blevet en betydelig bekymring. Dette bør være en bekymring, for da virksomheder og organisationer fortsat vedtager procesautomatisering, er mange uvidende om de potentielle konsekvenser, som disse automatiserede systemer kan have på retfærdighed og lighed.

Selvom automatisering bringer effektivitet og bekvemmelighed, kan den også indføre subtile, men alligevel magtfulde partier, der foreviger forskelsbehandling og ulighed. At forstå dynamikken i automatiseringsbias er afgørende for at tackle disse problemer og skabe systemer, der fremmer retfærdighed for alle.

Vil du opdage, hvordan man opretter objektivt automatiserede systemer med etisk AI?

Hvad er automatiseringsbias?

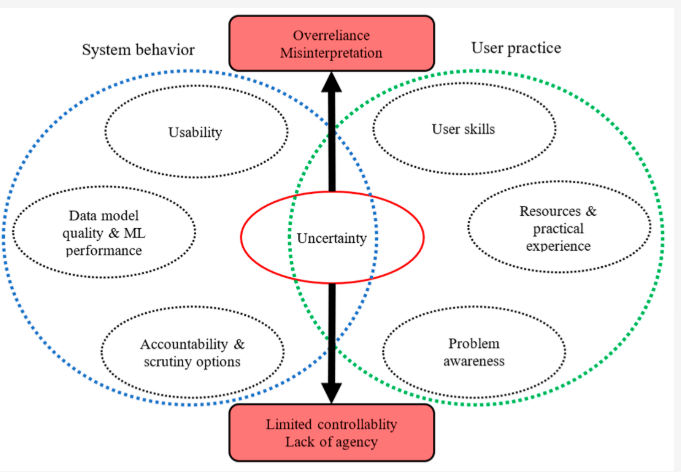

Automationsbias henviser til menneskers tendens til at overrige automatiserede systemer, forudsat at deres beslutninger er korrekte uden at stille spørgsmålstegn ved dem. I en verden, hvor maskiner ofte ses som ufejlbarlig, kan denne tillid føre til skadelige konsekvenser.

I praksis betyder automatiseringsbias, at mennesker kan ignorere deres egne vurderinger og stole på beslutninger truffet af et automatiseret system, selv når disse systemer er mangelfulde eller partiske. I ansættelsesprocesser er mange virksomheder i stigende grad afhængige af automatiserede systemer til at screene genoptage eller evaluere kandidater. Disse systemer, selvom de er effektive, kan forevige forspændinger, hvis de trænes i partiske data.

Kilde: MDPI om rapportering af avanceret ML og data mining

Som et resultat kan ansøgere fra underrepræsenterede grupper blive uretfærdigt screenet, selvom deres kvalifikationer er lig med eller overlegen andre. Dette er et klart eksempel på, hvordan automatiseringsbias direkte kan bidrage til ulighed.

Hvordan procesautomation kan forstærke forskelsbehandling

Mens procesautomation Kan strømline operationer og forbedre effektiviteten, det kan også forstærke algoritmisk bias, hvis det ikke håndteres omhyggeligt. Algoritmisk bias henviser til den systematiske favoritisme eller forskelsbehandling, der er forbundet med automatiserede systemer. Hvis de data, der bruges til at træne disse algoritmer, indeholder forspændinger-såsom køn, race eller socioøkonomiske partier-vil det automatiserede system sandsynligvis arve og endda forstærke disse partier.

Konsekvenserne af automatiseringsbias er vidtrækkende og kan have alvorlige konsekvenser for enkeltpersoner og samfund som helhed. Det kan føre til:

- Nedsatte muligheder: Partiske algoritmer kan begrænse adgangen til beskæftigelse, uddannelse og finansielle tjenester for visse grupper.

- Forstærkning af stereotyper: Automatiske systemer, der foreviger stereotyper, kan yderligere marginalisere allerede dårligt stillede samfund.

- Erosion af tillid: Når folk bliver opmærksomme på potentialet for bias i automatiserede systemer, kan det føre til et tab af tillid til institutioner og teknologi.

Overvej, hvordan AI og ulighed krydser hinanden i den virkelige verden scenarier. I det strafferetlige system bruges forudsigelige algoritmer til at vurdere sandsynligheden for gengældelse. Men hvis de data, disse algoritmer er afhængige af, afspejler historiske partier, såsom uforholdsmæssigt højere arrestationshastigheder i visse samfund, kan AI -bias i disse systemer resultere i urimelige resultater, såsom længere domme for minoriteter. Dette er et skarpt eksempel på, hvordan automatiseringsbias kan forevige samfundsmæssige uligheder.

Tilsvarende i sundhedsvæsenet kan procesautomation have utilsigtede konsekvenser. Hvis en algoritme trænes i data, der overreererer visse demografier, mens de underrepræsenterer andre, kan systemet muligvis gøre unøjagtige forudsigelser eller anbefalinger. Dette kan føre til uoverensstemmelser i medicinsk behandling, hvor marginaliserede grupper får underordnet behandling eller ikke diagnosticeres rettidigt.

Nogle kendte tilfælde af AI -algoritme forspændes

det er sandt, at det, der udelukkende er afhængig af AI, undertiden kan føre til urimelige resultater. Her er En rapport offentliggjort af Greenlining Institute Det viser et par eksempler på, hvordan algoritmer har været partiske i forskellige situationer:

Regeringsprogrammer:

- Michigan’s arbejdsløshedssystem: Michigan brugte en algoritme til at opdage svig i arbejdsløshedskrav. Desværre beskyldte systemet forkert tusinder af mennesker, hvilket førte til bøder, konkurser og endda afskærmninger. Det viste sig, at algoritmen ofte begik fejl, og der var ingen til at dobbeltkontrol af dens beslutninger.

- Arkansas Medicaid: En algoritme blev brugt til at bestemme, hvem der kvalificerede sig til Medicaid -fordele i Arkansas. Dette resulterede i, at mange mennesker mistede adgangen til væsentlig medicinsk behandling. Problemet? Algoritmen havde fejl, og det var meget vanskeligt for folk at appellere dens beslutninger.

Beskæftigelse:

- Amazons ansættelsesværktøj: Amazon forsøgte at oprette en algoritme for at hjælpe dem med at ansætte de bedste medarbejdere. Algoritmen endte imidlertid med at favorisere mænd frem for kvinder. Det ser ud til, at algoritmen læres af tidligere ansættelsesdata, som kan have indeholdt forudindtægter.

Sundhedspleje:

- Ulig behandling: Selv når algoritmer er designet til at være retfærdige, kan de bruges på måder, der skaber bias. For eksempel brugte et hospital en algoritme til at beslutte, hvilke patienter der havde brug for ekstra pleje. Desværre betød den måde, de brugte, at sorte patienter måtte være meget sygere end hvide patienter for at få det samme niveau af opmærksomhed.

Undervisning:

- Bedømmelsesbias i Storbritannien: Under pandemien brugte skoler i Storbritannien en algoritme til at give studerende karakterer, når eksamener blev annulleret. Algoritmen endte dog med at give lavere karakterer til studerende fra familier med lavere indkomst, hvilket viser, hvordan algoritmer undertiden kan styrke eksisterende uligheder.

Boliger:

- Urimelig screening: Mange udlejere bruger algoritmer til at screene potentielle lejere. En sådan algoritme forhindrede uretfærdigt en mor i at leje en lejlighed, fordi hendes søn havde en mindre overtrædelse af hans rekord, der senere blev afvist.

- Desinvestering i Detroit: En algoritme blev brugt i Detroit til at beslutte, hvilke kvarterer der skulle modtage investeringer og forbedringer. Dette resulterede i overvejende sorte og fattige kvarterer blev nægtet ressourcer, hvilket viser, hvordan algoritmer kan forværre eksisterende sociale problemer.

Disse eksempler viser, at selvom algoritmer kan være kraftfulde værktøjer, skal de være omhyggeligt designet og brugt ansvarligt for at undgå urimelighed og forskelsbehandling. Vi er nødt til at sikre, at algoritmer bruges til at fremme retfærdighed og lighed, ikke forevige eksisterende forudindtægter.

At tackle automatiseringsbias og algoritmisk bias

Adressering af automatiseringsbias og dens potentiale til at forevige algoritmisk bias kræver en mangesidet tilgang. For det første er det vigtigt at sikre, at de data, der bruges til at træne algoritmer, er forskellige og repræsentative for alle demografiske grupper. Uden forskellige data risikerer algoritmer at forstærke eksisterende partier snarere end at tackle dem.

For det andet skal gennemsigtighed og ansvarlighed indbygges i AI og automatiseringssystemer. Udviklere skal være klar over, hvordan disse systemer fungerer og være åbne for kontrol. Regelmæssige revisioner af algoritmer kan hjælpe med at identificere områder, hvor bias kan være til stede, og korrigerende foranstaltninger kan implementeres, før disse partier har skadelige virkninger.

Endelig kan AI og ulighed minimeres ved at fremme retfærdighed og inklusivitet i hele design- og implementeringsfaserne. Ved at integrere etisk AI -praksis kan virksomheder sikre, at deres procesautomatiseringsløsninger ikke kun er effektive, men også retfærdige og retfærdige.

Identificer og adresser automatiseringsbias i dine processer med vores ekspertvejledning

WeblineIndias rolle i adressering af automatiseringsbias

For virksomheder, der ønsker at udnytte kraften i procesautomatisering, samtidig med at de sikrer retfærdighed, gennemsigtighed og etisk ansvar, skiller WebLineindia sig ud som en betroet partner med sin Relyshore -model af outsourcing. Som eksperter i at integrere avanceret teknologi med etiske overvejelser, udmærker WebLineindia sig med at tackle udfordringerne ved automatiseringsbias. De er forpligtet til at skabe AI-drevne løsninger, der minimerer algoritmisk bias og fremmer AI og ulighedsbevidsthed.

WeblineIndias tilgang er unik, idet den afbalancerer fordelene ved automatisering med fokus på algoritmeetik, hvilket sikrer, at teknologien bruges ansvarligt og ikke foreviger forskelsbehandling. Uanset om det udvikler tilpasset software, implementering Procesautomatiseringsløsninger, eller rådgivning om AI -biasbegrænsende strategier, prioriterer WebLineindias team kvalitet, retfærdighed og socialt ansvar.

Klar til at bygge uvildige softwareløsninger drevet af AI?

Vælg WebLineindia, og vi kan være forvisset om, at du samarbejder med en tjenesteudbyder, der ikke kun forstår de tekniske vanskeligheder ved AI, men også prioriterer etiske overvejelser. Sammen kan vi opbygge en fremtid, hvor teknologi fungerer for alle, ikke imod dem.

Afslutningsvis, mens Process Automation tilbyder et enormt potentiale, er det vigtigt at være opmærksom på de risici, som automatiseringsbias udgør, som WebLineindia tager sig af. Vi kan sikre, at AI og automatiseringssystemer er værktøjer til gode, fremme af retfærdighed, inklusivitet og lighed på alle områder af livet ved at forstå, hvordan algoritmisk bias fungerer og tage skridt til at tackle det. Kontakt os Og vi hjælper dig med at navigere i denne udfordring og skabe løsninger, der opretholder de højeste standarder for etisk ansvar.

Sociale hashtags

#AutomationBias #ethicalai #biasintech #stopalgoritmicdiscrimination #ai #automation #aiautomation #softwaresolutions

Vil du bygge inkluderende og fair AI-drevne løsninger til din virksomhed?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.