Fitness-sporingsapps har udviklet sig langt ud over enkle trin-tællere eller GPS-baserede aktivitetslogfiler. Dagens brugere forventer rig social interaktivitet, konkurrencedygtig gamification, realtidsdatasynkronisering og problemfri integration med et voksende økosystem af bærbare og sundhedsplatforme. Strava satte et benchmark i dette rum ved at fusionere atletisk aktivitetssporing med socialt engagement – leaderboards, udfordringer, kommentarer, klubber og endda virtuelle løb – alt sammen indpakket i en glat UX, der prioriterer både performance og samfund. At designe et system som dette går langt ud over grundlæggende CRUD -operationer på brugervræning. Det kræver en robust arkitektur, der kan håndtere:

- Højfrekvent geo-placeringsopdateringer fra millioner af samtidige brugere

- Generering af realtidsfremstilling og aktivitet Broadcasting til efterfølgende netværk

- Skalerbar, lav-latens-sociale grafforespørgsler

- Medieopbevaring og hentning (f.eks. Rutekort, fotos, badges)

- Begivenhedsdrevne datarørledninger til computersegmenter, leaderboards og udfordringer

- Sikkerheds- og privatlivskontrol på tværs af komplekse præferencer om deling af data

Udfordringen er at arkitektere en backend, der understøtter en hurtig, engagerende og socialt rig oplevelse, mens den forbliver fleksibel nok til at integrere med tredjeparts fitnessenheder, støtte samfundsmoderation og udvikle nye funktioner uden at bryde gamle.

Denne tekniske dybe dyk nedbryder arkitekturen i et sådant system. Det skitserer kernekravene, design til skalerbarhed og realtidsreaktion, datamodeller for brugergenereret indhold og infrastrukturmønstre til understøttelse af en social fitness-platform, der kan vokse til millioner af brugere uden nedbrydende ydelse eller pålidelighed.

Systemkrav

1. funktionelle krav

Fitness -appens kernefunktionaliteter skal understøtte både aktivitetssporing og socialt engagement i skala. De vigtigste funktionelle krav inkluderer:

- Brugerstyring: Tilmelding, godkendelse, profilredigering og kontoudvinding.

- Aktivitetsoptagelse: Log GPS-baserede træning (f.eks. Kører, forlystelser), understøtter manuel indgang og fanger metadata som afstand, tempo, højde, hjerterytme og gear anvendt.

- Data-synkronisering i realtid: Stream placering og sensordata fra mobile eller bærbare enheder med lav latenstid.

- Social graf: Følg/følg mekanismer, forslag til ven og privatlivets kontrol af aktivitetsstyret (f.eks. Privat, kun tilhængere, offentlig).

- Aktivitetsfeed: Dynamisk tidslinje, der viser træning fra fulgte brugere, herunder likes, kommentarer og genskaber.

- Udfordringer og leaderboards: Opret tidsboksede konkurrencer (f.eks. “Ride 100 km på 7 dage”), spordsegmentlederboards og beregne placeringer asynkront.

- Medier support: Upload og se fotos, rutevarmekort og personlige resultater (f.eks. Badges, milepæle).

- Underretninger: Real-time push og in-app-meddelelser om likes, kommentarer, nye tilhængere og udfordringsopdateringer.

- 3rd-parti integration: Synkronisering med Apple Health, Google Fit, Garmin og andre fitness -økosystemer.

2. ikke-funktionelle krav

For at understøtte interaktion i realtid og voksende brugerbaser, skal systemet opfylde strenge ikke-funktionelle krav:

- Skalerbarhed: Horisontalt skalerbare tjenester og datalagre til at håndtere millioner af aktive brugere og terabyte af geotemporale data.

- Lav latenstid: Responstid for sub-sekund for sociale interaktioner og gengivelse i realtid.

- Tilgængelighed: 99,9%+ oppetid med fejltolerance på tværs af regioner og zoner.

- Sikkerhed og privatliv: OAuth2-baseret autentificering, granulær adgangskontrol, krypteret opbevaring og brugerstyrede delingsindstillinger.

- Udvidelighed: Modulære servicegrænser til støtte for fremtidige funktioner som virtuelle løb, klubbaserede chats eller live coaching.

- Datakonsistens: Eventuel konsistens er acceptabel i feeds og leaderboards, men stærk konsistens er påkrævet til transaktioner som kontoindstillinger eller premiumkøb.

- Offline support: Tillad brugere at registrere og stå i kø aktiviteter, når de er offline, med automatisk synkronisering ved genforbindelse.

3. begrænsninger og antagelser

- Mobile apps (iOS og Android) vil være de primære klienter; Webgrænseflade er sekundær.

- Placerings- og sundhedsdata skal behandles i henhold til regionale overholdelsesregler (f.eks. GDPR, HIPAA, hvor det er relevant).

- Størstedelen af brugere synkroniserer 1–2 aktiviteter pr. Dag, men strømbrugere og integrationer kan øge indtagelsesgraden under begivenheder eller udfordringsperioder.

- Cloud-indfødte implementering; Arkitekturen antager brug af administrerede skytjenester til beregning, opbevaring og streaming.

Brug sag / scenarie

1. forretningskontekst

Fitness -appen er rettet mod en bred demografisk – fra afslappede vandrere til konkurrencedygtige cyklister – men understreger samfundsengagement over individuel sporing. Tænk på det som en hybrid mellem en personlig træner og et socialt netværk. Målet er at drive tilbagevendende brug gennem konkurrence, social ansvarlighed og gamified fremskridt, hvilket i sidste ende øger tilbageholdelses- og abonnementskonvertering.

Genmonetisering af appen kan omfatte:

- Premium -abonnementer til avanceret analyse, live segmenter og dybere træningsindsigt

- Brandede udfordringer eller sponsorerede konkurrencer

- Gear Promotion in-App (f.eks. Tilknyttet markedsplads for sko, cykler, wearables)

Appen skal derfor muliggøre et robust fundament for realtidspræstationsmetrics, mens den også leverer engagerende, socialt dynamiske oplevelser, som brugerne vender tilbage til dagligt-selvom de ikke træner den dag.

2. Personas & brugsmønstre

- Solo -atleter: Brugere, der sporer deres træning, sammenligner tidligere præstationer og tilslutter sig lejlighedsvis globale udfordringer eller segmenter.

- Sociale entusiaster: Meget engagerede brugere, der ofte poster, kommenterer venners aktiviteter og trives med samfundsinteraktion.

- Klubledere: Strømbrugere, der koordinerer gruppebegivenheder, administrerer private leaderboards og moderate sociale rum inden for klubber.

- Data nerder: Premium-abonnenter, der er interesseret i hjertefrekvenszoner, strømkurver, gendannelsesmetrics og dataeksport.

3. forventet skala

Systemet skal være designet til at understøtte:

- 10m+ registrerede brugere

- 2–3 m Maus (månedlige aktive brugere) med ~ 500k daus (daglige aktive brugere)

- 10m+ aktivitet uploader pr. Måned med toppe i weekenderne og store udfordringsbegivenheder

- 500k+ samtidige brugere i spidsbelastede perioder

- Milliarder datapunkter pr. Måned på tværs af GPS, højde, hjerterytme og bevægelsessensorer

- Millioner af daglige foderforespørgsler, sociale interaktioner og meddelelser i realtid

For at imødekomme disse krav skal arkitekturen optimere til læsetunge sociale arbejdsbelastninger, bursty indtagende trafik fra uploads af aktiviteter og asynkron behandling med høj kapacitet til opdateringer af segment og leaderboardopdateringer.

Brug for hjælp til at designe din egen kondition eller social app?

At opbygge en social-første fitnessplatform, der skalerer til millioner af brugere, tager mere end ren kode-det tager den rigtige arkitektur fra første dag.

Vil du have ekspertvejledning til design til ydeevne, synkronisering i realtid og brugerengagement i skala?

Arkitektur på højt niveau

Arkitekturen skal effektivt understøtte indtagelse af realtidsaktivitet, social foderfordeling, geospatial analyse og brugerinteraktion-alt sammen i skala. Dette kræver en modulær, serviceorienteret tilgang med veldefinerede grænser mellem kernesystemer som aktivitetssporing, brugerstyring, social grafbehandling og anmeldelse.

1. Komponentoversigt

Systemet er struktureret omkring følgende hovedkomponenter:

- API Gateway: Det centrale indgangspunkt for al klientkommunikation. Håndterer godkendelse, hastighedsbegrænsende og ruter trafik til interne tjenester.

- Auth Service: Administrerer OAuth2-flow, token-udstedelse, sessionstyring og integration med tredjepartsidentitetsudbydere (f.eks. Apple, Google).

- Brugerprofil Service: Butikker personlig info, præferencer, gear og privatlivsindstillinger.

- Aktivitetstjeneste: Håndterer GPS-baseret træningsindtagelse, rute-parsing, aktivitetsvalidering og metadata-ekstraktion (f.eks. Pace, Elevation Gain).

- Foderservice: Genererer og gemmer aktivitetsfeeds, behandler sociale grafopdateringer og håndterer fan-out til nye aktivitetsindlæg.

- Social Graph service: Håndterer følgerforhold og beregner synlighed for aktiviteter og udfordringer.

- Udfordring & Leaderboard Engine: Beregner placeringer, håndterer udfordringslogik og opdaterer virtuelle trofæer og segmenter.

- Mediaservice: Håndterer billed uploads (fotos, rutekort), CDN -cache og adgangskontrol.

- Underretningstjeneste: Udgiver realtids- og batch-meddelelser via WebSockets, FCM/APN’er eller In-App-indbakker.

- Analytics Pipeline: Processer aktivitetsstrømme til indsigt, trenddetektion og atletanbefalinger.

- Admin & moderationsportal: Værktøjer til styring af misbrugsrapporter, udfordringsoprettelse og analyse dashboards.

2. Arkitekturdiagram på højt niveau

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Data Flow Summary

Når en bruger starter en træning:

- Mobilappen streamer GPS og sensordata via en WebSocket eller batchet API upload til Aktivitetstjeneste.

- Tjenesten analyserer dataene, gemmer træningen og udsender en begivenhed til Fodergenerator.

- De Social Graph Service Bestemmer, hvem der kan se aktiviteten.

- Tilførselselementet gemmes og skubbes til relevante brugere via Underretningstjeneste.

- Hvis relevant, evalueres aktiviteten af LEADBOARD MOTOR For udfordringsberettigelse og rangering af opdateringer.

- Fotos og rutevisualiseringer sendes til Mediaservice og cache gennem en CDN.

Denne modulære design understøtter både vandret skala og isoleret serviceudvikling. Det muliggør også fan-out realtid for feeds og meddelelser ved hjælp af begivenhedsdrevet kommunikation (f.eks. Kafka eller NATS).

Databasedesign

1. kernedatamodeller og ERD -oversigt

Systemet bruger en polyglot-persistens-tilgang-relationelle databaser til transaktionsintegritet, tidsserie/NOSQL til aktivitetsdata og graf- eller hukommelsesbutikker til højtydende sociale forespørgsler.

Primære enheder:

- Bruger: Profilinfo, autorisationsindstillinger, præferencer, abonnementsniveau

- Aktivitet: Træningsdata inklusive GPS -point, målinger, gear, medier

- Følge: Følger-efterfølgende forhold og synlighedsregler

- FeedItem: Renderable begivenheder bundet til brugere (f.eks. Sendt aktivitet, kommentar, badge)

- Udfordring: Metadata og stat for gruppekonkurrencer

- LeaderBoardEntry: Udfordring eller segmentposition og målinger

Enhedsforholdsdiagram (konceptuel):

[Bruger]

├── id (PK)

├── navn, e-mail, avatar_url

└── settings_json

[Aktivitet]

├── id (PK)

├── bruger-id (FK → Bruger)

├── type, start_tid, varighed

├── afstand, højde, gns._hr

├── geo_data_ref (FK → GeoStore)

└── synlighed (offentlig / følgere / privat)

[GeoStore] (eksternt lagerindeks eller S3 ref)

├── id (PK)

├── aktivitets-id (FK → Aktivitet)

└── gps_data (array eller filmarkør)

[Følge]

├── follower_id (FK → Bruger)

├── followee_id (FK → Bruger)

└── oprettet_kl

[FeedItem]

├── id (PK)

├── skuespiller-id (FK → Bruger)

├── verbum ("posted", "kommenterede", "synes godt om")

├── objekt-id (f.eks. aktivitets-id, kommentar-id)

└── target_user_id (FK → Bruger)

[Udfordring]

├── id (PK)

├── navn, beskrivelse, type

├── startdato, slutdato

└── synlighed, regel_json

[LeaderboardEntry]

├── id (PK)

├── challenge_id (FK → Challenge)

├── bruger-id (FK → Bruger)

├── metrisk_værdi (afstand, varighed)

└── rang

2. valg af databaseteknologi

Hvert datadomæne er optimeret til sit eget adgangsmønster:

- PostgreSQL: Kanonisk datakilde til brugerprofiler, aktiviteter, fodermetadata og udfordringer. Fremragende til transaktionsintegritet og udenlandsk nøglehåndhævelse.

- Timescaledb / tilstrømning: Til GPS-punktindtagelse, aktivitetstelemetri og tidsserieanalyse (f.eks. Tempo over tid, HR-zoner).

- S3 + CD: Bruges til opbevaring af rå GPS-spor, rutebilleder og uploadede medier (med sikker for-underskrevet URL-adgang).

- Redis / Memcached: Til hurtig hentning af leaderboards, nylige aktiviteter og forudgående foderdata.

- Neo4j eller dgraph (valgfrit): For komplekse sociale graf gennemgås, klubmedlemskab og gensidige efterfølgerforslag i skala.

3. Multi-Tenancy & Partitioning Strategi

- Sharding: Aktiviteter og foderartikler er afskåret af bruger -ID eller region -ID for at muliggøre vandret skalering på tværs af partitioner.

- Tidsbaseret opdeling: GPS -telemetri og leaderboards er opdelt i månedlige/ugentlige partitioner til aldring og ydeevne.

- Blød multi-tenans: Klubber eller organisationer (f.eks. Kørsel af grupper, cykelteam) opererer inden for det globale navneområde, men kan få scoped forespørgsler (via Tenant_ID), når det er nødvendigt.

4. Replikation og høj tilgængelighed

- PostgreSQL: Implementeret med Hot Standby Replicas og Wal Shipping for Failover.

- Redis: Konfigureret med Sentinel til høj tilgængelighed og automatiseret mastervalg.

- Media & Geostore: Objektlagring replikeres på tværs af regioner og leveres gennem en global CDN for adgang til lav latens.

Denne databasedesign sikrer fleksibel skemaudvikling, hurtig aktivitetsindtagelse og skalerbar support til social arbejdsbelastning og analyse – alt sammen med at bevare referencemæssig integritet, hvor det betyder mest.

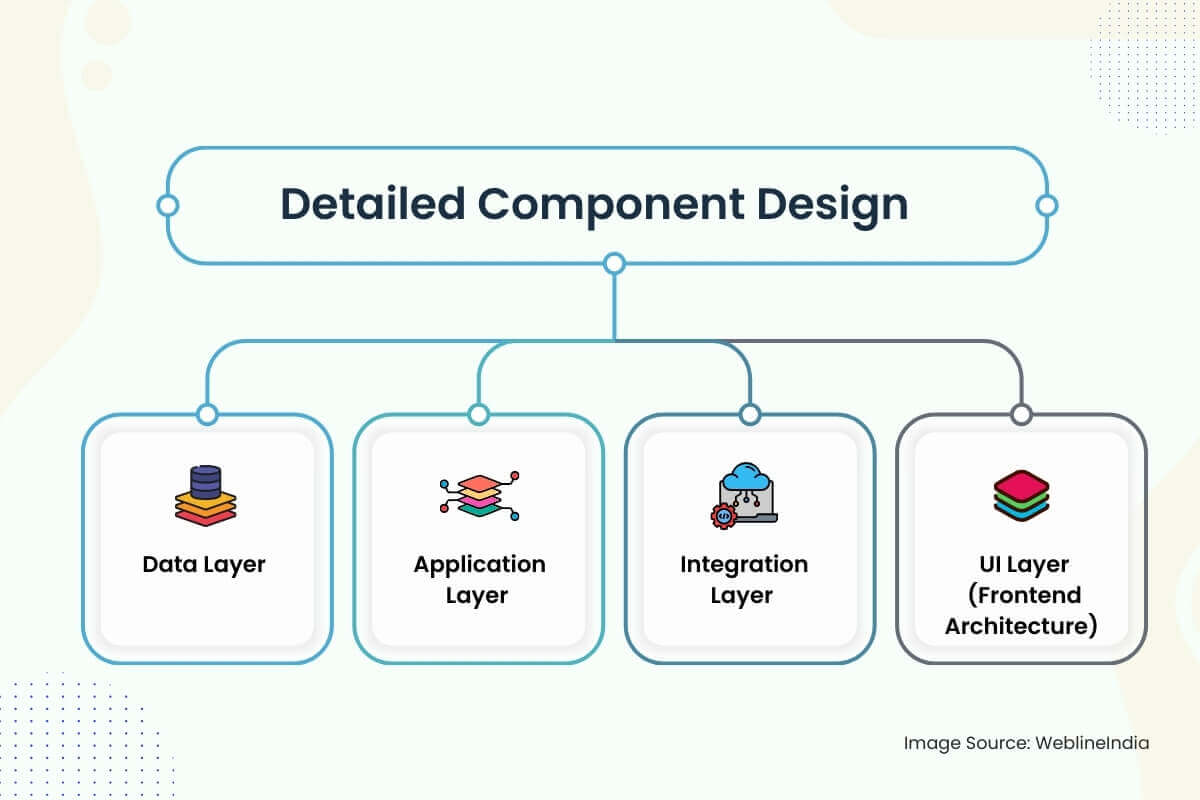

Detaljeret komponentdesign

1. datalag

- Skema Strategi: Skemaer er designet omkring klare domænegrænser: brugere, aktiviteter, feeds, sociale grafer og udfordringer. Kolonner som ‘Synlighed’, ‘Status’ og ‘Activity_Type’ bruger opregne typer til indekseringseffektivitet. UUID’er foretrækkes frem for autoinkrementerede heltal for at undgå varme nøgleproblemer i distribuerede butikker.

- Datatilgang: Adgang til kernedata gennemgår tynde servicelayer-lagre, der håndhæver adgangskontrolpolitikker (f.eks. Synlighedskontrol af aktiviteter). Læsningsoperationer er optimeret via materialiserede synspunkter og forudbestemte feed-snapshots. Skriv-tunge stier som aktivitet Indtagelse Brug skrivemæssige køer og bulkindsatsrørledninger til glatte indtagelsesspidser.

- Validering: Indgangsvalidering forekommer på flere niveauer-håndhævelse af kantskemaer via OpenAPI eller GraphQL, dyb validering i servicelag (f.eks. Gyldige GPS-point, ikke-overlappende tidsstempler) og asynkron sundhedskontrol af telemetri-data via baggrundsjob.

2. applikationslag

Servicedesign: Hvert større domæne (bruger, aktivitet, foder, anmeldelse, social graf) implementeres som en isoleret mikroservice. Tjenester udsætter både GRPC og REST-endepunkter-hvile for offentlige API’er, GRPC for kommunikation mellem tjenester. Rene arkitekturprincipper Separat domænelogik fra transport og infrastrukturkode.

Rammer:

- Gå eller rust til præstationskritiske tjenester (aktivitet, foder, leaderboard)

- Node.js eller Python for limkode, integrationer og async -arbejdsgange

- GraphQL Server (Apollo eller Hasura) til front-end aggregering og erklærende forespørgsel

Autentificering: JWT -tokens udstedes via OAuth2 -strømme. Service-til-service-opkald Brug underskrevne interne tokens med rollebaserede scopes.

Bedømmelsesbegrænsning og kvoter: Implementeret via Redis-støttede token-spande ved gateway- og brugerniveau-granularitet (især til aktivitets uploads).

3. Integrationslag

Meddelelseshaler: Kafka eller Nats bruges til async-arbejdsgange-aktivitetsbehandling, feed-fan-out, segment matching og meddelelsesudgivelse. Idempotente håndterere med stærke leveringsgarantier bruges til at forhindre duplikatposter eller leaderboard -poster.

Tredjepartssynkronisering: OAuth -integrationer med Garmin, Fitbit, Apple Health osv. Kør via en baggrund Poller + Webhook Combo. Nye data står i kø og behandles via aktivitetsindtagelsesrørledningen.

Begivenhedstyper:

Aktivitet. Oprettet→ Fan-out for at fodre service, underret tilhængereChallenge.joined→ Kontroller støtteberettigelse, Trigger Leaderboard Insertuser.followed→ Opdateringsgraf, opdateringsfoder, enqueue Velkommen meddelelse

4. UI -lag (frontend -arkitektur)

App Stack: React Native for Cross-Platform Mobile Apps, med TypeScript og Redux Toolkit til statsstyring. Web App bruger Next.js til SSR/ISR med Tailwind Utility Styling og GraphQL -forespørgsler til backend.

Sikkerhedsmæssige bekymringer:

- Klienthemmeligheder er aldrig indlejret – OAuth Pkce Flow er obligatorisk

- Alle API-opkald kræver underskrevne tokens, og offentlige vendte slutpunkter filtreres efter hastighed, oprindelse og rolle

- Geo -data er sandkasse pr. Synlighedsindstilling – private aktiviteter er udelukket fra heatmaps, feeds og segmentberegninger

Funktioner i realtid: WebSockets eller SSE bruges til at skubbe meddelelser, udfordringsstatus og feedopdateringer. Fallback til lang polling på begrænsede netværk. Frontend opretholder en lokal SQLite -cache til offline aktivitetslogging.

Arkitektering af noget lignende?

At designe realtid, geo-opmærksomme, socialt interaktive platforme tager præcision på tværs af dataflow, håndtering af begivenheder og mobil arkitektur.

Hvis du bygger noget ambitiøst-som en social fitness-platform, bærbar integration eller realtidsfoder-vil vi meget gerne hjælpe dig med at få det lige fra starten.

Overvejelser om skalerbarhed

1. applikationslagskalering

- Statløse tjenester: Alle kernetjenester (aktivitet, foder, udfordring osv.) Er statsløse og vandret skalerbare. Hver instans er engangs og frontet af en belastningsbalancer. Delt-intet principper sikrer, at forekomster ikke er afhængige af lokal stat.

- Auto-skalering: K8S-baserede vandrette POD-autoskalering (HPA) bruges til tjenester baseret på CPU, hukommelses- og kødybde. For latensfølsomme tjenester (som foder eller anmeldelse) kan brugerdefinerede målinger (f.eks. Begivenhedsforsinkelse) udløse hurtigere skala-outs.

- API Gateway throttling: Klient- og IP-baserede hastighedsgrænser forhindrer API-oversvømmelser. Burst-tolerance understøttes ved hjælp af Redis-støttet skydespil eller lækkende spandalgoritmer.

2. Datagagsskalering

Læs optimering: Ofte tilgængelige data (f.eks. Nylige aktiviteter, leaderboard -snapshots) er cache aggressivt i REDIS med TTLS og LRU -udsættelse. PostgreSQL -læst replikaer skaleres baseret på trafik til at aflaste analyse og UI -forespørgsler.

Sharding Strategies:

- Aktivitetsdata: Sharded af bruger -ID på tværs af partitioner eller logiske klynger (f.eks. Activity_01, Activity_02, …)

- Foderemner: Opdelt af skuespiller -ID og modtager -ID med sammensatte indekser til hurtige opslag

- Geostore: Bruger S3-nøglepræfiksering efter region og tidsstempel til optimeret objektliste og omkostningseffektiv leje

3. Feed og Social Graph Fan-Out

Fodergenerering er en vigtig skalerbarhedsudfordring i sociale platforme. Systemet bruger en hybrid fan-out-tilgang:

- Fan-out-on-write (primær): Når en bruger poster en aktivitet, skubber feedtjenesten den ind i forudgående foderrækker for tilhængere.

- Fan-out-on-read (Fallback): For brugere med høj fanout (berømtheder, influencere) konstrueres feeds på forespørgselstid med pagination fra Kafka-støttede begivenhedslogfiler eller foderindeksborde.

Foderopbevaring: Implementeret via skriveoptimerede tabeller eller kolonne-familiebutikker (f.eks. Scyllladb eller Cassandra-lignende butikker) med TTL’er til flygtige begivenheder og forudindgivet JSON til hurtig hydrering.

4. Udfordring og behandling af leaderboard

- Batch Compute: Leaderboards beregnes i batches ved hjælp af en strømforarbejdningsmotor (f.eks. Apache flink, gnist -streaming). Segmentkampe og udfordringsvalideringer kører asynkront fra aktivitetsindtagelse ved hjælp af holdbare Kafka -emner.

- Vindueret aggregering: Udfordringsstatistikker er vinduet (dagligt, ugentligt) for at forhindre fuld historikskanning og reducere lagringstrykket. Aggregerede materielle visninger indekseres pr. Udfordring og segment.

5. Geo- og sensordataindtagelse

- Højfrekvent indtagelse: GPS-point er skrevet i batches til tidsseriebutikker (eller S3-filer med indeksering) og kontrolleres for at undgå overløb af hukommelse. Batching reducerer skriveforstærkning på DB og fremskynder håndtering af bagtryk.

- Komprimering: GPS-koordinater er delta-kodede og gzipped inden opbevaring. Rehydrering sker ved MAP-gengivelse eller eksporttid, ikke under realtidsføringsdisplay.

6. Trafik i tredjepart

Spikes fra Garmin eller Apple Syncs absorberes ved hjælp af afkoblede indtagelseskøer og hastighedsstyrede ETL-rørledninger. Hver integration har en afbryder og prøver igen for at forhindre opstrøms misbrug eller fan-out storme.

Sikkerhedsarkitektur

1. Autentificering og autorisation

- Autentificering: Alle klientinteraktioner bruger OAuth 2.0 med PKCE til mobilstrømme. JWT’er udstedes og underskrev af Auth -tjenesten, der indeholder bruger -ID, omfang og udløb. Opdater tokens roteres og krypteres i hvile.

- Federated Login: Google, Apple og Facebook-login understøttes, men er altid knyttet til en indfødt brugeridentitet. Sociale login-tokens er valideret server-side, ikke direkte betroet.

- Bemyndigelse: Hver service validerer JWT-tokenet og håndhæver omfangsniveau-regler (f.eks. ‘Læs: Feed’, ‘Post: Activity’). RBAC (rollebaseret adgangskontrol) bruges til interne værktøjer (f.eks. Admin, moderatorroller).

2. databeskyttelse

- I hvile:

- PostgreSQL, Redis og objektbutikker krypteres ved hjælp af AES-256-kryptering med kundestyrede nøgler (CMK’er).

- Følsomme felter (f.eks. E -mail, sundhedsmetrics) er krypteret i applikationslaget, før DB skriver.

- I transit: Al inter-service og klient-til-server-trafik er beskyttet af TLS 1,2+. Gensidig TLS bruges til GRPC -kommunikation mellem pålidelige backend -tjenester.

- Maskering på feltniveau: Følsomme felter er maskeret eller redakteret i logfiler og dashboards. Observabilitetsværktøjet håndhæver feltmærkning og automatiseret PII -scanning inden indtagelse.

- Geo Privacy: Aktiviteter, der er markeret som private eller “kun tilhængere”, er fuldstændigt udelukket fra feeds, leaderboards og søgeindeks. Heatmap-data er kun anonymiseret og samplet fra offentlige aktiviteter med geo-blindende nær hjemmezoner.

3. IAM Design & Secrets Management

- Hemmeligheder: Alle API -nøgler, DB -legitimationsoplysninger og webhook -tokens gemmes i et centraliseret hvælving (f.eks. Hashicorp Vault eller AWS Secrets Manager) og injiceres via miljøet ved runtime. Rotationspolitikker automatiseres til kortvarige legitimationsoplysninger.

- Iam: Hver mikroservice har en unik identitet og sæt roller. IAM-politikker er scoped til de krævede minimale tilladelser (f.eks. Read-kun adgang til objektopbevaring, kun skrivende adgang til Kafka-emner). CI/CD -agenter antager midlertidige roller ved hjælp af OIDC Trust.

4. Sikker kodning og API -beskyttelse

- Input validering: Alle eksterne input er skema-valideret ved hjælp af OpenAPI eller JSON-skema. Frontend og backend håndhæver længde, format og grænser kontrol.

- Rate Begrænsende: Per-bruger- og per-IP-rentegrænser håndhæves via REDIS eller API Gateway-plugins. Misbrugsdetekteringsmodeller (f.eks. Login storm eller spamadfærd) Fejer til dynamiske throttling -politikker.

- Replay Protection: Alle underskrevne anmodninger inkluderer nonces eller tidsstempler. Aktivitets uploads og webhooks bruger HMAC -underskrifter til at validere oprindelse og forhindre manipulation.

- Kodesikkerhed: Statisk analyse (SAST) og afhængighedsscanning er integreret i CI -rørledninger. Hemmelighedsdetektion (f.eks. Gitleaks) blokerer for utilsigtet eksponering. Alle kritiske strømme gennemgår peer-reviewede og reviderede pull-anmodninger.

Udvidelighed og vedligeholdelighed

1. Modulære servicegrænser

Hvert større domæne – brugere, aktiviteter, feed, meddelelser, udfordringer – indkapsles i sin egen tjeneste med sit eget skema, API og implementerbar runtime. Disse tjenester kommunikerer asynkront gennem meddelelseskøer eller synkront via GRPC/REST, afhængigt af latensfølsomhed.

Denne isolering muliggør uafhængig skalering, frigørelsescyklusser og ombordstigning af nye ingeniører uden risiko for sikkerhedsskade på ikke -relaterede funktioner. For eksempel rører forsendelse af et nyt leaderboard -format eller anmeldelse trigger ikke aktiviteten indtagende logik eller brugerprofiler.

2. pluginorienterede mønstre

- Begivenhedslyttere: Nye funktioner (f.eks. Præstationer, live coaching-alarmer eller enhedsbaserede badges) introduceres ved at abonnere på kernebegivenheder som

Aktivitet. OprettetellerChallenge.completed. Dette tillader innovation uden at omskrive opstrøms logik. - Funktionsflag: Alle brugervendte funktioner styres af dynamiske flag (f.eks. Launchdarkly eller interne vippesystemer), hvilket muliggør kanarieudvikling, A/B-test eller iscenesatte udgivelser baseret på region, brugerniveau eller platform.

- Brugerdefineret udfordringslogik: Udfordringsmotoren er udvidelig via regelmotorer eller indlejret scripting (f.eks. LUA eller CEL). Dette gør det muligt for markedsføring eller klubledere at skabe nye typer udfordringer (f.eks. “Klatre 2K meter på 3 dage”) uden hardkodningslogik i backend.

3. Clean Code & Mønstre

- Domændrevet design (DDD): Tjenester bruger DDD til at organisere logik efter afgrænset kontekst – aktivitetsaggregation, segment scoring, efterfølgende styring – snarere end efter teknisk lag. Dette reducerer tværgående logik og kodespredning.

- Test og fnug: CI håndhæver streng fnug, kodedækningstærskler og kontraktforsøg for alle API’er. Udviklerhastigheden forbliver høj, fordi lokale Dev -opsætninger bruger containere med podede databaser og spotkøer til hurtig iteration.

- Monorepo vs Polyrepo: Backend er typisk Polyrepo (en pr. Tjeneste), mens mobilappen muligvis bor i en monorepo med modulære pakker. Delte Protobufs eller GraphQL-skema-definitioner er versionskontrolleret i en separat kontraktrepo.

4. service versionering og bagudkompatibilitet

- API -versionering: Alle offentlige API’er er versioneret (f.eks. `/V1/aktiviteter`). Udskrivede slutpunkter opretholdes i en defineret solnedgangsperiode med observerbarhed til overvågning af brugen.

- Skemaudvikling: PostgreSQL-skemaer bruger additive migrationer (tilføjelse af kolonner, ikke fjernelse af dem) og aldrig omdøbe enums eller begrænsninger uden dobbeltlæsning/skriv skifter på plads. For NoSQL-butikker er hvert objekt mærket med en skemaversion til bagudkompatibel deserialisering.

- Protokolkompatibilitet: GRPC- og Protobuf -kontrakter er designet til at undgå at bryde ændringer – felter fjernes aldrig, og felt -id’er genanvendes ikke. For GraphQL forbliver forældede felter tilgængelige med advarselsoverskrifter og fnug i frontend.

Tænker du langsigtet på din platform?

Brug for hjælp til at designe en modulær, fremtidssikre arkitektur, der ikke smuldrer under versionering af helvede eller vækstflaskehalse?

Uanset om du skalerer en social app eller udvider en fitnessplatform, er vi her for at hjælpe arkitekten i lang tid.

Præstationsoptimering

1. Databaseforespørgselsindstilling

- Forespørgselindeksering: Hver høj-cardinalitetskolonne, der bruges i filtre eller sammenføjninger-såsom `user_id`,` Activity_ID`, `create_at` eller` Challenge_ID ‘-understøttes af BTREE- eller GIN-indeks. Sammensatte indekser oprettes til hyppige forespørgsler som `Follower_ID + Create_at Desc` i feeds eller` user_id + Challenge_id` i leaderboard -opslag.

- Materialiserede synspunkter: Daglige rollups (f.eks. “Total Distance Run denne uge”) opbevares som materialiserede synspunkter og opdateres via async -job. Dette undgår gentagne aggregeringsscanninger og fremskynder mobile dashboard -metrics.

- Forespørgsel cache: Lederboards, offentlige profiler og statiske udfordringssider bruger Redis som et cache -lag med intelligente TTL’er og eksplicit ugyldighed ved relevante begivenheder.

2. asynkron behandling

- Udskudt arbejdsbelastning: Tunge opgaver såsom segment matching, varmekortgenerering, badge-evaluering og efterfølgende feed-fan-out udsættes alle til baggrundsarbejdere, der forbruger Kafka/Nats-emner. Dette holder aktivitetsindgivelsesstien responsiv (~ 100–200ms P99).

- Bulk indtagelsesstier: Uploads fra Garmin eller Apple Health batches og behandles parallelt med deduplikation og fejlisolering for at undgå at blokere fuld enhedssynkronisering på grund af enkeltkorrupte filer.

3. Rate Begrænsende og misbrugskontroller

- Bedømmekontrol: Hvert API-slutpunkt har brugerniveau og IP-niveau-rentegrænser, der håndhæves ved gatewayen. Højprisoperationer (f.eks. Indsendelsesaktiviteter med medier) er yderligere begrænset via adaptiv throttling bundet til at anmode om forsinkelse og køforsinkelse.

- Misbrugsdetektion: Maskin-lærede modeller scorer handlinger som følg spam, kommentar oversvømmelser eller voldelig geo-posting. Disse er bundet til realtidsfiltre, der bremser eller sandkasse ondsindede klienter automatisk.

4. cache -lag

- Kantcache: Rutekort, profil -avatarer, udfordringssider og heatmap -fliser serveres alle gennem CDN -kantknudepunkter (CloudFlare, hurtigt). Cache -nøgler er mærket med version hasher for at tillade hurtig global ugyldighed.

- Cache-side på klientsiden: Den mobile app bruger lokal SQLite til offline-tilstand, med hydrering fra delta-opdaterede JSON-klatter, der er modtaget ved opstart eller post-login. Dette muliggør instant foderet gengivelse og glattere kold starter.

5. Frontend Performance

- Trinvis belastning: Feedruller, profiludsigt og udfordringslister alle implementerer alle uendelige rulle eller vinduespagination ved hjælp af markørbaserede tokens. Dette minimerer nyttelaststørrelse og hukommelsestryk på mobile klienter.

- Billedoptimering: Alle uploadede billeder er ændret størrelse, komprimerede og format-konverterede (f.eks. WebP) af mediaservice inden CDN-levering. Enhedsspecifikke aktivvarianter vælges ved hjælp af indholdsforhandlingsoverskrifter.

- JS Bundling & Tree ryster: Webkunder bruger moderne bundlere (f.eks. Vite eller Webpack 5) med dynamisk importopdeling og rystelse af træ. Lazy belastning anvendes til ikke-kritiske UI-komponenter som diagrammer, kort eller analyse.

Teststrategi

1. typer af test

- Enhedstest: Hvert servicelag har omfattende enhedstest, der dækker domænelogik, inputvalidering og hjælpefunktioner. Disse er hurtigt løbende og isolerede-ingen eksterne afhængigheder tilladt. Spottende biblioteker (f.eks. Gomock, Pytest-mock, spøg) bruges til at isolere bivirkninger.

- Integrationstest: De vigtigste serviceinteraktioner-såsom aktivitetsindgivelse, der udløser fodergenerering eller udfordringsberettigelseskontrol-er dækket med Docker-baserede testmiljøer. Disse tests spin op reelle afhængigheder (PostgreSQL, Redis, Kafka) og validerer adfærd under realistiske forhold.

- Kontrakttest: For GRPC og REST API’er validerer kontraktforsøg (f.eks. Brug af PACT eller BUF til Protobuf), at producent- og forbrugertjenester overholder aftalte skemaer, især på tværs af serviceversions ujævnheder eller under parallelle implementeringer.

- End-to-End (E2E) test: Kritiske brugerstrømme – tilmelding, login, aktivitetssporing, kommentering – testes ved hjælp af cypress eller detox (til react indfødt). Disse test kører på emulatorer og reelle enheder i CI mod iscenesættelsesmiljøer.

2. CI -testdækningstrategi

- Håndhævelse af kodedækning: Minimumstærskler håndhæves for PR’er ved hjælp af værktøjer som Codecov eller Sonarqube. Dækningsporte blokerer fusioner, hvis ny kode mangler korrekte testtilfælde – især til servicelogik eller datatransformationsfunktioner.

- Paralleliserede CI -rørledninger: Tests er grupperet efter service og udført parallelt via GitHub -handlinger, Circleci eller BuildKite. Testmatrix inkluderer miljøpermutationer (f.eks. Forskellige DB -versioner, API -versioner).

- Testarmaturer og podning: Delte testdata leveres via containeriserede snapshots eller deklarative YAML/JSON -inventar. Alle tjenester understøtter testtilstand bootstrapping til lokale og CI -testmiljøer.

3. belastning og modstandsdygtighedstest

- Indlæsningstest: Locust, artilleri eller K6-scripts simulerer spids trafikmønstre-store fan-out, uploads af bulkaktiviteter, opkastning af leaderboard-for at teste systemrespons under stress. Belastningstest køres ugentligt og under større udgivelser.

- Chaos Engineering: Værktøjer som Gremlin eller Litmuschaos injicerer fejl ved tjenesten, DB eller netværkslag (f.eks. Latensspidser, faldt Kafka -partitioner, DB -fejl). Målet er at validere retry -politikker, tilbagefaldslogik og advarsel om dækning.

- Resilience påstande: Circuit Breakers, Bulkheads og Timeout -nedfalder testes eksplicit. Canary-implementeringer inkluderer fejlindsprøjtningstest, før fuld rulleprovenu.

DevOps & CI/CD

1. CI/CD Pipeline Oversigt

Hele systemet er bygget på GIT-baserede arbejdsgange (GitHub, Gitlab eller Bitbucket) med automatiserede rørledninger, der er udløst på pull-anmodninger, fusioner og tagbaserede udgivelser. CI/CD behandles som et førsteklasses produkt med ydeevne, isolering og synlighed som kerneprincipper.

Rørledningstrin:

- Bygge: Containerbilleder er bygget pr. Tjeneste ved hjælp af flertrins dockerfiles. Almindelige basisbilleder er cache og genanvendt. For frontend -apps inkluderer opbygningstrin træ ryster, transpilering og bundtanalyse.

- Prøve: Enhed, integration og kontraktforsøg kører i isolerede job med upload af artefakt (f.eks. Dækningsrapporter, testlogfiler). Mislykkede job er annoteret inline i PRS til hurtig triage.

- Sikkerhedsscanning: Sast (f.eks. Sonarqube, SNYK) og afhængighedssårbarhedsscanninger håndhæves, før artefakter fremmes. Secrets Scanning Tools blokerer for utilsigtet eksponering.

- Billedsignering: Containerbilleder er underskrevet og gemt i et sikkert register (f.eks. AWS ECR, GCP Artifact Registry) med uforanderlige tags og oprindelsesmetadata.

- Iscenesættelse af installation: Mærket builds implementeres automatisk til en iscenesættelsesklynge. Canary -tests, røgforsøg og syntetiske sundhedscheck køres mod dette miljø med korte TTL’er.

- Produktionsfremme: Implementeringer til produkt udløses enten manuelt (med godkendelsesporte) eller automatisk efter bestået QA -forhold. Gitops -værktøjer (f.eks. ArgOCD, Flux) anvender manifesteret fra en versioneret statsrepo.

2. Infrastruktur som kode (IAC)

- Terraform: Alle infrastrukturer – VPC’er, K8S -klynger, DB -forekomster, IAM -roller, køer – administreres via terraformmoduler. Ændringer gennemgås og forhåndsvisning ved hjælp af

Terraform PlanI PRS. Driftdetektion kører om natten for at detektere manuelle ændringer. - Tilpas & hjelme: K8S -manifestationer er templeret via ror og styres på tværs af miljøer ved hjælp af Kustomize -overlays. Dette gør det nemt at tilsidesætte kopier, konfigurer og hemmeligheder pr. Miljø.

- Hemmelighedsstyring: Hemmeligheder og konfigurationskort injiceres via forseglede hemmeligheder (f.eks. Mozilla SOPs, Bitnami forseglede hemmeligheder) eller synkroniseres fra hvælving ved hjælp af sidevogninjektorer. Alle hemmeligheder drejes og revideres regelmæssigt.

3. implementeringsstrategi

- Blågrønne implementeringer: For kritiske stier som autorisation eller aktivitet bruges blågrønne strategier. Trafikken forskydes gradvist ved hjælp af indtrængningsregler med automatiseret rollback, hvis sundhedskontrollen mislykkes.

- Canary frigiver: Ikke-kritiske tjenester (f.eks. Underretninger, leaderboards) bruger kanarieudviklinger-implementering til 5%, derefter 25%og derefter 100%over tid. Metrics (latenstid, fejlfrekvens, CPU) sammenlignes med baselinjer, før de fortsætter.

- Funktionsflag: Alle nye kodestier er beskyttet af funktionsskifter. Dette giver mulighed for progressiv eksponering, mørke lanceringer og øjeblikkelige dræbskontakter under hændelser.

4. Artefakt og miljøhygiejne

- Billedlivscyklus: Gamle bygninger beskæres automatisk baseret på alders- eller Sha -fastholdelsespolitikker. Ubrugte billeder opbevares aldrig over 30 dage, medmindre de er mærket som LTS- eller rollback -versioner.

- Preview miljøer: Efemiske iscenesættelsesmiljøer oprettes pr. PR ved hjælp af dynamiske navneområder i Kubernetes. Disse miljøer efterligner produktionstopologier og ødelægges efter fusion eller PR -tæt.

- Rollback -mekanisme: Hver implementering er atomisk og version-pinnet. Rollbacks kan udløses via Git Revert, Helm History Rollback eller ArgOCD UI -klik – inden for få sekunder.

Brug for hjælp til at sende hurtigere uden at bryde tingene?

Vil du bygge en højhastighedsteknisk rørledning med skudsikker rollbacks, gitops-arbejdsgange og CI/CD i produktionskvalitet?

Uanset om du skalerer en mikroservices backend eller lancerer en ny mobilfunktion, lad os arkitekt et DevOps -system, der fungerer under pres.

Overvågning og observerbarhed

1. logning

- Struktureret logning: Hvert service logger i JSON -format ved hjælp af strukturerede felter som `Request_ID`,` user_id`, `Activity_ID` og` varighed_MS ‘. Logfiler streames via flydende bit eller filbeat til en central rørledning (f.eks. Elasticsearch, Loki) til indekseret forespørgsel og analyse.

- Korrelations -id’er: Hver anmodning genererer et unikt korrelations -id, der forplantes på tværs af servicegrænser via overskrifter og log -kontekst. Dette muliggør fuld ende til ende sporbarhed fra mobilapp til backend-køer til DB.

- Log hygiejne: PII -maskeringsregler håndhæves på logpipeline -niveau. Hemmeligheder, adgangstokens, GPS -koordinater og rå telemetri er udelukket eller redigeret automatisk, før logfiler rammer opbevaring.

2. Metrics

- Systemmetrics: CPU, hukommelse, disk og netværksbrug eksporteres fra hver knude og pod via Prometheus -eksportører. Alarmgrænser er indstillet til mætning, ressourcetryk og usædvanlig pod -churn.

- Forretningsmetrics:

- Aktiviteter pr. Minut, foderbegivenheder pr. Sekund

- Challenge tilslutter sig, skriver leaderboard, segmentkampe

- Latens pr. Endpoint, 99. percentilfejlhastighed

- Brugerdefineret instrumentering: Tjenester bruger Prometheus -klientbiblioteker til at eksportere tællere, histogrammer og målere til brugerdefineret logik – såsom “Badge -evalueringer behandlet” eller “GPS -punkter pr. Upload.”

3. distribueret sporing

- Sporingssystem: OpenTelemetry bruges til instrumenttjenester med spenn for HTTP/GRPC -opkald, DB -forespørgsler og Async -køhåndtering. Spor eksporteres til backends som Jaeger, Honeycomb eller Tempo.

- Sporprøveudtagning: Hovedbaseret prøveudtagning (med justerbare hastigheder) sikrer transaktioner med høj værdi som aktivitetsindtagelse eller foderudgangsfaner altid fanges, mens baggrundsjob med lav prioritet samples probabilistisk.

- Sporforbindelse: Alle spor binder tilbage til bruger -id’er og anmoder om metadata, der muliggør fejlsøgning af individuelle aktivitetsindlæg, leaderboard -bugs eller langsom tilhængers fodergenerering med nøjagtige kausalitetskæder.

4. Alerting & Dashboards

- Alert Management: Prometheus AlertManager eller Opsgenie håndterer deduplikation, stilhedsvinduer, rotationer på vagt og eskaleringspolitikker. Alarmer inkluderer Slack/Teams Hooks, SMS og Pagerduty, når kritiske tærskler krydses.

- Dashboards: Grafana-dashboards er forudbygget pr. Tjeneste med bore-down kapaciteter til latenstid, fejlhastigheder, DB-gennemstrømning, kø-efterspørgsler og eksterne API-fejl. Forretningsinteressenter får også KPI -visninger (f.eks. Aktive brugere, udfordringsafslutningsrater).

- SLOS & FEJL BUDGETER: Key Endpoints (f.eks. Aktivitetsindgivelse, foderbelastning, udfordring tilslutning) er bundet til formelle SLO’er med latenstid/fejlgrænser. Forbrændingshastigheder beregnes for at informere funktionsflagging og udrulning.

5. Sundhedskontrol og beredskabsprober

- Livlighed og beredskab: Alle tjenester afslører `/Healthz` -slutpunkter for grundlæggende livlighed (f.eks. Trådpoolstatus, hukommelse) og beredskab (f.eks. DB -forbindelse, køforsinkelse). Kubernetes bruger disse til autoskalering og indsættelse af orkestrering.

- Dyb kontrol: Periodiske baggrundsopgaver udfører syntetiske transaktioner (f.eks. Testaktivitetsindsats + feed læst) for at validere forretningslogik sundhed – ikke kun systemoppetid.

Afvejninger og designbeslutninger

1. fan-out-on-write vs. fan-out-on-read

- Afgørelse: En hybridmodel blev valgt. For gennemsnitlige brugere bruger systemet fan-out-on-write til at præpopulere feeds. For brugere med høj fanout (f.eks. Influencere) skifter det til fan-out-on-read.

- Hvorfor: Forudbestilling af foderindgange minimerer latenstid og aflæser læsestien, men det er dyrt, når en bruger har tusinder af tilhængere. Hybriddesignet optimerer til 95% tilfælde, mens den beskytter infrastruktur mod fan-out storme.

- Afvejning: Mere operationel kompleksitet. Systemet skal dynamisk rutesskrivninger/læser gennem forskellige kodestier baseret på brugerniveau eller efterfølgende tælling. Øger også testoverfladen.

2. Polyglot persistens

- Afgørelse: PostgreSQL, Redis, Kafka og S3 blev valgt som kerne stak. Valgfri brug af NEO4J til social graf gennemgang blev udsat.

- Hvorfor: Disse værktøjer er godt tilpas med adgangsmønstrene: PostgreSQL for integritet, Redis for adgang med lav latens, Kafka i begivenhedsdrevet skala og S3 til BLOB-opbevaring. Undgå en specialiseret graf DB forenklet OPS og onboarding.

- Afvejning: Nogle grafforespørgsler (f.eks. “Gensidige tilhængere i en klub”) er mindre effektive uden en dedikeret grafmotor. Redis-baserede cache mindskes dette, men tilføjer cache-sammenhængskompleksitet.

3. realtid GPS Sync vs. Upload efter træning

- Afgørelse: Upload efter træning er standard; Synkronisering i realtid er valgfri og opt-in (f.eks. Til live tracking eller virtuelle løb).

- Hvorfor: GPS-streaming i realtid skaber konstant backendbelastning, introducerer konsistensudfordringer til delvis aktiviteter og øger strømafløbet på mobile enheder. For de fleste brugere er batch upload tilstrækkelig.

- Afvejning: Nedsat evne til strømfunktioner som live jubel, pacer-matching eller igangværende leaderboardopdateringer. Fremtidige versioner kan udvide realtidsstøtte bag funktionsflag.

4. mikroservices vs. monolit

- Afgørelse: Mikroservices blev valgt tidligt med klare domænegrænser: aktivitet, foder, bruger, udfordring, medier osv.

- Hvorfor: Muliggør uafhængig skalering, parallel udvikling og domænespecifikt ejerskab. Indtagelse af foder og aktivitet har vildt forskellige præstationsprofiler – adskilt dem tillader målrettet optimering.

- Afvejning: Kræver robust værktøj: serviceopdagelse, sporing, CI/CD -isolering og platformteknisk modenhed. For små hold tilføjer dette forhåndskompleksitet, men langvarig smidighed opvejer kortvarige smerter.

5. Begivenhedsdrevet vs. synkrone arbejdsgange

- Afgørelse: Alle ikke-kritiske stier (feed-fan-out, leaderboardopdateringer, meddelelser) er async via Kafka/Nats. Kun autoriserede og brugervendte forespørgsler bruger anmodning/svarstrømme.

- Hvorfor: Async Systems skala bedre og afkoble arbejdsgange. De tillader også batching, forsøg og køprioritering-essentiel for variable indtagelsesmønstre som tredjeparts synkronisering eller udfordringsspidser.

- Afvejning: Eventuel konsistens og fejlsøgning af kompleksitet. Kræver DLQS (død-bogstavskøer), begivenhedsudskiftninger og omhyggelig deduplikationslogik. Overvågning og observerbarhed er nøglen til sikkerhed her.

Arkitektonisk gæld og afbødninger

- Nogle ældre foderstier antager stadig synkrone skrivninger-der bliver refaktoreret til Kafka-baserede fan-out-tjenester.

- Den første udfordringsmotor havde hardkodede regler – erstattet med en regelmotor for fleksibilitet.

- Tilladelseslogik spredt på tværs af tjenester – at blive centraliseret i en adgangspolitisk service for at håndhæve konsistens.

Nøgle takeaways & områder for at forbedre

1. Hvad denne arkitektur får rigtigt

- Skalerbarhed efter design: Statløse tjenester, begivenhedsdrevet behandling og afskårne databaser holder systemet lydhør selv på millioner af brugere og høje indtagelsesgrader.

- Modulære grænser: Klar adskillelse mellem aktivitet, sociale, medier og analytiske logik tillader fokuseret optimering og sikker, parallel udvikling.

- Async først: Afkobling af feedgenerering, udfordringsscoring og meddelelser fra den kerneindtagelsessti leverer ydeevne og fejlisolering, hvor det betyder noget.

- Sikkerhed og privatliv: Finkornet adgangskontrol, krypteret opbevaring og streng observerbarhedspraksis er i overensstemmelse med GDPR-niveau-datasansvar.

- Udviklerhastighed: CI/CD -rørledninger, funktionsflag og kontraktforsøg understøtter hurtig, sikker iteration – uden at gå på kompromis med produktionsstabiliteten.

2. muligheder for forbedring

- Dynamiske grafforespørgsler: Genevaluering af brugen af Redis vs. specialbygget graf DBS (f.eks. DGraph, Nebula) til gensidig efterfølgende påvisning eller avancerede klubfunktioner.

- Unified Access Control: Centralisering af al tilladelseskontrol af en politik service (OPA eller brugerdefineret) for at undgå dobbeltarbejde og drive over tjenester.

- Live funktioner: Udvidelse af realtidsfunktioner (f.eks. Live segmenter, pacers, gruppekørsler) med pålidelige streamingprotokoller og kontrolleret udrulning.

- Mobil offline Sync: Forbedring af offline-første UX for brugere i landdistrikter eller under lange udendørs aktiviteter med bedre konfliktløsningsstrategier.

- Avanceret analyse: Bygning af dedikerede atletindsigt i atlete indsigt (f.eks. VO2 MAX-estimering, træningsbelastning) ved hjælp af præ-aggregerede dataløer og ML-modeller.

Denne platformdesign balancerer ydeevne, fleksibilitet og brugeroplevelse i en krævende social + fitness -kontekst. Det er produktionsklar, kamptestet og bygget til vækst-men med plads til at udvikle sig til et mere intelligent, realtid og personlig fitnessøkosystem.

Bygger noget denne ambitiøse?

At designe skalerbare, sikre og socialt engagerende platforme handler ikke kun om at vælge den rigtige stak – det handler om at tage de rigtige beslutninger på det rigtige tidspunkt.

Uanset om du lancerer en fitness -app, forbedrer brugerengagement eller moderniserer din backend, er vi klar til at hjælpe dig med at arkitekt den med selvtillid.

Folk spørger også (ofte stillede spørgsmål)

Hvordan udvikler man en fitness tracker -app?

Start med at definere kernefunktionerne: GPS -aktivitetssporing, indtagelse af sundhedsdata (hjerterytme, trin), brugerprofiler og offline -logning. Derfra skal du designe en mobil-første oplevelse ved hjælp af React Native eller Swift/Kotlin, implementere sikker brugergodkendelse (OAuth2) og oprette forbindelse til en backend, der kan indtage, behandle og analysere sensordata i realtid. Cloud-indfødte infrastruktur, skalerbare datalagre og begivenhedsdrevet behandling vil være nøglen til at holde ydeevne og lydhørhed tæt.

Hvor meget koster det at opbygge en fitness -app?

Det afhænger af rækkevidde, men en fitness-app med produktionskvalitet med GPS-sporing, bruger-autor $ 50.000 til $ 500K+ at bygge og lancere. Det inkluderer UI/UX, mobiludvikling, backend -arkitektur, DevOps og QA. Omkostningsskala baseret på kompleksitet – live tracking, sociale grafer, integrationer og analyse øger alle tekniske indsatser.

Hvordan laver man en Strava -app?

For at opbygge en Strava-lignende app har du brug for en mobil klient til GPS-baseret aktivitetsoptagelse, en backend til opbevaring og analyse af brugertræning og et socialt graflag til feeds, følger og interaktioner. Kernekomponenter inkluderer en realtids placeringsrørledning, en skalerbar fodervæsen og en begivenhedsdrevet motor til udfordringer og leaderboards. Arkitektering for skalerbarhed, lav latenstid og modulopbyggede servicegrænser er afgørende.

Hvor meget koster det at opbygge en app som Strava?

En platform med strava-stil i fuldt udstyret kan let overstige $ 500.000 til $ 1M+ I udviklingsomkostninger afhængigt af dit funktionssæt, teamstruktur og tid til marked. Omkostninger inkluderer udvikling af mobil og backend, skyinfrastruktur, ydeevneoptimering og support til ting som medier uploads, privatlivsindstillinger og tredjepartsintegrationer.

Hvilken database bruger Strava?

Strava har ikke offentligt detaljeret deres fulde stak, men baseret på mønstre, der er almindelige for systemer i lignende skala, bruger de sandsynligvis en blanding af relationelle databaser (f.eks. PostgreSQL), distribuerede datalagre til telemetri (f.eks. Cassandra eller tidsserier DBS) og redis-lignende systemer til cache. Deres arkitektur er begivenhedsdrevet og mikroservicebaseret med skyinfrastruktur, der håndterer millioner af aktiviteter pr. Dag.

Hvorfor er Strava så populær?

Strava spikede blandingen af fitnesssporing og socialt engagement. Det handler ikke kun om optagelsesløb – det handler om at dele dem, konkurrere om segmenter, tjene badges og engagere sig i et samfund. Det sociale foder, gamification har og udfordrende økosystem gør platformen klistret og vanedannende, der driver både tilbageholdelse og viralitet.

Er en fitness -app rentabel?

Ja – hvis det udføres godt. Abonnementsbaserede fitness-apps (som Strava Premium, MyFitnessPal osv.) Har vist sig at være meget rentable. Indtægter kan komme fra premium analyse, coachingværktøjer, brandede udfordringer eller gearmarkedspladser. Men rentabilitet kræver en stærk tilbageholdelsesstrategi, infrastruktureffektivitet og brugervækst ud over MVP.

Hvordan tjener jeg penge på min fitness -app?

Almindelige indtægtsstrategier inkluderer: freemium-abonnementer (f.eks. Lås op for dybere analyse eller coaching), køb i appen (f.eks. Træningsplaner), brandpartnerskaber (f.eks. Sponsorerede udfordringer) og tilknyttede markedspladser (f.eks. Sko, wearables). Annoncer er mulige, men forringer ofte brugeroplevelsen. Fokus på brugertillid og langsigtet værdi, når du designer indtægtsstier.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.