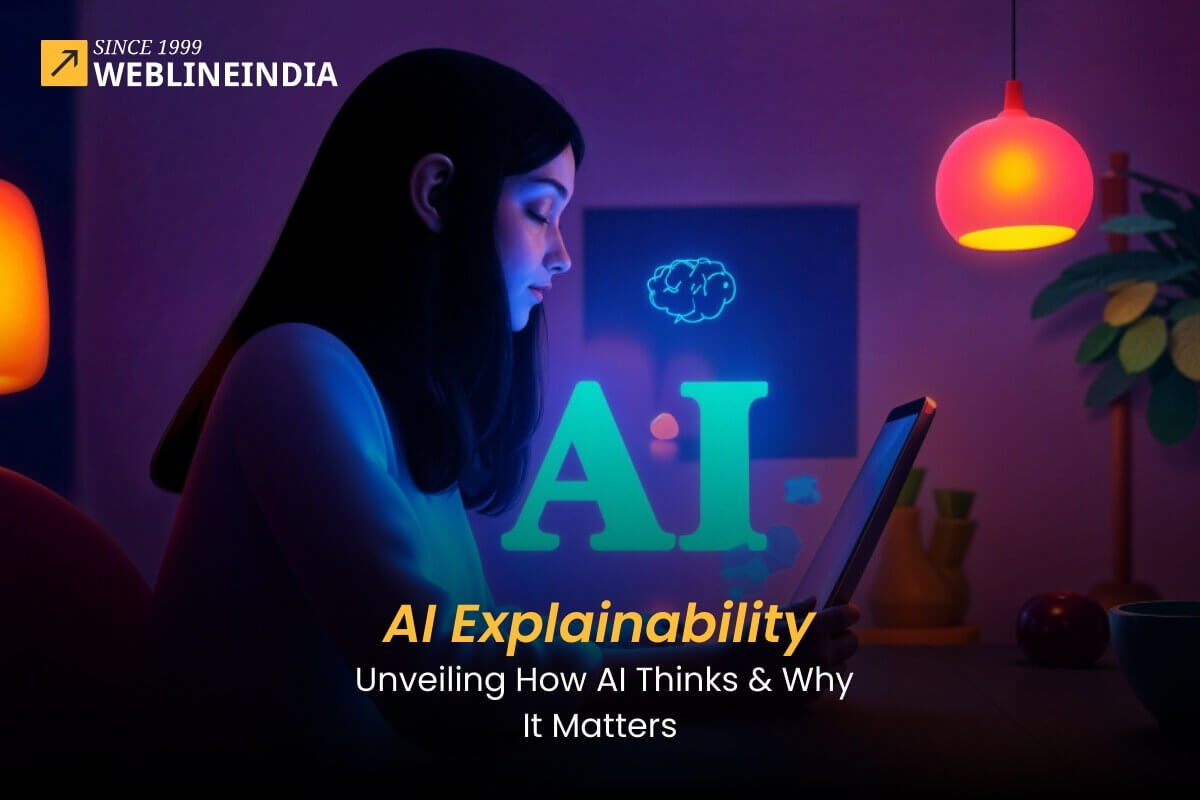

Künstliche Intelligenz (AI) verändert die Art und Weise, wie wir leben und arbeiten. Von selbstfahrenden Autos bis hin zur medizinischen Diagnose werden KI-Modelle verwendet, um Aufgaben zu automatisieren und Entscheidungen zu treffen, die einst als ausschließliche Domäne des Menschen angesehen wurden. Wenn KI -Modelle jedoch komplexer werden, wird es immer schwieriger zu verstehen, wie sie arbeiten. Dieser Mangel an Transparenz kann zu vielen Problemen führen, einschließlich Voreingenommenheit, Diskriminierung und sogar Sicherheitsbedenken.

Hier kommt die Erklärung der KI ins Spiel. Erklärbare KI (XAI) ist eine Reihe von Techniken, die es ermöglichen, zu verstehen, wie KI -Modelle Entscheidungen treffen. Diese Informationen können verwendet werden, um die Genauigkeit und Fairness von KI -Modellen zu verbessern und Vertrauen in AI -Systeme aufzubauen.

In diesem Leitfaden erfahren Sie, was erklärbare KI ist, warum sie wichtig ist und wie sie durch verschiedene Methoden und Technologien.

Möchten Sie KI -Software, die Automatisierung und intelligentere Entscheidungen vorantreibt?

KI -Erklärung verstehen

Die Erklärung der KI bezieht sich auf den Prozess, das Innenleben von KI -Modellen für den Menschen verständlich zu machen. Ziel ist es, sicherzustellen, dass die von diesen Modellen erzeugten Ergebnisse nicht nur genau, sondern auch interpretierbar und gerechtfertigt sind. Mit der zunehmenden Beliebtheit von KI-Entwicklungsdiensten bestand ein steigender Bedarf an erklärbarer KI, um Vertrauen aufzubauen, Vorurteile zu reduzieren und die Transparenz bei der Entscheidungsfindung der KI zu verbessern.

Warum ist die AI -Erklärung wichtig?

Durch die Einbeziehung der Erklärung der KI kann sowohl Entwicklern als auch Endbenutzern mehrere Vorteile bringen:

- Vertrauen und Adoption: Erklärbare KI hilft den Interessengruppen, den Entscheidungen der KI zu vertrauen und die breitere Verwendung zu fördern.

- Debugging und Verbesserung: Durch transparente KI -Modelle können Datenwissenschaftler Fehler verstehen, was für die Verbesserung der Modellgenauigkeit von entscheidender Bedeutung ist.

- Compliance: Bestimmte Branchen erfordern klare Erklärungen für Entscheidungen, wie z. B. in der Finanzierung und Gesundheitspflege, wo die Erklärung der KI für die Erfüllung der behördlichen Anforderungen von entscheidender Bedeutung ist.

- Ethische Überlegungen: Erklärbare KI hilft bei der Minderung von Vorurteilen und fördert die Fairness bei der automatisierten Entscheidungsfindung.

Wie funktioniert die Erklärung der KI?

Es gibt eine Reihe verschiedener Techniken, mit denen die AI -Erklärung erreicht werden kann. Einige der häufigsten Techniken umfassen:

- Lokale interpretierbare Modell-Agnostische Erklärungen (LIME): Diese Technik erklärt die Vorhersagen eines maschinellen Lernmodells, indem es sich lokal mit einem interpretierbaren Modell nähert.

- Shapley Additive Erklärungen (SHOP): Diese Technik basiert auf der Spieltheorie und erklärt die Vorhersagen eines maschinellen Lernmodells durch Berechnung des Beitrags jedes Merkmals zur Vorhersage.

- Entscheidungsbäume: Entscheidungsbäume sind eine Art maschinelles Lernmodell, mit dem die Vorhersagen anderer maschineller Lernmodelle erklärt werden können.

- Regelbasierte Systeme: Regelbasierte Systeme sind eine Art KI-Modell, mit dem die Vorhersagen anderer KI-Modelle erklärt werden können.

Die Schlüsselkomponenten der erklärbaren KI

Die Kernkomponenten der erklärbaren KI beinhalten Transparenz, Interpretierbarkeit und Rechenschaftspflicht. Das Verständnis, wie KI -Modelle eine bestimmte Schlussfolgerung oder Empfehlung erreichen, ist für die Entwicklung verantwortungsbewusster KI -Systeme von wesentlicher Bedeutung.

Im Folgenden finden Sie einige der Elemente, die zur Erklärung der KI beitragen:

Transparenz

Transparenz in AI-Entwicklungsdiensten bedeutet, dass die Prozesse hinter Modelltraining, Datennutzung und Entscheidungsfindung klar sind. Diese Transparenz hilft Entwicklern und Benutzern, die Logik hinter AI -Modellen zu verstehen und die Rechenschaftspflicht in ihren Ausgaben zu gewährleisten.

Interpretierbarkeit

Interpretierbarkeit bezieht sich auf die Fähigkeit des Menschen, die Entscheidungen von KI -Modellen zu verstehen. Ein Modell wird als interpretierbar angesehen, wenn sein Verhalten von Benutzern leicht verstanden werden kann, ohne dass komplexe Mathematik oder Algorithmen ein tiefes Verständnis benötigt werden. Viele KI-Entwicklungsdienste konzentrieren sich auf das Entwerfen von Modellen mit integrierten Interpretierbarkeitsfunktionen, um diesen Prozess zu vereinfachen.

Rechenschaftspflicht

Wenn KI -Modelle Ergebnisse erzielen, stellt die Rechenschaftspflicht sicher, dass die Stakeholder diese Entscheidungen verfolgen und überprüfen können. Dies ist besonders wichtig in Bereichen mit hohen Einsätzen wie Gesundheitswesen, Recht oder Finanzen, bei denen Entscheidungen von KI-Modellen erhebliche Folgen haben können.

Auf der Suche nach KI -Entwicklung, die Genauigkeit und Einhaltung sicherstellt?

Techniken zur Erklärung der KI

Durch die Erklärung der KI werden verschiedene Techniken eingesetzt, um zu verstehen, wie KI -Modelle Entscheidungen treffen. Zu diesen Methoden gehören Lime, das Modelle lokal mit interpretierbaren Erklärungen und Shap annähert, die die Spieltheorie verwendet, um Merkmalsbeiträge zu bestimmen.

Darüber hinaus bieten Entscheidungsbäume und regelbasierte Systeme inhärente Transparenz, indem sie Entscheidungswege bzw. explizite Regeln visualisieren, indem sie das Verhalten des KI-Modells verstehen und Vertrauen in ihre Vorhersagen aufbauen.

Dazu gehören:

1. Model-agnostische Methoden

Diese Techniken gelten für jedes Modell, unabhängig von der Architektur, und geben Einblicke in die Einflüsse von Eingaben. Einige gängige Methoden sind:

- Kalk (lokale interpretierbare Modell-Agnostische Erklärungen): Es erzeugt ein einfacheres, interpretierbares Modell, das sich dem komplexen KI-Modell lokal um eine bestimmte Vorhersage annähert.

- Shap (Shapley -Additive Erklärungen): Erklärt individuelle Vorhersagen durch Berechnung des Beitrags jedes Merkmals zur Ausgabe.

2. modellspezifische Methoden

Bestimmte KI -Modelle sind interpretierbarer als andere. Zum Beispiel sind Entscheidungsbäume und lineare Regressionsmodelle von Natur aus einfacher zu verstehen als Deep -Learning -Modelle. Zu den für bestimmten KI -Modelle spezifischen Techniken gehören:

- Merkmalswichtigkeitsanalyse: In Entscheidungsbaummodellen wie zufälligen Wäldern bewertet diese Technik die Bedeutung jedes Merkmals für die Vorhersage.

- Aktivierungskarten: Für Faltungsfaltungsnetzwerke (CNNs) in der Bildverarbeitung visualisieren Aktivierungskarten, welche Bereiche eines Bildes am meisten zur Entscheidung des KI -Modells beitragen.

3.. Erklärbare neuronale Netze

Obwohl Deep -Learning -Modelle wie neuronale Netzwerke oft als “schwarze Kisten” angesehen werden, gibt es Möglichkeiten, ihre Erklärung zu verbessern. Einige Methoden umfassen:

- Aufmerksamkeitsmechanismen: Diese Methoden ermöglichen es den Modellen, sich auf bestimmte Eingabefunktionen zu konzentrieren, die für die Vorhersage relevanter sind.

- AUSSCHAFTENCECE MAPS: In Computer Vision visualisieren Außendatenkarten Bereiche eines Bildes, die den höchsten Einfluss auf die Vorhersagen haben.

Vorteile von erklärbarer KI in KI -Entwicklungsdiensten

Die Implementierung erklärbarer KI ist für Organisationen, die KI -Entwicklungsdienste anbieten, von wesentlicher Bedeutung. Es stellt sicher, dass Kunden verstehen, wie KI -Modelle funktionieren und Entscheidungen treffen, die letztendlich das Vertrauen in die Technologie aufbauen.

Im Folgenden finden Sie einige wichtige Vorteile:

- Verbesserte Entscheidungsfindung: mit transparenten und verständlichen Modellen,, Künstliche Intelligenz im Geschäft Ermöglicht es Unternehmen, besser informierte Entscheidungen auf der Grundlage von KI-Ergebnissen zu treffen.

- Risikominderung: Eindeutige Erklärungen für die Vorhersagen von KI -Modellen verringern die Wahrscheinlichkeit unerwarteter oder schädlicher Ergebnisse, insbesondere bei sensiblen Anwendungen.

- Vorschriften für die regulatorische Einhaltung: Erklärung ist häufig erforderlich, um rechtliche und regulatorische Standards in Branchen wie Finanzen, Gesundheitswesen und Versicherungen zu erfüllen.

Herausforderungen bei der Implementierung erklärbarer KI

Die Implementierung der erklärbaren KI (XAI) ist nicht ohne Hürden. Das Ausgleich des Bedarfs an KI -Erklärung mit Modellgenauigkeit und Leistung kann schwierig sein. Hochkomplexe KI -Modelle können selbst mit XAI -Techniken schwer zu interpretieren sein.

Die Kommunikation von Erklärungen an Stakeholder mit unterschiedlichem technischem Verständnis ist eine weitere Herausforderung. Schließlich erschwert das Fehlen standardisierter XAI -Methoden und -metriken es schwierig, verschiedene Ansätze zu bewerten und zu vergleichen:

1. Komplexität von AI -Modellen

Viele fortschrittliche KI -Modelle wie Deep -Learning -Netzwerke arbeiten durch komplexe Architekturen, die es schwierig machen, zu interpretieren, wie sie zu bestimmten Entscheidungen kommen. Dies gilt insbesondere bei der Arbeit mit großen Datensätzen, die ausgefeilte Verarbeitungstechniken erfordern.

2. Kompromiss zwischen Genauigkeit und Erklärung

Es gibt oft einen Kompromiss zwischen der Genauigkeit eines Modells und seiner Erklärung. Komplexere Modelle liefern tendenziell höhere Genauigkeit, aber auf Kosten weniger interpretierbar. Das richtige Gleichgewicht zwischen diesen beiden Faktoren ist eine kontinuierliche Herausforderung in den AI -Entwicklungsdiensten.

3. Mangel an Standardisierung

Derzeit gibt es keinen allgemein anerkannten Rahmen für die Erklärung der KI. Verschiedene Modelle, Tools und Ansätze sind verfügbar, aber ihre Wirksamkeit kann je nach spezifischem Kontext und Anwendung stark variieren. Diese mangelnde Standardisierung macht es schwieriger, eine erklärbare KI in der gesamten Branche umzusetzen.

Die Zukunft der erklärbaren KI

Erklärbare KI ist ein relativ neuer Forschungsbereich. Es ist jedoch ein schnell wachsendes Feld. Wenn KI -Modelle komplexer werden, wird der Bedarf an KI -Erklärung nur zunehmen. Es sind eine Reihe von Initiativen im Gange, um die Entwicklung und Annahme von erklärbarer KI zu fördern.

Zum Beispiel finanziert die Defense Advanced Research Projects Agency (DARPA) die Forschung zur erklärbaren KI. Die Europäische Union arbeitet auch an einer Reihe von Richtlinien für erklärbare KI.

Erklärbare KI ist ein wichtiges Instrument, um sicherzustellen, dass KI -Modelle fair, genau und vertrauenswürdig sind. Da KI in unserem Leben weiterhin eine immer wichtigere Rolle spielt, wird die erklärbare KI noch wichtiger.

Wie können Sie mit erklärbarer KI beginnen?

Wenn Sie mit erklärbarer KI beginnen möchten, stehen Ihnen mehrere Ressourcen zur Verfügung, um Ihnen zu helfen. Es gibt eine Reihe von Büchern und Artikeln zur erklärbaren KI. Es gibt auch eine Reihe von Open-Source-Tools, mit denen die Vorhersagen von AI-Modellen erklärt werden können.

AI -Entwicklungsdienste kann Ihnen auch mit erklärbarer KI helfen. Mehrere Unternehmen bieten KI -Entwicklungsdienste an, mit denen Sie erklärbare KI -Modelle entwickeln und bereitstellen können. Erklärbare KI ist ein wichtiges Thema für alle, die sich für KI interessieren. Das Verständnis der erklärbaren KI kann Ihnen helfen, fundierte Entscheidungen über die Verwendung von KI zu treffen.

Soziale Hashtags

#AiexPlainability #ArtificialIntelligence #Ai #ExplainableAi #aitransparecy #aidevelopment #AiAautomation #aiNNovation #futureofai

Möchten Sie KI -Software, die Automatisierung und intelligentere Entscheidungen vorantreibt?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.