Während wir in Richtung der modernen technologischen Welt voranschreiten, verarbeiten Sie die Automatisierung mit Hilfe von Entwicklung künstlicher Intelligenz Und Entwicklung des maschinellen Lernens ist zum Rückgrat verschiedener Branchen geworden, da sie Effizienz, Geschwindigkeit und Kosteneffizienz verspricht. Andererseits ist die Automatisierungsverzerrung zu einem erheblichen Anliegen geworden. Dies sollte ein Problem sein, da Unternehmen und Organisationen weiterhin die Prozessautomatisierung übernehmen, viele der potenziellen Konsequenzen, die diese automatisierten Systeme auf Fairness und Gleichheit haben, nicht bewusst sind.

Obwohl die Automatisierung Effizienz und Bequemlichkeit bringt, kann sie auch subtile, aber leistungsstarke Verzerrungen einführen, die Diskriminierung und Ungleichheit aufrechterhalten. Das Verständnis der Dynamik der Automatisierungsverzerrung ist von entscheidender Bedeutung, um diese Probleme anzugehen und Systeme zu schaffen, die Fairness für alle fördern.

Möchten Sie herausfinden, wie Sie unvoreingenommene automatisierte Systeme mit ethischer KI erstellen können?

Was ist Automatisierungsbias?

Die Automatisierungsverzerrung bezieht sich auf die Tendenz des Menschen, über automatisierte Systeme übertrieben, vorausgesetzt, ihre Entscheidungen sind korrekt, ohne sie in Frage zu stellen. In einer Welt, in der Maschinen oft als unfehlbar angesehen werden, kann dieses Vertrauen zu schädlichen Folgen führen.

In der Praxis bedeutet die Automatisierungsverzerrung, dass der Mensch ihre eigenen Urteile ignorieren und sich auf Entscheidungen eines automatisierten Systems ignorieren kann, selbst wenn diese Systeme fehlerhaft oder voreingenommen sind. Beispielsweise verlassen sich bei Einstellungsprozessen viele Unternehmen zunehmend auf automatisierte Systeme, um Lebensläufe zu überprüfen oder Kandidaten zu bewerten. Diese Systeme können zwar effizient sind, können jedoch Verzerrungen aufrechterhalten, wenn sie nach voreingenommenen Daten geschult werden.

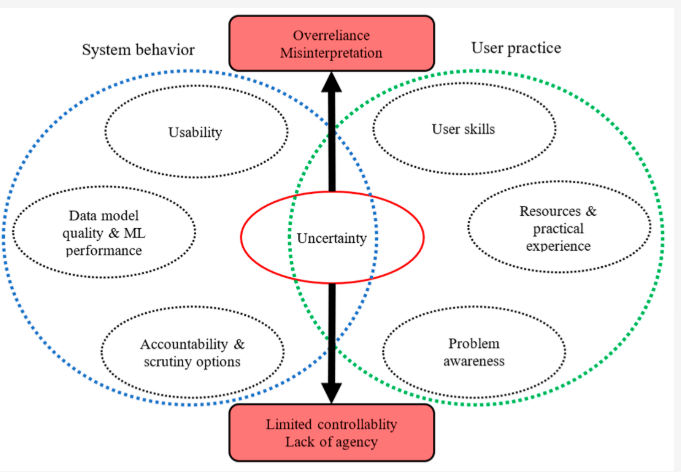

Quelle: MDPI zur Berichterstattung über fortgeschrittene ML und Data Mining

Infolgedessen können Bewerber aus unterrepräsentierten Gruppen unfair untersucht werden, obwohl ihre Qualifikationen anderen gleich oder anderen überlegen sind. Dies ist ein klares Beispiel dafür, wie Automatisierungsverzerrung direkt zur Ungleichheit beitragen kann.

Wie die Prozessautomatisierung die Diskriminierung verstärken kann

Während Prozessautomatisierung Kann den Vorgang rationalisieren und die Effizienz verbessern, kann auch die algorithmische Verzerrung verstärken, wenn sie nicht sorgfältig verwaltet werden. Die algorithmische Voreingenommenheit bezieht sich auf die systematische Bevorzugung oder Diskriminierung, die automatisierten Systemen inhärent sind. Wenn die zum Training dieser Algorithmen verwendeten Daten Verzerrungen enthalten-wie Geschlecht, Rasse oder sozioökonomische Vorurteile-, wird das automatisierte System diese Verzerrungen wahrscheinlich erben und sogar verstärken.

Die Auswirkungen der Automatisierungsverzerrung sind weitreichende und können schwerwiegende Konsequenzen für Einzelpersonen und die Gesellschaft insgesamt haben. Es kann zu:

- Reduzierte Möglichkeiten: Voreingenommene Algorithmen können den Zugang zu Beschäftigungs-, Bildungs- und Finanzdienstleistungen für bestimmte Gruppen einschränken.

- Verstärkung von Stereotypen: Automatisierte Systeme, die Stereotypen verewigen, können bereits benachteiligte Gemeinden marginalisieren.

- Erosion des Vertrauens: Da die Menschen sich des Potenzials für Verzerrungen in automatisierten Systemen bewusst werden, kann dies zu einem Vertrauensverlust in Institutionen und Technologien führen.

Überlegen Sie, wie sich KI und Ungleichheit in realen Szenarien überschneiden. Im Strafjustizsystem werden Prädiktivalgorithmen verwendet, um die Wahrscheinlichkeit einer Wiederholung zu bewerten. Wenn die Daten, auf die diese Algorithmen beruhen, jedoch historische Verzerrungen widerspiegelt, wie z. B. überproportional höhere Verhaftungsraten in bestimmten Gemeinden, können die KI -Verzerrung in diesen Systemen zu unfairen Ergebnissen führen, z. B. längere Sätze für Minderheiten. Dies ist ein starkes Beispiel dafür, wie die Automatisierungsverzerrung gesellschaftliche Ungleichheiten aufrechterhalten kann.

In ähnlicher Weise kann die Prozessautomatisierung im Gesundheitswesen unbeabsichtigte Konsequenzen haben. Wenn ein Algorithmus in Daten geschult wird, die bestimmte demografische Daten zu überrepräsentieren und gleichzeitig andere unterzuziehen, kann das System ungenaue Vorhersagen oder Empfehlungen abgeben. Dies könnte zu Unstimmigkeiten in der medizinischen Versorgung führen, wobei marginalisierte Gruppen eine minderwertige Behandlung erhalten oder nicht rechtzeitig diagnostiziert werden.

Einige bekannte Fälle von AI -Algorithmus -Vorurteilen

Es ist wahr, dass es manchmal zu unfairen Ergebnissen führen kann. Hier ist Ein Bericht des Greenlining Institute Das zeigt einige Beispiele dafür, wie Algorithmen in verschiedenen Situationen voreingenommen wurden:

Regierungsprogramme:

- Michigans Arbeitslosensystem: Michigan verwendete einen Algorithmus, um Betrug in Arbeitslosenansprüchen zu erkennen. Leider beschuldigte das System fälschlicherweise Tausende von Menschen, was zu Geldstrafen, Insolvenzen und sogar Zwangsvollstreckungen führte. Es stellte sich heraus, dass der Algorithmus oft Fehler machte und es niemanden gab, der seine Entscheidungen überprüfte.

- Arkansas Medicaid: Ein Algorithmus wurde verwendet, um zu bestimmen, wer sich für Medicaid -Vorteile in Arkansas qualifizierte. Dies führte dazu, dass viele Menschen den Zugang zu einer wesentlichen medizinischen Versorgung verlor. Das Problem? Der Algorithmus hatte Fehler, und es war für die Menschen sehr schwierig, gegen seine Entscheidungen Berufung einzulegen.

Anstellung:

- Einstellungswerkzeug von Amazon: Amazon versuchte, einen Algorithmus zu erstellen, um die besten Mitarbeiter einzustellen. Der Algorithmus bevorzugte jedoch Männer gegenüber Frauen. Es scheint, dass der Algorithmus aus früheren Einstellungsdaten gelernt hat, die möglicherweise Verzerrungen enthalten haben.

Gesundheitspflege:

- Ungleiche Behandlung: Selbst wenn Algorithmen fair sind, können sie auf eine Weise verwendet werden, die eine Verzerrung erzeugt. Zum Beispiel verwendete ein Krankenhaus einen Algorithmus, um zu entscheiden, welche Patienten zusätzliche Vorsorge benötigten. Leider bedeutete die Art und Weise, wie sie es verwendeten, dass schwarze Patienten viel kranker sein mussten als weiße Patienten, um die gleiche Aufmerksamkeit zu erhalten.

Ausbildung:

- Einstufung von Vorurteilen in Großbritannien: Während der Pandemie nutzten Schulen in Großbritannien einen Algorithmus, um den Schülern Noten zu geben, wenn Prüfungen abgesagt wurden. Der Algorithmus gab jedoch Schülern aus Familien mit niedrigerem Einkommen niedrigere Klassen und zeigt, wie Algorithmen manchmal bestehende Ungleichheiten verstärken können.

Gehäuse:

- Unfaire Screening: Viele Vermieter nutzen Algorithmen, um potenzielle Mieter zu überprüfen. Ein solcher Algorithmus hinderte eine Mutter unfair daran, eine Wohnung zu mieten, weil ihr Sohn eine geringfügige Straftat in seiner Bilanz hatte, die später entlassen wurde.

- Desinvestition in Detroit: In Detroit wurde ein Algorithmus verwendet, um zu entscheiden, welche Stadtteile Investitionen und Verbesserungen erhalten sollten. Dies führte dazu, dass vorwiegend schwarze und schlechte Stadtteile Ressourcen verweigert wurden und zeigten, wie Algorithmen bestehende soziale Probleme verschlimmern können.

Diese Beispiele zeigen, dass Algorithmen zwar leistungsstarke Werkzeuge sein können, sie jedoch sorgfältig entworfen und verantwortungsbewusst verwendet werden müssen, um Ungerechtigkeit und Diskriminierung zu vermeiden. Wir müssen sicherstellen, dass Algorithmen verwendet werden, um Fairness und Gleichheit zu fördern und nicht vorhandene Vorurteile aufrechtzuerhalten.

Angriffe Automatisierungsbias und algorithmische Voreingenommenheit

Die Bekämpfung der Automatisierungsverzerrung und ihr Potenzial zur Aufrechterhaltung der algorithmischen Verzerrung erfordert einen facettenreichen Ansatz. Erstens ist es wichtig sicherzustellen, dass die zum Ausbilden von Algorithmen verwendeten Daten vielfältig und repräsentativ für alle demografischen Gruppen sind. Ohne unterschiedliche Daten riskieren Algorithmen, bestehende Verzerrungen zu verstärken, anstatt sie anzusprechen.

Zweitens müssen Transparenz und Rechenschaftspflicht in KI- und Automatisierungssysteme eingebaut werden. Entwickler sollten sich darüber im Klaren sein, wie diese Systeme funktionieren und offen für die Prüfung stehen. Regelmäßige Audits von Algorithmen können dazu beitragen, Bereiche zu identifizieren, in denen Vorspannungen vorhanden sein können, und Korrekturmaßnahmen können implementiert werden, bevor diese Verzerrungen schädliche Auswirkungen haben.

Schließlich können KI und Ungleichheit minimiert werden, indem Fairness und Inklusivität während der gesamten Design- und Einsatzphasen fördert. Durch die Integration ethischer KI -Praktiken können Unternehmen sicherstellen, dass ihre Prozessautomationslösungen nicht nur effizient, sondern auch gerecht und gerecht sind.

Identifizieren und adressieren Sie die Automatisierungsverzerrung in Ihren Prozessen mit unserer Expertenanleitung

Die Rolle von WeblineIndia bei der Bekämpfung der Automatisierungsbias

Für Unternehmen, die die Macht der Prozessautomatisierung nutzen und gleichzeitig Fairness, Transparenz und ethische Verantwortung sicherstellen möchten Verweigerung des Shores -Modells Outsourcing. Als Experten für die Integration modernster Technologie in ethische Überlegungen zeichnen sich WebineIdindia bei der Bewältigung der Herausforderungen der Automatisierungsverzerrung aus. Sie sind verpflichtet, KI-gesteuerte Lösungen zu erstellen, die die algorithmische Verzerrung minimieren und die KI- und Ungleichheitsbewusstsein fördern.

Der Ansatz von WebineIndia ist insofern einzigartig, als er die Vorteile der Automatisierung mit Schwerpunkt auf Algorithmusethik in Einklang bringt und sicherstellt, dass die Technologie verantwortungsbewusst eingesetzt wird und die Diskriminierung nicht verewigt. Egal, ob es sich um eine kundenspezifische Software entwickelt, implementiert Prozessautomatisierungslösungen oder Beratung von Strategien zur Minderung von KI -Voreingenommenheit und des Teams von WebineIndia priorisiert Qualität, Fairness und soziale Verantwortung.

Bereit, unvoreingenommene Softwarelösungen zu bauen, die von KI betrieben werden?

Wählen Sie WebineIndia und wir können sicher sein, dass Sie mit einem Dienstleister zusammenarbeiten, der nicht nur die technischen Feinheiten von KI versteht, sondern auch ethische Überlegungen priorisiert. Gemeinsam können wir eine Zukunft aufbauen, in der Technologie für alle arbeitet, nicht gegen sie.

Obwohl die Prozessautomatisierung ein immenses Potenzial bietet, ist es entscheidend, die Risiken durch Automatisierungsvoreingenommenheit zu bewusst, für die WebineIndia sich kümmert. Wir können sicherstellen, dass KI- und Automatisierungssysteme Werkzeuge für Gutes sind und Fairness, Inklusivität und Gleichheit in allen Lebensbereichen fördern, indem wir verstehen, wie die algorithmische Voreingenommenheit funktioniert und Schritte unternimmt, um sie anzugehen. Kontaktieren Sie uns Und wir helfen Ihnen dabei, diese Herausforderung zu steuern und Lösungen zu schaffen, die die höchsten Standards der ethischen Verantwortung einhalten.

Soziale Hashtags

#AutomationBias #EthicalAI #BiasInTech #StopAlgorithmicDiscrimination #AI #Automation #AIAutomation #SoftwareSolutions

Möchten Sie inklusive und faire KI-gesteuerte Lösungen für Ihr Unternehmen aufbauen?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.