Fitness-Tracking-Apps haben sich weit über einfache Stufenzähler oder GPS-basierte Aktivitätsprotokolle hinaus entwickelt. Die Benutzer von heute erwarten eine umfangreiche soziale Interaktivität, Wettbewerbs-Gamifizierung, Echtzeitdatensynchronisierung und nahtlose Integration in ein wachsendes Ökosystem von Wearables und Gesundheitsplattformen. Strava setzte einen Benchmark in diesem Bereich, indem er sportliche Aktivitäten mit sozialem Engagement – Bestandteile, Herausforderungen, Kommentare, Clubs und sogar virtuelle Rennen – zusammenfasste, die alle in eine Slick -UX eingewickelt sind, die sowohl Leistung als auch Gemeinschaft priorisiert.

Das Entwerfen eines Systems wie dieser geht weit über die grundlegenden CRUD -Operationen für Benutzer -Trainingseinheiten hinaus. Es erfordert eine robuste Architektur, die umgehen kann:

- Hochfrequenzgeo-Location-Updates von Millionen von gleichzeitigen Benutzern

- Echtzeit-Feed-Generierung und Aktivitätsübertragung zu Follower-Netzwerken

- Skalierbare Abfragen mit sozialer Grafik mit geringer Latenz

- Medienspeicher und Abruf (z. B. Routenkarten, Fotos, Abzeichen)

- Ereignisgesteuerte Datenpipelines für Computersegmente, Bestenlisten und Herausforderungen

- Sicherheits- und Datenschutzkontrollen über komplexe Datenaustauschpräferenzen hinweg

Die Herausforderung besteht darin, ein Backend zu architekten, das ein schnelles, ansprechendes und sozial reichhaltiges Erlebnis unterstützt und gleichzeitig flexibel genug bleibt, um sich in Fitnessgeräte von Drittanbietern zu integrieren, Community-Moderation zu unterstützen und neue Funktionen zu entwickeln, ohne alte zu brechen.

Dieser technische Deep -Tauchgang bricht die Architektur eines solchen Systems ab. Es beschreibt die Kernanforderungen, Designs für Skalierbarkeit und Reaktionsfähigkeit in Echtzeit, Datenmodelle für benutzergenerierte Inhalte und Infrastrukturmuster, um eine soziale Fitnessplattform zu unterstützen, die auf Millionen von Benutzern wachsen kann, ohne die Leistung oder Zuverlässigkeit zu beeinträchtigen.

Systemanforderungen

1. Funktionsanforderungen

Die Kernfunktionen der Fitness -App müssen sowohl Aktivitätsverfolgung als auch soziales Engagement im Maßstab unterstützen. Zu den wichtigsten funktionalen Anforderungen gehören:

- Benutzerverwaltung: Anmeldung, Authentifizierung, Profilbearbeitung und Kontowiederherstellung.

- Aktivitätsaufzeichnung: Log-GPS-basierte Workouts (z. B. Läufe, Fahrten), stützende manuelle Eingabe und erfassen Metadaten wie Entfernung, Tempo, Höhen, Herzfrequenz und Getriebe.

- Echtzeitdatensynchronisierung: Stream -Standort- und Sensordaten von mobilen oder tragbaren Geräten mit geringer Latenz.

- Soziale Grafik: Befolgen Sie die Mechanismen, die Vorschläge für Freunden und die Sichtbarkeit von Datenschutzaktivitäten (z. B. private, nur Anhänger, öffentliche Aktivitäten).

- Aktivitätsfutter: Dynamische Zeitleiste, die Workouts von folgenden Benutzern zeigt, einschließlich Likes, Kommentare und Umstände.

- Herausforderungen und Bestenlisten: Erstellen Sie zeitboxierte Wettbewerbe (z. B. „Ride 100 km in 7 Tagen“), verfolgen Segment-Bestrebungen und berechnen Sie die Ranglisten asynchron.

- Medienunterstützung: Laden und anzeigen Sie Fotos, Routenhitze und persönliche Leistungen (z. B. Abzeichen, Meilensteine).

- Benachrichtigungen: Echtzeit-Push- und In-App-Benachrichtigungen für Likes, Kommentare, neue Follower und Challenge-Updates.

- Integration der 3. Parteien: Synchronisieren Sie mit Apple Health, Google Fit, Garmin und anderen Fitness -Ökosystemen.

2. nicht funktionierende Anforderungen

Um die Interaktion in Echtzeit und wachsende Benutzerbasis zu unterstützen, muss das System strenge nicht funktionsfähige Anforderungen erfüllen:

- Skalierbarkeit: Horizontal skalierbare Dienste und Datenspeicher, um Millionen von aktiven Benutzern und Terabyte von Geo-Temporal-Daten zu verarbeiten.

- Niedrige Latenz: Reaktionszeit unter Sekundenzweig für soziale Interaktionen und Echtzeit-Kartenrendern.

- Verfügbarkeit: 99,9%+ Betriebszeit mit Fehlertoleranz über Regionen und Zonen hinweg.

- Sicherheit und Privatsphäre: OAuth2-basierte Authentifizierung, Granularzugriffskontrolle, verschlüsselter Speicher und benutzergesteuerte Freigabeinstellungen.

- Erweiterbarkeit: Modulare Service-Grenzen zur Unterstützung zukünftiger Funktionen wie virtuellen Rennen, Club-basierten Chats oder Live-Coaching.

- Datenkonsistenz: Eine eventuelle Konsistenz ist in Feeds und Bestandteilen akzeptabel, aber für Transaktionen wie Kontoeinstellungen oder Prämienkäufe ist eine starke Konsistenz erforderlich.

- Offline -Unterstützung: Ermöglichen Sie den Benutzern die Aufzeichnung und Schlangeaktivitäten, wenn sie offline sind, mit automatischer Synchronisierung bei der Wiederverbindung.

3. Einschränkungen und Annahmen

- Mobile Apps (iOS und Android) werden die Hauptkunden sein. Die Webschnittstelle ist sekundär.

- Standort- und Gesundheitsdaten müssen gemäß den regionalen Compliance -Vorschriften bearbeitet werden (z. B. GDPR, HIPAA, falls zutreffend).

- Die Mehrheit der Benutzer synchronisiert 1 bis 2 Aktivitäten pro Tag, aber Stromnutzer und Integrationen können die Einnahmeraten während Ereignissen oder Herausforderungszeiten ansprechen.

- Cloud-native Bereitstellung; Die Architektur setzt die Verwendung von verwalteten Cloud -Diensten für Rechen, Speicher und Streaming voraus.

Anwendungsfall / Szenario

1. Geschäftskontext

Die Fitness -App richtet sich an eine breite Bevölkerungsgruppe – von Gelegenheitswanderern bis hin zu Wettbewerbsradfahrern -, betont jedoch das Engagement der Gemeinschaft über die individuelle Verfolgung. Betrachten Sie es als einen Hybrid zwischen einem Personal Trainer und einem sozialen Netzwerk. Ziel ist es, die wiederkehrende Nutzung durch Wettbewerb, soziale Rechenschaftspflicht und Gamified -Fortschritte voranzutreiben und letztendlich die Bindung und die Abonnementumwandlung zu erhöhen.

In-App-Monetarisierung kann umfassen:

- Premium -Abonnements für fortschrittliche Analysen, Live -Segmente und tiefere Schulungenerkenntnisse

- Markenherausforderungen oder gesponserte Wettbewerbe

- In-App-Ausrüstung Promotion (z. B. Affiliate-Marktplatz für Schuhe, Fahrräder, Wearables)

Die App muss daher eine robuste Grundlage für Echtzeit-Leistungsmetriken ermöglichen und gleichzeitig ansprechende, sozial dynamische Erlebnisse bieten, auf die Benutzer täglich zurückkehren-auch wenn sie an diesem Tag nicht trainieren.

2. Personas und Nutzungsmuster

- Solo -Athleten: Benutzer, die ihre Workouts verfolgen, vergleichen die vergangenen Leistung und gelegentlich beitreten globalen Herausforderungen oder Segmenten.

- Soziale Enthusiasten: Hoch engagierte Benutzer, die häufig posten, die Aktivitäten von Freunden kommentieren und von der Interaktion der Community leben.

- Clubmanager: Power -User, die Gruppenereignisse koordinieren, private Bestenlisten verwalten und soziale Räume innerhalb von Clubs moderieren.

- Daten Nerds: Premium-Abonnenten, die sich für Herz-Rate-Zonen, Leistungskurven, Wiederherstellungsmetriken und Datenexports interessieren.

3. Erwartete Skala

Das System sollte für die Unterstützung ausgelegt sein:

- 10 m+ registrierte Benutzer

- 2–3m Maus (monatliche aktive Benutzer) mit ~ 500.000 DUS (tägliche aktive Benutzer)

- 10 m+ Aktivitäts -Uploads pro Monat, mit Spitzen an Wochenenden und großen Herausforderungsveranstaltungen

- 500K+ gleichzeitige Benutzer während der Spitzenperioden

- Milliarden von Datenpunkten pro Monat in GPS, Höhen-, Herzfrequenz- und Bewegungssensoren

- Millionen von täglichen Futteranfragen, sozialen Interaktionen und Echtzeitbenachrichtigungen

Um diese Anforderungen gerecht zu werden, muss die Architektur für les-hungrige soziale Workloads, Bursty-Datenverkehr aus Aktivitäts-Uploads und asynchroner Verarbeitung mit hohem Durchsatz für Segmentanpassungen und Ranglisten-Updates optimieren.

Benötigen Sie Hilfe bei der Gestaltung Ihrer eigenen Fitness oder Ihrer sozialen App?

Aufbau einer Social-First-Fitness-Plattform, die sich auf Millionen von Benutzern skaliert, dauert mehr als sauberer Code-es wird vom ersten Tag an die richtige Architektur benötigt.

Möchten Sie kompetente Anleitungen zum Entwerfen von Leistung, Echtzeit-Synchronisierung und Benutzerneingagement im Maßstab?

Hochrangige Architektur

Die Architektur muss die Einnahme von Aktivitäten in Echtzeit, die Verteilung der sozialen Futtermittel, die Geospatialanalyse und die Benutzerinteraktion effizient unterstützen. Dies erfordert einen modularen, serviceorientierten Ansatz mit gut definierten Grenzen zwischen Kernsystemen wie Aktivitätsverfolgung, Benutzerverwaltung, sozialer Diagrammverarbeitung und Benachrichtigungsbereitstellung.

1. Komponentenübersicht

Das System ist um die folgenden Hauptkomponenten strukturiert:

- API -Tor: Zentraler Einstiegspunkt für alle Kundenkommunikation. Verwendet die Authentifizierung, die Ratenlimitierung und leitet den Verkehr an interne Dienste weiter.

- AUTH -Service: Verwaltet OAuth2-Flows, Token-Emission, Sitzungsmanagement und Integration in Identitätsanbieter von Drittanbietern (z. B. Apple, Google).

- Benutzerprofildienst: Speichert persönliche Informationen, Einstellungen, Ausrüstung und Datenschutzeinstellungen.

- Aktivitätsdienst: Verarbeitet GPS-basierte Trainingsaufnahme, Analyse der Route, Aktivitätsvalidierung und Metadatenextraktion (z. B. Tempo, Höhengewinn).

- Futtermittelservice: Erzeugt und speichert Aktivitätsfeeds, verarbeitet Updates für soziale Grafiken und behandelt Fan-Out für neue Aktivitätsbeiträge.

- Social Graph Service: Verwaltet Follower -Beziehungen und berechnet die Sichtbarkeit für Aktivitäten und Herausforderungen.

- Challenge & Rangingboard Engine: Berechnet Rankings, behandelt die Herausforderung Logic und aktualisiert virtuelle Trophäen und Segmente.

- Medienservice: Griff Bild -Uploads (Fotos, Routenkarten), CDN -Caching und Zugriffskontrolle.

- Benachrichtigungsdienst: Veröffentlicht Echtzeit- und Batch-Benachrichtigungen über WebSockets, FCM/APNs oder In-App-Posteingänge.

- Analytics -Pipeline: Verarbeitet Aktivitätsströme für Erkenntnisse, Trenderkennung und Athletenempfehlungen.

- Administrator & Moderationsportal: Tools zum Verwalten von Missbrauchsberichten, Herausforderungen für die Erstellung von Analysen und Analyse -Dashboards.

2. High-Level-Architekturdiagramm

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Datenflusszusammenfassung

Wenn ein Benutzer ein Training startet:

- Die mobile App streams GPS- und Sensordaten über ein WebSocket oder eine batchierte API -Hochladen in die Aktivitätsdienst.

- Der Dienst analysiert die Daten, speichert das Training und gibt ein Ereignis an die Futtergenerator.

- Der Social Graph Service bestimmt, wer die Aktivität sehen kann.

- Das Feed -Element wird über die gespeichert und an relevante Benutzer weitergeleitet Benachrichtigungsdienst.

- Gegebenenfalls wird die Aktivität von der bewertet Rangliste Motor Für die Herausforderung für die Herausforderung und die Rangluftaktualisierungen.

- Fotos und Routenvisualisierungen werden an die gesendet Medienservice und zwischen einem CDN zwischengespeichert.

Dieses modulare Design unterstützt sowohl die horizontale Skala als auch die isolierte Serviceentwicklung. Es ermöglicht auch Echtzeit-Fan-Out für Feeds und Benachrichtigungen mit ereignisorientierter Kommunikation (z. B. Kafka oder NATs).

Datenbankdesign

1. Kerndatenmodelle und ERD -Übersicht

Das System verwendet einen Polyglot-Persistenzansatz-relationale Datenbanken für die Transaktionsintegrität, Zeitreihen/NoSQL für Aktivitätsdaten sowie Diagramm- oder In-Memory-Speicher für soziale Abfragen mit leistungsstarker Leistung.

Haupteinheiten:

- Benutzer: Profilinformationen, AUTH -Einstellungen, Einstellungen, Abonnementstufe

- Aktivität: Trainingsdaten einschließlich GPS -Punkte, Metriken, Ausrüstung, Medien

- Folgen: Nachfolgerbesprechungs- und Sichtbarkeitsregeln

- FeedItem: Darstellbare Ereignisse, die an Benutzer gebunden sind (z. B. veröffentlichte Aktivität, Kommentar, Abzeichen)

- Herausforderung: Metadaten und Staat für Gruppenwettbewerbe

- Rangliste: Herausforderung oder Segmentposition und Metriken

Entity -Beziehungsdiagramm (konzeptionell):

[Benutzer] ├── ID (PK) ├── Name, E-Mail, Avatar-URL └── settings_json [Aktivität] ├── ID (PK) ├── Benutzer-ID (FK → Benutzer) ├── Typ, Startzeit, Dauer ├── Distanz, Höhe, durchschnittliche Std. ├── Geodatenreferenz (FK → GeoStore) └── Sichtbarkeit (öffentlich / Follower / privat) [GeoStore] (externer Speicherindex oder S3-Referenz) ├── ID (PK) ├── Aktivitäts-ID (FK → Aktivität) └── GPS-Daten (Array oder Dateizeiger) [Folgen] ├── Follower-ID (FK → Benutzer) ├── Follower-ID (FK → Benutzer) └── erstellt am [FeedItem] ├── ID (PK) ├── Akteur-ID (FK → Benutzer) ├── Verb („gepostet“, „kommentiert“, „geliked“) ├── Objekt-ID (z. B. Aktivitäts-ID, Kommentar-ID) └── Ziel-Benutzer-ID (FK → Benutzer) [Challenge] ├── ID (PK) ├── Name, Beschreibung, Typ ├── Startdatum Enddatum └── Sichtbarkeit, Regel-JSON [Leaderboard-Eintrag] ├── ID (PK) ├── Challenge-ID (FK → Challenge) ├── Benutzer-ID (FK → Benutzer) ├── Metrikwert (Distanz, Dauer) └── Rang

2. Auswahl der Datenbanktechnologie

Jede Datendomäne ist für ihr eigenes Zugriffsmuster optimiert:

- PostgreSQL: Kanonische Datenquelle für Benutzerprofile, Aktivitäten, Futtermetadaten und Herausforderungen. Hervorragend für die Transaktionsintegrität und die Durchsetzung der ausländischen Schlüssel.

- Timescaledb / InfluxDB: Für GPS-Punkteinnahme, Aktivitätstelemetrie und Zeitreihenanalyse (z. B. Tempo im Laufe der Zeit, HR-Zonen).

- S3 + CD: Wird zum Speichern von RAW-GPS-Tracks, Routenbildern und hochgeladenen Medien (mit sicherem vorschriebenem URL-Zugriff) verwendet.

- Redis / Memcached: Zum schnellen Abrufen von Besten

- NEO4J oder DGRAPH (optional): Für komplexe soziale Graphen -Traversal-, Club -Mitgliedschafts- und gegenseitige Follower -Vorschläge im Maßstab.

3. Multi-Tenancy- und Partitionierungsstrategie

- Sharding: Aktivitäten und Feed -Elemente werden durch Benutzer -ID oder Region ID geschützt, um die horizontale Skalierung zwischen Partitionen zu ermöglichen.

- Zeitbasierte Partitionierung: GPS -Telemetrie und Bestenlisten werden in monatliche/wöchentliche Partitionen für Alterung und Leistung aufgeteilt.

- Weiche Multi-Messen: Clubs oder Organisationen (z. B. laufende Gruppen, Radsportteams) arbeiten im globalen Namespace, können jedoch bei Bedarf Scoped -Abfragen (über Temant_ID) erhalten.

4. Replikation und hohe Verfügbarkeit

- PostgreSQL: Eingesetzt mit Hot Standby Replicas und Wal -Versand für Failover.

- Redis: Konfiguriert mit Sentinel für hohe Verfügbarkeit und automatisierte Master -Wahl.

- Medien & Geostore: Die Objektspeicherung wird über Regionen hinweg repliziert und über ein globales CDN für den Zugriff mit geringem Latenz geliefert.

Dieses Datenbankdesign sorgt für eine flexible Schemaentwicklung, die schnelle Aktivitätsaufnahme und die skalierbare Unterstützung für soziale Arbeitsbelastungen und Analysen – und bewahrt gleichzeitig die referenzielle Integrität, wo es am wichtigsten ist.

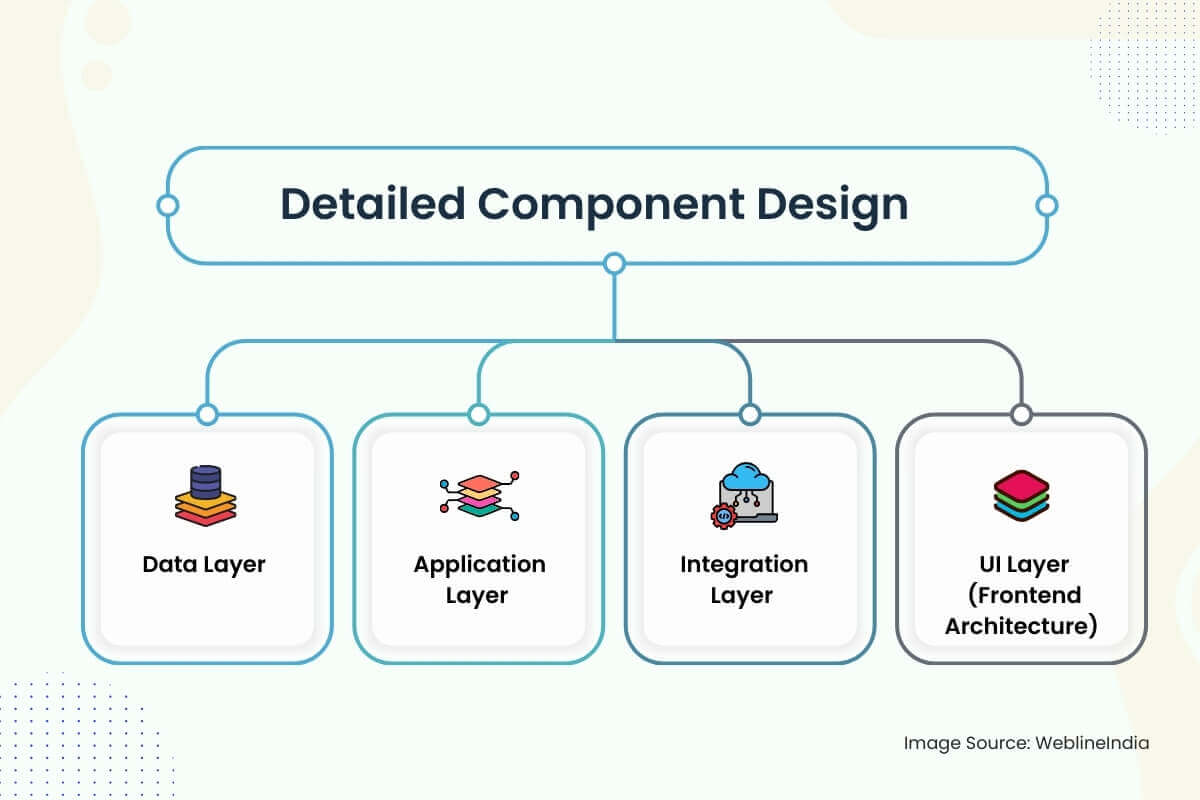

Detailliertes Komponentendesign

1. Datenschicht

- Schemastrategie: Schemas sind auf klare Domänengrenzen entwickelt: Benutzer, Aktivitäten, Feeds, soziale Grafiken und Herausforderungen. Spalten wie “Sichtbarkeit”, “Status” und “Activity_Type” verwenden auflistelige Typen für die Indexierungseffizienz. UUIDs werden gegenüber autoinkrementierten Ganzzahlen bevorzugt, um heiße Schlüsselprobleme in verteilten Geschäften zu vermeiden.

- Datenzugriff: Der Zugriff auf Kerndaten durchläuft die Repositories für dünne Service-Layer, die Richtlinien zur Zugriffskontrolle (z. B. Sichtbarkeitsprüfungen für Aktivitäten) durchsetzen. Die Lesevorgänge werden über materialisierte Ansichten und vorgezogene Feed-Schnappschüsse optimiert. Schreibhaarige Wege wie Aktivität Aufnahme verwenden Schreibwarteschlangen und Schüttgut-Pipelines, um die Aufnahmespikes zu reibungslosen.

- Validierung: Die Eingabevalidierung erfolgt auf mehreren Ebenen-Durchsetzung von Edge-Schema über OpenAPI oder GraphQL, eine tiefe Validierung in Serviceschichten (z. B. gültige GPS-Punkte, nicht überlappende Zeitstempel) und asynchrone Gesundheitsprüfungen zu Telemetriedaten über Hintergrundjobs.

2. Anwendungsschicht

Servicedesign: Jede Hauptdomäne (Benutzer, Aktivität, Feed, Benachrichtigung, soziales Diagramm) wird als isolierter Mikroservice implementiert. Dienstleistungen enthüllen sowohl GRPC- als auch REST-Endpunkte-Ruhe für öffentliche APIs, GRPC für die Kommunikation zwischen den Dienstleistungen. Prinzipien der sauberen Architektur getrennt Domänenlogik vom Transport- und Infrastrukturcode.

Frameworks:

- Go oder Rost für leistungskritische Dienste (Aktivität, Futtermittel, Rangliste)

- Node.js oder Python für Klebercode, Integrationen und asynchronisierte Workflows

- GraphQL Server (Apollo oder Hasura) für Front-End-Aggregation und deklarative Abfrage

Authentifizierung: JWT -Token werden über OAuth2 -Ströme ausgegeben. Service-to-Service-Anrufe verwenden signierte interne Token mit rollenbasierten Scopes.

Ratenbegrenzung und Kontingente: Implementiert über Redis-unterstützte Token-Eimer am Gateway und im Benutzer der Benutzerebene (insbesondere für Aktivitäts-Uploads).

3. Integrationsschicht

Nachrichtenschwänze: Kafka oder NATS wird für asynchronisierte Workflows verwendet-Aktivitätsverarbeitung, Futtermittel-Out, Segment-Matching und Benachrichtigungsveröffentlichung. Idempotent -Handler mit starken Liefergarantien werden verwendet, um doppelte Beiträge oder Ranglisteneinträge zu verhindern.

Synchronisierung von Drittanbietern: OAuth -Integrationen mit Garmin, Fitbit, Apple Health usw. werden über eine Kombination aus Hintergrund Poller + Webhook ausgeführt. Neue Daten werden über die Aktivitätspipeline der Aktivität in die Warteschlange gestellt und verarbeitet.

Veranstaltungstypen:

Aktivität.Created→ Fan-Out, um den Service zu ernähren, die Follower benachrichtigenChallenge.joed→ Berechtigung prüfen, Bestenliste einfügenuser.foly→ Diagramm aktualisieren, Feed aktualisieren, Willkommensbenachrichtigung in die Warteschlange stellen

4. UI -Schicht (Frontend -Architektur)

App Stack: Reagieren Sie nativ für plattformübergreifende mobile Apps mit TypeScript- und Redux-Toolkit für die staatliche Verwaltung. Web App verwendet Next.js für SSR/ISR mit dem Tailwind -Dienstprogramm und den GraphQL -Abfragen zum Backend.

Sicherheitsbedenken:

- Client -Geheimnisse sind nie eingebettet – OAuth PKCE Flow ist obligatorisch

- Alle API-Anrufe erfordern signierte Token, und die öffentlich ausgerichteten Endpunkte werden durch Rate, Herkunft und Rolle gefiltert

- Die GEO -Daten werden sandkäfig pro Sichtbarkeitseinstellung – Private Aktivitäten werden von Wärme-, Futter- und Segmentberechnungen ausgeschlossen

Echtzeit-Funktionen: WebSockets oder SSE werden verwendet, um Benachrichtigungen, Herausforderungsstatus und Feed -Updates zu überschreiten. Fallback zu langen Umfragen zu eingeschränkten Netzwerken. Der Frontend unterhält einen lokalen SQLite -Cache für die Protokollierung von Offline -Aktivitäten.

Etwas Ähnliches architektieren?

Das Entwerfen von Echtzeit-, Geo-bekannt-,-interaktiven Plattformen bietet Präzision über den Datenfluss, die Ereignisbehandlung und die mobile Architektur.

Wenn Sie etwas Ehrgeiziges aufbauen-wie eine soziale Fitnessplattform, eine tragbare Integration oder eine Echtzeit-Feed-, können wir Ihnen gerne von Anfang an helfen.

Skalierbarkeit Überlegungen

1. Anwendungsschicht Skalierung

- Staatenlose Dienste: Alle Kerndienste (Aktivität, Feed, Herausforderung usw.) sind zustandslos und horizontal skalierbar. Jede Instanz ist Einweg und von einem Lastausgleichsbalancer. Die Prinzipien für geteilte Nichts stellen sicher, dass Instanzen nicht auf den örtlichen Staat beruhen.

- Automatisch scaling: K8S-basierte horizontale POD-Autoscaling (HPA) wird für Dienste verwendet, die auf CPU-, Speicher- und Warteschlangentiefenmetriken basieren. Für latenz-sensitive Dienste (wie Feed oder Benachrichtigung) können benutzerdefinierte Metriken (z. B. Ereignisverzögerung) eine schnellere Skala auslösen.

- API -Gateway -Drossel: Client- und IP-basierte Ratengrenzen verhindern API-Überschwemmungen. Die Burst-Toleranz wird unter Verwendung von Redis-Backed-Gleitfenster oder undichten Bucket-Algorithmen unterstützt.

2. Datenschicht Skalierung

Optimierung lesen: Häufig zugegriffene Daten (z. B. jüngste Aktivitäten, Ranglisten -Schnappschüsse) werden aggressiv in Redis mit TTLs und LRU -Räumung zwischengespeichert. PostgreSQL Read Replicas werden basierend auf dem Verkehr skaliert, um Analysen und UI -Abfragen zu entlasten.

Sharding -Strategien:

- Aktivitätsdaten: Sharded durch Benutzer -ID über Partitionen oder logische Cluster (z. B. Aktivität_01, Aktivität_02, …)

- Elemente Feed: Durch Schauspieler -ID und Empfänger -ID mit zusammengesetzten Indizes für schnelle Lookups verteilt

- Geostore: Verwendet die S3-Key-Präfixierung nach Region und Zeitstempel für optimierte Objektliste und kostengünstige Tiering

3. Futter- und Social-Graph-Fan-Out

Die Futtermittelgenerierung ist eine große Skalierbarkeitsherausforderung in sozialen Plattformen. Das System verwendet einen Hybrid-Fan-Out-Ansatz:

- Fan-Out-on-Write (primär): Wenn ein Benutzer eine Aktivität veröffentlicht, drückt der Feed -Service ihn in vorberechtigte Futterzeilen für Follower.

- Fan-Out-on-Read (Fallback): Für Nutzer (Prominente, Influencer) werden Feeds zur Abfragezeit mit Pagination von von Kafka unterstützten Ereignisprotokollen oder Feed-Index-Tabellen erstellt.

Futterspeicherung: Implementiert über schreiboptimierte Tabellen oder Spaltenfamilienspeicher (z. B. Scylladb oder Cassandra-ähnliche Geschäfte) mit TTLs für kurzfristige Ereignisse und vorgefertigte JSON für schnelle Flüssigkeitszufuhr.

4. Challenge und Rangleichboardverarbeitung

- Batch -Computer: Bestenlisten werden in Stapeln unter Verwendung einer Stream -Verarbeitungs -Engine (z. B. Apache Flink, Spark -Streaming) berechnet. Segmentübereinstimmungen und Herausforderungsvalidierungen werden asynchron aus der Aktivitätsaufnahme unter Verwendung dauerhafter Kafka -Themen ausgeführt.

- Fensteraggregation: Challenge -Statistiken werden (täglich, wöchentlich) bester Schadensfenster, um vollständige Verlaufscans zu verhindern und den Speicherdruck zu verringern. Aggregierte materielle Ansichten werden pro Herausforderung und Segment indiziert.

5. Geo- und Sensordatenaufnahme

- Hochfrequenzaufnahme: GPS-Punkte werden in Stapel in Zeitreihenspeicher (oder S3-Dateien mit Indexierung) geschrieben und punktiert, um Speicherüberlauf zu vermeiden. Das Batching reduziert die Schreibverstärkung auf der DB und beschleunigt die Handhabung des Rückdrucks.

- Kompression: GPS-Koordinaten sind vor der Lagerung mit Delta kodiert und gzipiert. Die Rehydration erfolgt bei der Kartenrendern oder der Exportzeit, nicht während der Echtzeit-Feed-Anzeige.

6. Verkehrsburst von Drittanbietern

Spikes aus Garmin- oder Apfel-Synchronisierung werden unter Verwendung von entkoppelten Einnahmewarteschlangen und rategesteuerten ETL-Pipelines absorbiert. Jede Integration verfügt über einen Leistungsschalter und eine Wiederholung von Richtlinien, um voruntergeschaltete Missbrauch oder Fan-Out-Stürme zu verhindern.

Sicherheitsarchitektur

1. Authentifizierung und Autorisierung

- Authentifizierung: Alle Client -Interaktionen verwenden OAuth 2.0 mit PKCE für mobile Ströme. JWTs werden vom Auth -Dienst ausgestellt und unterschrieben, das Benutzer -ID, Umfang und Ablauf enthält. Refresh -Token werden in Ruhe gedreht und verschlüsselt.

- Federated Login: Die Anmeldungen von Google, Apple und Facebook werden unterstützt, aber immer mit einer nativen Benutzeridentität verknüpft. Social Login Tokens sind serverseitig und nicht direkt vertrauenswürdig.

- Genehmigung: Jeder Dienst bestätigt das JWT-Token und erzwingt Regeln auf Umfangsebene (z. B. `Read: Feed`,` post: activity`). RBAC (rollenbasierte Zugriffskontrolle) wird für interne Tools (z. B. Administrator, Moderatorrollen) verwendet.

2. Datenschutz

- In Ruhe:

- PostgreSQL-, Redis- und Objektspeicher werden mit der AES-256-Verschlüsselung mit kundenverwalteten Schlüssel (CMKS) verschlüsselt.

- Sensitive Felder (z. B. E -Mail, Gesundheitsmetriken) werden in der Anwendungsschicht vor dem Schreiben von DB verschlüsselt.

- Unterwegs: Der gesamte Verkehr zwischen den Dienstleistungen und beim Client zu Server wird durch TLS 1.2+ geschützt. Mutual TLS wird für die GRPC -Kommunikation zwischen vertrauenswürdigen Backend -Diensten verwendet.

- Maskierung auf Feldebene: Sensitive Felder werden in Protokollen und Dashboards maskiert oder reduziert. Observability Tooling erzwingt vor der Einnahme das Feld -Tagging und das automatisierte PII -Scannen.

- Geo -Privatsphäre: Aktivitäten, die als privat oder „nur Follower“ gekennzeichnet sind, sind vollständig aus Feeds, Bestenlisten und Suchindizes ausgeschlossen. Heatmap-Daten werden nur aus öffentlichen Aktivitäten anonymisiert und mit Geo-Verschmelzung in der Nähe von Heimzonen abgetastet.

3. Management von Design & Secrets

- Geheimnisse: Alle API -Schlüsseln, DB -Anmeldeinformationen und Webhook -Token werden in einem zentralen Gewölbe (z. B. Hashicorp -Tresor- oder AWS -Secrets -Manager) gespeichert und zur Laufzeit über die Umgebung injiziert. Rotationspolitik werden für kurzlebige Anmeldeinformationen automatisiert.

- ICH BIN: Jeder Microservice hat eine eindeutige Identität und eine Reihe von Rollen. Die IAM-Richtlinien werden auf die erforderlichen minimalen Berechtigungen (z. B. schreibgeschützte Zugriff auf Objektspeicher, nur Schreibzugriff auf Kafka-Themen) skopiert. CI/CD -Agenten übernehmen vorübergehende Rollen mit OIDC Trust.

4. Secure Coding & API -Schutz

- Eingabevalidierung: Alle externen Eingaben werden unter Verwendung von OpenAPI- oder JSON-Schema Schema-Validated. Frontend und Backend erzwingen Länge, Format und Grenzenprüfungen.

- Ratenbegrenzung: Die Grenzwerte von pro-user- und pro-IP-Raten werden durch Redis- oder API-Gateway-Plugins durchgesetzt. Missbrauchserkennungsmodelle (z. B. Anmeldesturm oder Spam -Verhalten) führen zu dynamischen Drosselrichtlinien.

- Wiederholungsschutz: Alle unterschriebenen Anfragen umfassen Nonces oder Zeitstempel. Aktivitäts -Uploads und Webhooks verwenden HMAC -Signaturen, um die Herkunft zu validieren und Manipulationen zu verhindern.

- Code -Sicherheit: Die statische Analyse (SAST) und das Abhängigkeitsscannen werden in CI -Pipelines integriert. Die Erkennung von Geheimnissen (z. B. Gitleaks) blockiert eine zufällige Exposition. Alle kritischen Ströme durchliegen von Experten begutachteten und geprüften Pull-Anfragen.

Erweiterbarkeit und Wartbarkeit

1. Modulare Servicegrenzen

Jede Hauptdomäne – Benutzer, Aktivitäten, Feeds, Benachrichtigungen, Herausforderungen – ist in ihrem eigenen Dienst mit eigenem Schema, API und bereitgestelltem Laufzeit verkapselt. Diese Dienste kommunizieren asynchron über Nachrichtenwarteschlangen oder synchron über GRPC/Rest, abhängig von der Latenzempfindlichkeit.

Diese Isolation ermöglicht eine unabhängige Skalierung, Freisetzungszyklen und das Onboarding neuer Ingenieure ohne Risiko für Kollateralschäden bei nicht verwandten Merkmalen. Beispielsweise berührt der Versand eines neuen Ranglistenformats oder eines Benachrichtigungsauslösers die Logik oder die Benutzerprofile der Aktivität nicht.

2. Plugin-orientierte Muster

- Event -Hörer: Neue Funktionen (z. B. Errungenschaften, Live-Coaching-Warnungen oder Gerätebasis) werden durch Abonnieren von Kernereignissen wie vorgestellt

Aktivität.CreatedoderChallenge.com pleted. Dies ermöglicht Innovation, ohne die Upstream -Logik neu zu schreiben. - Feature Flags: Alle benutzergerichteten Funktionen werden durch dynamische Flags gesteuert (z. B. Launchdarkly- oder interne Umschaltsysteme), wodurch Kanarische Rollouts, A/B-Tests oder inszenierte Freisetzungen basierend auf Region, Benutzerstufe oder Plattform ermöglicht werden.

- Benutzerdefinierte Herausforderung Logik: Die Challenge -Engine ist über Regelmotoren oder eingebettete Skripten (z. B. Lua oder Cel) erweiterbar. Auf diese Weise können Marketing- oder Clubmanager neue Arten von Herausforderungen (z. B. “2K -Meter in 3 Tagen) erstellen, ohne die Hardcodierungslogik in das Backend zu erstellen.

3. Sauberer Code & Muster

- Domänengetriebenes Design (DDD): Dienste verwenden DDD, um Logik nach begrenztem Kontext – Aktivitätsaggregation, Segmentbewertung, Follower -Management – und nicht nach technischer Ebene zu organisieren. Dies reduziert die Überschneidungslogik und die Code-Ausbreitung.

- Testen und Leinen: CI erzwingt strenge Linie, Code -Deckungsschwellen und Vertragstests für alle APIs. Entwicklergeschwindigkeit bleibt hoch, da lokale Entwickler -Setups Container mit gesätten Datenbanken und Scheinwarteschlangen für schnelle Iteration verwenden.

- Monorepo gegen Polyrepo: Backend ist in der Regel Polyrepo (einer pro Dienst), während die mobile App in einem Monorepo mit modularen Paketen lebt. Shared Protobufs oder GraphQL-Schema-Definitionen werden in einem separaten Vertrags-Repo Version kontrolliert.

4. Serviceversioning und Rückwärtskompatibilität

- API -Versioning: Alle öffentlichen APIs sind versioniert (z. B. `/v1/acity`). Veraltete Endpunkte werden für einen definierten Sonnenuntergangszeitraum aufrechterhalten, wobei die Verwendung der Nutzung überwacht wird.

- Schemaentwicklung: PostgreSQL-Schemas verwenden additive Migrationen (Hinzufügen von Spalten, nicht Entfernen) und benennen Sie niemals Enum oder Einschränkungen ohne vorhandene Togegles um. Für NoSQL-Speicher wird jedes Objekt mit einer Schemaversion für die rückwärtskompatible Deserialisierung markiert.

- Protokollkompatibilität: GRPC- und ProtobUF -Verträge sind so konzipiert, dass Veränderungen durch Brechen von Veränderungen vermieden werden – Felder werden nie entfernt und Feld -IDs werden nicht wiederverwendet. Für GraphQL bleiben veraltete Felder mit Warnkopfzeilen und dem Leinen in der Frontend verfügbar.

Denken Sie langfristig für Ihre Plattform?

Benötigen Sie Hilfe bei der Gestaltung einer modularen, zukunftssicheren Architektur, die nicht unter Versioning Hell oder Wachstum Engpässen zerbricht?

Egal, ob Sie eine soziale App skalieren oder eine Fitnessplattform erweitern, wir sind hier, um Architekten auf lange Sicht zu helfen.

Leistungsoptimierung

1. Datenbankabfragesteuerung

- Abfrageindizierung: Jede Hochkardinalitätsspalte, die in Filtern oder Verbindungen verwendet wird-wie `user_id`,` activity_id`, `created_at` oder` Challenge_id`-wird von BTree- oder Gin-Indizes unterstützt. Zusammengesetzte Indizes werden für häufige Abfragen erstellt wie `folwer_id + created_at Desc` in Feeds oder` user_id + Challenge_id` in Ranglisten -Lookups.

- Materialisierte Aussichten: Tägliche Rollups (z. B. “Gesamtabstand dieser Woche”) werden als materialisierte Ansichten gespeichert und über asynchronisierte Jobs aktualisiert. Dies vermeidet sich wiederholende Aggregations -Scans und beschleunigt mobile Dashboard -Metriken.

- Abfrage Caching: Ranglisten, öffentliche Profile und statische Herausforderungsseiten verwenden Redis als Caching -Schicht mit intelligenten TTLs und expliziten Ungültigkeit bei relevanten Ereignissen.

2. Asynchrone Verarbeitung

- Aufgeschobene Arbeitsbelastung: Starke Aufgaben wie Segmentanpassungen, Erzeugung von Heatmaps, Abzeichenbewertungen und Anhängerfutterfan-Out werden an Hintergrundarbeiter weitergeleitet, die Kafka/NAT-Themen konsumieren. Dadurch reagiert der Aktivitätsübermittlungspfad (~ 100–200 ms P99).

- Bulk -Einnahmewege: Uploads von Garmin oder Apple Health werden parallel angegriffen und verarbeitet, wobei die Deduplizierung und die Fehlerisolierung aufgrund einzelner beschädigter Dateien das Blockieren vollständiger Geräte -Synchronisierungen vermeiden.

3. Ratenlimit- und Missbrauchskontrollen

- Ratenkontrolle: Jeder API-Endpunkt verfügt über die im Gateway erzwungene Ratengrenzen auf Benutzerebene und IP-Ebene. Kostengünstige Operationen (z. B. Posting-Aktivitäten mit Medien) werden durch adaptive Drosselung weiter eingeschränkt, um Latenz- und Warteschlangenverzögerung anzufordern.

- Missbrauchserkennung: Maschinenlernte Modelle bewerten Aktionen wie folgen Spam, Kommentarflutung oder missbräuchlicher Geo-Posting. Diese sind an Echtzeitfilter gebunden, die automatisch böswillige Kunden verlangsamen oder Sandbox-Kunden verlangsamen.

4. Caching -Schichten

- Randausfall: Routenkarten, Profil -Avatare, Herausforderungsseiten und Hitzemap -Fliesen werden alle über CDN -Kantenknoten (Cloudflare) serviert. Cache -Tasten werden mit Versions -Hashes markiert, um eine schnelle globale Invalidierung zu ermöglichen.

- Client-Side-Caching: Die mobile App verwendet lokale SQLite für den Offline-Modus, wobei die Flüssigkeitszufuhr von Delta-Updated JSON-Blobs bei Startup oder Post-Login empfangen wird. Dies ermöglicht sofortige Feed -Rendering und reibungslosere Erkältung.

5. Frontend Performance

- Inkrementelle Belastung: Feed Scrolls, Profilansichten und Challenge listet alle implementierenden Infinite Scroll oder Fensterpagination mithilfe von Cursor-basierten Token auf. Dies minimiert die Nutzlastgröße und den Speicherdruck für mobile Clients.

- Bildoptimierung: Alle hochgeladenen Bilder werden durch den Mediendienst vor der CDN-Zustellung geändert, komprimiert und formatkonvertiert (z. B. WebP). Gerätespezifische Asset-Varianten werden mithilfe von Inhaltsverhandlungsheadern ausgewählt.

- JS Bündelung & Baumschütteln: Web -Clients verwenden moderne Bundler (z. B. vite oder Webpack 5) mit dynamischer Importaufteilung und Baumschütteln. Faule Belastung wird für nicht kritische UI-Komponenten wie Diagramme, Karten oder Analysen verwendet.

Teststrategie

1. Arten von Tests

- Unit -Tests: Jede Serviceschicht verfügt über umfangreiche Unit -Tests, die die Domänenlogik, die Eingabevalidierung und die Versorgungsfunktionen abdecken. Diese sind schnell laufend und isoliert-keine externen Abhängigkeiten erlaubt. Verspottete Bibliotheken (z. B. Gomock, Pytest-Mock, Scherz) werden verwendet, um Nebenwirkungen zu isolieren.

- Integrationstests: Wichtige Interaktionen für Service-Interaktionen-wie die Einreichung von Aktivitäten, die die Erzeugung der Futtermittelerzeugung oder die Herausforderung für die Zulassungsförderung auslösen-werden mit Docker-basierten Testumgebungen behandelt. Diese Tests drehen reale Abhängigkeiten (PostgreSQL, Redis, Kafka) und validieren das Verhalten unter realistischen Bedingungen.

- Vertragstests: Für GRPC- und REST-APIs bestätigen Vertragstests (z. B. unter Verwendung von PACT oder BUF für Protobuf), dass Produzenten- und Verbraucherdienste an vereinbarten Schemata einhalten, insbesondere über Service-Versionen oder während paralleler Bereitstellungen.

- End-to-End-Test (E2E): Kritische Benutzerströme – Anmeldung, Anmeldung, Aktivitätsverfolgung, Kommentare – werden unter Verwendung von Cypress oder Entgiftung (für React Native) getestet. Diese Tests werden auf Emulatoren und echten Geräten in CI gegen Staging -Umgebungen durchgeführt.

2. Strategie für CI -Testabdeckung

- Durchsetzung der Codeabdeckung: Mindestschwellenwerte werden für PRs mit Tools wie Codecov oder Sonarqube durchgesetzt. Deckungsgitter blockieren zusammen, wenn neuer Code keine ordnungsgemäßen Testfälle vorliegt – insbesondere für Servicelogik- oder Datenumwandlungsfunktionen.

- Parallelisierte CI -Pipelines: Die Tests werden nach Service gruppiert und parallel über GitHub -Aktionen, Circleci oder Buildkite ausgeführt. Die Testmatrix umfasst Umgebungspermutationen (z. B. verschiedene DB -Versionen, API -Versionen).

- Testvorstellungen & Aussaat: Freigegebene Testdaten werden über Container -Snapshots oder deklarative YAML/JSON -Geräte bereitgestellt. Alle Dienste unterstützen den Testmodus Bootstrapping für lokale und CI -Testumgebungen.

3. Last- und Resilienz -Tests

- Lasttests: Heuschrecken-, Artillerie- oder K6-Skripte simulieren die Spitzenverkehrsmuster-große Fan-Out, Uploads von Bulk-Aktivitäten, Herausforderer-Aktualisierung von Ranglisten-, um die Systemreaktion unter Stress zu testen. Lasttests werden wöchentlich und während der wichtigsten Veröffentlichungen durchgeführt.

- Chaos Engineering: Tools wie Gremlin oder Litmusschaos injizieren Fehler in den Dienst, die DB oder die Netzwerkschicht (z. B. Latenzspikes, Kafka -Partitionen, DB -Failovers). Ziel ist es, die Wiederholung von Richtlinien, die Fallback -Logik und die Deckung zu validieren.

- Resilienz Behauptungen: Zirkelschalter, Schotter und Auszeitleiter werden explizit getestet. Die Kanarischen Bereitstellungen umfassen Fehlerinjektionstests, bevor der vollständige Rollout fortgesetzt wird.

DevOps und CI/CD

1. CI/CD -Pipelineübersicht

Das gesamte System basiert auf GIT-basierten Workflows (Github, GitLab oder Bitbucket) mit automatisierten Pipelines, die auf Pull-Anforderungen, Zusammenführungen und Tag-basierten Versionen ausgelöst werden. CI/CD wird als erstklassiges Produkt mit Leistung, Isolation und Sichtbarkeit als Kernprinzipien behandelt.

Pipeline -Phasen:

- Bauen: Containerbilder werden pro Dienst mit mehrstufigen Dockerfiles erstellt. Gemeinsame Basisbilder werden zwischengespeichert und wiederverwendet. Für Frontend -Apps umfassen die Bauschritte Baumschütteln, Transpilation und Bündelanalyse.

- Prüfen: Einheit-, Integrations- und Vertragstests in isolierten Jobs mit Artefakt -Upload (z. B. Abdeckungsberichte, Testprotokolle). Fehlgeschlagene Jobs werden in PRS für schnelle Triage kommentiert.

- Sicherheitsscan: Sast (z. B. Sonarqube, Snyk) und Abhängigkeitsfälle werden durchgesetzt, bevor Artefakte gefördert werden. Geheimnisse Scaning -Tools blockieren die versehentliche Belichtung.

- Bildunterzeichnung: Containerbilder werden in einer sicheren Registrierung (z. B. AWS ECR, GCP -Artefaktregistrierung) mit unveränderlichen Tags und Provenance -Metadaten unterzeichnet und gespeichert.

- Bereitstellung von Staging: Tagged Builds werden automatisch in einem Staging -Cluster bereitgestellt. Kanarische Tests, Rauchtests und synthetische Gesundheitskontrollen führen gegen diese Umgebung mit kurzen TTLs.

- Produktionsförderung: Die Bereitstellungen zum Produkt werden entweder manuell (mit Genehmigungsstätten) oder automatisch nach Bestehen der QA -Bedingungen ausgelöst. Gitops -Tools (z. B. Argocd, Flux) wenden Manifests aus einem versionierten Status -Repo an.

2. Infrastruktur als Code (IAC)

- Terraform: Alle Infrastrukturen – VPCs, K8S -Cluster, DB -Instanzen, IAM -Rollen, Warteschlangen – werden über Terraform -Module verwaltet. Änderungen werden überprüft und mithilfe der Vorschau überprüft

Terraform planin PRS. Die Drifterkennung läuft abends ab, um manuelle Änderungen zu erkennen. - Anpassen und Helme: K8s Manifests werden über Helm vorgeschrieben und in Umgebungen verwaltet, wobei Kustomize -Overlays. Auf diese Weise können Replikate, Konfigurationen und Geheimnisse pro Umgebung überschrieben.

- Geheimnisse Management: Geheimnisse und Konfigurationskarten werden über versiegelte Geheimnisse (z. B. Mozilla -Sops, Bitnami -versiegelte Geheimnisse) oder mit SIDECAR -Injektoren aus dem Gewölbe synchronisiert. Alle Geheimnisse werden regelmäßig gedreht und geprüft.

3. Bereitstellungsstrategie

- Blue-Green-Bereitstellungen: Für kritische Pfaddienste wie Auth oder Aktivität werden blaugrüne Strategien verwendet. Der Datenverkehr wird allmählich unter Verwendung der Eindringung von Regeln verschoben, wobei automatisiertes Rollback fehlschlägt.

- Kanarische Veröffentlichungen: Nicht kritische Dienste (z. B. Benachrichtigungen, Besten Metriken (Latenz, Fehlerrate, CPU) werden vor fortgeschrittenen Baselines verglichen.

- Feature Flags: Alle neuen Codepfade werden durch Feature -Toggles bewacht. Dies ermöglicht Progressive Exposition, dunkle Starts und sofortige Kill -Switches bei Vorfällen.

4. Artefakt- und Umwelthygiene

- Bildlebenszyklus: Alte Builds werden automatisch auf der Grundlage von Alters- oder SHA -Retentionsrichtlinien beschnitten. Unbenutzte Bilder werden nie über 30 Tage gehalten, wenn sie nicht als LTS- oder Rollback -Versionen getaggt werden.

- Vorschauumgebungen: Ephemerale Staging -Umgebungen werden pro PR mit dynamischen Namespaces in Kubernetes erstellt. Diese Umgebungen imitieren die Produktion Topologien und werden nach dem Zusammenführen oder PR -Schließen zerstört.

- Rollback -Mechanismus: Jede Bereitstellung ist atomic und versionspinne. Rollbacks können über Git Revert, Helm History Rollback oder Argocd UI -Klick ausgelöst werden – innerhalb von Sekunden.

Benötigen Sie Hilfe mit Hilfe schneller, ohne Dinge zu brechen?

Möchten Sie eine Hochgeschwindigkeitstechnik-Pipeline mit kugelsicheren Rollbacks, Gitops-Workflows und CI/CD produzieren?

Egal, ob Sie ein Microservices -Backend skalieren oder eine neue mobile Funktion auf den Markt bringen, architekten wir ein DevOps -System, das unter Druck arbeitet.

Überwachung und Beobachtbarkeit

1. Protokollieren

- Strukturierte Protokollierung: Jedes Dienst loget sich im JSON -Format aus, das strukturierte Felder wie `Request_id`,` user_id`, `activity_id` und` duration_ms` verwendet. Die Protokolle werden über fließendes Bit oder Filebeat in eine zentrale Pipeline (z. B. Elasticsearch, Loki) für indizierte Abfragen und -analyse gestreamt.

- Korrelations -IDs: Jede Anforderung generiert eine eindeutige Korrelations -ID, die über die Kinogrenzen hinweg über Header und Protokollkontext übergibt. Dies ermöglicht die vollständige Rückverfolgbarkeit von End-to-End-Rückverfolgbarkeit von der mobilen App bis zur Backend-Warteschlangen nach DB.

- Loghygiene: PII -Maskierungsregeln werden auf der Ebene der Log -Pipeline durchgesetzt. Geheimnisse, Zugangsstoken, GPS -Koordinaten und Roh -Telemetrie werden automatisch ausgeschlossen oder reduziert, bevor Protokolle den Speicher aufnehmen.

2. Metriken

- Systemmetriken: CPU, Speicher, Festplatte und Netzwerknutzung werden über Prometheus -Exporteure aus jedem Knoten und Pod exportiert. Warnschwellen werden für Sättigung, Ressourcendruck und ungewöhnliche Pod -Abwanderung eingestellt.

- Geschäftsmetriken:

- Aktivitäten pro Minute, Futterveranstaltungen pro Sekunde

- Challenge tritt mit, schreibt Raangboard, Segment -Matches

- Latenz pro Endpunkt, 99. Perzentil -Fehlerraten

- Benutzerdefinierte Instrumentierung: Dienste verwenden Prometheus -Client -Bibliotheken, um Zähler, Histogramme und Messgeräte für benutzerdefinierte Logik zu exportieren – z. B. „Abzeichenbewertungen verarbeitet“ oder „GPS -Punkte pro Upload“.

3. Verteilte Verfolgung

- Verfolgungssystem: OpenTelemetry wird verwendet, um Dienste mit Spannweiten für HTTP/GRPC -Aufrufe, DB -Abfragen und asynchrische Warteschlangenhandhabungen zu instrumentieren. Spuren werden in Backends wie Jaeger, Waben oder Tempo exportiert.

- Spurenabtastung: Headbasierte Probenahme (mit einstellbaren Raten) sorgt dafür, dass hochwertige Transaktionen wie Aktivitätsaufnahme oder Futterausläufe immer erfasst werden, während Hintergrundjobs mit niedriger Priorität probabilistisch abgetastet werden.

- Trace -Verknüpfung: Alle Spuren sind wieder zu Benutzer -IDs und fordern Sie Metadaten an, wodurch das Debuggen individueller Aktivitäts -Einsendungen, Rangliste oder eine langsame Erzeugung von Follower -Feeds mit genauen Kausalitätsketten ermöglicht wird.

4. Alarming & Dashboards

- Alarmmanagement: Prometheus Alertmanager oder OpsGenie behandeln Deduplizierung, Stillefenster, Berechtigung und Eskalationsrichtlinien. Zu den Warnungen gehören Slack/Teams Hooks, SMS und Pagerduty, wenn kritische Schwellenwerte gekreuzt werden.

- Dashboards: Grafana-Dashboards werden pro Dienst mit Bohrerdown-Funktionen für Latenz, Fehlerraten, DB-Durchsatz, Warteschlangen Rückstände und externe API-Ausfälle vorhanden. Business -Stakeholder erhalten außerdem KPI -Ansichten (z. B. aktive Benutzer, Herausforderung Abschlussraten).

- SLOs & Fehlerbudgets: Die wichtigsten Endpunkte (z. B. Aktivitätsunterwerfung, Futterbelastung, Herausforderungsverbinden) sind an formale SLOs mit Latenz-/Fehlerschwellen gebunden. Verbrennungsraten werden berechnet, um Feature -Flagg -Gating und Rollout -Tempo zu informieren.

5. Gesundheitsprüfungen und Bereitschaftssonden

- Lebendigkeit und Bereitschaft: Alle Dienste enthüllen “/Healthz” -Dendpunkte für die Grundlagigkeit (z. B. Thread -Pool -Status, Speicher) und Bereitschaft (z. B. DB -Konnektivität, Warteschlangenverzögerung). Kubernetes verwendet diese für die autoscaling- und Bereitstellungsorchestrierung.

- Tiefe Überprüfungen: Periodische Hintergrundaufgaben führen synthetische Transaktionen aus (z. B. Testaktivität Insert + Feed Read), um die Gesundheit der Geschäftslogik zu validieren – nicht nur die Systemüberzeiten.

Kompromisse und Designentscheidungen

1. Fan-Out-on-Write vs. Fan-Out-on-Read

- Entscheidung: Ein Hybridmodell wurde ausgewählt. Für durchschnittliche Benutzer verwendet das System Fan-Out-on-Write, um Feeds vorab zu populieren. Für Benutzer von hohen Fanout-Benutzern (z. B. Influencer) wechselt es auf Fan-Out-on-Read.

- Warum: Vorkomputieren von Feed -Einträgen minimieren die Latenz und lädt den Lesepfad ab. Es ist jedoch teuer, wenn ein Benutzer Tausende von Followern hat. Das Hybriddesign optimiert den 95%-Fall und schützt die Infrastruktur vor Fan-Out-Stürmen.

- Abtausch: Mehr operative Komplexität. Das System muss dynamisch die Schreib-/Lesespfade basierend auf Benutzerebenen oder Follower -Anzahl durchführen. Erhöht auch die Testoberfläche.

2. Polyglot -Persistenz

- Entscheidung: Postgresql, Redis, Kafka und S3 wurden als Kernstapel ausgewählt. Die optionale Verwendung von NEO4J für soziale Graphenquellen wurde aufgeschoben.

- Warum: Diese Tools übereinstimmen gut mit den Zugriffsmustern: PostgreSQL für Integrität, Redis für den Zugang mit niedrigem Latenz, KAFKA für die ereignisgesteuerte Skala und S3 für den BLOB-Speicher. Vermeiden Sie ein spezialisiertes Diagramm DB vereinfachtes OPS und Onboarding.

- Abtausch: Einige Grafikabfragen (z. B. „gegenseitige Follower in einem Club“) sind ohne dedizierte Graph -Engine weniger effizient. Redis-basierte Caching mindert dies, fügt jedoch die Komplexität der Cache-Kohärenz hinzu.

3. Echtzeit-GPS-Synchronisation im Vergleich zum Aufladen nach dem Training

- Entscheidung: Das Upload nach dem Training ist der Standard. Echtzeit-Synchronisierung ist optional und optimiert (z. B. für Live-Tracking oder virtuelle Rennen).

- Warum: Das Echtzeit-GPS-Streaming erzeugt eine konstante Backend-Belastung, führt zu Konsistenzherausforderungen für teilweise Aktivitäten und erhöht den Stromverbrauch der mobilen Geräte. Für die meisten Benutzer ist das Batch -Upload ausreichend.

- Abtausch: Reduzierte Fähigkeit zur Stromversorgung von Funktionen wie Live-Jubel, Pacer-Matching oder in der progressiven Updates für die Rangliste. Zukünftige Versionen können die Echtzeitunterstützung hinter Feature-Flags erweitern.

4. Microservices gegen Monolith

- Entscheidung: Microservices wurden früh mit klaren Domänengrenzen ausgewählt: Aktivität, Feed, Benutzer, Herausforderung, Medien usw.

- Warum: Ermöglicht unabhängige Skalierung, parallele Entwicklung und domänenspezifische Besitz. Die Einnahme von Futtermitteln und Aktivitäten haben sehr unterschiedliche Leistungsprofile – die Trennung ermöglicht eine gezielte Optimierung.

- Abtausch: Erfordert robustes Werkzeug: Service -Erkennung, Verfolgung, CI/CD -Isolation und Reife von Plattformtechnik. Für kleine Teams erhöht dies die Komplexität im Voraus, aber langfristige Beweglichkeit überwiegt kurzfristige Schmerzen.

5. ereignisgesteuerte und synchrone Workflows

- Entscheidung: Alle nicht kritischen Pfade (Feed-Fan-Out, Rangliste, Benachrichtigungen) werden über Kafka/NATs asynchronisiert. Nur AUTH- und Benutzeranwendungsabfragen verwenden Anforderungs-/Antwortflüsse.

- Warum: Async Systems skalieren besser und entkoppeln Workflows. Sie ermöglichen auch die Priorisierung von Batching, Wiederholungen und Warteschlangen-für variable Einnahmemuster wie Drittanbieter-Synchronisierung oder Herausforderungspikes unerlässlich.

- Abtausch: Eventuelle Konsistenz und Komplexität des Debuggens. Erfordert DLQs (Dead-Letter-Warteschlangen), Ereignisreplays und sorgfältige Deduplizierungslogik. Überwachung und Beobachtbarkeit sind hier der Schlüssel zur Sicherheit.

Architektonische Schulden und Minderungen

- Einige ältere Feed-Pfade gehen immer noch davon aus, dass synchrone Schreibvorgänge in Kafka-basierte Fan-Out-Dienste umgerichtet werden.

- Der erste Herausforderungsmotor hatte hartcodierte Regeln – ersetzt durch eine Regelmotor für Flexibilität.

- Berechtigungslogik über Dienstleistungen verteilt – zentralisiert in einen Zugangspolitikdienst, um die Konsistenz durchzusetzen.

Wichtige Imbissbuden und Bereiche, um sich zu verbessern

1. Was diese Architektur richtig macht

- Skalierbarkeit durch Design: Staatelose Dienste, ereignisgesteuerte Verarbeitung und Sharded-Datenbanken halten das System auch bei Millionen von Benutzern und hohen Einnahmeraten an.

- Modulare Grenzen: Klare Trennung zwischen Aktivität, sozialem, Medien und Analyselogik ermöglicht eine fokussierte Optimierung und eine sichere parallele Entwicklung.

- Asynchron zuerst: Entkoppelung der Futtermittelgenerierung, Herausforderung der Bewertung und Benachrichtigungen aus dem Kernaufnahmepfad liefert Leistung und Fehlerisolation, wo es wichtig ist.

- Sicherheit und Privatsphäre: Feinkörnige Zugriffskontrollen, verschlüsselter Speicher und strenge Beobachtbarkeitspraktiken entsprechen der Datenverantwortung auf DSGVO-Ebene.

- Entwicklergeschwindigkeit: CI/CD -Pipelines, Feature -Flags und Vertragstests unterstützen eine schnelle, sichere Iteration – ohne die Produktionsstabilität zu beeinträchtigen.

2. Verbesserungsmöglichkeiten

- Dynamische Grafikfragen: Neubewertung der Verwendung von Redis vs. speziell gebauten Graphen-DBs (z. B. DGRAPH, Nebula) für die Erkennung gegenseitiger Follower oder fortschrittliche Clubfunktionen.

- Einheitliche Zugriffskontrolle: Zentralisierung aller Berechtigungsprüfungen in einen Richtliniendienst (OPA oder Custom), um Duplizierung und Drift über die Dienste zu vermeiden.

- Live -Funktionen: Erweiterte Echtzeitfähigkeiten (z. B. Live-Segmente, Pacer, Gruppenläufe) mit zuverlässigen Streaming-Protokollen und kontrollierten Rollout.

- Mobile Offline -Synchronisierung: Verbesserung der Offline-ersten-UX für Benutzer in ländlichen Gebieten oder bei langen Outdoor-Aktivitäten mit besseren Strategien zur Konfliktlösung.

- Erweiterte Analytik: Aufbau dedizierter Athleten-Insights-Pipelines (z. B. VO2-Maximalschätzung, Trainingsbelastung) unter Verwendung von vorabregierten Datenseen und ML-Modellen.

Diese Plattformgestaltung gleicht Leistung, Flexibilität und Benutzererfahrung in einem anspruchsvollen Kontext für soziale + Fitness aus. Es handelt sich um produktionsbereit, kattiert getestet und für das Wachstum gebaut-aber mit Raum, sich zu einem intelligenteren, in Echtzeit und personalisierten Fitness-Ökosystem zu entwickeln.

Etwas so ehrgeiziges bauen?

Bei der Gestaltung skalierbarer, sicherer und sozial ansprechender Plattformen geht es nicht nur darum, den richtigen Stapel auszuwählen, sondern auch die richtigen Entscheidungen zum richtigen Zeitpunkt.

Unabhängig davon, ob Sie eine Fitness -App auf den Markt bringen, das Engagement der Benutzer verbessern oder Ihr Backend modernisieren, sind wir bereit, Ihnen das Architekten mit Zuversicht zu unterstützen.

Menschen fragen auch (FAQs)

Wie entwickle ich eine Fitness -Tracker -App?

Beginnen Sie mit der Definition der Kernfunktionen: GPS -Aktivitätsverfolgung, Einnahme von Gesundheitsdaten (Herzfrequenz, Schritten), Benutzerprofile und Offline -Protokollierung. Entwerfen Sie von dort aus ein mobiles Erlebnis mit React Native oder Swift/Kotlin, implementieren Sie sichere Benutzerauthentifizierung (OAuth2) und eine Verbindung zu einem Backend, das Sensordaten in Echtzeit aufnehmen, verarbeiten und analysieren kann. Cloud-native Infrastruktur, skalierbare Datenspeicher und ereignisgesteuerte Verarbeitung sind der Schlüssel, um die Leistung und die Reaktionsfähigkeit eng zu halten.

Wie viel kostet es, eine Fitness -App zu erstellen?

Es hängt vom Umfang ab, aber eine Fitness-App der Produktionsstufe mit GPS-Tracking, Benutzerauth, Echtzeit-Synchronisation, Cloud-Speicher und sozialen Funktionen kostet normalerweise dazwischen $ 50.000 bis $ 500K+ zu bauen und zu starten. Dazu gehören UI/UX, mobile Entwicklung, Backend -Architektur, DevOps und QA. Kostenskala basierend auf Komplexität – Live -Tracking, soziale Grafiken, Integrationen und Analysen erhöhen die technischen Anstrengungen.

Wie erstellt man eine Strava -App?

Um eine Strava-ähnliche App zu erstellen, benötigen Sie einen mobilen Client für GPS-basierte Aktivitätsaufzeichnungen, ein Backend für die Speicherung und Analyse von Benutzer-Workouts sowie eine soziale Graphenschicht für Feeds, folgt und Interaktionen. Zu den Kernkomponenten gehören eine Pipeline in Echtzeit, einen skalierbaren Futtermittelservice und ein ereignisorientierter Motor für Herausforderungen und Bestenlisten. Die Architektierung für Skalierbarkeit, geringe Latenz und modulare Servicegrenzen ist unerlässlich.

Wie viel kostet es, eine App wie Strava zu erstellen?

Eine Plattform im strava-Stil mit vollem Funktionsumfang kann leicht überschreiten $ 500.000 bis $ 1 Mio.+ In den Entwicklungskosten, abhängig von Ihrem Feature-Set, der Teamstruktur und der Zeit zu Markt. Zu den Kosten gehören die Entwicklung von Mobil- und Backends, Cloud-Infrastruktur, Leistungsoptimierung und Unterstützung für Dinge wie Medien-Uploads, Datenschutzeinstellungen und Geräteintegrationen von Drittanbietern.

Welche Datenbank verwendet Strava?

Strava hat ihren vollständigen Stapel nicht öffentlich beschrieben, aber basierend auf Mustern, die bei Systemen ähnlicher Skala gemeinsam sind, verwenden sie wahrscheinlich eine Mischung aus relationalen Datenbanken (z. B. Postgresql), verteilte Datenspeicher für Telemetrie (z. B. Cassandra oder Zeitreins-DBS) und redisähnliche Systeme für das Caching. Ihre Architektur ist ereignisorientiert und mikrodienste basiert, wobei die Cloud-Infrastruktur Millionen von Aktivitäten pro Tag behandelt.

Warum ist Strava so beliebt?

Strawa nagelte die Mischung aus Fitnessverfolgung und sozialem Engagement. Es geht nicht nur darum, Läufe aufzunehmen – es geht darum, sie zu teilen, an Segmenten zu konkurrieren, Abzeichen zu verdienen und sich mit einer Community zu beschäftigen. Das Social Feed, die Gamification-Funktionen und das Herausforderungs-Ökosystem machen die Plattform klebrig und gewohnheitsbildend, was sowohl die Bindung als auch die Viralität fördert.

Ist eine Fitness -App profitabel?

Ja – wenn gut ausgeführt. Abonnementbasierte Fitness-Apps (wie Strava Premium, MyFitnessPal usw.) haben sich als hochprofitabel erwiesen. Der Umsatz kann aus Premium -Analysen, Coaching -Tools, Markenherausforderungen oder Ausrüstungsmarktplätzen stammen. Rentabilität erfordert jedoch eine starke Bindungstrategie, eine Infrastruktureffizienz und ein Benutzerwachstum über MVP hinaus.

Wie monetisiere ich meine Fitness -App?

Gemeinsame Monetarisierungsstrategien sind: Freemium-Abonnements (z. B. tiefere Analysen oder Coaching freischalten), In-App-Käufe (z. B. Schulungspläne), Markenpartnerschaften (z. B. gesponserte Herausforderungen) und Partnermarktplätze (z. B. Schuhe, Wearables). Anzeigen sind möglich, degradieren jedoch häufig die Benutzererfahrung. Konzentrieren Sie sich auf Benutzervertrauen und Langzeitwert bei der Gestaltung von Monetarisierungspfaden.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.