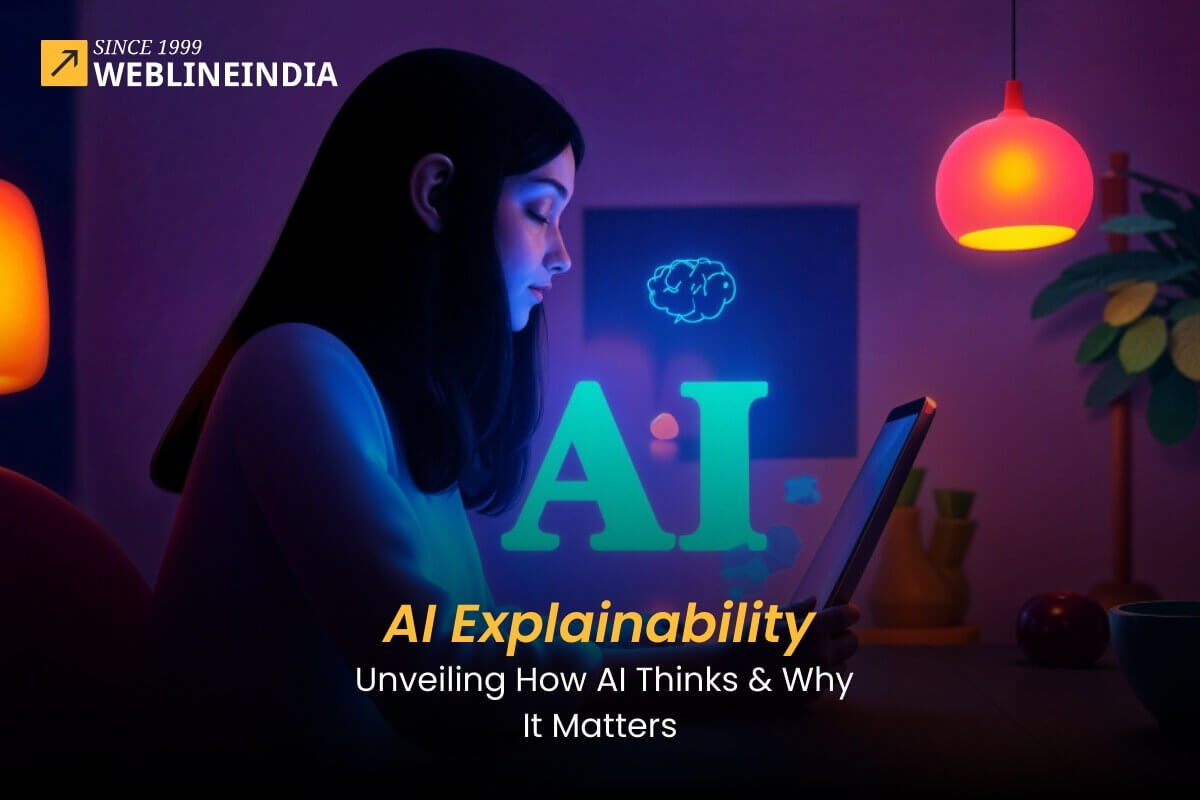

בינה מלאכותית (Ai) משנה במהירות את אופן החיים ועובדים. ממכוניות בנהיגה עצמית ועד לאבחון רפואי, מודלים של AI משמשים לאוטומציה של משימות ולקבל החלטות שנחשבו בעבר כתחום הבלעדי של בני אדם. עם זאת, ככל שמודלים של AI הופכים מורכבים יותר, מתוך הבנה כיצד הם עובדים הופכת קשה יותר ויותר. חוסר שקיפות זה יכול להוביל לבעיות רבות, כולל הטיה, אפליה ואפילו חששות בטיחותיים.

כאן נכנסת AI הסבר. AI הניתן להסבר (XAI) הוא קבוצה של טכניקות המאפשרות להבין כיצד מודלים של AI מקבלים החלטות. ניתן להשתמש במידע זה כדי לשפר את הדיוק וההגינות של דגמי AI כמו גם לבנות אמון במערכות AI.

מדריך זה יתעמק מהי AI הניתן להסבר, מדוע זה חשוב וכיצד ניתן להשיג אותו באמצעות מתודולוגיות שונות ו טכנולוגיות.

רוצה תוכנת AI שמניעה החלטות אוטומטיות וחכמות יותר?

הבנת הסבר AI

הסבר AI מתייחס לתהליך הפיכת פעולותיהם הפנימיות של מודלים של AI מובנים לבני אדם. המטרה היא להבטיח כי התוצאות המיוצרות על ידי דגמים אלה אינן רק מדויקות אלא גם ניתנות לפרשנות ומוצדקות. כאשר שירותי פיתוח AI גדלים בפופולריות, היה צורך גובר ב- AI הניתן להסבר לבנות אמון, להפחית הטיות ולהעצים את השקיפות בקבלת ההחלטות של AI.

מדוע AI הסבר חשוב?

שילוב הסבר AI יכול להביא מספר יתרונות הן למפתחים והן למשתמשים בקצה:

- אמון ואימוץ: AI הניתן להסבר מסייע לבעלי העניין לסמוך על החלטות ה- AI, לעודד את השימוש הרחב יותר שלה.

- ניפוי באגים ושיפור: הפיכת מודלים של AI לשקופים מאפשרת למדעני נתונים להבין שגיאות, וזה חיוני לשיפור דיוק המודל.

- ציות: תעשיות מסוימות דורשות הסברים ברורים להחלטות, כגון במימון ו שירותי בריאות כאשר AI הסבר הוא חיוני לעמידה בדרישות הרגולציה.

- שיקולים אתיים: AI הניתן להסבר מסייע בהפחתת הטיות ומקדמות הגינות בקבלת החלטות אוטומטיות.

איך AI מסביר את יכולת ההסבר?

ישנן מספר טכניקות שונות שניתן להשתמש בהן להשגת הסבר AI. כמה מהטכניקות הנפוצות ביותר כוללות:

- הסברים מקומיים שניתן לפרש מודל-אגנוסטי (LIME): טכניקה זו מסבירה את התחזיות של כל מודל למידת מכונה על ידי קירובו באופן מקומי עם מודל שניתן לפרש.

- הסברים תוספים של Shapley (SHAP): טכניקה זו מבוססת על תורת המשחקים ומסבירה את התחזיות של כל מודל למידת מכונה על ידי חישוב התרומה של כל תכונה לחיזוי.

- עצי החלטה: עצי החלטה הם סוג של מודל למידת מכונה שניתן להשתמש בו כדי להסביר את התחזיות של מודלים אחרים של למידת מכונות.

- מערכות מבוססות כללים: מערכות מבוססות כללים הן סוג של מודל AI שניתן להשתמש בו כדי להסביר את התחזיות של דגמי AI אחרים.

מרכיבי המפתח של AI הניתנים להסבר

מרכיבי הליבה של AI הניתנים להסבר כוללים שקיפות, פרשנות ואחריות. ההבנה כיצד מודלים של AI מגיעים למסקנה או המלצה מסוימת חיונית לפיתוח מערכות AI אחראיות.

להלן כמה מהאלמנטים התורמים להסבר AI:

שְׁקִיפוּת

שקיפות בשירותי פיתוח AI פירושה שהתהליכים העומדים מאחורי הדרכת מודלים, שימוש בנתונים וקבלת החלטות ברורים. שקיפות זו מסייעת למפתחים ומשתמשים להבין את ההיגיון העומד מאחורי דגמי AI ומבטיחה אחריות בתפוקותיהם.

פרשנות

הפרשנות מתייחסת ליכולתם של בני האדם להבין את ההחלטות שקיבלו מודלים של AI. מודל נחשב לפרשנות אם ניתן להבין בקלות את התנהגותו על ידי משתמשים מבלי להזדקק להבנה מעמיקה של מתמטיקה או אלגוריתמים מורכבים. שירותי פיתוח AI רבים מתמקדים בעיצוב דגמים עם תכונות פרשנות מובנות כדי להקל על תהליך זה.

אחריות

כאשר מודלים של AI מייצרים תוצאות, אחריות מבטיחה כי בעלי העניין יוכלו להתחקות אחר החלטות אלה. זה קריטי במיוחד בתחומים בעלי השקעות גבוהות כמו שירותי בריאות, חוק או כספים, בהם החלטות שהתקבלו על ידי מודלים של AI יכולות להיות בעלות השלכות משמעותיות.

מחפש פיתוח AI שמבטיח דיוק ותאימות?

טכניקות להשגת הסבר AI

השגת הסבר AI כרוכה בשימוש בטכניקות שונות כדי להבין כיצד מודלים של AI מקבלים החלטות. שיטות אלה כוללות סיד, המתקרב לדגמים באופן מקומי עם הסברים ניתנים לפרשנות, ו- SHAP, המשתמש בתורת המשחקים כדי לקבוע תרומות תכונות.

בנוסף, עצי החלטה ומערכות מבוססות כללים מציעים שקיפות מובנית על ידי הדמיה של מסלולי החלטה וכללים מפורשים, בהתאמה, מסייעים להבנת התנהגות מודל AI ובניית אמון בתחזיותיהם.

אלה כוללים:

1. שיטות מודל-אגנוסטיות

טכניקות אלה חלות על כל מודל, ללא קשר לארכיטקטורה, ומספקות תובנות כיצד תשומות משפיעות על תפוקות. כמה שיטות נפוצות כוללות:

- סיד (הסברים מקומיים שניתן לפרש מודל-אגנוסטי): הוא מייצר מודל פשוט יותר ופרשני המקורב למודל ה- AI המורכב באופן מקומי סביב תחזית ספציפית.

- SHAP (הסברים תוספים של Shapley): זה עוזר להסביר תחזיות אינדיבידואליות על ידי חישוב התרומה של כל תכונה לפלט.

2. שיטות ספציפיות למודל

דגמי AI מסוימים ניתנים לפרשנות יותר מאחרים. לדוגמה, עצי החלטה ומודלים של רגרסיה לינארית הם קלים יותר להבנה מאשר מודלים של למידה עמוקה. טכניקות ספציפיות לדגמי AI מסוימים כוללות:

- ניתוח חשיבות תכונות: במודלים מבוססי עץ כמו יערות אקראיים, טכניקה זו מעריכה את החשיבות של כל תכונה בביצוע תחזיות.

- מפות הפעלה: עבור רשתות עצביות מפותלות (CNNs) בעיבוד תמונה, מפות הפעלה מדמיינות אילו אזורים של תמונה תורמים ביותר להחלטה שהתקבלה על ידי מודל AI.

3. רשתות עצביות הניתנות להסבר

למרות שמודלים של למידה עמוקה כמו רשתות עצביות נחשבות לרוב “קופסאות שחורות”, ישנן דרכים לשפר את יכולת ההסבר שלהם. שיטות מסוימות כוללות:

- מנגנוני קשב: שיטות אלה מאפשרות למודלים להתמקד בתכונות קלט ספציפיות הרלוונטיות יותר לחיזוי.

- מפות פליטות: בראייה ממוחשבת, מפות בולאיות מדמיינות אזורים של תמונה המשפיעה ביותר על התחזיות.

היתרונות של AI הניתנים להסבר בשירותי פיתוח AI

יישום AI הניתן להסבר חיוני עבור ארגונים המציעים שירותי פיתוח AI. זה מבטיח שלקוחות יבינו כיצד מודלים של AI מתפקדים ומקבלים החלטות, שבסופו של דבר בונה אמון בטכנולוגיה.

להלן כמה יתרונות מרכזיים:

- קבלת החלטות משופרת: עם מודלים שקופים ומובנים, בינה מלאכותית בעסקים מאפשר לחברות לקבל החלטות מושכלות יותר על סמך תפוקות AI.

- הפחתת סיכונים: הסברים ברורים לתחזיות של מודלים של AI מפחיתה את הסבירות לתוצאות בלתי צפויות או מזיקות, במיוחד ביישומים רגישים.

- תאימות רגולטורית: לעתים קרובות נדרשת הסבר על מנת לעמוד בתקנים משפטיים ורגולטוריים בתעשיות כמו פיננסים, שירותי בריאות וביטוח.

אתגרים ביישום AI הניתן להסבר

יישום AI הניתן להסבר (XAI) אינו ללא מכשולים שלו. איזון הצורך בהסבר AI עם דיוק המודל והביצועים יכול להיות מסובך. דגמי AI מורכבים מאוד יכולים להיות קשה לפרש אפילו עם טכניקות XAI.

העברת הסברים לבעלי העניין עם רמות שונות של הבנה טכנית מהווה אתגר נוסף. לבסוף, היעדר שיטות ומדדים XAI סטנדרטיים מקשה על הערכת הגישות שונות והשוואה:

1. מורכבות של דגמי AI

מודלים רבים של AI מתקדמים, כמו רשתות למידה עמוקה, פועלים באמצעות ארכיטקטורות מורכבות המקשות על הפרשנות כיצד הם מגיעים להחלטות ספציפיות. זה נכון במיוחד כאשר עובדים עם מערכי נתונים גדולים הדורשים טכניקות עיבוד מתוחכמות.

2. סחר בין דיוק והסבר

לעיתים קרובות ישנו פיתרון בין דיוקו של מודל לבין יכולת ההסבר שלו. מודלים מורכבים יותר נוטים לספק דיוק גבוה יותר אך על חשבון היותם פחות פרשניים. הכיתוב האיזון הנכון בין שני גורמים אלה הוא אתגר מתמשך בשירותי פיתוח AI.

3. חוסר סטנדרטיזציה

נכון לעכשיו אין מסגרת מקובלת באופן אוניברסלי עבור AI הסבר. קיימים דגמים, כלים וגישות שונים, אך יעילותם יכולה להשתנות מאוד בהתאם להקשר וביישום הספציפי. חוסר סטנדרטיזציה זה מקשה על יישום AI הניתן להסבר בכל תעשיות.

העתיד של AI הניתן להסבר

AI הניתן להסבר הוא תחום מחקר חדש יחסית. עם זאת, זהו תחום שגדל במהירות. ככל שמודלים של AI הופכים מורכבים יותר, הצורך בהסבר AI רק יגדל.

קיימות מספר יוזמות לקידום פיתוח ואימוץ של AI הניתן להסבר. לדוגמה, סוכנות הפרויקטים של מחקרי המחקר המתקדמים להגנה (DARPA) מממנת מחקר על AI הניתן להסבר. האיחוד האירופי עובד גם על מערכת הנחיות ל- AI הניתן להסבר. AI הניתן להסבר הוא כלי חשוב להבטיח שמודלי AI הם הוגנים, מדויקים ואמינים.

כאשר AI ממשיך למלא תפקיד חשוב יותר ויותר בחיינו, AI הניתן להסבר יהפוך לחשוב עוד יותר.

איך אתה יכול להתחיל עם AI הניתן להסבר?

אם אתה רוצה להתחיל עם AI הניתן להסבר, קיימים מספר משאבים שיעזרו לך. ישנם מספר ספרים ומאמרים בנושא AI הניתן להסבר. ישנם גם מספר כלים לקוד פתוח שניתן להשתמש בהם כדי להסביר את התחזיות של דגמי AI.

שירותי פיתוח AI יכול גם לעזור לך עם AI הניתן להסבר. מספר חברות מציעות שירותי פיתוח AI שיכולים לעזור לכם לפתח ולפרוס מודלים של AI הניתנים להסבר. AI הניתן להסבר הוא נושא חשוב לכל מי שמתעניין ב- AI. הבנת AI הניתנת להסבר יכולה לעזור לך לקבל החלטות מושכלות לגבי השימוש ב- AI.

Hashtags חברתיים

#Aiexplainability #artificialintelligence #ai #explainableai #aitransparency #aidevelopment #aiautomation #aiinnovation #futureofai

רוצה תוכנת AI שמניעה החלטות אוטומטיות וחכמות יותר?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.