Mentre progrediamo verso il moderno mondo tecnologico, elabora l’automazione con l’aiuto di Sviluppo di intelligenza artificiale E Sviluppo dell’apprendimento automatico è diventata la spina dorsale di vari settori in quanto promette efficienza, velocità e efficacia in termini di costi. D’altra parte, la distorsione dell’automazione è diventata una preoccupazione significativa. Questo dovrebbe essere una preoccupazione perché poiché le aziende e le organizzazioni continuano ad adottare l’automazione dei processi, molti non sono consapevoli delle potenziali conseguenze che questi sistemi automatizzati possono avere sull’equità e sull’uguaglianza.

Sebbene l’automazione porti efficienza e praticità, può anche introdurre pregiudizi sottili ma potenti che perpetuano la discriminazione e la disuguaglianza. Comprendere le dinamiche della distorsione dell’automazione è fondamentale per affrontare questi problemi e creare sistemi che promuovono l’equità per tutti.

Vuoi scoprire come creare sistemi automatizzati imparziali con AI etica?

Cos’è la distorsione dell’automazione?

La distorsione dell’automazione si riferisce alla tendenza degli esseri umani a fare affidamento eccessivo sui sistemi automatizzati, supponendo che le loro decisioni siano corrette senza metterle in discussione. In un mondo in cui le macchine sono spesso viste come infallibili, questa fiducia può portare a conseguenze dannose.

In pratica, la distorsione dell’automazione significa che gli umani possono ignorare i propri giudizi e fare affidamento sulle decisioni prese da un sistema automatizzato, anche quando tali sistemi sono imperfetti o distorti. Ad esempio, nelle assunzioni dei processi, molte aziende fanno sempre più affidamento su sistemi automatizzati per schermare i curriculum o valutare i candidati. Questi sistemi, sebbene efficienti, possono perpetuare pregiudizi se sono addestrati su dati distorti.

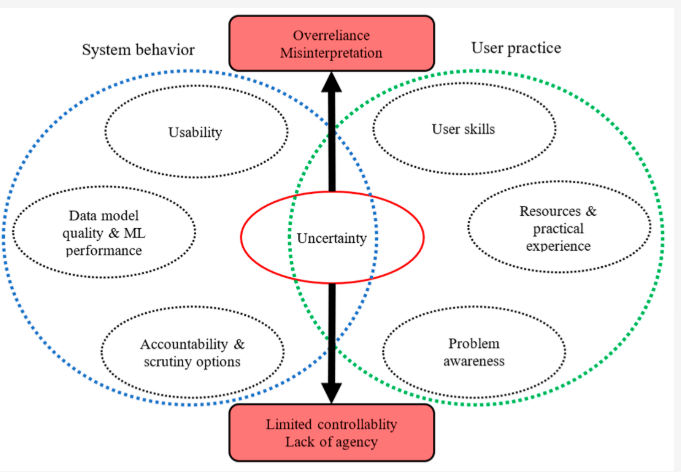

Fonte: MDPI sul reporting avanzato ML e data mining

Di conseguenza, i candidati di gruppi sottorappresentati possono essere ingiustamente sottoposti a screening, anche se le loro qualifiche sono uguali o superiori alle altre. Questo è un chiaro esempio di come la distorsione dell’automazione può contribuire direttamente alla disuguaglianza.

Come l’automazione dei processi può amplificare la discriminazione

Mentre Automazione del processo Può semplificare le operazioni e migliorare l’efficienza, può anche amplificare la distorsione algoritmica se non gestita con cura. La distorsione algoritmica si riferisce al favoritismo sistematico o alla discriminazione inerente ai sistemi automatizzati. Se i dati utilizzati per addestrare questi algoritmi contengono pregiudizi-come sesso, razza o pregiudizi socio-economici-il sistema automatizzato probabilmente erediterà e persino amplificherà questi pregiudizi.

Le implicazioni della distorsione dell’automazione sono di vasta portata e possono avere gravi conseguenze per gli individui e la società nel suo insieme. Può portare a:

- Opportunità ridotte: Gli algoritmi distorti possono limitare l’accesso all’occupazione, all’istruzione e ai servizi finanziari per determinati gruppi.

- Rinforzo degli stereotipi: I sistemi automatizzati che perpetuano gli stereotipi possono ulteriormente emarginare le comunità già svantaggiate.

- Erosione della fiducia: Man mano che le persone diventano consapevoli del potenziale per la distorsione nei sistemi automatizzati, può portare a una perdita di fiducia nelle istituzioni e nella tecnologia.

Considera come l’IA e la disuguaglianza si intersecano negli scenari del mondo reale. Nel sistema di giustizia penale, gli algoritmi predittivi vengono utilizzati per valutare la probabilità di refendere. Tuttavia, se i dati su cui questi algoritmi si basano riflettono pregiudizi storici, come tassi di arresto sproporzionatamente più elevati in determinate comunità, il pregiudizio AI in questi sistemi può comportare risultati sleali, come frasi più lunghe per le minoranze. Questo è un esempio rigido di come il pregiudizio di automazione può perpetuare le disuguaglianze sociali.

Allo stesso modo, nell’assistenza sanitaria, l’automazione dei processi può avere conseguenze non intenzionali. Se un algoritmo viene addestrato sui dati che rappresentano in modo eccessivo determinati dati demografici mentre sottorappresentano altri, il sistema può fare previsioni o raccomandazioni imprecise. Ciò potrebbe portare a discrepanze nelle cure mediche, con gruppi emarginati che ricevono un trattamento inferiore o non vengono diagnosticati in modo tempestivo.

Alcuni casi noti di distorsioni dell’algoritmo di intelligenza artificiale

è vero che fare affidamento esclusivamente sull’intelligenza artificiale può talvolta portare a risultati ingiusti. Ecco Un rapporto pubblicato dal Greenlining Institute Che mette in mostra alcuni esempi di come gli algoritmi sono stati distorti in diverse situazioni:

Programmi governativi:

- Sistema di disoccupazione del Michigan: Il Michigan ha usato un algoritmo per rilevare frodi nelle richieste di disoccupazione. Sfortunatamente, il sistema ha accusato erroneamente migliaia di persone, portando a multe, fallimenti e persino pignoramenti. Si è scoperto che l’algoritmo commetteva spesso errori e non c’era nessuno a ricontrollare le sue decisioni.

- Arkansas Medicaid: È stato usato un algoritmo per determinare chi si è qualificato per le prestazioni di Medicaid in Arkansas. Ciò ha portato molte persone a perdere l’accesso alle cure mediche essenziali. Il problema? L’algoritmo aveva errori ed era molto difficile per le persone appellarsi alle sue decisioni.

Occupazione:

- Lo strumento di assunzione di Amazon: Amazon ha cercato di creare un algoritmo per aiutarli a assumere i migliori dipendenti. Tuttavia, l’algoritmo ha finito per favorire gli uomini sulle donne. Sembra che l’algoritmo appreso dai dati di assunzione passati, che potrebbero aver contenuto pregiudizi.

Assistenza sanitaria:

- Trattamento ineguale: Anche quando gli algoritmi sono progettati per essere giusti, possono essere utilizzati in modi che creano distorsioni. Ad esempio, un ospedale ha utilizzato un algoritmo per decidere quali pazienti avevano bisogno di cure extra. Sfortunatamente, il modo in cui usavano significava che i pazienti neri dovevano essere molto più malati dei pazienti bianchi per ricevere lo stesso livello di attenzione.

Educazione:

- Bias di classificazione nel Regno Unito: Durante la pandemia, le scuole nel Regno Unito hanno usato un algoritmo per dare voti agli studenti quando gli esami venivano annullati. Tuttavia, l’algoritmo ha finito per dare voti più bassi agli studenti delle famiglie a basso reddito, mostrando come gli algoritmi possono talvolta rafforzare le disuguaglianze esistenti.

Alloggio:

- Screening ingiusto: Molti proprietari usano algoritmi per screening potenziali inquilini. Uno di questi algoritmo ingiustamente impediva a una madre di affittare un appartamento perché suo figlio aveva un reato minore nel suo record che fu successivamente licenziato.

- Disinvestment in Detroit: Un algoritmo è stato utilizzato a Detroit per decidere quali quartieri dovrebbero ricevere investimenti e miglioramenti. Ciò ha comportato che i quartieri prevalentemente neri e poveri vengano negati le risorse, mostrando come gli algoritmi possano peggiorare i problemi sociali esistenti.

Questi esempi mostrano che mentre gli algoritmi possono essere strumenti potenti, devono essere attentamente progettati e usati in modo responsabile per evitare ingiustizia e discriminazione. Dobbiamo garantire che gli algoritmi siano usati per promuovere l’equità e l’uguaglianza, non perpetuare i pregiudizi esistenti.

Affrontare la distorsione dell’automazione e la distorsione algoritmica

Affrontare la distorsione dell’automazione e il suo potenziale per perpetuare la distorsione algoritmica richiede un approccio multiforme. In primo luogo, è essenziale garantire che i dati utilizzati per formare gli algoritmi siano diversi e rappresentativi di tutti i gruppi demografici. Senza diversi dati, gli algoritmi rischiano di rafforzare i pregiudizi esistenti piuttosto che affrontarli.

In secondo luogo, la trasparenza e la responsabilità devono essere integrate in AI e sistemi di automazione. Gli sviluppatori dovrebbero essere chiari su come questi sistemi funzionano ed essere aperti al controllo. Gli audit regolari di algoritmi possono aiutare a identificare le aree in cui possono essere presenti distorsioni e le misure correttive possono essere implementate prima che questi pregiudizi abbiano effetti dannosi.

Infine, l’intelligenza artificiale e la disuguaglianza possono essere ridotte al minimo promuovendo l’equità e l’inclusività durante le fasi di progettazione e distribuzione. Integrando le pratiche etiche dell’IA, le aziende possono garantire che le loro soluzioni di automazione dei processi non siano solo efficienti ma anche giuste ed eque.

Identifica e affronta la distorsione dell’automazione nei processi con la nostra guida di esperti

Il ruolo di Weblineindia nell’affrontare la distorsione dell’automazione

Per le aziende che desiderano sfruttare il potere dell’automazione dei processi garantendo equità, trasparenza e responsabilità etica, Weblineindia si distingue come partner di fiducia con il suo Modello RelyShore di outsourcing. Come esperti nell’integrazione della tecnologia all’avanguardia con considerazioni etiche, Weblineindia eccelle nell’affrontare le sfide della distorsione dell’automazione. Si impegnano a creare soluzioni basate sull’intelligenza artificiale che minimizzano la distorsione algoritmica e promuovono la consapevolezza dell’intelligenza artificiale e della disuguaglianza.

L’approccio di Weblineindia è unico in quanto bilancia i benefici dell’automazione con un focus sull’etica dell’algoritmo, garantendo che la tecnologia sia utilizzata in modo responsabile e non perpetua la discriminazione. Che si tratti di sviluppare software personalizzato, implementazione soluzioni di automazione del processo Oppure consulendo sulle strategie di mitigazione dei pregiudizi AI, il team di Weblineindia dà la priorità alla qualità, all’equità e alla responsabilità sociale.

Pronto a creare soluzioni software imparziali alimentate dall’intelligenza artificiale?

Scegli WeblineIndia e possiamo essere certi che stai collaborando con un fornitore di servizi che non solo comprende le complessità tecniche dell’IA ma dà anche la priorità alle considerazioni etiche. Insieme, possiamo costruire un futuro in cui la tecnologia funziona per tutti, non contro di loro.

In conclusione, mentre l’automazione dei processi offre un potenziale immenso, è fondamentale essere consapevoli dei rischi posti dalla distorsione dell’automazione di cui Weblineindia si occupa. Siamo in grado di garantire che AI e sistemi di automazione siano strumenti per il bene, promuovendo l’equità, l’inclusività e l’uguaglianza in tutte le aree della vita comprendendo come funziona la distorsione algoritmica e adottando misure per affrontarlo. Contattaci E ti aiutiamo a navigare questa sfida, creando soluzioni che sostengono i più alti standard di responsabilità etica.

Hashtag sociali

#AutomationBias #Ethicai #BiaSintech #StopalGorithMicDiscrimination #Ai #Automation #Aiautomation #SoftWareSolutions

Vuoi costruire soluzioni inclusive ed equamente basate per la tua attività?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.