Treningssporingsapper har utviklet seg langt utover enkle trinntellere eller GPS-baserte aktivitetslogger. Dagens brukere forventer rik sosial interaktivitet, konkurransedyktig gamification, sanntids datasynkronisering og sømløs integrasjon med et voksende økosystem av wearables og helseplattformer. Strava satte et mål på dette rommet ved å smelte sammen sporing av atletisk aktivitet med sosialt engasjement – toppliste, utfordringer, kommentarer, klubber og til og med virtuelle løp – alt pakket inn i en glatt UX som prioriterer både ytelse og fellesskap.

Å designe et system som dette går langt utover grunnleggende CRUD -operasjoner på brukertrening. Det krever en robust arkitektur som kan håndtere:

- Høyfrekvente geo-lokasjonsoppdateringer fra millioner av samtidig brukere

- Sanntidsfeedgenerering og aktivitetssending til etterfølgernettverk

- Skalerbare, lave latens sosiale graf spørsmål

- Media lagring og gjenfinning (f.eks. Rutekart, bilder, merker)

- Hendelsesdrevne datapipelinjer for databehandlingssegmenter, toppliste og utfordringer

- Sikkerhets- og personvernkontroller på tvers av komplekse preferanser for datadeling

Utfordringen er å arkitektere en backend som støtter en rask, engasjerende og sosialt rik opplevelse, samtidig som de forblir fleksibel nok til å integrere seg med tredjeparts treningsenheter, støtte fellesskapsmoderasjon og utvikle nye funksjoner uten å bryte gamle.

Dette tekniske dypdykket bryter ned arkitekturen til et slikt system. Den skisserer kjernekravene, designene for skalerbarhet og reaksjonsevne i sanntid, datamodeller for brukergenerert innhold og infrastrukturmønstre for å støtte en sosial treningsplattform som kan vokse til millioner av brukere uten å nedbryte ytelsen eller påliteligheten.

Systemkrav

1. Funksjonskrav

Fitness -appens kjernefunksjonaliteter må støtte både aktivitetssporing og sosialt engasjement i skala. Viktige funksjonelle krav inkluderer:

- Brukeradministrasjon: Påmelding, autentisering, profilredigering og gjenoppretting av kontoer.

- Aktivitetsopptak: Logg GPS-baserte treningsøkter (f.eks. Kjør, ritt), støtte manuell oppføring og fanger metadata som avstand, tempo, høyde, hjertefrekvens og utstyr som brukes.

- Synkronisering i sanntid: Strømplassering og sensordata fra mobile eller bærbare enheter med lav latens.

- Sosial graf: Følg/ikke følgede mekanismer, vennforslag og personvernkontrollert aktivitetssynlighet (f.eks. Privat, bare følgere, offentlig).

- Aktivitetsfeed: Dynamisk tidslinje som viser treningsøkter fra fulgte brukere, inkludert likes, kommentarer og re-shares.

- Utfordringer og toppliste: Lag tidboksede konkurranser (f.eks. “Ride 100 km på 7 dager”), sporingsplater og beregne rangeringer asynkront.

- Mediestøtte: Last opp og vis bilder, rutevarm og personlige prestasjoner (f.eks. Merker, milepæler).

- Varsler: Push- og in-app-varsler for likes, kommentarer, nye følgere og utfordrer oppdateringer.

- 3.-parti-integrasjon: Synkronisert med Apple Health, Google Fit, Garmin og andre treningsøkosystemer.

2. Ikke-funksjonelle krav

For å støtte sanntidsinteraksjon og voksende brukerbaser, må systemet oppfylle strenge ikke-funksjonelle krav:

- Skalerbarhet: Horisontalt skalerbare tjenester og datalagre for å håndtere millioner av aktive brukere og terabyte med geo-temporale data.

- Lav latens: Underundersøkelse responstid for sosiale interaksjoner og kartgjengivelse i sanntid.

- Tilgjengelighet: 99,9%+ oppetid med feiltoleranse over regioner og soner.

- Sikkerhet og personvern: OAuth2-basert autentisering, granulær tilgangskontroll, kryptert lagring og brukerstyrte delingsinnstillinger.

- Utvidbarhet: Modulære tjenestegrenser for å støtte fremtidige funksjoner som virtuelle løp, klubbbaserte chatter eller live coaching.

- Datakonsistens: Eventuell konsistens er akseptabel i feeds og toppliste, men det kreves sterk konsistens for transaksjoner som kontoinnstillinger eller premiumkjøp.

- Offline støtte: La brukere registrere og kø aktiviteter når de er frakoblet, med automatisk synkronisering ved tilkobling.

3. Begrensninger og forutsetninger

- Mobilapper (iOS og Android) vil være de viktigste klientene; Nettgrensesnittet er sekundært.

- Plasserings- og helsedata må behandles i henhold til regionale overholdelsesregler (f.eks. GDPR, HIPAA der det er aktuelt).

- Flertallet av brukerne vil synkronisere 1–2 aktiviteter per dag, men strømbrukere og integrasjoner kan øke inntakstallene under hendelser eller utfordringsperioder.

- Sky-innfødte distribusjon; Arkitekturen forutsetter bruk av administrerte skytjenester for beregning, lagring og streaming.

Bruk sak / scenario

1. Forretningskontekst

Fitness -appen retter seg mot en bred demografisk – fra tilfeldige turgåere til konkurrerende syklister – men legger vekt på samfunnsengasjement over individuell sporing. Tenk på det som en hybrid mellom en personlig trener og et sosialt nettverk. Målet er å drive tilbakevendende bruk gjennom konkurranse, sosial ansvarlighet og gamified fremgang, til slutt øke oppbevaring og konvertering av abonnement. Inntektsgenerering i appen kan omfatte:

- Premium abonnement for avansert analyse, live segmenter og dypere treningsinnsikt

- Merket utfordringer eller sponsede konkurranser

- Kampanje i appen (f.eks. Tilknyttet markedsplass for sko, sykler, wearables)

Appen må derfor muliggjøre et robust fundament for ytelsesmålinger i sanntid, samtidig som den leverer engasjerende, sosialt dynamiske opplevelser som brukere kommer tilbake til daglig-selv om de ikke trener den dagen.

2. Personas & bruksmønstre

- Solo -idrettsutøvere: Brukere som sporer treningsøktene sine, sammenligner tidligere ytelse og blir med globale utfordringer eller segmenter.

- Sosiale entusiaster: Svært engasjerte brukere som legger ut ofte, kommenterer venners aktiviteter og trives med samfunnsinteraksjon.

- Klubbsjefer: Kraftbrukere som koordinerer gruppearrangementer, administrerer private toppliste og moderate sosiale rom i klubber.

- Datanerder: Premium-abonnenter som er interessert i hjertefrekvenssoner, kraftkurver, utvinningsmålinger og dataeksport.

3. Forventet skala

Systemet skal være designet for å støtte:

- 10m+ registrerte brukere

- 2–3m Maus (månedlige aktive brukere), med ~ 500k daus (daglige aktive brukere)

- 10m+ aktivitet opplastes per måned, med topper i helgene og store utfordringsarrangementer

- 500K+ samtidig brukere i høysesongen

- Milliarder av datapunkter per måned på tvers av GPS, høyde, hjertefrekvens og bevegelsessensorer

- Millioner av daglige fôrforespørsler, sosiale interaksjoner og varsler i sanntid

For å oppfylle disse kravene, må arkitekturen optimalisere for lesetunge sosiale arbeidsmengder, sprengt inntak av trafikk fra aktivitetsopplastinger og asynkron behandling med høy gjennomstrømning for segmentmatching og topplisteoppdateringer.

Trenger du hjelp med å designe din egen kondisjon eller sosiale app?

Å bygge en sosial første treningsplattform som skalerer til millioner av brukere tar mer enn ren kode-det tar riktig arkitektur fra første dag.

Vil du ha ekspertveiledning om design for ytelse, sanntidssynkronisering og brukerengasjement i skala?

Arkitektur på høyt nivå

Arkitekturen må effektivt støtte inntak av sanntidsaktiviteter, sosial fôrfordeling, geospatial analyse og brukerinteraksjon-alt i skala. Dette krever en modulær, tjenesteorientert tilnærming med veldefinerte grenser mellom kjernesystemer som aktivitetssporing, brukerstyring, sosial grafbehandling og varsling levering.

1. Oversikt over komponent

Systemet er strukturert rundt følgende hovedkomponenter:

- API Gateway: Sentral inngangspunkt for all klientkommunikasjon. Håndterer autentisering, hastighetsbegrensning og ruter trafikk til interne tjenester.

- Auth-tjeneste: Administrerer OAuth2-strømmer, utstedelse av symbolet, sesjonsstyring og integrasjon med tredjeparts identitetsleverandører (f.eks. Apple, Google).

- Brukerprofiltjeneste: Lagrer personlig informasjon, preferanser, utstyr og personverninnstillinger.

- Aktivitetstjeneste: Håndterer GPS-basert trening av trening, ruteparsing, aktivitetsvalidering og metadata-ekstraksjon (f.eks. Tempo, høydeforsterkning).

- Fôrtjeneste: Genererer og lagrer aktivitetsfeeds, behandler oppdateringer av sosiale graf og håndterer vifte ut for nye aktivitetsposter.

- Sosial grafstjeneste: Administrerer følgerforhold og beregner synlighet for aktiviteter og utfordringer.

- Challenge & Leaderboard Engine: Beregner rangeringer, håndterer utfordringslogikk og oppdaterer virtuelle trofeer og segmenter.

- Medietjeneste: Håndterer bildeopplastinger (bilder, rutekart), CDN -hurtigbufring og tilgangskontroll.

- Varslingstjeneste: Publiserer sanntids- og batchvarsler via WebSockets, FCM/APN-er eller innbokser i appen.

- Analytics Pipeline: Prosesser Aktivitetsstrømmer for innsikt, trenddeteksjon og idrettsutøveranbefalinger.

- Administrasjons- og moderasjonsportal: Verktøy for å håndtere misbruksrapporter, utfordringsskaping og analysedashboards.

2. Arkitekturdiagram på høyt nivå

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Dataflytsammendrag

Når en bruker starter en treningsøkt:

- Mobilappen strømmer GPS og sensordata via en websocket eller batched API -last opp til Aktivitetstjeneste.

- Tjenesten analyserer dataene, lagrer treningen og avgir en hendelse til Fôrgenerator.

- De Sosialt grafstjeneste Bestemmer hvem som kan se aktiviteten.

- Feedelementet lagres og presses til relevante brukere via Varslingstjeneste.

- Hvis aktuelt, evalueres aktiviteten av Leaderboard Engine For utfordringsberettigelse og rangeringsoppdateringer.

- Bilder og rutevisualiseringer sendes til Medietjeneste og hurtigbufret gjennom en CDN.

Denne modulære designen støtter både horisontal skala og isolert tjenesteutvikling. Det muliggjør også sanntids fan-out for feeds og varsler ved bruk av hendelsesdrevet kommunikasjon (f.eks. Kafka eller NAT).

Databasedesign

1. Kjernedatamodeller og ERD -oversikt

Systemet bruker en polyglot-utholdenhetstilnærming-relasjonsdatabaser for transaksjonell integritet, tidsserie/NOSQL for aktivitetsdata, og graf eller i minnet for å få høy ytelse sosiale spørsmål.

Primære enheter:

- Bruker: Profilinfo, Auth -innstillinger, preferanser, abonnementsnivå

- Aktivitet: Treningsdata inkludert GPS -poeng, beregninger, utstyr, media

- Følge: Følger-følgede forhold og synlighetsregler

- FeedItem: Gjengivbare hendelser knyttet til brukere (f.eks. Lagt ut aktivitet, kommentar, merke)

- Utfordring: Metadata og stat for gruppekonkurranser

- LeaderboardEntry: Utfordring eller segmentposisjon og beregninger

Enhetsforholdsdiagram (konseptuelt):

[Bruker]

├── id (PK)

├── navn, e-post, avatar_url

└── settings_json

[Aktivitet]

├── id (PK)

├── bruker-id (FK → Bruker)

├── type, start_time, varighet

├── avstand, høyde, avg_hr

├── geo_data_ref (FK → GeoStore)

└── synlighet (offentlig / følgere / privat)

[GeoStore] (ekstern lagringsindeks eller S3 ref)

├── id (PK)

├── aktivitets-id (FK → Aktivitet)

└── gps_data (array eller filpeker)

[Følge]

├── follower_id (FK → Bruker)

├── followee_id (FK → Bruker)

└── opprettet_kl

[FeedItem]

├── id (PK)

├── actor_id (FK → Bruker)

├── verb ("postet", "kommenterte", "likte")

├── objekt-id (f.eks. aktivitets-id, kommentar-id)

└── target_user_id (FK → Bruker)

[Utfordring]

├── id (PK)

├── navn, beskrivelse, type

├── startdato, sluttdato

└── synlighet, rule_json

[LeaderboardEntry]

├── id (PK)

├── challenge_id (FK → Challenge)

├── bruker-id (FK → Bruker)

├── metrisk_verdi (avstand, varighet)

└── rangering

2. Valg av databaseteknologi

Hvert datadomene er optimalisert for sitt eget tilgangsmønster:

- PostgreSql: Kanonisk datakilde for brukerprofiler, aktiviteter, fôrmetadata og utfordringer. Utmerket for transaksjonell integritet og utenlandsk nøkkelhåndhevelse.

- Timescaledb / influxDB: For inntak av GPS-punkt, aktivitetstelemetri og tidsserieanalyse (f.eks. Tempo over tid, HR-soner).

- S3 + CD: Brukes til lagring av rå GPS-spor, rutebilder og opplastede medier (med sikker forhåndsignert URL-tilgang).

- Redis / Memcached: For hurtig henting av toppliste, nyere aktiviteter og forhåndsbestemte fôrdata.

- Neo4j eller dgraph (valgfritt): For komplekse sosiale graf Traversal, Klubbmedlemskap og Mutual Folker -forslag i skala.

3. Flerleie- og partisjoneringsstrategi

- Sharding: Aktiviteter og fôrvarer blir avskåret av bruker -ID eller region -ID for å muliggjøre horisontal skalering på tvers av partisjoner.

- Tidsbasert partisjonering: GPS -telemetri og toppliste er delt inn i månedlige/ukentlige partisjoner for aldring og ytelse.

- Myk multi-leiekant: Klubber eller organisasjoner (f.eks. Løpende grupper, sykkelteam) opererer innen det globale navneområdet, men kan få scoped spørsmål (via leietaker) når det er nødvendig.

4. Replikering og høy tilgjengelighet

- PostgreSql: Utplassert med varme standby -kopier og Wal -frakt for failover.

- Redis: Konfigurert med Sentinel for høy tilgjengelighet og automatisert mestervalg.

- Media og Geostore: Objektlagring blir replikert over regioner og leveres gjennom en global CDN for tilgang med lav latens.

Denne databasedesignen sikrer fleksibel skjemautvikling, rask aktivitetsinntak og skalerbar støtte for sosial arbeidsmengde og analyser – alt sammen med å bevare referanseintegriteten der den betyr mest.

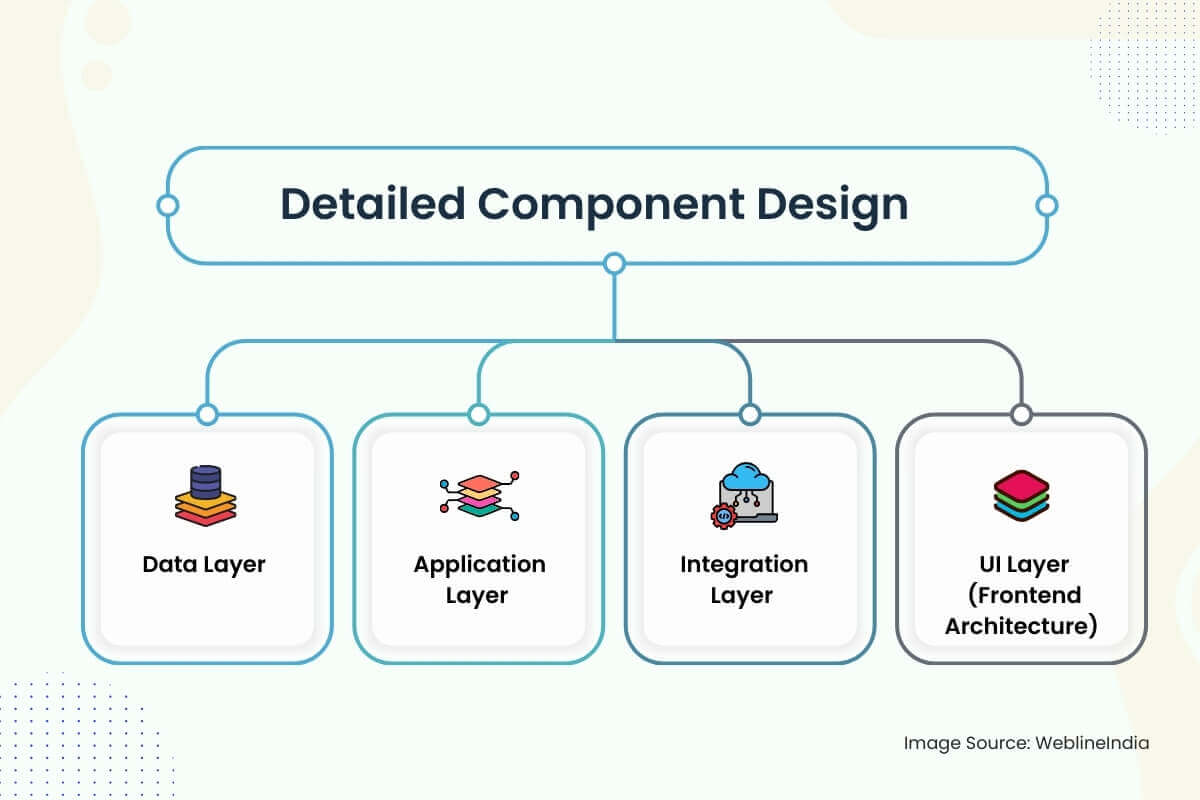

Detaljert komponentdesign

1. Data lag

- Skjemadrategi: Skjemaer er designet rundt klare domenegrenser: brukere, aktiviteter, feeds, sosiale grafer og utfordringer. Kolonner som `Synlighet`,` Status` og `Aktivitet_type` Bruk tellerte typer for indekseringseffektivitet. UUID -er er å foretrekke fremfor autoincremented heltall for å unngå varme nøkkelproblemer i distribuerte butikker.

- Datatilgang: Tilgang til kjernedata går gjennom tynne tjenestelags-lagringsplasser som håndhever retningslinjene for tilgangskontroll (f.eks. Synlighetskontroller av aktiviteter). Lesoperasjoner er optimalisert via materialiserte visninger og forhåndsinnsamlede øyeblikksbilder. Skrivetunge stier som aktivitetsinntak Bruk Skriv foran køer og bulkinnsats rørledninger for å glatte inntakspikene.

- Validering: Inngangsvalidering oppstår på flere nivåer-kantskjemahåndhevelse via OpenAPI eller GraphQL, dyp validering i tjenestelag (f.eks. Gyldige GPS-punkter, ikke-overlappende tidsstempler) og asynkrone sanity-sjekker på telemetri-data via bakgrunnsjobber.

2. Søknadslag

Servicedesign: Hvert hoveddomene (bruker, aktivitet, fôr, varsel, sosial graf) implementeres som en isolert mikroservice. Tjenester utsetter både GRPC og hvile endepunkter-hvile for offentlige API-er, GRPC for kommunikasjon mellom tjenester. Rengjør arkitekturprinsipper skiller domenelogikk fra transport- og infrastrukturkode.

Rammer:

- Gå eller rust for ytelseskritiske tjenester (aktivitet, feed, toppliste)

- Node.js eller Python for limkode, integrasjoner og asynk

- GraphQL Server (Apollo eller Hasura) for front-end aggregering og erklærende spørring

Autentisering: JWT -symboler utstedes via OAuth2 -strømmer. Service-to-service samtaler bruker signerte interne symboler med rollebaserte omfang.

Ratebegrensende & kvoter: Implementert via Redis-støttede tokenbøtter ved gateway og brukernivå granularitet (spesielt for aktivitetsopplastinger).

3. integrasjonslag

Meldingshaler: Kafka eller Nats brukes til async-arbeidsflyter-Aktivitetsbehandling, fôrvifte, segmentmatching og varslingspublisering. Idempotente behandlere med sterke leveringsgarantier brukes til å forhindre dupliserte innlegg eller topplisteoppføringer.

Tredjepartssynkronisering: OAuth -integrasjoner med Garmin, Fitbit, Apple Health, etc., kjørt via en bakgrunn Poller + Webhook Combo. Nye data står i kø og behandlet via aktivitetsinntakets rørledning.

Hendelsestyper:

aktivitet→ fan-out for å mate service, varsle følgereutfordring→ Kontroller valgbarhet, utløser topplisteinnsatsbruker. Følget→ Oppdater graf, oppdater feed, enqueue velkomstvarsling

4. UI -lag (frontend arkitektur)

App Stack: React Native for mobilapper på tvers av plattformer, med TypeScript og Redux Toolkit for State Management. Web -appen bruker Next.js for SSR/ISR med Tailwind Utility Styling og GraphQL Queries to backend.

Sikkerhetsproblemer:

- Klienthemmeligheter er aldri innebygd – Oauth PKCE Flow er obligatorisk

- Alle API-anrop krever signerte symboler, og offentlig vendte endepunkter filtreres etter hastighet, opprinnelse og rolle

- GEO -data er sandkasse per synlighetsinnstilling – Private aktiviteter er ekskludert fra varmekart, feeds og segmentberegninger

Sanntidsfunksjoner: Websockets eller SSE brukes til å skyve varsler, utfordringsstatus og fôroppdateringer. Fallback til lang meningsmåling på begrensede nettverk. Frontenden opprettholder en lokal SQLite -cache for logging offline aktivitet.

Arkigere noe lignende?

Å designe sanntid, geo-bevisst, sosialt interaktive plattformer tar presisjon på tvers av dataflyt, hendelseshåndtering og mobilarkitektur.

Hvis du bygger noe ambisiøst-som en sosial treningsplattform, bærbar integrasjon eller sanntidsfeed-vil vi gjerne hjelpe deg med å få det helt fra starten av.

Skalerbarhetshensyn

1. Omskalering av applikasjonslag

- Stateløse tjenester: Alle kjernetjenester (aktivitet, fôr, utfordring osv.) Er statsløse og horisontalt skalerbare. Hver forekomst er disponibel og frontet av en belastningsbalanse. Delt-ingenting-prinsipper sikrer at tilfeller ikke er avhengige av lokal stat.

- Auto-skalering: K8S-basert horisontal pod autoscaling (HPA) brukes til tjenester basert på CPU, minne og kødybdeberegninger. For latensfølsomme tjenester (som fôr eller varsel), kan tilpassede beregninger (f.eks. Hendelsesforsinkelse) utløse raskere skala-outs.

- API Gateway Throttling: Klient- og IP-baserte hastighetsgrenser forhindrer API-flommer. Burst-toleranse støttes ved hjelp av redis-støttet skyvevindu eller lekker bøttealgoritmer.

2. Data lagskalering

Les optimalisering: Ofte tilgjengelige data (f.eks. Nyere aktiviteter, toppliste -øyeblikksbilder) blir cache aggressivt i Redis med TTLS og LRU -utkastelse. PostgreSql Les kopier skaleres basert på trafikk til avlastning av analyser og UI -spørsmål.

Sharding Strategies:

- Aktivitetsdata: Avskåret av bruker -ID på tvers av partisjoner eller logiske klynger (f.eks. Aktivitet_01, aktivitet_02, …)

- Feedelementer: Partisjonert av skuespiller -ID og mottaker -ID med sammensatte indekser for raske oppslag

- Geostore: Bruker S3-nøkkelprefiksering etter region og tidsstempel for optimalisert objektoppføring og kostnadseffektiv tiering

3. Fôr og sosial graf fan-out

Feedgenerering er en viktig skalerbarhetsutfordring i sosiale plattformer. Systemet bruker en hybrid fan-out-tilnærming:

- Fan-Out-on-Write (primær): Når en bruker legger ut en aktivitet, skyver fôrtjenesten den inn i forhåndsbestemte fôrrader for følgere.

- Fan-out-on-Read (Fallback): For brukere av høye fanout (kjendiser, påvirkere), er feeds konstruert på spørringstidspunktet med paginering fra Kafka-støttede hendelseslogger eller fôrindeksbord.

Fôrlagring: Implementert via skriveoptimaliserte tabeller eller kolonne-familiebutikker (f.eks. Scylladb eller Cassandra-lignende butikker) med TTL-er for flyktige hendelser og forhåndsutgitt JSON for rask hydrering.

4. Utfordring og topplistebehandling

- Batch -beregning: Leaderboards beregnes i partier ved hjelp av en strømbehandlingsmotor (f.eks. Apache Flink, Spark Streaming). Segmentkamp og utfordringsvalideringer kjøres asynkront fra aktivitetsinntak ved bruk av holdbare Kafka -emner.

- Vinduet aggregering: Utfordringsstatistikk er vinduet (daglig, ukentlig) for å forhindre full historieskanning og redusere lagringstrykket. Aggregerte materielle visninger indekseres per utfordring og segment.

5. GEO- og sensordatainntak

- Høyfrekvensinntak: GPS-poeng er skrevet i partier til tidsserie-butikker (eller S3-filer med indeksering) og sjekkpunkt for å unngå minnetoverløp. Batching reduserer skriveforsterkning på DB og fremskynder baktrykkshåndtering.

- Komprimering: GPS-koordinater er delta-kodet og gzippet før lagring. Rehydrering skjer ved kartrender eller eksporttid, ikke under fôrskjerm i sanntid.

6. Tredjeparts trafikk bursts

Pigger fra Garmin- eller Apple-synkronisering blir absorbert ved bruk av avkoblede inntakskøer og hastighetskontrollerte ETL-rørledninger. Hver integrasjon har en effektbryter og prøver på nytt for å forhindre misbruk av oppstrøms eller fan-out-stormer.

Sikkerhetsarkitektur

1. Autentisering og autorisasjon

- Autentisering: Alle klientinteraksjoner bruker OAuth 2.0 med PKCE for mobile strømmer. JWTS utstedes og signeres av Auth -tjenesten, som inneholder bruker -ID, omfang og utløp. Oppdater symboler roteres og krypteres i ro.

- Forbundet innlogging: Legistreringer av Google, Apple og Facebook støttes, men alltid knyttet til en innfødt brukeridentitet. Sosiale påloggingstokener er validert serversiden, ikke direkte pålitelig.

- Autorisasjon: Hver tjeneste validerer JWT-tokenet og håndhever regler på omfangsnivå (f.eks. `Les: Feed`,` Post: Activity`). RBAC (rollebasert tilgangskontroll) brukes til interne verktøy (f.eks. Admin, moderatorroller).

2. Databeskyttelse

- I hvile:

- PostgreSQL, Redis og Object-butikker er kryptert ved bruk av AES-256-kryptering med kundestyrte nøkler (CMKS).

- Sensitive felt (f.eks. E -post, helsemålinger) er kryptert på applikasjonslaget før DB skriver.

- I transitt: All trafikk mellom tjenester og klient-til-server er beskyttet av TLS 1.2+. Mutual TLS brukes til GRPC -kommunikasjon mellom pålitelige backend -tjenester.

- Maskering på feltnivå: Sensitive felt er maskert eller redigert i tømmerstokker og dashbord. Observerbarhetsverktøy håndhever feltmerke og automatisert PII -skanning før inntak.

- Geo personvern: Aktiviteter merket som private eller “bare følgere” er fullstendig ekskludert fra feeds, toppliste og søkeindekser. Heatmap-data er bare anonymisert og prøvetatt fra offentlige aktiviteter, med geo-blurring nær hjemmesoner.

3. IAM Design & Secrets Management

- Hemmeligheter: Alle API -nøkler, DB -legitimasjon og Webhook Tokens lagres i et sentralisert hvelv (f.eks. Hashicorp Vault eller AWS Secrets Manager) og injisert via miljø ved kjøretid. Rotasjonspolitikk automatiseres for kortvarig legitimasjon.

- Iam: Hver mikroservice har en unik identitet og sett med roller. IAM-policyer er scoped til de minimale tillatelsene som kreves (f.eks. Skrivetilgang til objektlagring, bare skrivetilgang til Kafka-emner). CI/CD -agenter påtar seg midlertidige roller ved bruk av OIDC Trust.

4. Sikker koding & API -beskyttelse

- Inngangsvalidering: All ekstern inndata er skjemavalidert ved bruk av OpenAPI eller JSON-skjema. Frontend og backend håndhever lengde, format og grenser sjekker.

- Ratebegrensning: Per-bruker- og Per-IP-grensen håndheves via Redis eller API Gateway-plugins. Misbruksdeteksjonsmodeller (f.eks. Login storm eller spam -oppførsel) lever inn i dynamisk gasspolitikk.

- Replay -beskyttelse: Alle signerte forespørsler inkluderer nonces eller tidsstempler. Aktivitetsopplastinger og netthooks bruker HMAC -signaturer for å validere opprinnelse og forhindre tukling.

- Kodesikkerhet: Statisk analyse (SAST) og avhengighetsskanning er integrert i CI -rørledninger. Secrets Detection (f.eks. Gitleaks) blokkerer utilsiktet eksponering. Alle kritiske strømmer går gjennom fagfellevurderte og reviderte trekkforespørsler.

Utvidbarhet og vedlikeholdbarhet

1. Modulære tjenestegrenser

Hvert hoveddomene – brukere, aktiviteter, fôr, varsler, utfordringer – er innkapslet i sin egen tjeneste, med sitt eget skjema, API og distribuert kjøretid. Disse tjenestene kommuniserer asynkront gjennom meldingskøer eller synkront via GRPC/REST, avhengig av latensfølsomhet.

Denne isolasjonen muliggjør uavhengig skalering, frigjøringssykluser og ombordstigning av nye ingeniører uten risiko for sikkerhetsskader på ikke -relaterte funksjoner. For eksempel å sende et nytt topplisteformat eller varslingsutløser ikke berører aktiviteten til å innta logikk eller brukerprofiler.

2. Plugin-orienterte mønstre

- Begivenhetslyttere: Nye funksjoner (f.eks. prestasjoner, live coaching-varsler eller enhetsbaserte merker) introduseres ved å abonnere på kjernebegivenheter som activity.created eller challenge.completed. Dette tillater innovasjon uten å omskrive oppstrømslogikk.

- Funksjonsflagg: Alle brukervendte funksjoner kontrolleres av dynamiske flagg (f.eks. Lanseringsdark eller interne vekslingssystemer), noe som gir mulighet for kanari-utrullinger, A/B-testing eller iscenesatte utgivelser basert på region, brukernivå eller plattform.

- Tilpasset utfordringslogikk: Utfordringsmotoren er utvidbar via regelmotorer eller innebygd skripting (f.eks. LUA eller CEL). Dette gjør det mulig for markedsførings- eller klubbledere å lage nye typer utfordringer (f.eks. “Klatre på 2k meter på 3 dager”) uten hardkodende logikk i backend.

3. Rengjør kode og mønstre

- Domenedrevet design (DDD): Tjenester bruker DDD for å organisere logikk etter avgrenset kontekst – aktivitetsaggregering, segmentscoring, følgeradministrasjon – snarere enn med teknisk lag. Dette reduserer tverrskjæringslogikk og spredning av koder.

- Testing og fôring: CI håndhever streng linting, kodedekningsterskler og kontraktstester for alle API -er. Utviklerhastighet holder seg høy fordi lokale dev -oppsett bruker containere med frøede databaser og hånskø for rask iterasjon.

- MonorePo vs PolyRepo: Backend er typisk PolyRepo (en per tjeneste), mens mobilappen kan bo i en monorepo med modulære pakker. Delte protobufs eller GraphQL-skjema-definisjoner er versjonskontrollert i en egen kontraktsrepo.

4. Serviceversjonering og bakoverkompatibilitet

- API versjonering: Alle offentlige API -er er versjonert (f.eks. `/V1/aktiviteter`). Avskrevne endepunkter opprettholdes for en definert solnedgangsperiode, med observerbarhet for å overvåke bruken.

- Skjemautvikling: PostgreSQL-skjemaer bruker additive migrasjoner (legger til kolonner, ikke fjerner dem) og gir aldri nytt navn eller begrensninger uten dobbeltlesing/skriving på plass. For NoSQL-butikker er hvert objekt merket med en skjemaversjon for bakoverkompatibel deserialisering.

- Protokollkompatibilitet: GRPC og Protobuf -kontrakter er designet for å unngå å bryte endringer – felt blir aldri fjernet, og felt -ID -er blir ikke gjenbrukt. For GraphQL forblir utdaterte felt tilgjengelige med advarselsoverskrifter og innlinting i frontend.

Tenker du langsiktig for plattformen din?

Trenger du hjelp med å designe en modulær, fremtidssikker arkitektur som ikke vil smuldre under versjonering av helvete eller vekstflaskehalser?

Enten du skalerer en sosial app eller utvider en treningsplattform, er vi her for å hjelpe arkitekt på lang sikt.

Ytelsesoptimalisering

1. Database spørringsinnstilling

- Spørringsindeksering: Hver høykardinalitetskolonne som brukes i filtre eller sammenføyninger-for eksempel `user_id`,` aktivitet_id`, `create_at`, eller` challenge_id`-støttes av btree eller gin-indekser. Sammensatte indekser opprettes for hyppige spørsmål som `follower_id + create_at desc` i feeds eller` user_id + challenge_id` i topplisten oppslag.

- Materialiserte visninger: Daglige opprullinger (f.eks. “Total distanseløp denne uken”) lagres som materialisert visning og oppdatert via ASYNC -jobber. Dette unngår repeterende aggregeringsskanninger og fremskynder mobile dashbordmålinger.

- Spørring caching: Leaderboards, offentlige profiler og statiske utfordringssider bruker Redis som et hurtigbufringslag med intelligente TTL -er og eksplisitt ugyldighet på relevante hendelser.

2. Asynkron prosessering

- Utsatt arbeidsmengde: Tunge oppgaver som segmentmatching, heatmap-generering, merkete evaluering og tilhengerfôr-fan-out blir alle utsatt for bakgrunnsarbeidere som bruker Kafka/NATS-emner. Dette holder aktivitetsinnleveringsveien responsiv (~ 100–200ms P99).

- Bulkinntakstier: Opplastinger fra Garmin eller Apple Health er batchet og behandlet parallelt, med deduplisering og feilisolasjon for å unngå å blokkere full enhetssynkronisering på grunn av enkelt korrupte filer.

3. Ratebegrensende og overgrepskontroller

- Hastighetskontroll: Hvert API-endepunkt har brukernivå- og IP-nivå rate-grenser håndhevet ved inngangsporten. Høykostnadsoperasjoner (f.eks. Innleggingsaktiviteter med media) er ytterligere begrenset via adaptiv gassbundet for å be om latens og kø etterslep.

- Misbruksdeteksjon: Maskinlærte modeller scorer handlinger som følg spam, kommentarflom eller voldelig geo-posting. Disse er bundet til sanntidsfiltre som bremser eller sandkasse ondsinnede klienter automatisk.

4. Cache -lag

- Kantbufring: Rutekart, profilavatarer, utfordringssider og hetekartfliser serveres alle gjennom CDN -kantnoder (Cloudflare, raskt). Cache -nøkler er merket med versjonshager for å tillate rask global ugyldighet.

- Caching av klientsiden: Mobilappen bruker lokal SQLite for offline-modus, med hydrering fra delta-oppdaterte JSON-klatter mottatt ved oppstart eller post-login. Dette muliggjør øyeblikkelig fôr gjengivelse og jevnere kalde starter.

5. Frontend Performance

- Inkrementell lasting: Feed-ruller, profilvisninger og utfordring viser alle implementerte uendelige rulle eller vinduer paginering ved hjelp av markørbaserte symboler. Dette minimerer nyttelaststørrelse og minnetrykk på mobile klienter.

- Bildeoptimalisering: Alle opplastede bilder er endret, komprimert og formatkonvertert (f.eks. Webp) av medietjenesten før CDN-levering. Enhetsspesifikke aktivarianter velges ved hjelp av innholdsforhandlingsoverskrifter.

- JS -pakking og risting av tre: Nettklienter bruker moderne bundlers (f.eks. Vite eller Webpack 5) med dynamisk importsplitting og risting av tre. Lat belastning brukes for ikke-kritiske UI-komponenter som diagrammer, kart eller analyser.

Teststrategi

1. Typer testing

- Enhetstesting: Hvert tjenestelag har omfattende enhetstester som dekker domenelogikk, inngangsvalidering og verktøyfunksjoner. Disse er hurtigløpende og isolerte-ingen eksterne avhengigheter tillatt. Spottende biblioteker (f.eks. Gomock, Pytest-Mock, Jest) brukes til å isolere bivirkninger.

- Integrasjonstesting: Key Service-interaksjoner-for eksempel aktivitetsinnlevering som utløser fôrproduksjon eller utfordringsberettigelseskontroller-er dekket med Docker-baserte testmiljøer. Disse testene spinner opp reelle avhengigheter (PostgreSQL, Redis, Kafka) og validerer atferd under realistiske forhold.

- Kontraktstesting: For GRPC og REST API-er, validerer kontraktstester (f.eks. Å bruke PACT eller BUF for Protobuf) at produsent- og forbrukertjenester fester seg til avtalte skjemaer, spesielt på tvers av serviceversjonshumper eller under parallelle distribusjoner.

- End-to-end (E2E) testing: Kritiske brukerstrømmer – påmelding, pålogging, aktivitetssporing, kommentering – testes ved hjelp av sypress eller detox (for React Native). Disse testene kjøres på emulatorer og virkelige enheter i CI mot iscenesettelsesmiljøer.

2. CI -testdekningsstrategi

- Kodedekningshåndhevelse: Minimumsgrenser håndheves for PRS ved bruk av verktøy som Codecov eller Sonarqube. Dekningsportene blokkerer fusjonerer hvis ny kode mangler riktige testtilfeller – spesielt for tjenestelogikk eller datatransformasjonsfunksjoner.

- Parallelliserte CI -rørledninger: Tester er gruppert etter tjeneste og utført parallelt via GitHub -handlinger, circleci eller buildkite. Testmatrise inkluderer miljømutasjoner (f.eks. Ulike DB -versjoner, API -versjoner).

- Testarmaturer og såing: Delte testdata leveres via containeriserte øyeblikksbilder eller deklarative YAML/JSON -inventar. Alle tjenester støtter testmodus bootstrapping for lokale og CI -testmiljøer.

3. Last og resiliens testing

- Lasttesting: Land, artilleri eller K6-skript simulerer topptrafikkmønstre-store fan-out, bulkaktiviteter opplastinger, utfordrings-topplisteoppdatering-for å teste systemrespons under stress. Lastetester kjøres ukentlig og under større utgivelser.

- Chaos Engineering: Verktøy som Gremlin eller Litmuschaos injiserer feil ved tjenesten, DB eller nettverkslag (f.eks. Latenspigger, droppet Kafka -partisjoner, DB Failovers). Målet er å validere prøvetid på nytt, tilbakeslagslogikk og varslingsdekning.

- Påstander om spenst: Havbrytere, skott og tilbakeslag av timeout er eksplisitt testet. Kanari-distribusjoner inkluderer tester av feilinjeksjoner før full utrulling fortsetter.

DevOps & CI/CD

1. CI/CD -rørledningsoversikt

Hele systemet er bygget på Git-baserte arbeidsflyter (GitHub, Gitlab eller Bitbucket) med automatiserte rørledninger utløste på trekkforespørsler, sammenslåing og tagbaserte utgivelser. CI/CD behandles som et førsteklasses produkt med ytelse, isolasjon og synlighet som kjerneprinsipper.

Rørledningsstadier:

- Bygge: Containerbilder er bygget per tjeneste ved hjelp av flertrinns dockerfiles. Vanlige basebilder blir hurtigbufret og gjenbrukt. For frontend -apper inkluderer Build -trinnene trestang, transpilering og buntanalyse.

- Test: Enhet, integrasjon og kontraktstester kjøres i isolerte jobber med artefaktopplasting (f.eks. Dekningsrapporter, testlogger). Mislykkede jobber er kommentert inline i PRS for rask triage.

- Sikkerhetsskanning: Sast (f.eks. Sonarqube, Snyk) og avhengighetsskanninger i avhengighet blir håndhevet før gjenstander fremmes. Hemmeligheter Skanneverktøy blokkerer utilsiktet eksponering.

- Bildesignering: Containerbilder er signert og lagret i et sikkert register (f.eks. AWS ECR, GCP Artifact Registry) med uforanderlige tagger og Metadata.

- Iscenesettelse av distribusjon: Merkede bygg blir automatisk distribuert til en iscenesettelsesklynge. Kanariprøver, røykprøver og syntetiske helsekontroller kjøres mot dette miljøet med korte TTL -er.

- Produksjonsfremmelse: Distribusjoner til PROD utløses enten manuelt (med godkjenningsporter) eller automatisk etter passering av QA -forhold. Gitops -verktøy (f.eks. Argocd, Flux) bruker manifester fra en versjonert statsrepo.

2. Infrastruktur som kode (IAC)

- Terraform: All infrastruktur – VPC -er, K8S -klynger, DB -forekomster, IAM -roller, køer – administreres via Terraform -moduler. Endringer blir gjennomgått og forhåndsvisning ved hjelp av

TerraformplanI PRS. Driftdeteksjon kjører nattlig for å oppdage manuelle endringer. - Tilpass og hjelmer: K8s -manifester blir maltet via roret og administreres på tvers av miljøer ved bruk av Kustomize -overlegg. Dette gjør det enkelt å overstyre kopier, konfigurasjoner og hemmeligheter per miljø.

- Hemmeligheter Ledelse: Hemmeligheter og konfigurasjonskart blir injisert via forseglede hemmeligheter (f.eks. Mozilla SOP, Bitnami forseglede hemmeligheter) eller synkronisert fra hvelv ved hjelp av sidevogninjektorer. Alle hemmeligheter roteres og revideres regelmessig.

3. Distribusjonsstrategi

- Blågrønne distribusjoner: For kritiske banetjenester som autoritet eller aktivitet brukes blågrønne strategier. Trafikken forskyves gradvis ved å bruke inntrengningsregler, med automatisert tilbakeføring hvis helsekontroller mislykkes.

- Kanariutgivelser: Ikke-kritiske tjenester (f.eks. Varsler, toppliste) bruker kanari-utrullinger-som distribuerer til 5%, deretter 25%, deretter 100%over tid. Metrikk (latens, feilhastighet, CPU) blir sammenlignet med baselinjene før de fortsetter.

- Funksjonsflagg: Alle nye kodeveier er beskyttet av funksjoner. Dette muliggjør progressiv eksponering, mørke lanseringer og øyeblikkelig drepe brytere under hendelser.

4. Artifact & Environment Hygiene

- Bildelivssyklus: Gamle bygninger beskjæres automatisk basert på alders- eller SHA -oppbevaringspolitikk. Ubrukte bilder holdes aldri utover 30 dager med mindre de er merket som LTS- eller Rollback -versjoner.

- Forhåndsvisningsmiljøer: Efemerale iscenesettelsesmiljøer opprettes per PR ved hjelp av dynamiske navneområder i Kubernetes. Disse miljøene etterligner produksjonstopologier og blir ødelagt etter sammenslåing eller PR -nær.

- Rollback -mekanisme: Hver distribusjon er atomisk og versjon pinnet. Rollbacks kan utløses via Git Revert, Helm History Rollback eller Argocd UI Click – i løpet av sekunder.

Trenger du hjelp til å sende raskere uten å bryte ting?

Vil du bygge en rørledning med høy hastighet med skuddsikre tilbakeslag, Gitops arbeidsflyter og produksjonsklasse CI/CD?

Enten du skalerer en mikroservices backend eller lanserer en ny mobilfunksjon, la oss arkivere et DevOps -system som fungerer under press.

Overvåking og observerbarhet

1. Logging

- Strukturert logging: Hver tjenestelogger i JSON -format ved hjelp av strukturerte felt som `request_id`,` user_id`, `aktivitet_id` og` varighet_ms`. Logger streames via flytende bit eller filbeat til en sentral rørledning (f.eks. Elasticsearch, Loki) for indeksert spørring og analyse.

- Korrelasjons -ID -er: Hver forespørsel genererer en unik korrelasjons -ID som forplanter seg på tvers av servicegrenser via overskrifter og loggkontekst. Dette muliggjør full sporbarhet fra ende-til-ende fra mobilapp til backend-køer til DB.

- Logghygiene: PII -maskeringsregler håndheves på loggrørledningsnivå. Hemmeligheter, tilgangstokener, GPS -koordinater og rå telemetri blir ekskludert eller redusert automatisk før logger treffer lagring.

2. Metriker

- Systemmålinger: CPU, minne, disk og nettverksbruk eksporteres fra hver node og pod via Prometheus eksportører. Varslingsgrenser er satt for metning, ressurspress og uvanlig pod churn.

- Forretningsmålinger:

- Aktiviteter per minutt, fôrhendelser per sekund

- Challenge -sammenføyninger, skriver toppboard, segmentkamper

- Latens per endepunkt, 99. persentilfeilrater

- Tilpasset instrumentering: Tjenester bruker Prometheus klientbiblioteker for å eksportere tellere, histogrammer og måler for tilpasset logikk – for eksempel “merketevalueringer behandlet” eller “GPS -poeng per opplasting.”

3. Distribuert sporing

- Sporingssystem: OpenTelemetry brukes til instrumenttjenester med spenn for HTTP/GRPC -anrop, DB -spørsmål og håndtering av async kø. Spor blir eksportert til backends som Jaeger, Honeycomb eller Tempo.

- Spor prøvetaking: Hovedbasert prøvetaking (med justerbare priser) sikrer at transaksjoner med høy verdi som aktivitetsinntak eller fôrvifte alltid blir fanget, mens bakgrunnsjobber med lav prioritet er prøvetatt probabilistisk.

- Sporkobling: Alle spor binder tilbake til bruker -ID -er og ber om metadata, noe som muliggjør feilsøking av individuelle aktivitetsinnleveringer, topplistefeil eller langsomme fôrgenereringsgenerering med eksakte kausalitetskjeder.

4. Varsling og dashbord

- Varslingsledelse: Prometheus AlertManager eller Opsgenie håndterer deduplisering, stillhetsvinduer, rotasjoner på samtalen og opptrappingspolitikk. Varsler inkluderer Slack/Teams Hooks, SMS og PagerDuty når kritiske terskler krysses.

- Dashboards: Grafana dashboards er forhåndsbygd per service med boredre-muligheter for latens, feilrater, DB-gjennomstrømning, kø-etterslep og eksterne API-feil. Forretningsinteressenter får også KPI -visninger (f.eks. Aktive brukere, utfordringsrater).

- SLOS & Feilbudsjetter: Viktige endepunkter (f.eks. Aktivitetsinnlevering, fôrbelastning, utfordring med sammenføyning) er knyttet til formelle SLO -er med latens/feilgrenser. Forbrenningshastigheter beregnes for å informere Feature Flag Gating og Rollout Pacing.

5. Helsekontroller og beredskapsprober

- Livlighet og beredskap: Alle tjenester utsetter `/Healthz` -endepunkter for grunnleggende livlighet (f.eks. Trådbassengstatus, minne) og beredskap (f.eks. DB -tilkobling, køelag). Kubernetes bruker disse for autoskalering og distribusjonsorkestrering.

- Dype sjekker: Periodiske bakgrunnsoppgaver utfører syntetiske transaksjoner (f.eks. Testaktivitetsinnsats + fôrlesing) for å validere forretningslogikkhelse – ikke bare systemoppetid.

Avveininger og designbeslutninger

1. Hva denne arkitekturen får rett

- Avgjørelse: En hybridmodell ble valgt. For gjennomsnittlige brukere bruker systemet fan-out-on-write for å forhåndspopulere fôr. For brukere med høye fanout (f.eks. Influencers) bytter den til fan-out-on-Read.

- Hvorfor: Preconputing Feed Entries minimerer latens og avlaster lesestien, men det er dyrt når en bruker har tusenvis av følgere. Hybriddesignet optimaliserer for 95% saken mens du beskytter infrastruktur mot fan-out-stormer.

- Avveining: Mer operativ kompleksitet. Systemet må dynamisk rute skriver/leser gjennom forskjellige kodebaner basert på brukernivå eller følger. Øker også testoverflaten.

2. Polyglot utholdenhet

- Avgjørelse: PostgreSql, Redis, Kafka og S3 ble valgt som kjernebunken. Valgfri bruk av Neo4j for sosial graftraversal ble utsatt.

- Hvorfor: Disse verktøyene stemmer godt overens med tilgangsmønstrene: PostgreSQL for integritet, Redis for tilgang med lav latens, Kafka for begivenhetsdrevet skala og S3 for Blob Storage. Unngå en spesialisert graf DB forenklet OPS og Onboarding.

- Avveining: Noen grafforespørsler (f.eks. “Mutuelle følgere i en klubb”) er mindre effektive uten en dedikert grafmotor. Redis-basert hurtigbufring demper dette, men tilfører cache-koherenskompleksitet.

3. sanntid GPS-synkronisering mot opplasting etter trening

- Avgjørelse: Opplasting etter trening er standard; Synkronisering i sanntid er valgfritt og opt-in (f.eks. For live sporing eller virtuelle løp).

- Hvorfor: GPS-streaming i sanntid skaper konstant backend-belastning, introduserer konsistensutfordringer for delvise aktiviteter og øker strømavløpet på mobile enheter. For de fleste brukere er batchopplasting tilstrekkelig.

- Avveining: Redusert evne til å kraftfunksjoner som live cheering, pacer-matching eller pågående topplisteoppdateringer. Fremtidige versjoner kan utvide sanntidsstøtte bak funksjonsflagg.

4. Mikroservices vs. Monolith

- Avgjørelse: Mikroservices ble valgt tidlig, med klare domenegrenser: aktivitet, fôr, bruker, utfordring, media osv.

- Hvorfor: Muliggjør uavhengig skalering, parallell utvikling og domenespesifikt eierskap. Inntak av fôr og aktivitet har veldig forskjellige ytelsesprofiler – å skille dem tillater målrettet optimalisering.

- Avveining: Krever robust verktøy: tjenesteoppdagelse, sporing, CI/CD -isolasjon og plattformteknisk modenhet. For små lag tilfører dette forhåndskompleksitet, men langvarig smidighet oppveier kortsiktige smerter.

5. Hendelsesdrevet kontra synkrone arbeidsflyter

- Avgjørelse: Alle ikke-kritiske stier (Feed Fan-Out, Leaderboard-oppdateringer, varsler) er async via Kafka/Nats. Bare spørsmål om autoritekt og brukervendte bruker forespørsel/responsstrømmer.

- Hvorfor: Async Systems skala bedre og koblingsflyte arbeidsflyter. De tillater også prioritering av batching og kø-essensielt for variable inntaksmønstre som tredjepartssynkroniseringer eller utfordrer pigger.

- Avveining: Eventuell konsistens og feilsøkingskompleksitet. Krever DLQ-er (køer med død bokstav), events repriser og nøye deduplikasjonslogikk. Overvåking og observerbarhet er nøkkelen til sikkerhet her.

Arkitektonisk gjeld og avbøtninger

- Noen eldre fôrstier antar fortsatt at synkrone skriver-blir refactored til Kafka-baserte fan-out-tjenester.

- Den første utfordringsmotoren hadde hardkodede regler – erstattet med en regelmotor for fleksibilitet.

- Tillatelseslogikk spredt på tvers av tjenester – å bli sentralisert til en tilgangspolitisk tjeneste for å håndheve konsistens.

Viktige takeaways og områder for å forbedre

1. Hva denne arkitekturen blir riktig

- Skalerbarhet etter design: Statsløse tjenester, hendelsesdrevet prosessering og sharded-databaser holder systemet responsive selv hos millioner av brukere og høye inntaksgrad.

- Modulære grenser: Klar skille mellom aktivitet, sosiale, medier og analyselogikk tillater fokusert optimalisering og sikker, parallell utvikling.

- Async først: Avkobling av fôrgenerering, utfordringscoring og varsler fra kjernen inntaksti gir ytelse og feilisolasjon der den betyr noe.

- Sikkerhet og personvern: Finkornede tilgangskontroller, kryptert lagring og streng observerbarhetspraksis stemmer overens med dataansvaret på GDPR-nivå.

- Utviklerhastighet: CI/CD -rørledninger, funksjonsflagg og kontraktstester støtter rask, sikker iterasjon – uten at det går ut over produksjonsstabiliteten.

2. Muligheter for forbedring

- Dynamiske grafspørsmål: Omvurderer bruken av Redis vs. spesialbygde graf DBS (f.eks. DGraph, Nebula) for gjensidig følgedeteksjon eller avanserte klubbfunksjoner.

- Samlet tilgangskontroll: Å sentralisere alle tillatelseskontroller til en policy -tjeneste (OPA eller Custom) for å unngå duplisering og drive på tvers av tjenester.

- Live funksjoner: Utvidelse av sanntidsegenskaper (f.eks. Live segmenter, pacers, gruppeløp) med pålitelige streamingprotokoller og kontrollert utrulling.

- Mobil offline synkronisering: Forbedre offline-første UX for brukere i landlige områder eller under lange friluftsaktiviteter med bedre konfliktløsningsstrategier.

- Advanced Analytics: Bygg dedikerte rørledninger av idrettsutøvere (f.eks. VO2 MAX-estimering, treningsbelastning) ved bruk av pre-aggregerte dataløter og ML-modeller.

Denne plattformdesignet balanserer ytelse, fleksibilitet og brukeropplevelse i en krevende sosial + kondisjonskontekst. Det er produksjonsklar, kamptestet og bygget for vekst-men med rom for å utvikle seg til et mer intelligent, sanntids og personalisert treningsøkosystem.

Bygge noe så ambisiøst?

Å designe skalerbare, sikre og sosialt engasjerende plattformer handler ikke bare om å velge riktig stabel – det handler om å ta de riktige beslutningene til rett tid.

Enten du lanserer en treningsapp, forbedrer brukerengasjement eller moderniserer backenden din, er vi klare til å hjelpe deg med å arkivere den med selvtillit.

Folk spør også (vanlige spørsmål)

Hvordan utvikle en Fitness Tracker -app?

Begynn med å definere kjernefunksjonene: GPS -aktivitetssporing, inntak av helsedata (hjertefrekvens, trinn), brukerprofiler og logging offline. Derfra kan du designe en mobil-første opplevelse ved hjelp av React Native eller Swift/Kotlin, implementere sikker brukerautentisering (OAuth2) og koble til en backend som kan innta, behandle og analysere sensordata i sanntid. Sky-innfødte infrastruktur, skalerbare datalagre og hendelsesdrevet behandling vil være nøkkelen til å holde ytelse og respons stram.

Hvor mye koster det å bygge en treningsapp?

Det avhenger av omfang, men en produksjon av produksjonsklasse med GPS-sporing, bruker authent, sanntidssynkronisering, skylagring og sosiale funksjoner vil vanligvis koste mellom $ 50K til $ 500K+ å bygge og lansere. Det inkluderer UI/UX, mobilutvikling, backend -arkitektur, DevOps og QA. Kostnader skala basert på kompleksitet – live sporing, sosiale grafer, integrasjoner og analyser øker teknisk innsats.

Hvordan lage en Strava -app?

For å bygge en Strava-lignende app, trenger du en mobilklient for GPS-basert aktivitetsopptak, en backend for lagring og analyse av brukertrening og et sosialt graflag for feeds, følger og interaksjoner. Kjernekomponenter inkluderer en sanntidsplasseringsrørledning, en skalerbar fôrtjeneste og en hendelsesdrevet motor for utfordringer og toppliste. Arkitekturering for skalerbarhet, lav latens og modulære servicegrenser er essensielt.

Hvor mye koster det å bygge en app som Strava?

En fullverdig Strava-stil plattform kan lett overstige $ 500K til $ 1M+ I utviklingskostnader, avhengig av funksjonssett, teamstruktur og tid til markedet. Kostnadene inkluderer utvikling av mobil og backend, skyinfrastruktur, ytelsesoptimalisering og støtte for ting som medier opplastinger, personverninnstillinger og integrasjoner av tredjeparts enheter.

Hvilken database bruker Strava?

Strava har ikke offentlig detaljert sin fulle stabel, men basert på mønstre som er felles for systemer i lignende skala, bruker de sannsynligvis en blanding av relasjonsdatabaser (f.eks. PostgreSQL), distribuerte datalagre for telemetri (f.eks. Cassandra eller tidsserie) og redis-like-systemer for caching. Deres arkitektur er hendelsesdrevet og mikroservicebasert, med skyinfrastruktur som håndterer millioner av aktiviteter per dag.

Hvorfor er Strava så populær?

Strava spikret blandingen av kondisjonssporing og sosialt engasjement. Det handler ikke bare om å spille inn løp – det handler om å dele dem, konkurrere om segmenter, tjene merker og engasjere seg i et samfunn. Funksjonene for sosiale fôr, gamification og utfordrer økosystemet gjør plattformen klissete og vanedannende, som driver både oppbevaring og viralitet.

Er en treningsapp lønnsomt?

Ja – hvis det er utført godt. Abonnementsbaserte treningsapper (som Strava Premium, MyFitnessPal, etc.) har vist seg å være svært lønnsom. Inntektene kan komme fra premiumanalyse, coachingverktøy, merkeutfordringer eller girmarked. Men lønnsomheten krever en sterk retensjonsstrategi, infrastruktur effektivitet og brukervekst utover MVP.

Hvordan tjener jeg opp på treningsappen min?

Vanlige inntektsgenereringsstrategier inkluderer: Freemium-abonnement (f.eks. Lås opp dypere analyse eller coaching), kjøp i appen (f.eks. Opplæringsplaner), merkevarepartnerskap (f.eks. Sponsede utfordringer) og tilknyttede markedsplasser (f.eks. Sko, Wearables). Annonser er mulige, men forringer ofte brukeropplevelsen. Fokuser på brukertillit og langsiktig verdi når du utformer inntektsveier.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.