Fitness-spårningsappar har utvecklats långt utöver enkla stegräknare eller GPS-baserade aktivitetsloggar. Dagens användare förväntar sig rik social interaktivitet, konkurrenskraftig gamification, realtidssynkronisering och sömlös integration med ett växande ekosystem av bärbara och hälsoplattformar. Strava satte ett riktmärke i detta utrymme genom att smälta idrottsaktivitetsspårning med socialt engagemang – topplistor, utmaningar, kommentarer, klubbar och till och med virtuella raser – alla inslagna i en slick UX som prioriterar både prestanda och samhälle.

Att utforma ett system som detta går långt utöver grundläggande CRUD -operationer på användarträning. Det kräver en robust arkitektur som kan hantera:

- Högfrekventa geo-platsuppdateringar från miljoner samtidiga användare

- Realtidsfodergenerering och aktivitetssändning till följare nätverk

- Skalbara, låg-latens sociala graffrågor

- Medielagring och hämtning (t.ex. ruttkartor, foton, märken)

- Händelsedrivna datarörledningar för datorsegment, topplistor och utmaningar

- Säkerhets- och integritetskontroller över komplexa inställningar för datadelning

Utmaningen är att arkitekten en backend som stöder en snabb, engagerande och socialt rik upplevelse, samtidigt som den förblir tillräckligt flexibel för att integrera med tredjeparts fitnessenheter, stödja måttlighet och utveckla nya funktioner utan att bryta gamla. Detta tekniska djupa dyk bryter ner arkitekturen för ett sådant system. Den beskriver kärnkraven, mönster för skalbarhet och realtidens lyhördhet, datamodeller för användargenererat innehåll och infrastrukturmönster för att stödja en social fitnessplattform som kan växa till miljoner användare utan att förnedra prestanda eller tillförlitlighet.

Systemkrav

1. Funktionella krav

Fitness -appens kärnfunktioner måste stödja både aktivitetsspårning och socialt engagemang i skala. Viktiga funktionskrav inkluderar:

- Användarhantering: Registrering, autentisering, profilredigering och återhämtning av konto.

- Aktivitetsinspelning: Log GPS-baserade träningspass (t.ex. körningar, åkattraktioner), stöd manuell inträde och fånga metadata som avstånd, takt, höjd, hjärtfrekvens och redskap som används.

- Datasynkronisering i realtid: Strömplats och sensordata från mobila eller bärbara enheter med låg latens.

- Social graf: Följ/avföljande mekanismer, vänförslag och sekretesskontrollerad aktivitetssynlighet (t.ex. privata, endast följare, offentliga).

- Aktivitetsflöde: Dynamisk tidslinje som visar träning från följde användare, inklusive likes, kommentarer och omslag.

- Utmaningar och topplistor: Skapa tidsboxade tävlingar (t.ex. “Rida 100 km på 7 dagar”), spåravtalslistor och beräkna ranking asynkront.

- Media Support: Ladda upp och visa foton, vägvärmekartor och personliga prestationer (t.ex. märken, milstolpar).

- Meddelanden: I realtidspush- och i-app-meddelanden för likes, kommentarer, nya följare och utmaning av uppdateringar.

- Tredje partintegration: Synkronisera med Apple Health, Google Fit, Garmin och andra fitnessekosystem.

2. Icke-funktionella krav

För att stödja interaktion i realtid och växande användarbaser måste systemet uppfylla stränga icke-funktionella krav:

- Skalbarhet: Horisontellt skalbara tjänster och datalager för att hantera miljoner aktiva användare och terabyte geo-temporala data.

- Låg latens: Responstid under sekund för sociala interaktioner och realtidskartavendering.

- Tillgänglighet: 99,9%+ drifttid med feltolerans över regioner och zoner.

- Säkerhet och integritet: OAUTH2-baserad autentisering, granulär åtkomstkontroll, krypterad lagring och användarkontrollerade delningsinställningar.

- Sträckbarhet: Modulära servicgränser för att stödja framtida funktioner som virtuella lopp, klubbbaserade chattar eller livecoaching.

- Datakonsistens: Eventuell konsistens är acceptabelt i flöden och topplistor, men stark konsistens krävs för transaktioner som kontoinställningar eller premiumköp.

- Offline -stöd: Låt användare spela in och köer aktiviteter när de är offline, med automatisk synkronisering vid återanslutning.

3. Begränsningar och antaganden

- Mobilappar (iOS och Android) kommer att vara de primära klienterna; Webbgränssnittet är sekundärt.

- Plats- och hälsodata måste behandlas enligt regionala efterlevnadsregler (t.ex. GDPR, HIPAA där det är tillämpligt).

- Majoriteten av användarna kommer att synkronisera 1–2 aktiviteter per dag, men kraftanvändare och integrationer kan öka intagfrekvensen under evenemang eller utmaningsperioder.

- Moln-infödd distribution; Arkitekturen antar användning av hanterade molntjänster för beräkning, lagring och strömning.

Använd ärende / scenario

1. Företagskontext

Fitness -appen riktar sig till en bred demografisk – från avslappnade vandrare till konkurrenskraftiga cyklister – men betonar samhällsengagemang över individuell spårning. Tänk på det som en hybrid mellan en personlig tränare och ett socialt nätverk. Målet är att driva återkommande användning genom konkurrens, socialt ansvar och spelad framsteg, vilket i slutändan ökar behållnings- och prenumerationskonverteringen.

Intonisering i appen kan inkludera:

- Premiumabonnemang för avancerad analys, levande segment och djupare träningsinsikter

- Märkesutmaningar eller sponsrade tävlingar

- In-App Gear-marknadsföring (t.ex. affiliate Marketplace för skor, cyklar, wearables)

Appen måste därför möjliggöra en robust grund för mätvärden i realtid och samtidigt leverera engagerande, socialt dynamiska upplevelser som användare återvänder till dagligen-även om de inte tränar den dagen.

2. Personas och användningsmönster

- Solo -idrottare: Användare som spårar sina träningspass, jämför tidigare prestanda och ibland går med i globala utmaningar eller segment.

- Sociala entusiaster: Mycket engagerade användare som ofta publicerar, kommenterar vännernas aktiviteter och trivs med samhällsinteraktion.

- Klubbchefer: Kraftanvändare som samordnar gruppevenemang, hanterar privata topplistor och måttliga sociala utrymmen inom klubbar.

- Data nördar: Premiumprenumeranter som är intresserade av hjärtfrekvenszoner, kraftkurvor, återhämtningsmetriker och dataexport.

3. Förväntad skala

Systemet ska vara utformat för att stödja:

- 10m+ registrerade användare

- 2–3m MAUS (månatliga aktiva användare), med ~ 500k daus (dagliga aktiva användare)

- 10m+ aktivitetsuppladdningar per månad, med toppar under helger och stora utmaningsevenemang

- 500k+ samtidiga användare under toppperioder

- Miljarder datapunkter per månad över GPS, höjd, hjärtfrekvens och rörelsessensorer

- Miljontals dagliga foderfrågor, sociala interaktioner och aviseringar i realtid

För att uppfylla dessa krav måste arkitekturen optimera för lästunga sociala arbetsbelastningar, sprängt trafik från aktivitetsuppladdningar och asynkron bearbetning med hög kapacitet för segmentmatchning och toppuppdateringar.

Behöver du hjälp med att utforma din egen fitness eller sociala app?

Att bygga en social-första fitnessplattform som skalar till miljoner användare tar mer än ren kod-det tar rätt arkitektur från första dagen.

Vill du ha expertvägledning om design för prestanda, realtidssynkronisering och användarengagemang i skala?

Arkitektur på hög nivå

Arkitekturen måste effektivt stödja intag i realtid, intag av socialt foder, geospatial analys och användarinteraktion-allt i skala. Detta kräver ett modulärt, serviceorienterat tillvägagångssätt med väldefinierade gränser mellan kärnsystem som aktivitetsspårning, användarhantering, social grafbehandling och leverans av anmälan.

1. Komponentöversikt

Systemet är strukturerat kring följande huvudkomponenter:

- API Gateway: Central inträdesplats för all klientkommunikation. Hanterar autentisering, räntebegränsning och rutter trafik till interna tjänster.

- Auth Service: Hanterar OAUTH2-flöden, token emission, sessionhantering och integration med tredjeparts identitetsleverantörer (t.ex. Apple, Google).

- Användarprofiltjänst: Lagrar personlig information, preferenser, redskap och sekretessinställningar.

- Aktivitetstjänst: Hanterar GPS-baserat träning av träning, ruttning av rutt, aktivitetsvalidering och metadata-extraktion (t.ex. tempo, höjdförstärkning).

- FEED SERVICE: Genererar och lagrar aktivitetsflöden, bearbetar uppdateringar av sociala grafer och hanterar fläkt för nya aktiviteter.

- Social grafservice: Hanterar följareförhållanden och beräknar synlighet för aktiviteter och utmaningar.

- Utmaning & Leaderboard Engine: Beräknar ranking, hanterar utmaningslogik och uppdaterar virtuella troféer och segment.

- Medietjänst: Hanterar bilduppladdningar (foton, ruttkartor), CDN -cachning och åtkomstkontroll.

- Noteringstjänst: Publicerar realtids- och satsmeddelanden via WebSockets, FCM/APNS eller In-App-inkorgar.

- Analytics Rörledning: Processer aktivitetsströmmar för insikter, trenddetektering och idrottsman rekommendationer.

- Admin- och modereringsportal: Verktyg för att hantera övergreppsrapporter, utmaning och analyspaneler.

2. Arkitekturdiagram på hög nivå

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Sammanfattning av dataflödet

När en användare startar ett träningspass:

- Mobilappen strömmar GPS- och sensordata via en WebSocket eller satsad API -uppladdning till Aktivitetstjänst.

- Tjänsten analyserar uppgifterna, lagrar träningen och avger en händelse till Fodergenerator.

- De Social graftjänst bestämmer vem som kan se aktiviteten.

- Foderobjektet lagras och drivs till relevanta användare via Anmälningstjänst.

- Om tillämpligt utvärderas aktiviteten av Toppmotor För utmaning av utmaningar och rankinguppdateringar.

- Foton och ruttvisualiseringar skickas till Medietjänst och cachade genom en CDN.

Denna modulära design stöder både horisontell skala och isolerad serviceutveckling. Det möjliggör också fans i realtid för flöden och aviseringar med hjälp av händelsedriven kommunikation (t.ex. Kafka eller Nats).

Databasdesign

1. Kärndatamodeller och ERD -översikt

Systemet använder en polyglotpersistens-strategi-relationella databaser för transaktionell integritet, tidsserie/NoSQL för aktivitetsdata och graf eller i minnet för högpresterande sociala frågor.

Primära enheter:

- Användare: Profilinfo, autoriserade inställningar, preferenser, prenumerationsnivå

- Aktivitet: Träningsdata inklusive GPS -poäng, mätvärden, redskap, media

- Följa: Följare av efterföljande förhållande och synlighetsregler

- Feeditem: Evenemang för återgivningsbara bundna till användare (t.ex. publicerad aktivitet, kommentar, märke)

- Utmaning: Metadata och tillstånd för grupptävlingar

- Ledareentry: Utmaning eller segmentposition och mätvärden

Enhetsförhållanden diagram (konceptuell):

[Användare]

├── id (PK)

├── namn, e-post, avatar_url

└── settings_json

[Aktivitet]

├── id (PK)

├── användar-id (FK → Användare)

├── typ, start_tid, varaktighet

├── avstånd, höjd, avg_hr

├── geo_data_ref (FK → GeoStore)

└── synlighet (offentlig / följare / privat)

[GeoStore] (externt lagringsindex eller S3 ref)

├── id (PK)

├── aktivitets-id (FK → Aktivitet)

└── gps_data (array eller filpekare)

[Följa]

├── follower_id (FK → Användare)

├── followee_id (FK → Användare)

└── skapad_at

[FeedItem]

├── id (PK)

├── actor_id (FK → Användare)

├── verb ("postat", "kommenterade", "gillade")

├── objekt-id (t.ex. aktivitets-id, kommentars-id)

└── target_user_id (FK → Användare)

[Utmaning]

├── id (PK)

├── namn, beskrivning, typ

├── startdatum, slutdatum

└── synlighet, regel_json

[LeaderboardEntry]

├── id (PK)

├── challenge_id (FK → Challenge)

├── användar-id (FK → Användare)

├── metriskt_värde (avstånd, varaktighet)

└── rang

2. Val av databasteknik

Varje datadomän är optimerad för sitt eget åtkomstmönster:

- PostgreSQL: Kanonisk datakälla för användarprofiler, aktiviteter, matningsmetadata och utmaningar. Utmärkt för transaktionsintegritet och utländsk nyckelhantering.

- TIDSCALEDB / INFUXDB: För GPS-intag, aktivitetstelemetri och tidsserieanalys (t.ex. takt över tid, HR-zoner).

- S3 + CD: Används för att lagra råa GPS-spår, ruttbilder och laddade media (med säker för-undertecknad URL-åtkomst).

- Redis / memcached: För snabb återhämtning av topplistor, senaste aktiviteter och förskrivna foderdata.

- NEO4J eller DGRAPH (valfritt): För komplex sociala grafövergångar, klubbmedlemskap och ömsesidiga följareförslag i skala.

3. Multi-Tenancy & Partitioning Strategy

- Skärm: Aktiviteter och foderobjekt skärs av användar -ID eller region -ID för att möjliggöra horisontell skalning över partitioner.

- Tidsbaserad partitionering: GPS -telemetri och topplistor delas upp i månatliga/veckovisa partitioner för åldrande och prestanda.

- Mjuk multi-hyresgäst: Klubbar eller organisationer (t.ex. löpande grupper, cykelteam) fungerar inom det globala namnområdet men kan få scopedfrågor (via Tenant_id) vid behov.

4. Replikering och hög tillgänglighet

- PostgreSQL: Distribueras med heta standby -repliker och WAL -frakt för failover.

- Redis: Konfigurerad med Sentinel för hög tillgänglighet och automatiserat masterval.

- Media & Geostore: Objektlagring replikeras över regioner och levereras genom en global CDN för låg latensåtkomst.

Denna databasdesign säkerställer flexibel schemautveckling, snabb aktivitet intag och skalbart stöd för sociala arbetsbelastningar och analyser – samtidigt som man bevarar referensintegritet där det är viktigast.

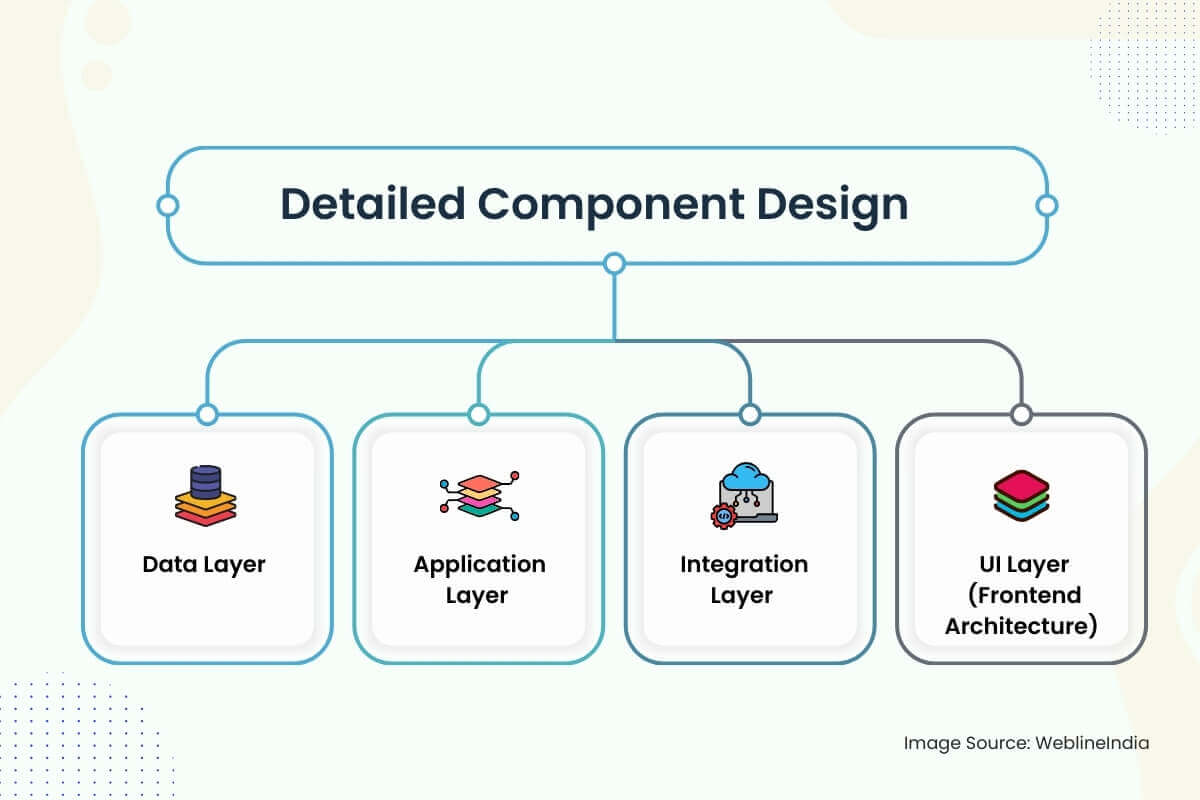

Detaljerad komponentdesign

1. Dataklager

- Schemastrategi: Scheman är utformade kring tydliga domängränser: användare, aktiviteter, flöden, sociala grafer och utmaningar. Kolumner som `Synlighet ‘,` Status’ och `Aktivitet_typ ‘använder uppräknade typer för indexeringseffektivitet. Uuider föredras framför autoinkrementade heltal för att undvika heta nyckelproblem i distribuerade butiker.

- Datatillgång: Tillgång till kärndata går igenom tunna serviceskiktsförvar som upprätthåller policyer för åtkomstkontroll (t.ex. synlighetskontroller av aktiviteter). Läsoperationer är optimerade via materialiserade vyer och fördrivna foder-ögonblicksbilder. Skrivtunga vägar som aktivitetsintag använder skriv-framkö och bulkinsatsrörledningar för att smidiga intagspikar.

- Godkännande: Ingångsvalidering sker på flera nivåer-EDGE SCHEMA-verkställighet via OpenAPI eller GraphQL, djup validering i servicelager (t.ex. giltiga GPS-punkter, icke-överlappande tidsstämplar) och asynkrona sanitetskontroller av telemetri-data via bakgrundsjobb.

2. Applikationslager

Servicedesign: Varje större domän (användare, aktivitet, foder, anmälan, social graf) implementeras som en isolerad mikroservice. Tjänsterna exponerar både GRPC och REST-slutpunkter-vila för offentliga API: er, GRPC för kommunikation mellan tjänster. Rengör arkitekturprinciper separerar domänlogik från transport- och infrastrukturkod.

Ramar:

- Gå eller rost för prestationskritiska tjänster (aktivitet, foder, topplista)

- Node.js eller python för limkod, integrationer och async arbetsflöden

- GraphQL Server (Apollo eller Hasura) för front-end aggregering och deklarativ fråga

Autentisering: JWT -tokens utfärdas via OAUTH2 -flöden. Service-till-service-samtal använder signerade interna symboler med rollbaserade räckvidd.

Betygsbegränsande & kvoter: Implementerad via Redis-Backed Token-hinkar vid gateway och användarnivå granularitet (särskilt för aktivitetsuppladdningar).

3. Integrationslager

Meddelande svansar: KAFKA eller NATS används för async-arbetsflöden-aktivitetsbehandling, utfodring, segmentmatchning och publiceringspublicering. Idempotenta hanterare med starka leveransgarantier används för att förhindra duplicerade inlägg eller topplista.

Synkronisering av tredje part: OAuth -integrationer med Garmin, Fitbit, Apple Health, etc., körs via en bakgrundspoller + webhook combo. Nya data står i kö och bearbetas via Aktivitetsintagets rörledning.

Händelsetyper:

aktivitet. skapad→ Fan-out to Feed Service, meddela följareutmaning.Joined→ Kontrollera behörighet, Trigger Leaderboard Insertuser.folled→ Uppdatera graf, uppdatera flöde, enhet välkommen meddelande

4. UI Layer (Frontend Architecture)

Appstack: React Native för mobilappar över plattformar, med TypeScript och Redux Toolkit för statlig hantering. Webapp använder Next.js för SSR/ISR med svängningsverktygsstyling och GraphQL -frågor för att backa.

Säkerhetsproblem:

- Klienthemligheter är aldrig inbäddade – oauth pkce flöde är obligatoriskt

- Alla API-samtal kräver signerade tokens, och offentliga slutpunkter filtreras efter hastighet, ursprung och roll

- Geo -data är sandlådad per synlighetsinställning – Privata aktiviteter utesluts från värmekartor, foder och segmentberäkningar

Funktioner i realtid: WebSockets eller SSE används för att trycka på aviseringar, utmaningsstatus och matningsuppdateringar. Fallback till lång polling på begränsade nätverk. Frontend upprätthåller en lokal SQLite -cache för offlineaktivitetsloggning.

Arkitekterar något liknande?

Att utforma realtid, geo-medvetna, socialt interaktiva plattformar tar precision över dataflöde, händelseshantering och mobil arkitektur.

Om du bygger något ambitiöst-som en social fitnessplattform, bärbar integration eller flöde i realtid-skulle vi gärna hjälpa dig att få det från början.

Skalbarhetsöverväganden

1. Skalning av applikationslager

- STATLESS TJÄNSTER: Alla kärntjänster (aktivitet, foder, utmaning etc.) är statslösa och horisontellt skalbara. Varje instans är engångsbruk och fronted av en lastbalanserare. Delade-ingenting-principer säkerställer att fall inte förlitar sig på lokal stat.

- Auto-skalning: K8S-baserade horisontella POD-autoscaling (HPA) används för tjänster baserade på CPU, minne och könsdjupmätningar. För latenskänsliga tjänster (som foder eller anmälan) kan anpassade mätvärden (t.ex. evenemangsfördröjning) utlösa snabbare skalor.

- API Gateway Thravling: Kund- och IP-baserade räntebegränsningar förhindrar API-översvämningar. Burst-tolerans stöds med hjälp av Redis-Backed skjutfönster eller läckande hinkalgoritmer.

2. Skalning av datalagret

Läs optimering: Ofta åtkomst till data (t.ex. senaste aktiviteter, toppbilder för topplistan) cachas aggressivt i Redis med TTL och LRU -utkast. PostgreSQL -läsreplikationer skalas baserat på trafik för att lossa analyser och UI -frågor.

Skärmstrategier:

- Aktivitetsdata: Sharded av användar -ID över partitioner eller logiska kluster (t.ex. Activity_01, Activity_02, …)

- Mata föremål: Partitionerad av skådespelare -ID och mottagar -ID med sammansatta index för snabba uppslag

- Geostore: Använder S3-nyckelprefix av region och tidsstämpel för optimerad objektlista och kostnadseffektivt tiering

3. FEED och SOCIAL GRAFT FAN-OUT

Fodergenerering är en viktig skalbarhetsutmaning i sociala plattformar. Systemet använder en hybrid-fläkt-strategi:

- Fan-out-on-write (primär): När en användare publicerar en aktivitet, skjuter matningstjänsten den i förputerade matningsrader för följare.

- Fan-out-on-Read (fallback): För användare med hög fan (kändisar, påverkare) konstrueras flöden vid frågetid med pagination från Kafka-stödda händelseloggar eller foderindextabeller.

Foderlagring: Implementerad via skrivoptimerade tabeller eller kolumnfamiljebutiker (t.ex. Scylladb eller Cassandra-liknande butiker) med TTL för flyktiga händelser och förhandsgjorda JSON för snabb hydrering.

4. Utmaning och bearbetning av topplistan

- Batch Compute: Leaderboards beräknas i partier med hjälp av en strömbehandlingsmotor (t.ex. Apache Flink, Spark -strömning). Segmentmatchningar och utmaningsvalideringar går asynkront från aktivitetsinförsting med hjälp av hållbara kafka -ämnen.

- Fönstermässig aggregering: Utmaningsstatistik är fönster (dagligen, varje vecka) för att förhindra fullständiga historikskanningar och minska lagringstrycket. Aggregerade materialvyer indexeras per utmaning och segment.

5. Geo och sensordata intag

- Högfrekventa intag: GPS-punkter är skrivna i satser till tidsserie-butiker (eller S3-filer med indexering) och kontrolleras för att undvika överflöd av minnes. Batchning minskar skrivförstärkningen på DB och påskyndar hanteringen av backtryck.

- Kompression: GPS-koordinater är delta-kodade och gzippas före lagring. Rehydrering sker vid MAP-render eller exporttid, inte under realtidsfoderdisplayen.

6. Tredje trafikbrister

Spikar från Garmin- eller Apple-synkronisering absorberas med avkopplade förtäringsköer och hastighetsstyrda ETL-rörledningar. Varje integration har en brytare och försökspolicy för att förhindra uppströms missbruk eller stormar.

Säkerhetsarkitektur

1. Autentisering och auktorisation

- Autentisering: Alla klientinteraktioner använder OAuth 2.0 med PKCE för mobilflöden. JWTS utfärdas och undertecknas av Auth Service, som innehåller användar -ID, omfattning och utgång. Uppdatering av tokens roteras och krypteras i vila.

- Federated inloggning: Google, Apple och Facebook-inloggningar stöds, men alltid kopplade till en inbyggd användaridentitet. Tokens för sociala inloggningar är validerade serversidan, inte direkt pålitliga.

- Tillstånd: Varje tjänst validerar JWT-tokenet och upprätthåller regler för scopnivå (t.ex. `Läs: FEED ‘,` POST: AKTIVITET’). RBAC (rollbaserad åtkomstkontroll) används för interna verktyg (t.ex. administratör, moderatorroller).

2. Dataskydd

- I vila:

- PostgreSQL, Redis och Object Stores krypteras med AES-256-kryptering med kundhanterade nycklar (CMK).

- Känsliga fält (t.ex. e -post, hälsomätningar) är krypterade vid applikationslagret innan DB skriver.

- I transit: All trafik mellan service och klient-till-server skyddas av TLS 1.2+. Ömsesidig TLS används för GRPC -kommunikation mellan pålitliga backend -tjänster.

- Fältnivåmaskering: Känsliga fält är maskerade eller redigerade i stockar och instrumentpaneler. Observerbarhetsverktyget upprätthåller fältmärkning och automatiserad PII -skanning före intag.

- Geo integritet: Aktiviteter markerade som privata eller “endast följare” är helt uteslutna från flöden, topplistor och sökindex. Värmekartdata är anonymiserade och samplas endast från offentliga aktiviteter, med geo-o-ojämn nära hemzoner.

3. IAM Design & Secrets Management

- Hemligheter: Alla API -nycklar, DB -referenser och Webhook -tokens lagras i ett centraliserat valv (t.ex. Hashicorp Vault eller AWS Secrets Manager) och injiceras via miljö vid körning. Rotationspolicyer automatiseras för kortlivade referenser.

- IAM: Varje mikroservice har en unik identitet och uppsättning roller. IAM-policyer är scoped till de minimala behörigheter som krävs (t.ex. skrivskyddad åtkomst till objektlagring, skriv endast åtkomst till KAFKA-ämnen). CI/CD -agenter antar tillfälliga roller med OIDC Trust.

4. Säker kodning och API -skydd

- Inmatningsvalidering: All extern ingång är schemaliderad med OpenAPI eller JSON-schema. Frontend och backend upprätthåller längd, format och gränser.

- Betygsbegränsning: Per-användare och per-IP-hastighetsgränser verkställs via Redis eller API Gateway-plugins. Modeller för detektering av missbruk (t.ex. inloggningsstorm eller skräppost) matas in i dynamisk strypningspolicy.

- Uppspelningsskydd: Alla signerade förfrågningar inkluderar nonces eller tidsstämplar. Aktivitetsuppladdningar och webhooks använder HMAC -signaturer för att validera ursprung och förhindra manipulering.

- Kodsäkerhet: Statisk analys (SAST) och beroendeskanning är integrerade i CI -rörledningar. Secrets Detection (t.ex. Gitleaks) blockerar oavsiktlig exponering. Alla kritiska flöden går igenom peer-granskade och granskade dragförfrågningar.

Förlängbarhet och underhållbarhet

1. Modulära servicgränser

Varje större domän – användare, aktiviteter, foder, aviseringar, utmaningar – är inkapslade i sin egen tjänst, med sitt eget schema, API och distribuerbar runtime. Dessa tjänster kommunicerar asynkront genom meddelandeköer eller synkront via GRPC/REST, beroende på latenskänslighet.

Denna isolering möjliggör oberoende skalning, frisläppningscykler och onboarding av nya ingenjörer utan risk för säkerhetsskador på oberoende funktioner. Till exempel berör ett nytt toppformat eller anmälningsutlösare inte Aktivitetsintagens logik eller användarprofiler.

2. Pluginorienterade mönster

- Händelselyssnare: Nya funktioner (t.ex. prestationer, levande coachingvarningar eller enhetsbaserade märken) introduceras genom att prenumerera på kärnevenemang som aktivitet.skapad eller utmaning.slutförd. Detta möjliggör innovation utan att skriva om uppströmslogik.

- Funktionsflaggor: Alla användarvända funktioner styrs av dynamiska flaggor (t.ex. lansering av inledande eller interna växlingssystem), vilket möjliggör kanarieutrullningar, A/B-testning eller iscensatta utgåvor baserade på region, användarnivå eller plattform.

- Anpassad utmaningslogik: Utmaningsmotorn är utdragbar via regelmotorer eller inbäddade skript (t.ex. LUA eller CEL). Detta gör det möjligt för marknadsförings- eller klubbförvaltare att skapa nya typer av utmaningar (t.ex. “klättra på 2K meter på 3 dagar”) utan att hårdkodar logik i backend.

3. Ren kod och mönster

- Domändriven design (DDD): Tjänster använder DDD för att organisera logik efter begränsad sammanhang – aktivitetsaggregering, segmentpoäng, följarehantering – snarare än av tekniskt lager. Detta minskar tvärskärande logik och kodspridning.

- Testning och röster: CI verkställer strikt santning, kodtäckningströsklar och kontraktstester för alla API: er. Utvecklarhastigheten förblir hög eftersom lokala dev -inställningar använder behållare med utsäde databaser och håliga köer för snabb iteration.

- Monorepo vs PolyRepo: Backend är vanligtvis polyrepo (en per tjänst), medan mobilappen kan bo i ett monorepo med modulpaket. Delade ProtoBUF: er eller GraphQL-schema-definitioner är versionskontrollerade i en separat kontraktrepo.

4. Serviceversion och bakåtkompatibilitet

- API -versionering: Alla offentliga API: er är versionerade (t.ex. `/v1/aktiviteter ‘). Avskrivna slutpunkter upprätthålls under en definierad solnedgångsperiod med observerbarhet att övervaka användningen.

- Schema Evolution:

PostgreSQL-scheman använder tillsatsmigrering (lägga till kolumner, inte ta bort dem) och byta aldrig namn eller begränsningar utan dubbelläst/skriv växlar på plats. För NoSQL-butiker är varje objekt taggat med en schemaversion för bakåtkompatibel deserialisering. - Protokollkompatibilitet: GRPC- och ProtobuF -kontrakt är utformade för att undvika att bryta förändringar – fält tas aldrig bort och fält -ID: er återanvänds inte. För GraphQL förblir avskrivna fält tillgängliga med varningsrubriker och smäll i frontend.

Tänker du på lång sikt för din plattform?

Behöver du hjälp med att utforma en modulär, framtidssäker arkitektur som inte smuldrar under version av helvete eller tillväxtflaskhalsar?

Oavsett om du skalar en social app eller utökar en fitnessplattform, är vi här för att hjälpa arkitekten på lång sikt.

Prestationsoptimering

1.. Databasfrågan inställning

- Frågeindexering: Varje kolumn med hög kardinalitet som används i filter eller sammanfogningar-såsom `user_id`,` aktivitet_id`, `create_at` eller` utmaning_id`-stöds av btree eller gin-index. Kompositindex skapas för frekventa frågor som `follower_id + create_at desc` i flöden eller` user_id + utmaning_id` i topplista.

- Materialiserade vyer: Dagliga samlingar (t.ex. “Total Distance Run denna vecka”) lagras som materialiserade vyer och uppdateras via async -jobb. Detta undviker repetitiva aggregeringssökningar och påskyndar mobila instrumentpanelmätningar.

- Fråga Caching: Leaderboards, offentliga profiler och statiska utmaningssidor använder Redis som ett cache -lager med intelligenta TTL och uttryckliga ogiltiga på relevanta händelser.

2. Asynkron bearbetning

- Uppskjutna arbetsbelastningar: Tunga uppgifter som segmentmatchning, värmekartgenerering, utvärdering av märken och follower foderfläkt är alla uppskjuten till bakgrundsarbetare som konsumerar Kafka/NATS-ämnen. Detta håller aktiviteten för inlämning av aktivitetsvägen (~ 100–200 ms P99).

- Bulkintagvägar: Uppladdningar från Garmin eller Apple Health är satsade och bearbetas parallellt, med deduplicering och felisolering för att undvika att blockera fullständiga enhetssynkronisering på grund av enstaka korrupta filer.

3. Betygsbegränsande och missbrukskontroller

- Ratskontroll: Varje API-slutpunkt har gränser på användarnivå och IP-nivå som verkställs vid gatewayen. Högkostnadsoperationer (t.ex. postaktiviteter med media) begränsas ytterligare via adaptiv strypning bunden för att begära latens och köfördröjning.

- Detektering av missbruk: Maskinlärda modeller gör åtgärder som Follow Spam, Comment Flooding eller kränkande geo-post. Dessa är bundna till realtidsfilter som bromsar eller Sandbox skadliga klienter automatiskt.

4. Cache -lager

- Edge Caching: Ruttkartor, profilavatarer, utmaningssidor och värmekartplattor serveras alla genom CDN -kantnoder (CloudFlare, snabbt). Cache -nycklar är taggade med version hash för att möjliggöra snabb global ogiltighet.

- Cachning av klientsidan: Mobilappen använder lokal SQLite för offline-läge, med hydrering från delta-uppdaterade JSON-klokt som mottogs vid start eller post-login. Detta möjliggör omedelbar foderåtergivning och jämnare förkylningsstart.

5. Frontend Performance

- Inkrementell lastning: Mata rullar, profilvyer och utmaningslistor som alla implementerar oändlig rullning eller fönsterpagination med markbaserade tokens. Detta minimerar nyttolaststorlek och minnestryck på mobila klienter.

- Bildoptimering: Alla uppladdade bilder ändras, komprimeras och formatkonverteras (t.ex. WEBP) av medietjänsten före CDN-leverans. Enhetsspecifika tillgångsvarianter väljs med hjälp av innehållsförhandlingsrubriker.

- JS Bundling & Tree Shaking: Webklienter använder moderna bundlers (t.ex. Vite eller Webpack 5) med dynamisk importdelning och skakning av träd. Lazy Loading används för icke-kritiska UI-komponenter som diagram, kartor eller analyser.

Teststrategi

1. Typer av testning

- Enhetstest: Varje serviceskikt har omfattande enhetstester som täcker domänlogik, inmatningsvalidering och verktygsfunktioner. Dessa är snabbt och isolerade-inga externa beroenden tillåtna. Hocking-bibliotek (t.ex. Gomock, Pytest-Mock, Jest) används för att isolera biverkningar.

- Integrationstest: Viktiga serviceinteraktioner-som aktivitetsinlämning som utlöser generering av foder eller utmaningsbehörighetskontroller-är täckta med dockningsbaserade testmiljöer. Dessa tester snurrar upp verkliga beroenden (PostgreSQL, Redis, Kafka) och validerar beteende under realistiska förhållanden.

- Kontraktstest: För GRPC- och REST-API: er validerar kontraktstester (t.ex. med hjälp av PACT eller BUF för Protobuf) att producenten och konsumenttjänster följer överenskomna scheman, särskilt över serviceversionens stötar eller under parallella distributioner.

- End-to-end (E2E) testning: Kritiska användarflöden – registrering, inloggning, aktivitetsspårning, kommentarer – testas med Cypress eller detox (för React Native). Dessa tester körs på emulatorer och verkliga enheter i CI mot iscensättningsmiljöer.

2. CI Testtäckningsstrategi

- Kodtäckningsförvaltning: Minsta tröskelvärden verkställs för PRS med hjälp av verktyg som CodeCov eller SonarQue. Täckningsgrindar blockerar sammanslagningar om ny kod saknar lämpliga testfall – särskilt för servicelogik eller datatransformationsfunktioner.

- Parallelliserade CI -rörledningar: Tester grupperas efter service och körs parallellt via Github -åtgärder, circci eller buildkite. Testmatris inkluderar miljöpermutationer (t.ex. olika DB -versioner, API -versioner).

- Testarmaturer och sådd: Delade testdata tillhandahålls via containeriserade ögonblicksbilder eller deklarativa YAML/JSON -fixturer. Alla tjänster stöder testläge bootstrapping för lokala och CI -testmiljöer.

3. Last & motståndskraftstestning

- Belastningstest: Locust-, artilleri- eller K6-skript simulerar topptrafikmönster-stora fläkt-out, bulkaktivitetsuppladdningar, utmaningsledare-uppdateringar-för att testa systemrespons under stress. Lasttester körs varje vecka och under större utgåvor.

- Chaos Engineering: Verktyg som Gremlin eller Litmuschaos injicerar fel vid tjänsten, DB eller nätverksskiktet (t.ex. latensspikar, tappade Kafka -partitioner, DB -failovers). Målet är att validera försökspolicyer, fallback -logik och varningstäckning.

- Motståndskrafter: Kretsbrytare, skott och timeout -fallbacks testas uttryckligen. Canary-distributioner inkluderar felinjektionstester innan full utrullning fortsätter.

DevOps & CI/CD

1. Översikt över CI/CD -rörledningar

Hela systemet är byggt på GIT-baserade arbetsflöden (GitHub, Gitlab eller Bitbucket) med automatiserade rörledningar utlösta på dragförfrågningar, sammanslagningar och taggbaserade utgåvor. CI/CD behandlas som en förstklassig produkt med prestanda, isolering och synlighet som kärnprinciper.

Rörledningssteg:

- Bygga: Behållarbilder är byggda per tjänst med flera stegs dockerfiler. Vanliga basbilder cachas och återanvänds. För frontend -appar inkluderar byggsteg trädskakning, transpilering och buntanalys.

- Testa: Enhets-, integrations- och kontraktstester körs i isolerade jobb med uppladdning av artefakt (t.ex. täckningsrapporter, testloggar). Misslyckade jobb är kommenterade inline i PR för snabb triage.

- Säkerhetsskanning: SAST (t.ex. SonarQube, Snyk) och beroenden sårbarhetsskanningar verkställs innan artefakter främjas. Hemligheter Skanningsverktyg blockerar oavsiktlig exponering.

- Bildsignering: Behållarbilder är signerade och lagrade i ett säkert register (t.ex. AWS ECR, GCP Artifact Registry) med oföränderliga taggar och provningsmetadata.

- Iscensättning av distribution: Taggade builds distribueras automatiskt till ett iscenesättande kluster. Kanariestester, rökprover och syntetiska hälsokontroller körs mot denna miljö med korta TTL: er.

- Produktionskampanj: Distributioner till PROD utlöses antingen manuellt (med godkännande grindar) eller automatiskt efter att QA -förhållanden har passerat. Gitops verktyg (t.ex. ArgoCD, Flux) tillämpar manifester från en versionerad tillståndrepo.

2. Infrastruktur som kod (IAC)

- Terraform: All infrastruktur – VPC: er, K8S -kluster, DB -instanser, IAM -roller, köer – hanteras via terraform -moduler. Ändringar granskas och förhandsgranskas med terraform plan i prs. Driftdetektering körs varje natt för att upptäcka manuella ändringar.

- Anpassa & hjälmar: K8s manifester mallas via roret och hanteras över miljöer med hjälp av kustomize -överlägg. Detta gör det enkelt att åsidosätta kopior, konfigurationer och hemligheter per miljö.

- Secrets Management: Hemligheter och konfigurationskartor injiceras via förseglade hemligheter (t.ex. Mozilla Sops, Bitnami Sealed Secrets) eller synkroniseras från valv med hjälp av sidovagnar. Alla hemligheter roteras och granskas regelbundet.

3. Distributionsstrategi

- Blågröna distributioner: För kritiska vägtjänster som autor eller aktivitet används blågröna strategier. Trafiken skiftas gradvis med hjälp av Ingress -regler, med automatiserad återkoppling om hälsokontroller misslyckas.

- Canary Releases: Icke-kritiska tjänster (t.ex. aviseringar, topplistor) använder kanarieutrullningar-som distribueras till 5%, sedan 25%, sedan 100%över tiden. Metrics (latens, felfrekvens, CPU) jämförs mot baslinjer innan de fortsätter.

- Funktionsflaggor: Alla nya kodvägar skyddas av funktionsväxlar. Detta möjliggör progressiv exponering, mörka lanseringar och omedelbara killomkopplare under incidenter.

4. Artifakt & miljöhygien

- Bildlivscykel: Gamla byggnader beskärs automatiskt baserat på ålders- eller SHA -lagringspolicy. Oanvända bilder hålls aldrig längre än 30 dagar såvida inte märkta som LTS- eller Rollback -versioner.

- Förhandsgranskningsmiljöer: Efemala iscensättningsmiljöer skapas per PR med dynamiska namnutrymmen i Kubernetes. Dessa miljöer efterliknar produktionstopologier och förstörs efter sammanslagning eller PR nära.

- Rollback -mekanism: Varje distribution är atomisk och versionstång. Rollbacks kan utlösas via GIT -återvändning, Helm History Rollback eller ArgoCd UI -klick – inom några sekunder.

Behöver du hjälp med att leverera snabbare utan att bryta saker?

Vill du bygga en höghastighetsteknisk pipeline med skottbeständiga rollbacks, gitops arbetsflöden och produktionsklass CI/CD?

Oavsett om du skalar en Microservices -backend eller lanserar en ny mobil funktion, låt oss arkitekten ett DevOps -system som fungerar under tryck.

Övervakning och observerbarhet

1. loggning

- Strukturerad loggning: Varje serviceloggar i JSON -format med strukturerade fält som `request_id`,` user_id`, `aktivitet_id` och` varaktighet_ms`. Loggar strömmas via flytande bit eller filebeat till en central pipeline (t.ex. Elasticsearch, Loki) för indexerad fråga och analys.

- Korrelations -ID: Varje begäran genererar ett unikt korrelations -ID som förökas över servicegränser via rubriker och loggsammanhang. Detta möjliggör spårbarhet i full slut från mobilappen för att backa köer till DB.

- Logghygien: PII -maskeringsregler verkställs på log -rörledningsnivån. Hemligheter, åtkomsttokens, GPS -koordinater och rå telemetri utesluts eller redigeras automatiskt innan loggar träffar lagring.

2. Metriker

- Systemmätningar: CPU, minne, disk och nätverksanvändning exporteras från varje nod och pod via Prometheus -exportörer. Varningströsklar är inställda på mättnad, resurstryck och ovanlig podkörning.

- Business Metrics:

- Aktiviteter per minut, mata händelser per sekund

- Challenge går med, skriver topplistan, segmentmatchningar

- Latens per slutpunkt, 99: e percentilfelfrekvensen

- Anpassad instrumentering: Tjänster använder Prometheus -klientbibliotek för att exportera räknare, histogram och mätare för anpassad logik – till exempel “Badge -utvärderingar bearbetade” eller “GPS -poäng per uppladdning.”

3. Distribuerad spårning

- Spårningssystem: OpenLemetry används för att instrumenttjänster med spann för HTTP/GRPC -samtal, DB -frågor och Async -köhantering. Spår exporteras till backends som Jaeger, Honeycomb eller Tempo.

- Spårprovtagning: Huvudbaserad provtagning (med justerbara priser) säkerställer transaktioner med högt värde som aktivitetsförbindelse eller utfodring alltid fångas, medan lågprioriteringsbakgrundsjobb samplas sannolikt.

- Spårlänkning: Alla spår binder tillbaka till användar -ID: er och begär metadata, vilket möjliggör felsökning av enskilda aktivitetsinlämningar, toppbugg eller långsam följare av foderfoder med exakta kausalitetskedjor.

4. Varning och instrumentpaneler

- Alert Management: Prometheus AlertManager eller OpsGenie hanterar deduplicering, tystnadsfönster, rotationer på samtal och eskaleringspolicy. Varningar inkluderar Slack/Teams Hooks, SMS och PagerDuty när kritiska trösklar korsas.

- Instrumentpaneler: Grafana-instrumentpaneler är förbyggda per tjänst med borrnedgångsfunktioner för latens, felfrekvens, DB-genomströmning, köets orderstockar och externa API-fel. Affärsintressenter får också KPI -vyer (t.ex. aktiva användare, utmaningsfrekvenser).

- SLOS & ERROR BUDGUDER: Viktiga slutpunkter (t.ex. aktivitetsinlämning, foderbelastning, utmaning) är bundna till formella SLOS med latens/feltrösklar. Förbränningshastigheter beräknas för att informera funktionsgrindning och utrullning.

5. Hälsokontroller och beredskapssonder

- Livskraft och beredskap: Alla tjänster exponerar “/Healthz` -slutpunkter för grundläggande livlighet (t.ex. trådpoolstatus, minne) och beredskap (t.ex. DB -anslutning, köfördröjning). Kubernetes använder dessa för autoskalerings- och distributionsorkestrering.

- Djupa kontroller: Periodiska bakgrundsuppgifter utför syntetiska transaktioner (t.ex. testaktivitetsinsats + foderläsning) för att validera affärslogikhälsa – inte bara systemdum.

Avvägningar och designbeslut

1. Fan-out-on-write vs. Fan-out-on-Read

- Beslut: En hybridmodell valdes. För genomsnittliga användare använder systemet fan-out-on-write för att förpolera flöden. För användare med hög fan (t.ex. påverkare) byter den till Fan-O-LEAD.

- Varför: Förberedande av foderposter minimerar latensen och avlastar läsvägen, men det är dyrt när en användare har tusentals följare. Hybriddesignen optimerar för 95% -fallet samtidigt som infrastrukturen skyddar från fläktstormar.

- Avvägning: Mer operativ komplexitet. Systemet måste dynamiskt dirigera skriver/läser genom olika kodvägar baserat på användarnivå eller följare. Ökar också testytan.

2. Polyglotpersistens

- Beslut: PostgreSQL, Redis, Kafka och S3 valdes som kärnstacken. Valfri användning av NEO4J för social grafövergång uppskjuts.

- Varför: Dessa verktyg anpassar sig väl till åtkomstmönstren: PostgreSQL för integritet, redis för låg latensåtkomst, kafka för evenemangsdriven skala och S3 för klumplagring. Undvik en specialiserad graf DB förenklade OPS och onboarding.

- Avvägning: Vissa graffrågor (t.ex. “ömsesidiga följare i en klubb”) är mindre effektiva utan en dedikerad grafmotor. Redis-baserad caching mildrar detta men lägger till cache-koherens komplexitet.

3. Realtid GPS Sync kontra uppladdning efter träning

- Beslut: Uppladdning efter träning är standard; Synkronisering av realtid är valfritt och opt-in (t.ex. för livespårning eller virtuella lopp).

- Varför: GPS-strömning i realtid skapar konstant backend-belastning, introducerar konsistensutmaningar för delvis aktiviteter och ökar strömavloppet på mobila enheter. För de flesta användare är Batch -uppladdning tillräcklig.

- Avvägning: Minskad förmåga till kraftfunktioner som live jublande, pacer matchning eller pågående topplista-uppdateringar. Framtida versioner kan utöka support i realtid bakom funktionsflaggor.

4. Microservices vs. Monolith

- Beslut: Mikroservices valdes tidigt, med tydliga domängränser: aktivitet, foder, användare, utmaning, media, etc.

- Varför: Aktiverar oberoende skalning, parallell utveckling och domänspecifikt ägande. Foder- och aktivitetsintag har väldigt olika prestandaprofiler – att separera dem möjliggör riktad optimering.

- Avvägning: Kräver robust verktyg: Serviceupptäckt, spårning, CI/CD -isolering och mognad av plattformsteknik. För små team tillför detta komplexitet i förväg, men långvarig smidighet uppväger kortvarig smärta.

5. Händelsedriven kontra synkrona arbetsflöden

- Beslut: Alla icke-kritiska banor (Feed Fan-Out, Leaderboard-uppdateringar, aviseringar) är asynkroniserade via Kafka/Nats. Endast Auth och användarvänliga frågor använder förfrågan/svarflöden.

- Varför: Async -system skalas bättre och avkopplar arbetsflöden. De tillåter också satsning, retria och prioritering av kö-nödvändigt för variabla intagsmönster som tredjepartssynkronisering eller utmaningsspikar.

- Avvägning: Eventuell konsistens och felsökningskomplexitet. Kräver DLQ: er (Dead-Letter-köer), upprepningar av händelser och noggrann dedupliceringslogik. Övervakning och observerbarhet är nyckeln till säkerheten här.

Arkitektonisk skuld och mildring

- Vissa äldre fodervägar antar fortfarande synkrona skrivningar-att återfaktas till Kafka-baserade fans-out-tjänster.

- Den första utmaningsmotorn hade hårdkodade regler – ersatt med en regelmotor för flexibilitet.

- Behörighetslogik spridd över tjänster – centraliseras i en åtkomstpolicy för att upprätthålla konsistens.

Viktiga takeaways och områden att förbättra

1. Vad denna arkitektur får rätt

- Skalbarhet genom design: Statlösa tjänster, händelsedriven behandling och skakade databaser håller systemet lyhörd även vid miljoner användare och höga intag.

- Modulära gränser: Tydlig separering mellan aktivitet, sociala, media och analyslogik möjliggör fokuserad optimering och säker, parallell utveckling.

- Async först: Avkoppling av fodergenerering, utmaningsscoring och aviseringar från Core Ingest -banan ger prestanda och felisolering där det är viktigt.

- Säkerhet och integritet: Finkorniga åtkomstkontroller, krypterad lagring och strikt observerbarhetspraxis är i linje med dataansvaret på GDPR-nivå.

- Utvecklarhastighet: CI/CD -rörledningar, funktionsflaggor och kontraktstester stöder snabb, säker iteration – utan att kompromissa med produktionsstabilitet.

2. Möjligheter till förbättringar

- Dynamiska graffrågor: Omvärdera användningen av Redis kontra specialbyggd graf DBS (t.ex. Dgraph, Nebula) för ömsesidig följare upptäckt eller avancerade klubbfunktioner.

- Unified Access Control: Centrala alla tillståndskontroller av en policy -tjänst (OPA eller Custom) för att undvika duplicering och driva över tjänster.

- Live -funktioner: Att utvidga realtidsfunktioner (t.ex. levande segment, pacers, gruppkörningar) med pålitliga strömningsprotokoll och kontrollerad utrullning.

- Mobil offline synkronisering: Förbättra offline-första UX för användare på landsbygden eller under långa utomhusaktiviteter med bättre strategier för konfliktlösning.

- Avancerad analys: Byggande dedikerade idrottsutrymmen rörledningar (t.ex. VO2 MAX-uppskattning, träningsbelastning) med hjälp av pre-aggregerade datasjöar och ML-modeller.

Denna plattformsdesign balanserar prestanda, flexibilitet och användarupplevelse i ett krävande socialt + fitness -sammanhang. Det är produktionsklar, stridstestad och byggd för tillväxt-men med utrymme att utvecklas till ett mer intelligent, realtid och personligt fitnessekosystem.

Bygga något så ambitiöst?

Att designa skalbara, säkra och socialt engagerande plattformar handlar inte bara om att välja rätt stack – det handlar om att fatta rätt beslut vid rätt tidpunkt.

Oavsett om du lanserar en fitness -app, förbättrar användarengagemanget eller moderniserar din backend, är vi redo att hjälpa dig att arkitekt med förtroende.

Människor frågar också (vanliga frågor)

Hur utvecklar jag en fitness tracker -app?

Börja med att definiera kärnfunktionerna: GPS -aktivitetsspårning, intag av data (hjärtfrekvens, steg), användarprofiler och offline -loggning. Därifrån, designa en mobil-första upplevelse med React Native eller Swift/Kotlin, implementera säker användarverifiering (OAUTH2) och ansluta till en backend som kan äta, bearbeta och analysera sensordata i realtid. Moln-infödda infrastruktur, skalbara datalager och evenemangsdriven bearbetning kommer att vara nyckeln till att hålla prestanda och lyhördhet tätt.

Hur mycket kostar det att bygga en fitness -app?

Det beror på omfattning, men en fitness-app med produktionsklass med GPS-spårning, användarutnyttjande, realtidssynkronisering, molnlagring och sociala funktioner kommer vanligtvis att kosta mellan $ 50K till $ 500K+ att bygga och lansera. Det inkluderar UI/UX, mobil utveckling, backend -arkitektur, DevOps och QA. Kostnadsskalan baserad på komplexitet – livespårning, sociala grafer, integrationer och analys ökar alla tekniska ansträngningar.

Hur gör jag en Strava -app?

För att bygga en Strava-liknande app behöver du en mobilklient för GPS-baserad aktivitetsinspelning, en backend för lagring och analys av användarträning och ett socialt graflager för flöden, följer och interaktioner. Kärnkomponenter inkluderar en realtidsläge, en skalbar fodertjänst och en evenemangsdriven motor för utmaningar och topplistor. Arkitekt för skalbarhet, låg latens och modulära servicgränser är avgörande.

Hur mycket kostar det att bygga en app som Strava?

En fullständig plattform i Strava-stil kan enkelt överstiga $ 500 000 till $ 1 miljoner+ i utvecklingskostnad, beroende på din funktionsuppsättning, teamstruktur och tid till marknad. Kostnaderna inkluderar mobil- och backend-utveckling, molninfrastruktur, prestationsoptimering och stöd för saker som mediauppladdningar, sekretessinställningar och tredjepartsenhetsintegrationer.

Vilken databas använder Strava?

Strava har inte offentligt detaljerat sin fulla stack, men baserat på mönster som är gemensamma för system i liknande skala använder de troligtvis en blandning av relationsdatabaser (t.ex. PostgreSQL), distribuerade datalagrar för telemetri (t.ex. Cassandra eller Time-Series DBS) och Redis-liknande system för caching. Deras arkitektur är evenemangsdriven och mikroservicebaserad, med molninfrastruktur som hanterar miljoner aktiviteter per dag.

Varför är Strava så populär?

Strava spikade blandningen av fitnessspårning och socialt engagemang. Det handlar inte bara om att spela in körningar – det handlar om att dela dem, tävla på segment, tjäna märken och engagera sig i ett samhälle. Det sociala foder, gamification-funktioner och utmanar ekosystem gör plattformen klibbig och vanor, vilket driver både kvarhållning och viralitet.

Är en fitness -app lönsam?

Ja – om den körs väl. Prenumerationsbaserade fitness-appar (som Strava Premium, MyFitnessPal, etc.) har visat sig vara mycket lönsamma. Intäkterna kan komma från premiumanalys, coachningsverktyg, märkesutmaningar eller redskapsmarknadsplatser. Men lönsamheten kräver en stark lagringsstrategi, infrastruktureffektivitet och användartillväxt utöver MVP.

Hur tjänar jag pengar på min fitness -app?

Vanliga intäktsstrategier inkluderar: freemium-prenumerationer (t.ex. lås upp djupare analys eller coachning), inköp i appen (t.ex. utbildningsplaner), varumärkespartnerskap (t.ex. sponsrade utmaningar) och affiliatmarknadsplatser (t.ex. skor, wearables). Annonser är möjliga men försämrar ofta användarupplevelsen. Fokusera på användarförtroende och långsiktigt värde vid utformning av intäktsvägar.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.