Terwijl we doorgaan naar de moderne technologische wereld, verwerk dan automatisering met behulp van Kunstmatige intelligentie -ontwikkeling En Ontwikkeling van machine learning is de ruggengraat van verschillende industrieën geworden omdat het efficiëntie, snelheid en kosteneffectiviteit belooft. Aan de andere kant is automatiseringsbias een aanzienlijke zorg geworden. Dit zou een zorg moeten zijn, omdat naarmate bedrijven en organisaties procesautomatisering blijven gebruiken, velen zich niet bewust zijn van de mogelijke gevolgen die deze geautomatiseerde systemen kunnen hebben op billijkheid en gelijkheid.

Hoewel automatisering efficiëntie en gemak brengt, kan het ook subtiele maar krachtige vooroordelen introduceren die discriminatie en ongelijkheid bestendigen. Inzicht in de dynamiek van automatiseringsbias is cruciaal bij het aanpakken van deze problemen en het creëren van systemen die eerlijkheid voor iedereen bevorderen.

Wilt u ontdekken hoe u onpartijdige geautomatiseerde systemen kunt maken met ethische AI?

Wat is Automatiseringsbias?

Bias automatisering verwijst naar de neiging van mensen om over te vertrouwen op geautomatiseerde systemen, ervan uitgaande dat hun beslissingen correct zijn zonder ze in twijfel te trekken. In een wereld waar machines vaak als onfeilbaar worden beschouwd, kan dit vertrouwen leiden tot schadelijke gevolgen.

In de praktijk betekent automatiseringsbias dat mensen hun eigen oordelen kunnen negeren en vertrouwen op beslissingen die een geautomatiseerd systeem hebben genomen, zelfs wanneer die systemen gebrekkig of bevooroordeeld zijn. Bij het inhuren van processen zijn veel bedrijven bijvoorbeeld in toenemende mate afhankelijk van geautomatiseerde systemen om cv’s te screenen of kandidaten te evalueren. Deze systemen kunnen, hoewel efficiënt, vooroordelen bestendigen als ze worden getraind op bevooroordeelde gegevens.

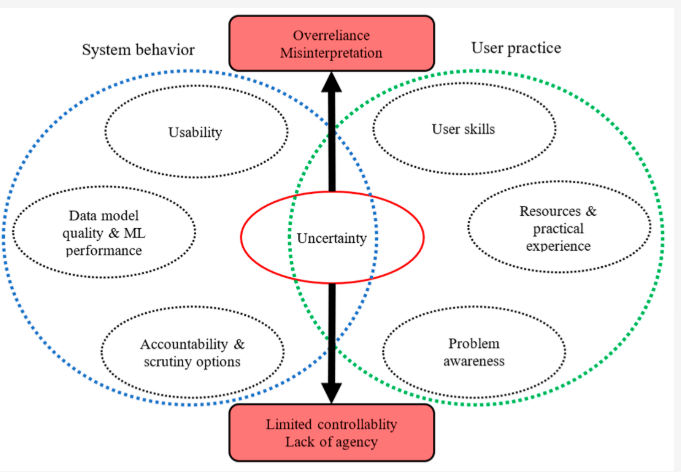

Bron: MDPI over het rapporteren van geavanceerde ML en datamining

Als gevolg hiervan kunnen aanvragers van ondervertegenwoordigde groepen oneerlijk worden vertoond, hoewel hun kwalificaties gelijk zijn aan of superieur aan anderen. Dit is een duidelijk voorbeeld van hoe automatiseringsbias direct kan bijdragen aan ongelijkheid.

Hoe procesautomatisering discriminatie kan versterken

Terwijl Procesautomatisering Kan bewerkingen stroomlijnen en de efficiëntie verbeteren, het kan ook algoritmische vertekening versterken als het niet zorgvuldig wordt beheerd. Algoritmische bias verwijst naar het systematische favoritisme of discriminatie die inherent is aan geautomatiseerde systemen. Als de gegevens die worden gebruikt om deze algoritmen te trainen, vooroordelen bevatten-zoals geslacht, ras of sociaal-economische vooroordelen-zal het geautomatiseerde systeem deze vooroordelen waarschijnlijk erven en zelfs versterken.

De implicaties van automatiseringsbias zijn verreikend en kunnen ernstige gevolgen hebben voor individuen en de samenleving als geheel. Het kan leiden tot:

- Verminderde kansen: Biased algoritmen kunnen de toegang tot werkgelegenheid, onderwijs en financiële diensten voor bepaalde groepen beperken.

- Versterking van stereotypen: Geautomatiseerde systemen die stereotypen bestendigen, kunnen de reeds achtergestelde gemeenschappen verder marginaliseren.

- Erosie van vertrouwen: Naarmate mensen zich bewust worden van het potentieel voor bias in geautomatiseerde systemen, kan dit leiden tot een verlies van vertrouwen in instellingen en technologie.

Overweeg hoe AI en ongelijkheid elkaar kruisen in real-world scenario’s. In het strafrechtsysteem worden voorspellende algoritmen gebruikt om de kans op recidive te beoordelen. Als de gegevens echter op deze algoritmen vertrouwen op historische vooroordelen weerspiegelen, zoals onevenredig hogere arrestatiepercentages in bepaalde gemeenschappen, kan de AI -bias in deze systemen leiden tot oneerlijke resultaten, zoals langere zinnen voor minderheden. Dit is een schril voorbeeld van hoe automatiseringsbias maatschappelijke ongelijkheden kan bestendigen.

Evenzo kan procesautomatisering in de gezondheidszorg onbedoelde gevolgen hebben. Als een algoritme wordt getraind op gegevens die bepaalde demografie oververtegenwoordigt, terwijl anderen ondervertegenwoordiging, kan het systeem onnauwkeurige voorspellingen of aanbevelingen doen. Dit kan leiden tot discrepanties in medische zorg, waarbij gemarginaliseerde groepen een inferieure behandeling krijgen of niet tijdig worden gediagnosticeerd.

Sommige bekende gevallen van AI -algoritme vooroordelen

Het is waar dat alleen vertrouwen op AI soms kan leiden tot oneerlijke resultaten. Hier is Een rapport gepubliceerd door het Greenlineing Institute Dat toont enkele voorbeelden van hoe algoritmen in verschillende situaties zijn bevooroordeeld:

Overheidsprogramma’s:

- Het werkloosheidssysteem van Michigan: Michigan gebruikte een algoritme om fraude in werkloosheidsclaims te detecteren. Helaas beschuldigde het systeem ten onrechte duizenden mensen, wat leidde tot boetes, faillissementen en zelfs verhinderingen. Het bleek dat het algoritme vaak fouten maakte en er was niemand om zijn beslissingen te controleren.

- Arkansas Medicaid: Een algoritme werd gebruikt om te bepalen wie in aanmerking kwam voor Medicaid -voordelen in Arkansas. Dit leidde ertoe dat veel mensen de toegang tot essentiële medische zorg verloren. Het probleem? Het algoritme had fouten en het was erg moeilijk voor mensen om in beroep te gaan tegen zijn beslissingen.

Werkgelegenheid:

- Amazon’s wervingsinstrument: Amazon probeerde een algoritme te maken om hen te helpen de beste werknemers in te huren. Het algoritme was echter de voorkeur aan mannen boven vrouwen. Het lijkt erop dat het algoritme dat wordt geleerd van het inhuren van gegevens uit het verleden, die mogelijk vooroordelen bevatten.

Gezondheidszorg:

- Ongelijke behandeling: Zelfs wanneer algoritmen zijn ontworpen om eerlijk te zijn, kunnen ze worden gebruikt op manieren die vooringenomenheid creëren. Een ziekenhuis gebruikte bijvoorbeeld een algoritme om te beslissen welke patiënten extra zorg nodig hadden. Helaas betekende de manier waarop ze gebruikten dat zwarte patiënten veel zieker moesten zijn dan blanke patiënten om hetzelfde niveau van aandacht te krijgen.

Onderwijs:

- Beoordeling vooringenomenheid in het VK: Tijdens de pandemie gebruikten scholen in het VK een algoritme om studentencijfers te geven toen examens werden geannuleerd. Het algoritme gaf echter lagere cijfers aan studenten uit gezinnen met een lager inkomen, waaruit blijkt hoe algoritmen soms bestaande ongelijkheden kunnen versterken.

Huisvesting:

- Oneerlijke screening: Veel verhuurders gebruiken algoritmen om potentiële huurders te screenen. Een dergelijk algoritme verhinderde ten onrechte dat een moeder een appartement zou huren omdat haar zoon een kleine overtreding in zijn dossier had die later werd afgewezen.

- Desinvestering in Detroit: Een algoritme werd in Detroit gebruikt om te beslissen welke buurten investeringen en verbeteringen zouden moeten ontvangen. Dit resulteerde in overwegend zwarte en arme buurten die middelen werden geweigerd, waaruit blijkt hoe algoritmen bestaande sociale problemen kunnen verergeren.

Deze voorbeelden laten zien dat hoewel algoritmen krachtige hulpmiddelen kunnen zijn, ze zorgvuldig moeten worden ontworpen en op verantwoorde wijze worden gebruikt om oneerlijkheid en discriminatie te voorkomen. We moeten ervoor zorgen dat algoritmen worden gebruikt om billijkheid en gelijkheid te bevorderen, niet bestaande vooroordelen in stand te houden.

Automatiseringsvooroordeel en algoritmische bias aanpakken

Het aanpakken van automatiseringsbias en het potentieel ervan om algoritmische vertekening te bestendigen, vereist een veelzijdige aanpak. Ten eerste is het essentieel om ervoor te zorgen dat de gegevens die worden gebruikt om algoritmen te trainen divers en representatief zijn voor alle demografische groepen. Zonder verschillende gegevens riskeren algoritmen bestaande vooroordelen te versterken in plaats van deze aan te pakken.

Ten tweede moeten transparantie en verantwoording worden ingebouwd in AI- en automatiseringssystemen. Ontwikkelaars moeten duidelijk zijn over hoe deze systemen functioneren en openstaan voor controle. Regelmatige audits van algoritmen kunnen helpen bij het identificeren van gebieden waar bias aanwezig kan zijn en corrigerende maatregelen kunnen worden geïmplementeerd voordat deze vooroordelen schadelijke effecten hebben.

Ten slotte kunnen AI en ongelijkheid worden geminimaliseerd door eerlijkheid en inclusiviteit te bevorderen tijdens de ontwerp- en implementatiefasen. Door ethische AI -praktijken te integreren, kunnen bedrijven ervoor zorgen dat hun oplossingen voor procesautomatisering niet alleen efficiënt, maar ook rechtvaardig en billijk zijn.

Identificeer en behandel automatiseringsbias in uw processen met onze deskundige begeleiding

De rol van WeblineIndia bij het aanpakken van bias van automatisering

Voor bedrijven die de kracht van procesautomatisering willen benutten en tegelijkertijd eerlijkheid, transparantie en ethische verantwoordelijkheid waarborgen, valt WeblineIndia op als een vertrouwde partner met zijn Vertrouwensmodel van outsourcing. Als experts in het integreren van geavanceerde technologie met ethische overwegingen blinkt WeblineIndia uit in het aanpakken van de uitdagingen van automatiseringsbias. Ze zijn toegewijd aan het creëren van AI-aangedreven oplossingen die algoritmische vooringenomenheid minimaliseren en AI en ongelijkheidsbewustzijn bevorderen.

De aanpak van WeblineIndia is uniek omdat het de voordelen van automatisering in evenwicht brengt met een focus op algoritme -ethiek, zodat de technologie op verantwoorde wijze wordt gebruikt en discriminatie niet bestendigt. Of het nu gaat om het ontwikkelen van aangepaste software, implementeren Procesautomatiseringsoplossingen, of adviseren over AI BIAS -mitigatiestrategieën, het team van WeblineIndia prioriteit geeft aan kwaliteit, billijkheid en sociale verantwoordelijkheid.

Klaar om onpartijdige softwareoplossingen te bouwen die door AI worden aangedreven?

Kies WeblineIndia en we kunnen er zeker van zijn dat u samenwerkt met een dienstverlener die niet alleen de technische fijne kneepjes van AI begrijpt, maar ook prioriteit geeft aan ethische overwegingen. Samen kunnen we een toekomst bouwen waar technologie voor iedereen werkt, niet tegen hen.

Concluderend, hoewel procesautomatisering een enorm potentieel biedt, is het cruciaal om op de hoogte te zijn van de risico’s van automatiseringsbias waarvoor WeblineIndia zorgt. We kunnen ervoor zorgen dat AI- en automatiseringssystemen voorgoed tools zijn, het bevorderen van billijkheid, inclusiviteit en gelijkheid op alle gebieden van het leven door te begrijpen hoe algoritmische bias werkt en stappen ondernemen om het aan te pakken. Neem contact met ons op En we helpen u bij het navigeren van deze uitdaging en creëren oplossingen die de hoogste normen van ethische verantwoordelijkheid handhaven.

Sociale hashtags

#AutomationBias #ethicalai #biasintech #StopalgorithmicDiscrimination #ai #Automation #AiaUtomation #SoftWaresolutions

Wilt u inclusieve en eerlijke AI-aangedreven oplossingen voor uw bedrijf bouwen?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.