Fitness-tracking-apps zijn veel verder geëvolueerd dan eenvoudige staptellers of op GPS gebaseerde activiteitenlogboeken. De gebruikers van vandaag verwachten een rijke sociale interactiviteit, competitieve gamification, realtime gegevenssynchronisatie en naadloze integratie met een groeiend ecosysteem van wearables en gezondheidsplatforms. Strava zette een benchmark in deze ruimte door atletische activiteiten te volgen bij het volgen van sociale engagement – leaderboards, uitdagingen, opmerkingen, clubs en zelfs virtuele races – allemaal gewikkeld in een gladde UX die prioriteit geeft aan zowel prestaties als gemeenschap.

Het ontwerpen van een systeem als dit gaat veel verder dan basis CRUD -bewerkingen op gebruikerstrainingen. Het vereist een robuuste architectuur die aankan:

- Hoogfrequente geolocatie-updates van miljoenen gelijktijdige gebruikers

- Real-time voedergeneratie en activiteitenuitzendingen naar volgernetwerken

- Schaalbare, lage latentie sociale grafiekquery’s

- Mediaopslag en ophalen (bijv. Routekaarten, foto’s, badges)

- Gedreven gegevenspijpleidingen voor het berekenen van segmenten, leaderboards en uitdagingen

- Beveiliging en privacycontroles over complexe voorkeuren voor het delen van gegevens

De uitdaging is om een backend te architecteren die een snelle, boeiende en sociaal rijke ervaring ondersteunt, terwijl flexibel genoeg blijft om te integreren met fitnessapparaten van derden, de mate van gemeenschaps te ondersteunen en nieuwe functies te ontwikkelen zonder oude functies te breken.

Deze technische diepe duik breekt de architectuur van een dergelijk systeem af. Het schetst de kernvereisten, ontwerpen voor schaalbaarheid en realtime responsiviteit, gegevensmodellen voor door gebruikers gegenereerde inhoud en infrastructuurpatronen om een sociaal fitnessplatform te ondersteunen dat tot miljoenen gebruikers kan groeien zonder de prestaties of betrouwbaarheid te vernederen.

Systeemvereisten

1. Functionele vereisten

De kernfunctionaliteiten van de fitness -app moeten zowel het volgen van activiteiten als sociale betrokkenheid op schaal ondersteunen. Belangrijke functionele vereisten zijn onder meer:

- Gebruikersbeheer: Aanmelden, authenticatie, profielbewerking en accountherstel.

- Activiteitsopname: Log GPS-gebaseerde trainingen (bijv. Runs, ritten), ondersteuningshandleiding en capture metadata zoals afstand, tempo, hoogte, hartslag en gebruikte uitrusting.

- Real-time gegevenssynchronisatie: Stream locatie en sensorgegevens van mobiele of draagbare apparaten met lage latentie.

- Sociale grafiek: Volg/ontvolgingsmechanismen, suggesties van vrienden en privacy-gecontroleerde activiteiten zichtbaarheid (bijvoorbeeld privé, alleen volgers, openbaar).

- Activiteitsvoer: Dynamische tijdlijn die trainingen toont, volgden gebruikers, waaronder likes, reacties en heruitwissingen.

- Uitdagingen en leaderboards: Creëer time-boxed competities (bijv. “Rij 100 km in 7 dagen”), volg segment-leaderboards en bereken rankings asynchroon.

- Media -ondersteuning: Upload en bekijk foto’s, route hittemaps en persoonlijke prestaties (bijv. Badges, mijlpalen).

- Meldingen: Real-time push- en in-app-meldingen voor likes, opmerkingen, nieuwe volgers en uitdagingsupdates.

- Integratie van 3e partijen: Synchroniseren met Apple Health, Google Fit, Garmin en andere fitness -ecosystemen.

2. Niet-functionele vereisten

Om realtime interactie en groeiende gebruikersbasis te ondersteunen, moet het systeem voldoen aan strikte niet-functionele vereisten:

- Schaalbaarheid: Horizontaal schaalbare services en gegevenswinkels om miljoenen actieve gebruikers en terabytes van geo-temporele gegevens aan te kunnen.

- Lage latentie: Sub-seconde responstijd voor sociale interacties en realtime kaartweergave.

- Beschikbaarheid: 99,9%+ uptime met fouttolerantie in regio’s en zones.

- Beveiliging en privacy: Op OAuth2 gebaseerde authenticatie, gedetailleerde toegangscontrole, gecodeerde opslag en door de gebruiker gecontroleerde deelinstellingen.

- Uitbreidbaarheid: Modulaire servicegrenzen ter ondersteuning van toekomstige functies zoals virtuele races, clubgebaseerde chats of live coaching.

- Gegevensconsistentie: Eventuele consistentie is acceptabel in feeds en leaderboards, maar sterke consistentie is vereist voor transacties zoals accountinstellingen of premium -aankopen.

- Offline ondersteuning: Sta gebruikers toe om activiteiten op te nemen en in de wachtrij te bewaren wanneer ze offline zijn, met automatische synchronisatie bij herverbinding.

3. Beperkingen en veronderstellingen

- Mobiele apps (iOS en Android) zullen de primaire clients zijn; Webinterface is secundair.

- Locatie- en gezondheidsgegevens moeten worden verwerkt onder regionale nalevingsvoorschriften (bijv. GDPR, HIPAA waar van toepassing).

- De meerderheid van de gebruikers zal 1-2 activiteiten per dag synchroniseren, maar krachtige gebruikers en integraties kunnen innamespercentages tijdens evenementen of uitdagingsperioden piekeren.

- Cloud-native implementatie; De architectuur veronderstelt het gebruik van beheerde cloudservices voor reken-, opslag- en streaming.

Use case / scenario

1. Zakelijke context

De fitness -app richt zich op een brede demografie – van informele wandelaars tot competitieve fietsers – maar benadrukt gemeenschapsbetrokkenheid over individuele tracking. Zie het als een hybride tussen een personal trainer en een sociaal netwerk. Het doel is om terugkerend gebruik te stimuleren door concurrentie, sociale verantwoordelijkheid en gamified vooruitgang, waardoor het retentie en abonnementsconversie uiteindelijk toeneemt.

In-app-inkomsten kunnen zijn:

- Premium -abonnementen voor geavanceerde analyses, live segmenten en diepere trainingsinzichten

- Merkuitdagingen of gesponsorde competities

- In-app uitrustingspromotie (bijv. Affiliate marktplaats voor schoenen, fietsen, wearables)

De app moet daarom een robuuste basis mogelijk maken voor realtime prestatiestatistieken en tegelijkertijd boeiende, sociaal dynamische ervaringen leveren die gebruikers dagelijks terugkeren-zelfs als ze die dag niet trainen.

2. Persona’s en gebruikspatronen

- Solo -atleten: Gebruikers die hun trainingen volgen, prestaties uit het verleden vergelijken en af en toe deelnemen aan wereldwijde uitdagingen of segmenten.

- Sociale enthousiastelingen: Zeer betrokken gebruikers die vaak posten, commentaar geven op de activiteiten van vrienden en gedijen op gemeenschapsinteractie.

- Clubmanagers: Power -gebruikers die groepsevenementen coördineren, particuliere leaderboards en gematigde sociale ruimtes binnen clubs beheren.

- Data nerds: Premium-abonnees die geïnteresseerd zijn in hartslagzones, stroomcurves, herstelstatistieken en export van gegevens.

3. Verwachte schaal

Het systeem moet worden ontworpen om te ondersteunen:

- 10m+ geregistreerde gebruikers

- 2–3m MAU’s (maandelijkse actieve gebruikers), met ~ 500K Daus (dagelijkse actieve gebruikers)

- 10m+ activiteit uploads per maand, met pieken in het weekend en grote uitdagingsevenementen

- 500k+ gelijktijdige gebruikers tijdens piekperioden

- Miljarden gegevenspunten per maand over GPS, hoogte, hartslag en bewegingssensoren

- Miljoenen dagelijkse voedingsquery’s, sociale interacties en realtime meldingen

Om aan deze eisen te voldoen, moet de architectuur optimaliseren voor lees-zware sociale werkbelastingen, het uitbarsting van het verkeer van activiteiten uploads en asynchrone verwerking met hoge doorvoer voor segment matching en updates voor leaderboard.

Hulp nodig bij het ontwerpen van uw eigen fitness of sociale app?

Het bouwen van een sociaal-eerste fitnessplatform dat schaalt naar miljoenen gebruikers neemt meer dan schone code-het neemt de juiste architectuur vanaf de eerste dag.

Wilt u deskundige begeleiding bij het ontwerpen van prestaties, realtime synchronisatie en gebruikersbetrokkenheid op schaal?

Op hoog niveau architectuur

De architectuur moet efficiënt innemen van realtime activiteiten, distributie van sociale voeders, geospatiale analyse en gebruikersinteractie ondersteunen-allemaal op schaal. Dit vereist een modulaire, servicegerichte aanpak met goed gedefinieerde grenzen tussen kernsystemen zoals activiteiten volgen, gebruikersbeheer, verwerking van sociale grafiek en meldingslevering.

1. Overzicht van het onderdeel

Het systeem is gestructureerd rond de volgende belangrijke componenten:

- API Gateway: Central Entry Point voor alle clientcommunicatie. Behandelt authenticatie, rentebeperking en routeert verkeer naar interne services.

- AUTH Service: Beheert OAuth2-stromen, tokenuitgifte, sessiebeheer en integratie met identiteitsproviders van derden (bijv. Apple, Google).

- Gebruikersprofielservice: Slaat persoonlijke info, voorkeuren, uitrusting en privacy -instellingen op.

- Activiteitendienst: Behandelt op GPS gebaseerde trainingsinname, route-parsing, activiteitenvalidatie en metadata-extractie (bijvoorbeeld tempo, hoogtewinst).

- Feed Service: Genereert en slaat activiteitenfeeds op, verwerkt sociale grafische updates en verwerkt fan-out voor nieuwe activiteitenberichten.

- Sociale grafiekervice: Beheert volgerrelaties en berekent de zichtbaarheid voor activiteiten en uitdagingen.

- Challenge & Leaderboard Engine: Berekent ranglijsten, zorgt voor uitdagingslogica en werkt virtuele trofeeën en segmenten bij.

- Mediaservice: Behandelt afbeeldingen uploads (foto’s, routekaarten), CDN -caching en toegangscontrole.

- Meldingsservice: Publiceert realtime en batchmeldingen via websockets, FCM/APN’s of in-app-inboxen.

- Analytics Pipeline: Processen activiteitenstromen voor inzichten, trenddetectie en aanbevelingen voor atleet.

- Admin & Matation Portal: Tools voor het beheren van misbruikrapporten, het creëren van het maken van dashboards en analyse.

2. Hoge architectuurdiagram

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Samenvatting van de gegevensstroom

Wanneer een gebruiker begint met een training:

- De mobiele app streamt GPS- en sensorgegevens via een WebSocket of Batched API -upload naar de Activiteitendienst.

- De service ontleedt de gegevens, slaat de training op en geeft een evenement uit naar de Voedergenerator.

- De Sociale grafiekervice bepaalt wie de activiteit kan zien.

- Het feeditem wordt opgeslagen en geduwd naar relevante gebruikers via de Meldingsservice.

- Indien van toepassing wordt de activiteit geëvalueerd door de Leaderboardmotor voor uitdagingen voor uitdagingen en ranking -updates.

- Foto’s en route -visualisaties worden verzonden naar de Mediaservice en cached door een CDN.

Dit modulaire ontwerp ondersteunt zowel horizontale schaal als geïsoleerde service -evolutie. Het maakt ook realtime fan-out mogelijk voor feeds en meldingen met behulp van gebeurtenisgestuurde communicatie (bijv. Kafka of Nats).

Database -ontwerp

1. Kerngegevensmodellen en ERD -overzicht

Het systeem maakt gebruik van een polyglot-persistentiebenadering-relationele databases voor transactionele integriteit, tijdreeks/NoSQL voor activiteitsgegevens en grafiek- of in-memory-winkels voor krachtige sociale vragen.

Primaire entiteiten:

- Gebruiker: Profielinformatie, AUTH -instellingen, voorkeuren, abonnementsleer

- Activiteit: Workoutgegevens inclusief GPS -punten, statistieken, uitrusting, media

- Volgen: Volger-volgrelatie en zichtbaarheidsregels

- FeedItem: Renderable evenementen die aan gebruikers zijn gekoppeld (bijv. Geplaatst activiteit, commentaar, badge)

- Uitdaging: Metadata en staat voor groepswedstrijden

- Leaderboardtry: Uitdaging of segmentpositie en statistieken

Entity Relationship Diagram (conceptueel):

[Gebruiker]

├── id (PK)

├── naam, e-mailadres, avatar_url

└── settings_json

[Activiteit]

├── id (PK)

├── user_id (FK → Gebruiker)

├── type, starttijd, duur

├── afstand, hoogte, gemiddeld uur

├── geo_data_ref (FK → GeoStore)

└── zichtbaarheid (openbaar / volgers / privé)

[GeoStore] (externe opslagindex of S3-ref)

├── id (PK)

├── activity_id (FK → Activiteit)

└── gps_data (array of bestandspointer)

[Volgen]

├── follower_id (FK → Gebruiker)

├── followee_id (FK → Gebruiker)

└── created_at

[FeedItem]

├── id (PK)

├── actor_id (FK → Gebruiker)

├── verb ("gepost", "gecommentarieerd", "geliket")

├── object_id (bijv. activity_id, comment_id)

└── target_user_id (FK → Gebruiker)

[Uitdaging]

├── id (PK)

├── naam, beschrijving, type

├── startdatum, einddatum

└── zichtbaarheid, rule_json

[LeaderboardEntry]

├── id (PK)

├── challenge_id (FK → Challenge)

├── user_id (FK → User)

├── metric_value (afstand, duur)

└── rang

2. Keuzes voor databasetechnologie

Elk gegevensdomein is geoptimaliseerd voor zijn eigen toegangspatroon:

- Postgreesql: Canonieke gegevensbron voor gebruikersprofielen, activiteiten, feed -metadata en uitdagingen. Uitstekend voor transactionele integriteit en buitenlandse sleutelhandhaving.

- TimesCaledB / influxdb: Voor GPS-puntinname, activiteitentelemetrie en tijdreeksanalyses (bijv. Pace in de loop van de tijd, HR-zones).

- S3 + CD: Gebruikt voor het opslaan van RAW GPS-tracks, routebeelden en geüpload media (met veilige vooraf ondertekende URL-toegang).

- Redis / Memcached: Voor snel ophalen van leaderboards, recente activiteiten en vooraf berekende voedingsgegevens.

- Neo4j of dgraph (optioneel): Voor complexe sociale grafiek Traversal, Club -lidmaatschap en suggesties voor wederzijdse volgers op schaal.

3. Strategie voor meerdere tenancy & Partitioning

- Sharding: Activiteiten en feeditems worden geactiveerd door gebruikers -ID of regio -ID om horizontale schaalverdeling over partities mogelijk te maken.

- Tijdgebaseerde partitionering: GPS -telemetrie en leaderboards zijn opgesplitst in maandelijkse/wekelijkse partities voor veroudering en prestaties.

- Zachte multi-tenancy: Clubs of organisaties (bijvoorbeeld lopende groepen, fietsteams) werken binnen de wereldwijde naamruimte, maar kunnen scoped query’s krijgen (via tenant_id) wanneer dat nodig is.

4. Replicatie en hoge beschikbaarheid

- Postgreesql: Ingezet met Hot Standby Replica’s en Wal Shipping voor failover.

- Redis: Geconfigureerd met Sentinel voor een hoge beschikbaarheid en geautomatiseerde master verkiezingen.

- Media & Geostore: Objectopslag wordt over regio’s gerepliceerd en geleverd via een globale CDN voor toegang tot lage latentie.

Dit databaseontwerp zorgt voor flexibele schema -evolutie, snelle activiteiten inname en schaalbare ondersteuning voor sociale werklast en analyses – terwijl het behouden van referentiële integriteit waar het het belangrijkst is.

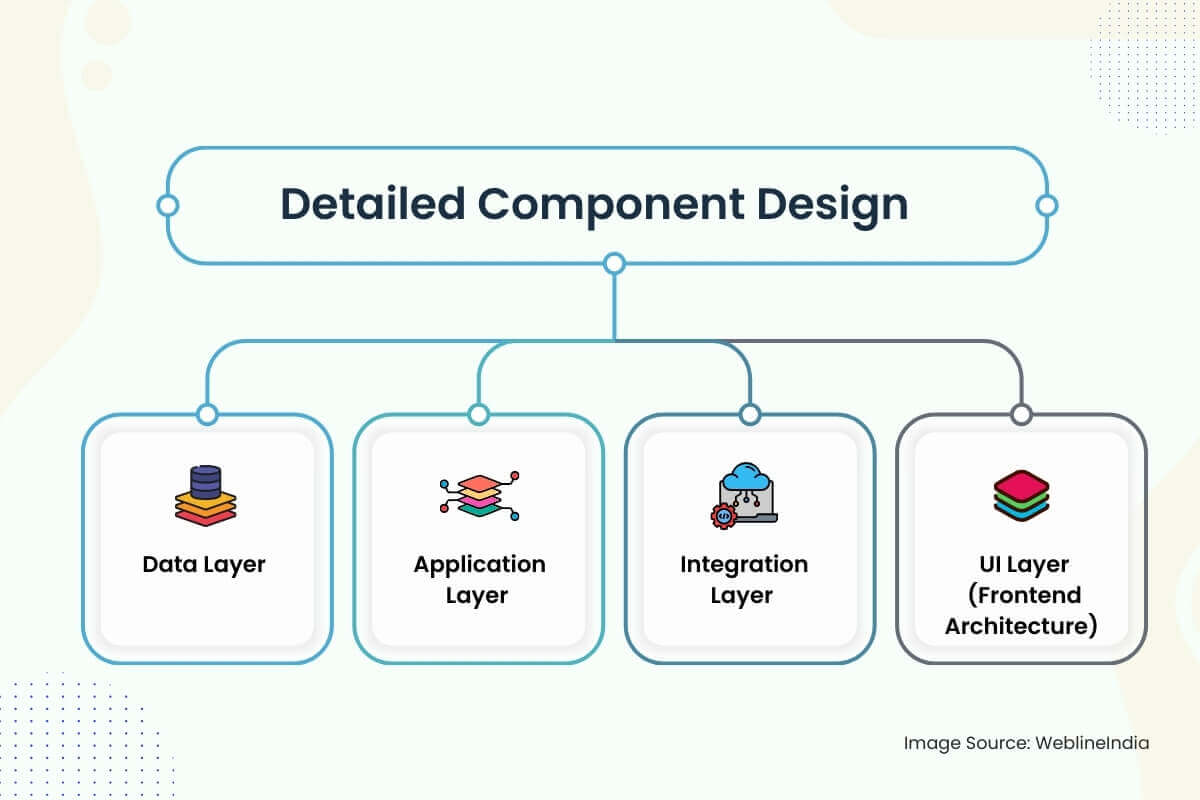

Gedetailleerd componentontwerp

1. Gegevenslaag

- Schema -strategie: Schema’s zijn ontworpen rond duidelijke domeingrenzen: gebruikers, activiteiten, feeds, sociale grafieken en uitdagingen. Kolommen zoals `zichtbaarheid ‘,` status` en `Activity_Type` gebruiken opgesomde typen voor het indexeren van efficiëntie. UUID’s hebben de voorkeur boven auto -geïncrementeerde gehele getallen om hotsleutelproblemen in gedistribueerde winkels te voorkomen.

- Gegevenstoegang: Toegang tot kerngegevens gaat door dunne servicelaagse repositories die het toegangscontrolebeleid afdwingen (bijvoorbeeld zichtbaarheidscontroles op activiteiten). Leesbewerkingen worden geoptimaliseerd via gematerialiseerde weergaven en voor elkaar gesloten feed snapshots. Schrijf-zware paden zoals inname van activiteiten gebruiken schrijven-licht wachtrijen en bulkinvoegpijpleidingen om innamespieken glad te maken.

- Geldigmaking: Invoervalidatie vindt plaats op meerdere niveaus-Randschema-handhaving via OpenAPI of GraphQL, diepe validatie in servicelagen (bijvoorbeeld geldige GPS-punten, niet-overlappende tijdstempels) en asynchrone gezond verstandcontroles op telemetriegegevens via achtergrondtaken.

2. Applicatielaag

Serviceontwerp: Elk belangrijk domein (gebruiker, activiteit, feed, melding, sociale grafiek) wordt geïmplementeerd als een geïsoleerde microservice. Services stellen zowel GRPC als REST-eindpunten bloot-rust voor openbare API’s, GRPC voor inter-service communicatie. Schone architectuurprincipes scheiden domeinlogica van transport- en infrastructuurcode.

Frameworks:

- Ga of roest voor prestatie-kritische diensten (activiteit, feed, leaderboard)

- Node.js of python voor lijmcode, integraties en asyncworkflows

- GraphQL Server (Apollo of Hasura) voor front-end aggregatie en declaratieve vraag

Authenticatie: JWT -tokens worden uitgegeven via OAuth2 -stromen. Service-to-service-oproepen gebruiken ondertekende interne tokens met op rollen gebaseerde scopes.

Rate beperkende & quota: Geïmplementeerd via door Redis gesteunde token emmers bij de gateway en granulariteit op gebruikersniveau (vooral voor activiteiten uploads).

3. Integratielaag

Berichtstaarten: Kafka of Nats wordt gebruikt voor async-workflows-activiteitenverwerking, feed-fan-out, segment matching en melding publiceren. Idempotent handlers met sterke leveringsgaranties worden gebruikt om dubbele berichten of leaderboard -inzendingen te voorkomen.

Synchronisatie van derden: OAuth -integraties met Garmin, Fitbit, Apple Health, etc., uitgevoerd via een achtergrondbeleid + webhook -combinatie. Nieuwe gegevens worden in de wachtrij geplaatst en verwerkt via de activiteitenopname -pijplijn.

Evenementtypen:

Activity.Created→ Fan-out om service te voeden, stelt volgers op de hoogteUitdaging.→ Controleer in aanmerking komen, trigger leaderboard inzetstukuser.followed→ Update grafiek, vernieuwingsfeed, enqueue welkomstmelding

4. UI -laag (frontend -architectuur)

App Stack: React native voor platformoverschrijdende mobiele apps, met Typescript en Redux Toolkit voor staatsmanagement. Web App gebruikt Next.js voor SSR/ISR met stylingstyling van Tailwind en GraphQL -query’s om te backend.

Beveiligingsproblemen:

- Clientgeheimen zijn nooit ingebed – oauth pkce flow is verplicht

- Alle API-oproepen vereisen ondertekende tokens en openbare eindpunten worden gefilterd door snelheid, oorsprong en rol

- Geo -gegevens zijn sandboxed per zichtbaarheidsinstelling – particuliere activiteiten zijn uitgesloten van hittemaps, feeds en segmentberekeningen

Realtime functies: Websockets of SSE worden gebruikt voor het pushen van meldingen, uitdagingsstatus en feedupdates. Fallback naar lange polling op beperkte netwerken. De frontend onderhoudt een lokale SQLite -cache voor offline activiteitslogging.

Iets soortgelijks architecteren?

Het ontwerpen van real-time, geo-bewuste, sociaal interactieve platforms neemt precisie over gegevensstroom, gebeurtenisafhandeling en mobiele architectuur.

Als u iets ambitieus bouwt-zoals een sociaal fitnessplatform, draagbare integratie of realtime feed-helpen we u graag vanaf het begin te krijgen.

Overwegingen van schaalbaarheid

1. Schalatie van toepassingslaag

- Stateless Services: Alle kerndiensten (activiteit, feed, uitdaging, enz.) Zijn staatloos en horizontaal schaalbaar. Elke instantie is wegwerpbaar en fronted door een load balancer. Gedeelde niets principes zorgen ervoor dat instanties niet afhankelijk zijn van de lokale staat.

- Auto-scaling: K8S-gebaseerde horizontale pod autoscaling (HPA) wordt gebruikt voor services op basis van CPU-, geheugen- en wachtrijdieptestatistieken. Voor latentiegevoelige services (zoals feed of melding) kunnen aangepaste statistieken (bijv. Event Lag) snellere schaal-outs activeren.

- API Gateway Throttling: Klant- en IP-gebaseerde tarieflimieten voorkomen API-overstromingen. Burst-tolerantie wordt ondersteund met behulp van het door Redis gesteund schuifraam of lekkende emmeralgoritmen.

2. Gegevenslaagschaling

Lees optimalisatie: Vaak toegang tot gegevens (bijv. Recente activiteiten, snapshots in het klassement) worden agressief in de cache in Redis met TTLS en LRU -uitzetting in cache. Postgreesql gelezen replica’s worden geschaald op basis van verkeer om analyses en UI -query’s te ontladen.

Sharding -strategieën:

- Activiteitsgegevens: Geschild door gebruikers -ID over partities of logische clusters (bijv. Activity_01, Activity_02, …)

- Items voeden: Gepartitioneerd door acteur -ID en ontvanger -ID met composietindexen voor snelle opzoekingen

- Geostore: Gebruikt S3-sleutel voorvoegsels per regio en tijdstempel voor geoptimaliseerde objectlijst en kostenefficiënte rijen

3. Fan-out van feed en sociale grafiek

Feed Generation is een belangrijke uitdaging voor schaalbaarheid op sociale platforms. Het systeem gebruikt een hybride fan-out aanpak:

- Fan-Out-on-Write (primair): Wanneer een gebruiker een activiteit plaatst, duwt de feed -service deze in vooraf berekende voederrijen voor volgers.

- Fan-Out-on-Read (Fallback): Voor high-fanout-gebruikers (beroemdheden, influencers) worden feeds gebouwd tijdens querytijd met paginering van door Kafka gesteunde gebeurtenislogboeken of feed-indextabellen.

Feedopslag: Geïmplementeerd via schrijf-geoptimaliseerde tabellen of kolom-familieswinkels (bijv. Scylladb of Cassandra-achtige winkels) met TTL’s voor kortstondige gebeurtenissen en vooraf weergegeven JSON voor snelle hydratatie.

4. Uitdaging en leaderboardverwerking

- Batch Compute: Leaderboards worden berekend in batches met behulp van een stream -verwerkingsmotor (bijv. Apache Flink, Spark Streaming). Segmentwedstrijden en uitdagingsvalidaties lopen asynchroon uit activiteiteninnering met behulp van duurzame Kafka -onderwerpen.

- Aggregatie met vensters: Uitdagingsstatistieken zijn vensters (dagelijks, wekelijks) om volledige geschiedenisscans te voorkomen en de opslagdruk te verminderen. Geaggregeerde materiaalweergaven worden geïndexeerd per uitdaging en segment.

5. Geo- en sensorgegevensinname

- Hoogfrequente inname: GPS-punten worden in batches geschreven naar tijdreeksopslag (of S3-bestanden met indexering) en checkpointed om geheugenoverloop te voorkomen. Batching vermindert de schrijfversterking op de DB en versnelt de achterdrukverwerking.

- Compressie: GPS-coördinaten zijn delta-gecodeerd en gzipped vóór opslag. Rehydratatie vindt plaats op kaart render of exporttijd, niet tijdens realtime feedweergave.

6. Verkeer van derden barst

Spikes van Garmin- of Apple-synchronisaties worden geabsorbeerd met behulp van ontkoppelde inname-wachtrijen en snelheidsgestuurde ETL-pijpleidingen. Elke integratie heeft een stroomonderbreker en poging het beleid om stroomopwaarts misbruik of fan-out stormen te voorkomen.

Beveiligingsarchitectuur

1. Authenticatie en autorisatie

- Authenticatie: Alle clientinteracties gebruiken OAuth 2.0 met PKCE voor mobiele stromen. JWT’s worden uitgegeven en ondertekend door de AUTH Service, met gebruikers -ID, reikwijdte en vervaldatum. Vernieuw tokens worden gedraaid en gecodeerd in rust.

- Federated login: Google, Apple en Facebook-aanmeldingen worden ondersteund, maar altijd gekoppeld aan een native gebruikersidentiteit. Sociale inlogtokens worden gevalideerde server-side, niet direct vertrouwd.

- Autorisatie: Elke service valideert het JWT-token en handhaaft regels op scope-niveau (bijv. `Lees: feed`,` post: activiteit ‘). RBAC (rolgebaseerde toegangscontrole) wordt gebruikt voor interne tools (bijv. Admin, moderatorrollen).

2. Gegevensbescherming

- Onbeweeglijk:

- PostgreSQL-, Redis- en objectwinkels worden gecodeerd met behulp van AES-256-codering met klantbeheerde toetsen (CMKS).

- Gevoelige velden (bijv. E -mail, gezondheidsmetrieken) worden gecodeerd in de applicatielaag voordat DB schrijft.

- Onderweg: Alle inter-service en client-to-server verkeer wordt beschermd door TLS 1.2+. Mutual TLS wordt gebruikt voor GRPC -communicatie tussen vertrouwde backend -services.

- Maskering op veldniveau: Gevoelige velden worden gemaskeerd of geredigeerd in stammen en dashboards. Observeerbaarheid Tooling handhaaft veldtagging en geautomatiseerde PII -scanning vóór inname.

- Geo -privacy: Activiteiten gemarkeerd als privé- of “alleen volgers” zijn volledig uitgesloten van feeds, leaderboards en zoekindexen. HeatMap-gegevens zijn alleen geanonimiseerd en bemonsterd uit openbare activiteiten, met geo-flauwvallen in de buurt van thuiszones.

3. IAM Design & Secrets Management

- Geheimen: Alle API -toetsen, DB -referenties en webhook -tokens worden opgeslagen in een gecentraliseerd kluis (bijv. Hashicorp Vault of AWS Secrets Manager) en geïnjecteerd via de omgeving tijdens runtime. Rotatiebeleid is geautomatiseerd voor kortstondige referenties.

- IK BEN: Elke microservice heeft een unieke identiteit en een reeks rollen. Het IAM-beleid wordt onder de aandacht gebracht van de vereiste minimale machtigingen (bijvoorbeeld alleen-lezen toegang tot objectopslag, alleen-schrijftoegang tot Kafka-onderwerpen). CI/CD -agenten nemen tijdelijke rollen aan met behulp van OIDC Trust.

4. Veilige codering- en API -bescherming

- Invoervalidatie: Alle externe invoer is schema-gevalideerd met behulp van OpenAPI- of JSON-schema. Frontend en backend handhaven lengte-, indeling en grenzencontroles.

- Rate beperkende: De limieten van de gebruiker en de per-IP-snelheid worden afgedwongen via Redis- of API-gateway-plug-ins. Misbruikdetectiemodellen (bijv. Loginstorm of spamgedrag) voeden het dynamisch throttlingbeleid.

- Bescherming opnieuw afspelen: Alle ondertekende verzoeken omvatten nonces of tijdstempels. Activiteit uploads en webhooks gebruiken HMAC -handtekeningen om oorsprong te valideren en geknoei te voorkomen.

- Codebeveiliging: Statische analyse (SAST) en afhankelijkheidsscanning zijn geïntegreerd in CI -pijpleidingen. Secrets Detectie (bijv. Gitleaks) blokkeert toevallige blootstelling. Alle kritische stromen gaan door peer-reviewed en gecontroleerde pull-aanvragen.

Uitbreidbaarheid en onderhoudbaarheid

1. Modulaire servicegrenzen

Elk belangrijk domein – gebruikers, activiteiten, feed, meldingen, uitdagingen – is ingekapseld in zijn eigen service, met zijn eigen schema, API en inzetbare runtime. Deze services communiceren asynchroon via berichtwachtrijen of synchroon via GRPC/REST, afhankelijk van de latentiegevoeligheid.

Deze isolatie maakt onafhankelijke schaling, release -cycli en onboarding van nieuwe ingenieurs mogelijk zonder risico op bijkomende schade aan niet -gerelateerde functies. Het verzenden van een nieuw leaderboard -formaat of meldingstrigger raakt bijvoorbeeld niet de activiteit in de activiteit innemen of gebruikersprofielen.

2. Plugin-georiënteerde patronen

- Luisteraars van evenementen: Nieuwe functies (bijvoorbeeld prestaties, live coachingwaarschuwingen of apparaatgebaseerde badges) worden geïntroduceerd door zich te abonneren op kernevenementen zoals zoals

Activity.CreatedofChallenge.completed. Dit maakt innovatie mogelijk zonder stroomopwaartse logica te herschrijven. - Feature vlaggen: Alle gebruikersgerichte functies worden bestuurd door dynamische vlaggen (bijv. LaunchDarkly of Internal Toggle Systems), waardoor canary-uitrol, A/B-testen of geënsceneerde releases mogelijk zijn op basis van regio, gebruikersniveau of platform.

- Aangepaste uitdaging logica: De Challenge Engine is uitbreidbaar via regelmotoren of ingebedde scripting (bijv. Lua of CEL). Dit stelt marketing- of clubmanagers in staat om nieuwe soorten uitdagingen te creëren (bijv. “Klim 2k meters in 3 dagen”) zonder hardcoderende logica in de backend.

3. Schone code en patronen

- Domeingestuurd ontwerp (DDD): Services gebruiken DDD om logica te organiseren door begrensde context – activiteitsaggregatie, segmentscores, volgerbeheer – in plaats van door technische laag. Dit vermindert cross-snutslogica en code-wildgroei.

- Testen en plichten: CI handhaaft strikte steunen, codedekkingsdrempels en contracttests voor alle API’s. Ontwikkelaarssnelheid blijft hoog omdat lokale DEV -opstellingen containers gebruiken met geplaatste databases en mockwachtrijen voor snelle iteratie.

- Monorepo vs polyrepo: Backend is meestal polyrepo (één per service), terwijl de mobiele app mogelijk in een monorepo met modulaire pakketten wonen. Gedeelde protobufs- of GraphQL-schemadefinities zijn versiebehandeld in een afzonderlijke contractrepo.

4. Serviceversie en achterwaartse compatibiliteit

- API -versie: Alle openbare API’s zijn versie (bijv. `/V1/activiteiten ‘). Verouderde eindpunten worden gehandhaafd voor een gedefinieerde zonsondergangperiode, met waarneembaarheid om het gebruik te controleren.

- Schema -evolutie: PostgreSQL-schema’s gebruiken additieve migraties (kolommen toevoegen, niet verwijderen) en hernoem nooit enums of beperkingen zonder dual-lees/schrijven schakels op zijn plaats. Voor NoSQL-winkels is elk object getagd met een schemasversie voor achterwaartse compatibele deserialisatie.

- Protocolcompatibiliteit: GRPC- en ProtobUF -contracten zijn ontworpen om te voorkomen dat het breken van veranderingen – velden worden nooit verwijderd en veld -ID’s worden niet hergebruikt. Voor GraphQL blijven verouderde velden beschikbaar met waarschuwingskoppen en plichten in de frontend.

Denkt u op lange termijn voor uw platform?

Hulp nodig bij het ontwerpen van een modulaire, toekomstbestendige architectuur die niet afbrokkelt onder versiering van de hel of groeimiddelen?

Of u nu een sociale app schaalt of een fitnessplatform uitbreidt, we zijn er om te helpen architect voor de lange termijn.

Prestatie -optimalisatie

1. Tuning voor databasequery

- Query -indexering: Elke kolom met hoge cardinaliteit die wordt gebruikt in filters of joins-zoals `user_id`,` Activity_ID`, `Creat_at`, of` Challenge_ID`-wordt ondersteund door BTree- of Gin-indexen. Composiet -indexen worden gemaakt voor frequente vragen zoals `follower_id + Create_at Desc` in feeds of` user_id + challenge_id` in leaderboard -lookups.

- Gematerialiseerde uitzichten: Dagelijkse rollups (bijv. “Totale afstandsrun deze week”) worden opgeslagen als gematerialiseerde uitzichten en vernieuwd via async -banen. Dit voorkomt repetitieve aggregatiescans en versnelt mobiele dashboardstatistieken.

- Vraag caching: Leaderboards, openbare profielen en statische uitdagingspagina’s gebruiken Redis als een cachinglaag met intelligente TTL’s en expliciete ongeldigheid bij relevante gebeurtenissen.

2. Asynchrone verwerking

- Uitgestelde werklast: Zware taken zoals segment matching, heatmap-generatie, badge-evaluatie en fan-out van volger worden allemaal uitgesteld tot achtergrondmedewerkers die Kafka/Nats-onderwerpen consumeren. Dit houdt het actieve verwervingspad reactief (~ 100–200ms P99).

- Bulk -inname paden: Uploads van Garmin of Apple Health worden parallel gehouden en verwerkt, met deduplicatie en foutisolatie om het blokkeren van volledige apparaatsynchronisatie te voorkomen vanwege enkele corrupte bestanden.

3. Rentebeperkende en misbruikcontroles

- Rate controle: Elk API-eindpunt heeft de tarieflimieten op de tarief op de gebruikersniveau en op de gateway gedwongen. Kostenige bewerkingen (bijv. Postactiviteiten met media) worden verder beperkt via adaptieve throttling om latentie en wachtrijvertraging aan te vragen.

- Misbruikdetectie: Machine-geleerde modellen scoren acties zoals volgen spam, commentaar overstromingen of beledigende geo-posten. Deze zijn gebonden aan realtime filters die automatisch vertragen of sandbox kwaadaardige klanten.

4. Cachinglagen

- Edge Caching: Routekaarten, profielavatars, uitdagingspagina’s en heatmap -tegels worden allemaal geserveerd via CDN -randknooppunten (CloudFlare, snel). Cache -toetsen zijn getagd met versiehashes om snelle globale ongeldigheid mogelijk te maken.

- Client-side caching: De mobiele app maakt gebruik van lokale SQLite voor offline modus, met hydratatie van Delta-Upedated JSON-blobs die zijn ontvangen bij Startup of Post-Login. Dit maakt onmiddellijke voedingsweergave en soepeler koude starts mogelijk.

5. Frontend -prestaties

- Incrementele laden: Feed-scrolls, profielweergaven en uitdagingslijsten implementeren allemaal oneindige scroll of raampaginatie met behulp van cursorgebaseerde tokens. Dit minimaliseert de payloadgrootte en geheugendruk op mobiele clients.

- Afbeeldingoptimalisatie: Alle geüploade afbeeldingen worden gewijzigd, gecomprimeerd en door de formaat geconverteerd (bijv. Webp) door de mediaservice vóór de levering van CDN. Apparaatspecifieke activievarianten worden geselecteerd met behulp van contentonderhandelingsheaders.

- Js bundel & boom schudden: Webclients gebruiken moderne bundlers (bijv. Vite of Webpack 5) met dynamische importsplitsing en schudden met boom. Lazy laden wordt gebruikt voor niet-kritische UI-componenten zoals grafieken, kaarten of analyses.

Teststrategie

1. Soorten testen

- Eenheidstesten: Elke servicelaag heeft uitgebreide eenheidstests voor domeinlogica, invoervalidatie en hulpprogramma’s. Deze zijn snelrennen en geïsoleerd-geen externe afhankelijkheden toegestaan. Mocking bibliotheken (bijv. Gomock, Pytest-Mock, Jest) worden gebruikt om bijwerkingen te isoleren.

- Integratietesten: Belangrijkste service-interacties-zoals het indienen van activiteiten die worden geactiveerd voor het genereren van voederingen of uitdaging voor uitdagingen-worden behandeld met op Docker gebaseerde testomgevingen. Deze tests draaien echte afhankelijkheden (PostgreSQL, Redis, Kafka) en valideren gedrag onder realistische omstandigheden.

- Contract testen: Voor GRPC en REST API’s valideren contracttests (bijvoorbeeld het gebruik van PACT of BUF voor protobuf) dat producent- en consumentendiensten voldoen aan overeengekomen schema’s, met name over serviceversie-hobbels of tijdens parallelle implementaties.

- End-to-end (E2E) testen: Kritieke gebruikersstromen – aanmelden, inloggen, activiteiten volgen, commentaar geven – worden getest met cypress of detox (voor REACT Native). Deze tests worden uitgevoerd op emulators en echte apparaten in CI tegen enscenering omgevingen.

2. CI -testdekkingstrategie

- Handhaving van de codedekking: Minimale drempels worden afgedwongen voor PR’s met behulp van tools zoals Codecov of Sonarquis. Dekkingsgatesblokken samenvoegt als nieuwe code de juiste testcases mist – met name voor servicogogica of gegevenstransformatiefuncties.

- Paralleliseerde CI -pijpleidingen: Tests worden gegroepeerd per service en parallel uitgevoerd via GitHub -acties, Circleci of buildkite. Testmatrix omvat omgevingspermutaties (bijv. Verschillende DB -versies, API -versies).

- Testarmaturen en zaaien: Gedeelde testgegevens worden voorzien via containerized snapshots of declaratieve YAML/JSON -armaturen. Alle services ondersteunen testmodus bootstrapping voor lokale en CI -testomgevingen.

3. Laden en veerkrachttesten

- Laadtests: Locust-, artillerie- of K6-scripts simuleren piekverkeerspatronen-grote ventilator-uit, bulkactiviteit uploads, uitdaging van het leaderboard vernieuwen-om systeemrespons onder stress te testen. Laadtests worden wekelijks uitgevoerd en tijdens grote releases.

- Chaos Engineering: Tools zoals Gremlin of Litmuschaos injecteren mislukkingen bij de service, DB of netwerklaag (bijv. Latentiepieken, gevallen Kafka -partities, DB -failovers). Het doel is om het opnieuw proberen beleid, fallback -logica en het waarschuwen van dekking te valideren.

- Veerkrachtbeesten: Stroomonderbrekers, schotten en time -out fallbacks worden expliciet getest. Canarische implementaties omvatten foutinjectietests voordat de volledige uitrolverbruikt.

DevOps & CI/CD

1. CI/CD -pijplijnoverzicht

Het hele systeem is gebouwd op op GIT gebaseerde workflows (GitHub, Gitlab of Bitbucket) met geautomatiseerde pijpleidingen die zijn geactiveerd op pull-aanvragen, fusies en op tag gebaseerde releases. CI/CD wordt behandeld als een eersteklas product met prestaties, isolatie en zichtbaarheid als kernprincipes.

Pijplijnfasen:

- Bouwen: Containerafbeeldingen worden per service gebouwd met multi-fase dockerfiles. Gemeenschappelijke basisafbeeldingen worden in de cache en hergebruikt. Voor frontend -apps omvatten bouwstappen boomschudden, transpilatie en bundelanalyse.

- Test: Eenheid-, integratie- en contracttests worden uitgevoerd in geïsoleerde banen met artefact -upload (bijv. Dekkingsrapporten, testlogboeken). Mislukte banen zijn geannoteerd inline in PRS voor snelle triage.

- Beveiligingsscan: SAST (bijv. Sonarqube, Snyk) en afhankelijkheidskwetsbaarheidsscans worden afgedwongen voordat artefacten worden gepromoot. Secrets Scanning Tools blokkeren toevallige blootstelling.

- Afbeelding ondertekenen: Containerafbeeldingen worden ondertekend en opgeslagen in een veilig register (bijv. AWS ECR, GCP Artifact Registry) met onveranderlijke tags en herkomstmetadata.

- Staging -implementatie: Getagde builds worden automatisch geïmplementeerd in een stagingcluster. Canarische tests, rooktests en synthetische gezondheidscontroles lopen tegen deze omgeving met korte TTL’s.

- Productiepromotie: Implementaties in PROC worden ofwel handmatig geactiveerd (met goedkeuringspoorten) of automatisch na het doorgeven van QA -voorwaarden. Gitops -tools (bijv. Argocd, flux) passen manifests toe van een versie -repo van de status.

2. Infrastructuur als code (IAC)

- Terraform: Alle infrastructuur – VPC’s, K8S -clusters, DB -instanties, IAM -rollen, wachtrijen – worden beheerd via Terraform -modules. Wijzigingen worden beoordeeld en bekeken met behulp van

Terraform -planin PRS. Drift -detectie loopt elke nacht om handmatige veranderingen te detecteren. - Aanpassen en helmen: K8S -manifesten worden gesjemplateerd via Helm en beheerd over omgevingen met behulp van Kustomize -overlays. Dit maakt het gemakkelijk om replica’s, configs en geheimen per omgeving te negeren.

- Secrets Management: Secrets en config -kaarten worden geïnjecteerd via verzegelde geheimen (bijv. Mozilla SOP’s, Bitnami verzegelde geheimen) of gesynchroniseerd uit kluis met behulp van sidecar -injectoren. Alle geheimen worden regelmatig gedraaid en gecontroleerd.

3. Implementatiestrategie

- Blauwgroene implementaties: Voor kritieke paddiensten zoals AUTH of Activity worden blauwgroene strategieën gebruikt. Het verkeer wordt geleidelijk verschoven met behulp van Ingress -regels, met geautomatiseerde terugdraaien als gezondheidscontroles mislukken.

- Canarische releases: Niet-kritische diensten (bijv. Meldingen, leaderboards) gebruiken canary-uitrol-inzet tot 5%, dan 25%, dan 100%in de loop van de tijd. Metrics (latentie, foutenpercentage, CPU) worden vergeleken met basislijnen voordat ze doorgaan.

- Feature vlaggen: Alle nieuwe codepaden worden bewaakt door functiesschakels. Dit zorgt voor progressieve belichting, donkere lanceringen en instant kill -schakelaars tijdens incidenten.

4. Artefact & milieuhygiëne

- Afbeelding Lifecycle: Oude builds worden automatisch gesnoeid op basis van leeftijd- of SHA -retentiebeleid. Ongebruikte afbeeldingen worden nooit meer dan 30 dagen bewaard, tenzij getagd als LTS- of rollback -versies.

- Voorbeeldomgevingen: Efemere staging omgevingen worden per PR gemaakt met behulp van dynamische naamruimten in Kubernetes. Deze omgevingen bootsen productietopologieën na en worden vernietigd na samenvoegen of PR -close.

- Roldback -mechanisme: Elke implementatie is atomair en versieneringen. Rollbacks kunnen worden geactiveerd via Git Revert, Helm History Rollback of Argocd UI Click – binnen enkele seconden.

Hulp nodig bij het verzenden van sneller zonder dingen te breken?

Wilt u een engineeringpijplijn met hoge snelheid bouwen met kogelvrije terugdraaiingen, gitops-workflows en productiekwaliteit CI/CD?

Of u nu een Microservices -backend schaalt of een nieuwe mobiele functie lanceert, laten we een DevOps -systeem architecteren dat onder druk werkt.

Monitoring en waarneembaarheid

1. Logging

- Gestructureerde houtkap: Elke servicemogs in JSON -indeling met behulp van gestructureerde velden zoals `request_id`,` user_id`, `Activity_ID` en` duration_ms`. Logboeken worden gestreamd via vloeiende bit of fileBeat in een centrale pijplijn (bijv. Elasticsearch, Loki) voor geïndexeerde vraag en analyse.

- Correlatie -ID’s: Elk verzoek genereert een unieke correlatie -ID die zich voortplant over servicegrenzen via headers en logcontext. Dit maakt volledige end-to-end traceerbaarheid mogelijk van mobiele app tot backend wachtrijen naar DB.

- Loghygiëne: PII -maskeerregels worden gehandhaafd op logpijplijnniveau. Secrets, Access Tokens, GPS -coördinaten en ruwe telemetrie worden automatisch uitgesloten of geredigeerd voordat logboeken opslag raken.

2. Metrics

- Systeemstatistieken: CPU, geheugen, schijf en netwerkgebruik worden geëxporteerd vanuit elke knooppunt en pod via Prometheus Exporters. Waarschuwingsdrempels zijn ingesteld op verzadiging, resourcedruk en ongebruikelijke pod -churn.

- Zakelijke statistieken:

- Activiteiten per minuut, voedingsevenementen per seconde

- Challenge Joins, schrijft Leaderboard, segmenterende wedstrijden

- Latentie per eindpunt, 99e percentiel foutenpercentage

- Aangepaste instrumentatie: Services gebruiken Prometheus -clientbibliotheken om tellers, histogrammen en meters te exporteren voor aangepaste logica – zoals “badge -evaluaties verwerkt” of “GPS -punten per upload”.

3. Gedistribueerde tracing

- Traceringssysteem: OpenTelemetrie wordt gebruikt om services met overspanningen voor HTTP/GRPC -oproepen, DB -query’s en async wachtrijafhandeling. Sporen worden geëxporteerd naar backends zoals Jaeger, Honeycomb of Tempo.

- Trace bemonstering: Hoofdgebaseerde bemonstering (met instelbare tarieven) zorgt voor hoogwaardige transacties zoals activiteiten inname of feed-fan-out worden altijd vastgelegd, terwijl achtergrondbanen met lage prioriteit probabilistisch worden bemonsterd.

- Trace Linking: Alle sporen binden terug aan gebruikers -ID’s en vragen metadata, waardoor foutopsporing van individuele activiteiten, insecten van het klassement, of langzame volger van volger met exacte causaliteitsketens mogelijk wordt.

4. Alleer- en dashboards

- Alert Management: Prometheus AlertManager of Opsgenie behandelt deduplicatie, stilte vensters, oproeprotaties en escalatiebeleid. Waarschuwingen zijn onder meer slappe/teams hooks, sms en pagerduty wanneer kritische drempels worden gekruist.

- Dashboards: Grafana-dashboards zijn voorgebouwd per service met drill-down mogelijkheden voor latentie, foutenpercentages, DB-doorvoer, wachtrijen van de wachtrij en externe API-storingen. Zakelijke belanghebbenden krijgen ook KPI -weergaven (bijv. Actieve gebruikers, uitdaging voor uitdagingen).

- SLOS & foutbudgetten: Belangrijke eindpunten (bijv. Activiteitsinzending, feedbelasting, uitdaging van uitdagingen) zijn gebonden aan formele SLO’s met latentie/foutdrempels. Verbrandingspercentages worden berekend om de vlaggaging van functies en uitrolstimulatie te informeren.

5. Probes voor gezondheidscontroles en gereedheid

- Levenzaamheid en gereedheid: Alle services stellen `/healthz` eindpunten bloot voor basis LIVENS (bijv. Draadpoolstatus, geheugen) en gereedheid (bijv. DB -connectiviteit, wachtrijvertraging). Kubernetes gebruikt deze voor autoscaling- en implementatie -orkestratie.

- Diepe controles: Periodieke achtergrondtaken voeren synthetische transacties uit (bijv. Testactiviteitsinvoegen + feed lezen) om de gezondheidsgezondheid van de bedrijfslogica te valideren – niet alleen de uptime van het systeem.

Afwegingen en ontwerpbeslissingen

1. Fan-out-on-Write vs. Fan-Out-on-Read

- Beslissing: Een hybride model werd gekozen. Voor gemiddelde gebruikers maakt het systeem gebruik van fan-out-on-schrijven om feeds vooraf te vervullen. Voor high-fanout-gebruikers (bijv. Beïnvloeders) schakelt het over naar fan-out-op-read.

- Waarom: Precomputerende feed -vermeldingen minimaliseert de latentie en ontlaadt het leespad, maar het is duur wanneer een gebruiker duizenden volgers heeft. Het hybride ontwerp optimaliseert voor het geval van 95% en tegelijkertijd de infrastructuur beschermt tegen fan-out stormen.

- Afweging: Meer operationele complexiteit. Het systeem moet dynamisch schrijft/leest door verschillende codepaden op basis van het aantal gebruikers of volgers. Verhoogt ook het testoppervlak.

2. Polyglot persistentie

- Beslissing: PostgreSQL, Redis, Kafka en S3 werden gekozen als de kernstapel. Optioneel gebruik van NEO4J voor sociale grafiek Traversal werd uitgesteld.

- Waarom: Deze tools komen goed overeen met de toegangspatronen: PostgreSQL voor integriteit, Redis voor toegang tot lage latentie, KAFKA voor gebeurtenisgestuurde schaal en S3 voor Blob-opslag. Een gespecialiseerde grafiek vermijden DB vereenvoudigde ops en onboarding.

- Afweging: Sommige grafiekquery’s (bijv. “Wederzijdse volgers in een club”) zijn minder efficiënt zonder een speciale grafische motor. Op redis gebaseerde caching vermindert dit maar voegt de cache-coherentiecomplexiteit toe.

3. Real-time GPS-synchronisatie vs. upload na de training

- Beslissing: Upload na de workout is de standaardinstelling; Real-time synchronisatie is optioneel en opt-in (bijvoorbeeld voor live tracking of virtuele races).

- Waarom: Real-time GPS-streaming creëert een constante backend-belasting, introduceert consistentie-uitdagingen voor gedeeltelijke activiteiten en verhoogt de stroomafvoer op mobiele apparaten. Voor de meeste gebruikers is batch -upload voldoende.

- Afweging: Verminderde mogelijkheid om functies aan te putten, zoals live gejuich, pacer-matching of in-progress leaderboard-updates. Toekomstige versies kunnen realtime ondersteuning achter de vlaggen van functies uitbreiden.

4. Microservices vs. Monolith

- Beslissing: Microservices werden vroeg gekozen, met duidelijke domeingrenzen: activiteit, feed, gebruiker, uitdaging, media, enz.

- Waarom: Maakt onafhankelijke schaal, parallelle ontwikkeling en domeinspecifiek eigendom mogelijk. Inname van voer en activiteit hebben wild verschillende prestatieprofielen – het scheiden ervan maakt gerichte optimalisatie mogelijk.

- Afweging: Vereist robuuste tooling: service -ontdekking, tracering, CI/CD -isolatie en volwassenheid van platformtechniek. Voor kleine teams voegt dit de complexiteit vooraf, maar langdurige behendigheid weegt zwaarder dan de pijn op korte termijn.

5. Gebeurtenisgestuurde versus synchrone workflows

- Beslissing: Alle niet-kritische paden (feed-fan-out, updates van het klassement, meldingen) zijn async via Kafka/Nats. Alleen auth- en gebruikersgerichte query’s gebruiken verzoek/antwoordstromen.

- Waarom: Async -systemen schalen beter en ontkoppelen workflows. Ze staan ook batching, petries en wachtrijprioritering toe-essentieel voor variabele inname-patronen zoals externe synchronisatie of daagpieken.

- Afweging: Eventuele consistentie en debuggen complexiteit. Vereist DLQ’s (dode-lettere wachtrijen), herhalingen van gebeurtenissen en zorgvuldige deduplicatielogica. Monitoring en waarneembaarheid zijn hier de sleutel tot veiligheid.

Architecturale schuld en mitigaties

- Sommige oudere feedpaden gaan er nog steeds van uit dat synchroon schrijft-worden gerefacteerd in op Kafka gebaseerde fan-out services.

- Initiële Challenge -motor had hardgecodeerde regels – vervangen door een regelmotor voor flexibiliteit.

- Toestemmingslogica verspreid over diensten – gecentraliseerd in een toegangsbeleidsdienst om de consistentie af te dwingen.

Belangrijkste afhaalrestaurants en gebieden om te verbeteren

1. Wat deze architectuur goed doet

- Schaalbaarheid door ontwerp: Stateless Services, Event-Driven Processing en Sharded-databases houden het systeem zelfs responsief bij miljoenen gebruikers en hoge innamespercentages.

- Modulaire grenzen: Duidelijke scheiding tussen activiteit, sociale, media en analyse -logica maakt gerichte optimalisatie en veilige, parallelle ontwikkeling mogelijk.

- ASYNC Eerst: Ontkoppelende voedingsgeneratie, uitdagingscores en meldingen van het kernin inname -pad levert prestaties en foutisolatie waar het toe doet.

- Beveiliging en privacy: Fijnkorrelige toegangscontroles, gecodeerde opslag en strikte waarneembaarheidspraktijken komen overeen met GDPR-niveau dataverantwoordelijkheid.

- Ontwikkelaarsnelheid: CI/CD -pijpleidingen, vlaggen van functies en contracttests ondersteunen snel, veilige iteratie – zonder de productiestabiliteit in gevaar te brengen.

2. Kansen voor verbetering

- Dynamische grafiekquery’s: Het gebruik van Redis versus speciaal gebouwde grafiek DBS (bijv. Dgraph, Nebula) opnieuw evalueren voor de detectie van wederzijdse volger of geavanceerde clubfuncties.

- Unified Access Control: Centralisatie van alle toestemmingcontroles in een beleidsdienst (OPA of Custom) om duplicatie te voorkomen en over te drijven over diensten.

- Live -functies: Uitbreiding van realtime mogelijkheden (bijv. Live segmenten, pacers, groepsruns) met betrouwbare streamingprotocollen en gecontroleerde uitrol.

- Mobiele offline synchronisatie: Verbetering van offline-first UX voor gebruikers in plattelandsgebieden of tijdens lange buitenactiviteiten met betere strategieën voor conflictoplossing.

- Geavanceerde analyses: Gedwedste atleetinzichten bouwen pijpleidingen (bijv. Vo2 Max-schatting, trainingsbelasting) met behulp van vooraf geaggregeerde data-meren en ML-modellen.

Dit platformontwerp brengt prestaties, flexibiliteit en gebruikerservaring in een veeleisende sociale + fitnesscontext in evenwicht. Het is klaar voor productie, gevecht getest en gebouwd voor groei-maar met ruimte om te evolueren naar een intelligenter, realtime en gepersonaliseerd fitnessecosysteem.

Iets zo ambitieus bouwen?

Het ontwerpen van schaalbare, veilige en sociaal boeiende platforms gaat niet alleen over het kiezen van de juiste stapel – het gaat erom de juiste beslissingen op het juiste moment te nemen.

Of u nu een fitness -app lanceert, de gebruikersbetrokkenheid verbetert of uw backend moderniseert, wij zijn klaar om u te helpen deze met vertrouwen te architecteren.

Mensen vragen ook (veelgestelde vragen)

Hoe een Fitness Tracker -app te ontwikkelen?

Begin met het definiëren van de kernfuncties: GPS -activiteiten volgen, inname van gezondheidsgegevens (hartslag, stappen), gebruikersprofielen en offline logboekregistratie. Vanaf daar ontwerpen een mobiel-eerste ervaring met behulp van React Native of Swift/Kotlin, implementeer Secure User Authentication (OAuth2) en maak verbinding met een backend die sensorgegevens in realtime kunnen innemen, verwerken en analyseren. Cloud-native infrastructuur, schaalbare datavoeringen en gebeurtenisgestuurde verwerking zijn van cruciaal belang om de prestaties en reactievermogen strak te houden.

Hoeveel kost het om een fitness -app te bouwen?

Het hangt af van de reikwijdte, maar een fitness-app voor productiekwaliteit met GPS-tracking, gebruikersauth, realtime synchronisatie, cloudopslag en sociale functies zullen meestal tussen $ 50k tot $ 500K+ om te bouwen en te lanceren. Dat omvat UI/UX, mobiele ontwikkeling, backend -architectuur, DevOps en QA. Kostenschaal op basis van complexiteit – live tracking, sociale grafieken, integraties en analyses verhogen allemaal de technische inspanningen.

Hoe maak je een Strava -app?

Om een Strava-achtige app te bouwen, hebt u een mobiele client nodig voor GPS-gebaseerde activiteitenopname, een backend voor het opslaan en analyseren van gebruikerstrainingen en een sociale grafieklaag voor feeds, volgt en interacties. Kerncomponenten omvatten een realtime locatiepijplijn, een schaalbare voedingsservice en een event-gedreven motor voor uitdagingen en leaderboards. Architecting voor schaalbaarheid, lage latentie en modulaire servicegrenzen is essentieel.

Hoeveel kost het om een app te bouwen zoals Strava?

Een volledig geveadigd Strava-stijl platform kan gemakkelijk overtreffen $ 500k tot $ 1 miljoen+ in ontwikkelingskosten, afhankelijk van uw functieset, teamstructuur en time-to-market. Kosten zijn onder meer mobiele en backend-ontwikkeling, cloudinfrastructuur, prestatie-optimalisatie en ondersteuning voor dingen zoals media-uploads, privacy-instellingen en apparaatintegraties van derden.

Welke database gebruikt Strava?

Strava heeft hun volledige stapel niet publiekelijk gedetailleerd gedetailleerd, maar op basis van patronen die gemeenschappelijk zijn voor systemen van vergelijkbare schaal, gebruiken ze waarschijnlijk een mix van relationele databases (bijv. PostgreSQL), gedistribueerde gegevenswinkels voor telemetrie (bijv. Cassandra of tijd-serie DBS) en Redis-like systemen voor caching. Hun architectuur is gebaseerd op evenementen en op microservices, waarbij cloudinfrastructuur miljoenen activiteiten per dag afhandelt.

Waarom is Strava zo populair?

Strava heeft de mix van fitness volgen en sociale engagement genageld. Het gaat niet alleen om het opnemen van runs – het gaat erom ze te delen, te concurreren op segmenten, badges te verdienen en met een gemeenschap te communiceren. De sociale feed, gamification-functies en het uitdagen van ecosysteem maken het platform plakkerig en gewoonlijk, wat zowel retentie als viraliteit aandrijft.

Is een fitness -app winstgevend?

Ja – indien goed uitgevoerd. Op abonnement gebaseerde fitness-apps (zoals Strava Premium, MyFitnessPal, etc.) zijn zeer winstgevend gebleken. Opbrengsten kunnen afkomstig zijn van premium analyses, coachingtools, merkuitdagingen of uitrustingsmarktplaatsen. Maar de winstgevendheid vereist een sterke retentiestrategie, infrastructuurefficiëntie en gebruikersgroei die verder gaat dan MVP.

Hoe kan ik inkomsten met mijn fitness -app?

Gemeenschappelijke strategieën voor het genereren van inkomsten omvatten: freemium-abonnementen (bijv. Ontgrendel diepere analyses of coaching), in-app aankopen (bijv. Trainingsplannen), merkpartnerschappen (bijv. Gesponsorde uitdagingen) en gelieerde marktplaatsen (bijv. Schoenen, wearables). Advertenties zijn mogelijk maar degraderen de gebruikerservaring vaak af. Focus op gebruik van gebruikersvertrouwen en langetermijnwaarde bij het ontwerpen van inkomstenpaden.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.