Alors que nous progressons vers le monde technologique moderne, l’automatisation des processus Développement de l’intelligence artificielle et Développement d’apprentissage automatique est devenu l’épine dorsale de diverses industries car elle promet l’efficacité, la vitesse et la rentabilité. D’un autre côté, le biais d’automatisation est devenu une préoccupation importante. Cela devrait être une préoccupation car, alors que les entreprises et les organisations continuent d’adopter l’automatisation des processus, beaucoup ne sont pas au courant des conséquences potentielles que ces systèmes automatisés peuvent avoir sur l’équité et l’égalité.

Bien que l’automatisation apporte l’efficacité et la commodité, il peut également introduire des biais subtils mais puissants qui perpétuent la discrimination et les inégalités. Comprendre la dynamique du biais d’automatisation est crucial pour résoudre ces problèmes et créer des systèmes qui favorisent l’équité pour tous.

Vous voulez découvrir comment créer des systèmes automatisés impartiaux avec une IA éthique?

Qu’est-ce que le biais d’automatisation?

Le biais d’automatisation fait référence à la tendance des humains à exercer trop sur les systèmes automatisés, en supposant que leurs décisions sont correctes sans les remettre en question. Dans un monde où les machines sont souvent considérées comme infaillibles, cette confiance peut entraîner des conséquences nocives.

Dans la pratique, le biais d’automatisation signifie que les humains peuvent ignorer leurs propres jugements et s’appuyer sur les décisions prises par un système automatisé, même lorsque ces systèmes sont défectueux ou biaisés. Par exemple, dans les processus d’embauche, de nombreuses entreprises comptent de plus en plus sur des systèmes automatisés pour filtrer les CV ou évaluer les candidats. Ces systèmes, bien que efficaces, peuvent perpétuer les biais s’ils sont formés sur des données biaisées.

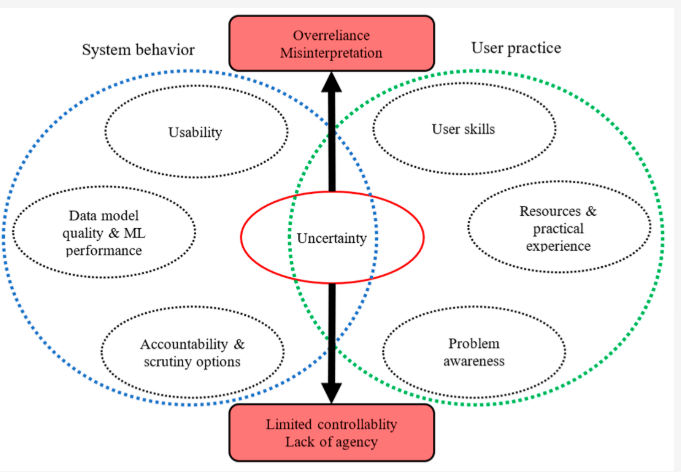

Source: MDPI sur la déclaration de ML avancée et d’exploration de données

En conséquence, les candidats de groupes sous-représentés peuvent être injustement projetés, même si leurs qualifications sont égales ou supérieures aux autres. Ceci est un exemple clair de la façon dont le biais d’automatisation peut contribuer directement à l’inégalité.

Comment l’automatisation des processus peut amplifier la discrimination

Alors que Automatisation des processus Peut rationaliser les opérations et améliorer l’efficacité, il peut également amplifier le biais algorithmique s’il n’est pas soigneusement géré. Le biais algorithmique fait référence au favoritisme systématique ou à la discrimination inhérente aux systèmes automatisés. Si les données utilisées pour entraîner ces algorithmes contient des biais – tels que le sexe, la race ou les biais socio-économiques – le système automatisé héritera probablement et même amplifier ces biais.

Les implications du biais d’automatisation sont d’une grande portée et peuvent avoir de graves conséquences pour les individus et la société dans son ensemble. Cela peut conduire à:

- Opportunités réduites: Les algorithmes biaisés peuvent limiter l’accès à l’emploi, à l’éducation et aux services financiers pour certains groupes.

- Renforcement des stéréotypes: Les systèmes automatisés qui perpétuent les stéréotypes peuvent marginaliser davantage les communautés déjà défavorisées.

- Érosion de la confiance: Alors que les gens prennent conscience du potentiel de biais dans les systèmes automatisés, cela peut entraîner une perte de confiance dans les institutions et la technologie.

Considérez comment l’IA et les inégalités se croisent dans les scénarios du monde réel. Dans le système de justice pénale, des algorithmes prédictifs sont utilisés pour évaluer la probabilité de récidive. Cependant, si les données sur lesquelles ces algorithmes s’appuient reflète des biais historiques, tels que des taux d’arrestation disproportionnellement plus élevés dans certaines communautés, le biais d’IA dans ces systèmes peut entraîner des résultats injustes, tels que des phrases plus longues pour les minorités. Ceci est un exemple brutal de la façon dont les biais d’automatisation peuvent perpétuer les inégalités sociétales.

De même, dans les soins de santé, l’automatisation des processus peut avoir des conséquences imprévues. Si un algorithme est formé sur des données qui sur-représentent certaines données démographiques tout en sous-représentant d’autres, le système peut faire des prédictions ou des recommandations inexactes. Cela pourrait entraîner des écarts dans les soins médicaux, avec des groupes marginalisés recevant un traitement inférieur ou ne pas être diagnostiqué en temps opportun.

Certains cas connus de biais d’algorithmes d’IA

il est vrai que le fait de s’appuyer uniquement sur l’IA peut parfois conduire à des résultats injustes. Voici Un rapport publié par le Greenlining Institute qui présente quelques exemples de la façon dont les algorithmes ont été biaisés dans différentes situations:

Programmes gouvernementaux:

- Système de chômage du Michigan: Le Michigan a utilisé un algorithme pour détecter la fraude dans les demandes de chômage. Malheureusement, le système a accusé à tort des milliers de personnes, entraînant des amendes, des faillites et même des saisies. Il s’est avéré que l’algorithme a souvent fait des erreurs et il n’y avait personne pour vérifier ses décisions.

- Arkansas Medicaid: Un algorithme a été utilisé pour déterminer qui est qualifié pour les avantages de Medicaid en Arkansas. Cela a fait que de nombreuses personnes perdent accès aux soins médicaux essentiels. Le problème? L’algorithme avait des erreurs et il était très difficile pour les gens de faire appel de ses décisions.

Emploi:

- L’outil d’embauche d’Amazon: Amazon a essayé de créer un algorithme pour les aider à embaucher les meilleurs employés. Cependant, l’algorithme a fini par favoriser les hommes aux femmes. Il semble que l’algorithme appris des données d’embauche passées, qui peuvent avoir contenu des biais.

Santé:

- Traitement inégal: Même lorsque les algorithmes sont conçus pour être justes, ils peuvent être utilisés de manière à créer un biais. Par exemple, un hôpital a utilisé un algorithme pour décider quels patients avaient besoin de soins supplémentaires. Malheureusement, la façon dont ils les utilisaient signifiait que les patients noirs devaient être beaucoup plus malades que les patients blancs pour recevoir le même niveau d’attention.

Éducation:

- Biais de notation au Royaume-Uni: Pendant la pandémie, les écoles du Royaume-Uni ont utilisé un algorithme pour donner aux élèves les notes lorsque les examens ont été annulés. Cependant, l’algorithme a fini par donner des notes inférieures aux élèves des familles à faible revenu, montrant comment les algorithmes peuvent parfois renforcer les inégalités existantes.

Logement:

- Prix injuste: De nombreux propriétaires utilisent des algorithmes pour filtrer les locataires potentiels. Un tel algorithme a empêché injustement une mère de louer un appartement parce que son fils avait une infraction mineure sur son dossier qui a ensuite été rejeté.

- Désinvestissement à Détroit: Un algorithme a été utilisé à Détroit pour décider quels quartiers devraient recevoir des investissements et des améliorations. Cela a entraîné la priorité de quartiers noirs et pauvres, montrant comment les algorithmes peuvent aggraver les problèmes sociaux existants.

Ces exemples montrent que si les algorithmes peuvent être des outils puissants, ils doivent être soigneusement conçus et utilisés de manière responsable pour éviter l’injustice et la discrimination. Nous devons nous assurer que les algorithmes sont utilisés pour promouvoir l’équité et l’égalité, et non perpétuer les biais existants.

Aborder le biais d’automatisation et le biais algorithmique

La lutte contre le biais d’automatisation et son potentiel à perpétuer le biais algorithmique nécessite une approche à multiples facettes. Premièrement, il est essentiel de garantir que les données utilisées pour former des algorithmes sont diverses et représentatives de tous les groupes démographiques. Sans données diverses, les algorithmes risquent de renforcer les biais existants plutôt que de les résoudre.

Deuxièmement, la transparence et la responsabilité doivent être intégrées dans l’IA et les systèmes d’automatisation. Les développeurs doivent être clairs sur le fonctionnement de ces systèmes et être ouvert à l’examen. Des audits réguliers des algorithmes peuvent aider à identifier les domaines où les biais peuvent être présents, et des mesures correctives peuvent être mises en œuvre avant que ces biais aient des effets nocifs.

Enfin, l’IA et les inégalités peuvent être minimisées en favorisant l’équité et l’inclusivité tout au long des phases de conception et de déploiement. En intégrant les pratiques d’IA éthiques, les entreprises peuvent s’assurer que leurs solutions d’automatisation des processus sont non seulement efficaces mais aussi justes et équitables.

Identifiez et abordez le biais d’automatisation dans vos processus avec nos conseils d’experts

Le rôle de WeblineIndia dans la lutte contre les biais d’automatisation

Pour les entreprises qui cherchent à exploiter le pouvoir de l’automatisation des processus tout en garantissant l’équité, la transparence et la responsabilité éthique, WeblineIndia se distingue comme un partenaire de confiance avec son Modèle de relevé de l’externalisation. En tant qu’experts dans l’intégration de la technologie de pointe aux considérations éthiques, WeblineIndia excelle dans la relevé des défis du biais d’automatisation. Ils s’engagent à créer des solutions axées sur l’IA qui minimisent les biais algorithmiques et favorisent l’IA et la conscience des inégalités.

L’approche de WeblineIndia est unique en ce qu’elle équilibre les avantages de l’automatisation en mettant l’accent sur l’éthique des algorithmes, garantissant que la technologie est utilisée de manière responsable et ne perpétue pas la discrimination. Qu’il s’agisse de développer un logiciel personnalisé, la mise en œuvre Solutions d’automatisation de processus ou conseiller sur les stratégies d’atténuation des biais de l’IA, l’équipe de WeblineIndia privilégie la qualité, l’équité et la responsabilité sociale.

Prêt à créer des solutions logicielles impartiales alimentées par l’IA?

Choisissez WeblineIndia et nous pouvons être assurés que vous vous associez à un fournisseur de services qui comprend non seulement les subtilités techniques de l’IA, mais privilégie également les considérations éthiques. Ensemble, nous pouvons construire un avenir où la technologie fonctionne pour tout le monde, pas contre eux.

En conclusion, bien que l’automatisation des processus offre un immense potentiel, il est crucial d’être conscient des risques posés par les biais d’automatisation dont WeblineIndia s’occupe. Nous pouvons nous assurer que l’IA et les systèmes d’automatisation sont des outils pour le bien, favorisant l’équité, l’inclusivité et l’égalité dans tous les domaines de la vie en comprenant comment fonctionne le biais algorithmique et en prenant des mesures pour y remédier. Contactez-nous Et nous vous aidons à naviguer dans ce défi, créant des solutions qui respectent les normes les plus élevées de responsabilité éthique.

Hashtags sociaux

#AutoMationBias #Ethicalai #biasIntech #StopalgorithMicDiscrimination #AI #AutoMation #aiAutoMation #Softwaresolutions

Vous voulez créer des solutions inclusives et équitables axées sur l’IA pour votre entreprise?

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.