Les applications de suivi de fitness ont évolué bien au-delà des simples compteurs d’étape ou des journaux d’activité basés sur GPS. Les utilisateurs d’aujourd’hui s’attendent à une riche interactivité sociale, à une gamification compétitive, à une synchronisation des données en temps réel et à une intégration transparente avec un écosystème croissant de portables et de plateformes de santé. Strava a établi une référence dans cet espace en fusionnant le suivi des activités sportives avec l’engagement social – classements, défis, commentaires, clubs et même des courses virtuelles – le tout enveloppé dans une UX lisse qui priorise à la fois les performances et la communauté.

La conception d’un système comme celle-ci va bien au-delà des opérations CRUD de base sur les entraînements des utilisateurs. Il exige une architecture robuste qui peut gérer:

- Mises à jour de géo-localisation à haute fréquence de millions d’utilisateurs simultanés

- Génération des aliments en temps réel et diffusion d’activités aux réseaux suiveurs

- Requêtes de graphe social évolutives et à faible latence

- Stockage et récupération des médias (par exemple, cartes d’itinéraire, photos, badges)

- Pipelines de données motivées pour les événements pour calculer les segments, les classements et les défis

- Contrôles de sécurité et de confidentialité à travers des préférences de partage de données complexes

Le défi consiste à architer un backend qui prend en charge une expérience rapide, engageante et socialement riche, tout en restant suffisamment flexible pour s’intégrer à des dispositifs de fitness tiers, soutenir la modération communautaire et évoluer de nouvelles fonctionnalités sans casser les anciennes.

Cette plongée profonde technique décompose l’architecture d’un tel système. Il décrit les exigences de base, les conceptions de l’évolutivité et de la réactivité en temps réel, les modèles de données pour le contenu généré par les utilisateurs et les modèles d’infrastructure pour prendre en charge une plate-forme de fitness sociale qui peut atteindre des millions d’utilisateurs sans dégrader les performances ni la fiabilité.

Exigences du système

1. Exigences fonctionnelles

Les fonctionnalités principales de l’application de fitness doivent prendre en charge le suivi des activités et l’engagement social à grande échelle. Les exigences fonctionnelles clés comprennent:

- Gestion des utilisateurs: Inscription, authentification, édition de profil et récupération des comptes.

- Enregistrement d’activité: Log sur les entraînements basés sur GPS (par exemple, les courses, les manèges), l’entrée manuelle de support et la capture de métadonnées, la distance, le rythme, l’élévation, la fréquence cardiaque et l’équipement utilisés.

- Synchronisation des données en temps réel: Données d’emplacement et de capteurs de flux à partir d’appareils mobiles ou portables à faible latence.

- Graphique social: Suivez / désabonnez les mécanismes, les suggestions d’amis et la visibilité des activités contrôlées par la vie privée (par exemple, privé, abonnés uniquement, public).

- Alimentation d’activité: Dynamic Timeline montrant les séances d’entraînement des utilisateurs suivis, y compris les goûts, les commentaires et les reprises.

- Défis et classements: Créez des compétitions à cases de temps (par exemple, «Ride 100 km en 7 jours»), parcourir les leaders du segment et calculer les classements de manière asynchrone.

- Support médiatique: Téléchargez et affichez des photos, achemine les cartes thermiques et les réalisations personnelles (par exemple, les badges, les jalons).

- Notifications: Notifications de poussée et de push en temps réel pour les likes, les commentaires, les nouveaux abonnés et les mises à jour de défi.

- Intégration du tiers: Synchronisez avec Apple Health, Google Fit, Garmin et d’autres écosystèmes de fitness.

2. Exigences non fonctionnelles

Pour prendre en charge l’interaction en temps réel et les bases d’utilisateurs en croissance, le système doit répondre aux exigences non fonctionnelles strictes:

- Évolutivité: Les services et les magasins de données évolutifs horizontalement pour gérer des millions d’utilisateurs actifs et les téraoctets de données géo-temporelles.

- Faible latence: Temps de réponse inférieur à la seconde pour les interactions sociales et le rendu de carte en temps réel.

- Disponibilité: 99,9% + du temps de disponibilité avec tolérance aux défauts entre les régions et les zones.

- Sécurité et confidentialité: Authentification basée sur OAuth2, contrôle d’accès granulaire, stockage crypté et paramètres de partage contrôlés par l’utilisateur.

- Extensibilité: Limites de service modulaires pour soutenir les fonctionnalités futures telles que les courses virtuelles, les chats basés sur des clubs ou le coaching en direct.

- Cohérence des données: La cohérence éventuelle est acceptable dans les flux et les classements, mais une forte cohérence est requise pour les transactions telles que les paramètres de compte ou les achats premium.

- Support hors ligne: Permettez aux utilisateurs d’enregistrer et de filer des activités lorsqu’ils sont hors ligne, avec une synchronisation automatique lors de la reconnexion.

3. Contraintes et hypothèses

- Les applications mobiles (iOS et Android) seront les principaux clients; L’interface Web est secondaire.

- Les données de localisation et de santé doivent être traitées dans le cadre des réglementations régionales de conformité (par exemple, RGPD, HIPAA, le cas échéant).

- La majorité des utilisateurs synchroniseront 1 à 2 activités par jour, mais les utilisateurs de puissance et les intégrations peuvent augmenter les taux d’ingestion pendant les événements ou les périodes de défi.

- Déploiement natif du cloud; L’architecture suppose l’utilisation de services cloud gérés pour le calcul, le stockage et le streaming.

Cas d’utilisation / scénario

1. Contexte commercial

L’application de fitness cible un large groupe démographique – des marcheurs occasionnels aux cyclistes compétitifs – mais met l’accent sur l’engagement communautaire sur le suivi individuel. Considérez-le comme un hybride entre un entraîneur personnel et un réseau social. L’objectif est de stimuler l’utilisation récurrente par la concurrence, la responsabilité sociale et les progrès gamifiés, augmentant finalement la rétention et la conversion d’abonnement. La monétisation intégrée peut inclure:

- Abonnements premium pour l’analyse avancée, les segments en direct et les informations de formation plus profondes

- Défis de marque ou concours parrainés

- Promotion de l’équipement dans l’application (par exemple, marché d’affiliation pour les chaussures, les vélos, les appareils portables)

L’application doit donc permettre une base robuste pour des mesures de performance en temps réel tout en offrant des expériences engageantes et socialement dynamiques auxquelles les utilisateurs reviennent quotidiennement – même s’ils ne s’entraînent pas ce jour-là.

2. Personnes et modèles d’utilisation

- Athlètes solo: Les utilisateurs qui suivent leurs entraînements, comparent les performances passées et se joignent parfois à des défis ou des segments mondiaux.

- Antactifs sociaux: Les utilisateurs très engagés qui publient fréquemment, commentent les activités des amis et prospèrent sur l’interaction communautaire.

- Managers de club: Les utilisateurs d’énergie qui coordonnent les événements de groupe, gèrent des classements privés et modéré les espaces sociaux dans les clubs.

- Nerds de données: Les abonnés premium intéressés par les zones de fréquence cardiaque, les courbes de puissance, les mesures de récupération et l’exportation de données.

3. Échelle attendue

Le système doit être conçu pour soutenir:

- 10m + utilisateurs enregistrés

- 2–3m MAUS (utilisateurs actifs mensuels), avec ~ 500k Daus (utilisateurs actifs quotidiens)

- 10m + téléchargement d’activité par mois, avec des pics le week-end et des événements de défi majeur

- 500k + utilisateurs simultanés pendant les périodes de pointe

- Des milliards de points de données par mois dans tous les GPS, l’élévation, la fréquence cardiaque et les capteurs de mouvement

- Des millions de requêtes de flux quotidiennes, d’interactions sociales et de notifications en temps réel

Pour répondre à ces demandes, l’architecture doit optimiser pour les charges de travail social lourdes en lecture, ingérer le trafic d’éclatement des téléchargements d’activités et un traitement asynchrone à haut débit pour la correspondance des segments et les mises à jour de classement.

Besoin d’aide pour concevoir votre propre fitness ou votre application sociale?

Construire une plate-forme de fitness d’abord social qui évolue vers des millions d’utilisateurs prend plus que du code propre – il faut la bonne architecture du premier jour.

Vous voulez des conseils d’experts sur la conception pour les performances, la synchronisation en temps réel et l’engagement des utilisateurs à grande échelle?

Architecture de haut niveau

L’architecture doit soutenir efficacement l’ingestion d’activité en temps réel, la distribution des aliments sociaux, l’analyse géospatiale et l’interaction des utilisateurs – tous à grande échelle. Cela exige une approche modulaire orientée services avec des limites bien définies entre les systèmes de base comme le suivi des activités, la gestion des utilisateurs, le traitement des graphiques sociaux et la livraison de notification.

1. Présentation des composants

Le système est structuré autour des principaux composants suivants:

- Passerelle API: Point d’entrée central pour toutes les communications du client. Gère l’authentification, la limitation des taux et achemine le trafic vers les services internes.

- Service AUTH: Gère les flux OAuth2, l’émission de jetons, la gestion de session et l’intégration avec des fournisseurs d’identité tiers (par exemple, Apple, Google).

- Service de profil utilisateur: Stocke les informations personnelles, les préférences, les équipements et les paramètres de confidentialité.

- Service d’activité: Gère l’ingestion d’entraînement basée sur le GPS, l’analyse de l’itinéraire, la validation de l’activité et l’extraction des métadonnées (par exemple, rythme, gain d’altitude).

- Service d’alimentation: Génére et stocke les flux d’activité, traite les mises à jour des graphiques sociaux et gère le fan-out pour les nouveaux messages d’activité.

- Service de graphique social: Gère les relations avec les suiveurs et calcule la visibilité des activités et des défis.

- Défi moteur de défi et de classement: Calculez les classements, gère la logique de défi et met à jour les trophées et segments virtuels.

- Service multimédia: Gère les téléchargements d’images (photos, cartes d’itinéraire), la mise en cache CDN et le contrôle d’accès.

- Service de notification: Publie des notifications en temps réel et lots via les boîtes Websockets, les boîtes de réception FCM / APNS ou dans l’application.

- Pipeline d’analyse: Traite les flux d’activité pour les informations, la détection des tendances et les recommandations des athlètes.

- Portail administrateur et modération: Outils pour gérer les rapports d’abus, la création de défis et les tableaux de bord analytiques.

2. Diagramme d’architecture de haut niveau

+-------------------------+

| Mobile / Web |

+-----------+-------------+

|

[ API Gateway ]

|

+------------+-----------+-----------+------------+

| | | |

[ Auth Service ] [ User Profile ] [ Activity Service ] |

|

[ Social Graph Service ]

|

+----------+----------+

| |

[ Feed Generator ] [ Media Service ]

| |

[ Notification Service ] |

| |

[ Challenge & Leaderboard Engine ] |

| |

[ Analytics / Data Pipeline ]

3. Résumé du flux de données

Lorsqu’un utilisateur démarre un entraînement:

- L’application mobile diffuse des données GPS et des capteurs via un téléchargement d’API WebSocket ou lot Service d’activité.

- Le service analyse les données, stocke l’entraînement et émet un événement à la Générateur d’alimentation.

- Le Service de graphique social détermine qui peut voir l’activité.

- L’élément de flux est stocké et poussé vers les utilisateurs concernés via le Service de notification.

- Le cas échéant, l’activité est évaluée par le Classeur Pour l’éligibilité des défis et les mises à jour de classement.

- Des photos et des visualisations d’itinéraire sont envoyées au Service multimédia et mis en cache à travers un CDN.

Cette conception modulaire prend en charge à la fois l’échelle horizontale et l’évolution de service isolée. Il permet également un fan-out en temps réel pour les flux et les notifications en utilisant la communication axée sur les événements (par exemple, Kafka ou Nats).

Conception de la base de données

1. Modèles de données de base et aperçu ERD

Le système utilise une approche de persistance polyglot – bases de données relationnelles pour l’intégrité transactionnelle, les séries chronologiques / nosql pour les données d’activité et les magasins graphiques ou en mémoire pour les requêtes sociales haute performance.

Entités primaires:

- Utilisateur: Informations sur le profil, paramètres AUTH, préférences, niveau d’abonnement

- Activité: Données d’entraînement, y compris les points GPS, les métriques, l’équipement, les médias

- Suivre: Règles de relation et de visibilité de suivi des suiveurs

- Se nourrir: Événements rendus liés aux utilisateurs (par exemple, activité publiée, commentaire, badge)

- Défi: Métadonnées et état pour les compétitions de groupe

- Classeur: Position et métriques de défi ou de segment

Diagramme de la relation d’entité (conceptuel):

[Utilisateur] ├── id (PK) ├── nom, e-mail, URL de l'avatar └── settings_json [Activité] ├── id (PK) ├── user_id (FK → Utilisateur) ├── type, heure de début, durée ├── distance, altitude, heure moyenne ├── geo_data_ref (FK → GeoStore) └── visibilité (public / abonnés / privé) [GeoStore] (index de stockage externe ou référence S3) ├── id (PK) ├── activity_id (FK → Activité) └── gps_data (tableau ou pointeur de fichier) [Suivre] ├── id_abonné (FK → Utilisateur) ├── id_abonné (FK → Utilisateur) └── créé_à [Élément de flux] ├── id (PK) ├── id_acteur (FK → Utilisateur) ├── verbe (« publié », « commenté », « aimé ») ├── id_objet (par exemple, id_activité, id_commentaire) └── id_utilisateur_cible (FK → Utilisateur) [Défi] ├── id (PK) ├── nom, description, type ├── Date_début, Date_fin └── Visibilité, Rule_JSON [Entrée_Classement] ├── ID (PK) ├── ID_défi (FK → Défi) ├── ID_utilisateur (FK → Utilisateur) ├── Valeur_métrique (distance, durée) └── Classement

2. Choix de technologie de base de données

Chaque domaine de données est optimisé pour son propre modèle d’accès:

- PostgreSQL: Source de données canonique pour les profils d’utilisateurs, les activités, les métadonnées alimentaires et les défis. Excellent pour l’intégrité transactionnelle et l’application des clés étrangères.

- TimesCaledB / affluxdb: Pour l’ingestion de points GPS, la télémétrie d’activité et l’analyse des séries chronologiques (par exemple, rythme au fil du temps, zones RH).

- CD S3 +: Utilisé pour le stockage des pistes GPS brutes, des images d’itinéraire et des supports téléchargés (avec un accès URL pré-signé sécurisé).

- Redis / memcached: Pour la récupération rapide des classements, des activités récentes et des données d’alimentation précalculées.

- Neo4j ou dgraph (facultatif): Pour la traversée complexe du graphique social, l’adhésion au club et les suggestions de suiveurs mutuelles à grande échelle.

3. Stratégie multi-tension et partitionnement

- Sharding: Les activités et les éléments de flux sont francs par l’ID utilisateur ou l’ID de région pour permettre la mise à l’échelle horizontale entre les partitions.

- Partitionnement basé sur le temps: La télémétrie GPS et les classements sont divisés en partitions mensuelles / hebdomadaires pour le vieillissement et les performances.

- Multi-location douce: Les clubs ou organisations (par exemple, les groupes de course, les équipes de cyclisme) fonctionnent dans l’espace de noms mondial, mais peuvent obtenir des requêtes dans les lèvres (via Tenant_ID) en cas de besoin.

4. Réplication et haute disponibilité

- PostgreSQL: Déployé avec des répliques de secours chaudes et l’expédition de WAL pour le basculement.

- Redis: Configuré avec Sentinel pour une haute disponibilité et une élection maîtresse automatisée.

- Media & Geostore: Le stockage d’objets est reproduit entre les régions et livré via un CDN global pour l’accès à faible latence.

Cette conception de la base de données assure une évolution flexible du schéma, une ingestion d’activité rapide et un support évolutif pour les charges de travail social et les analyses – tout en préservant l’intégrité référentielle où elle compte le plus.

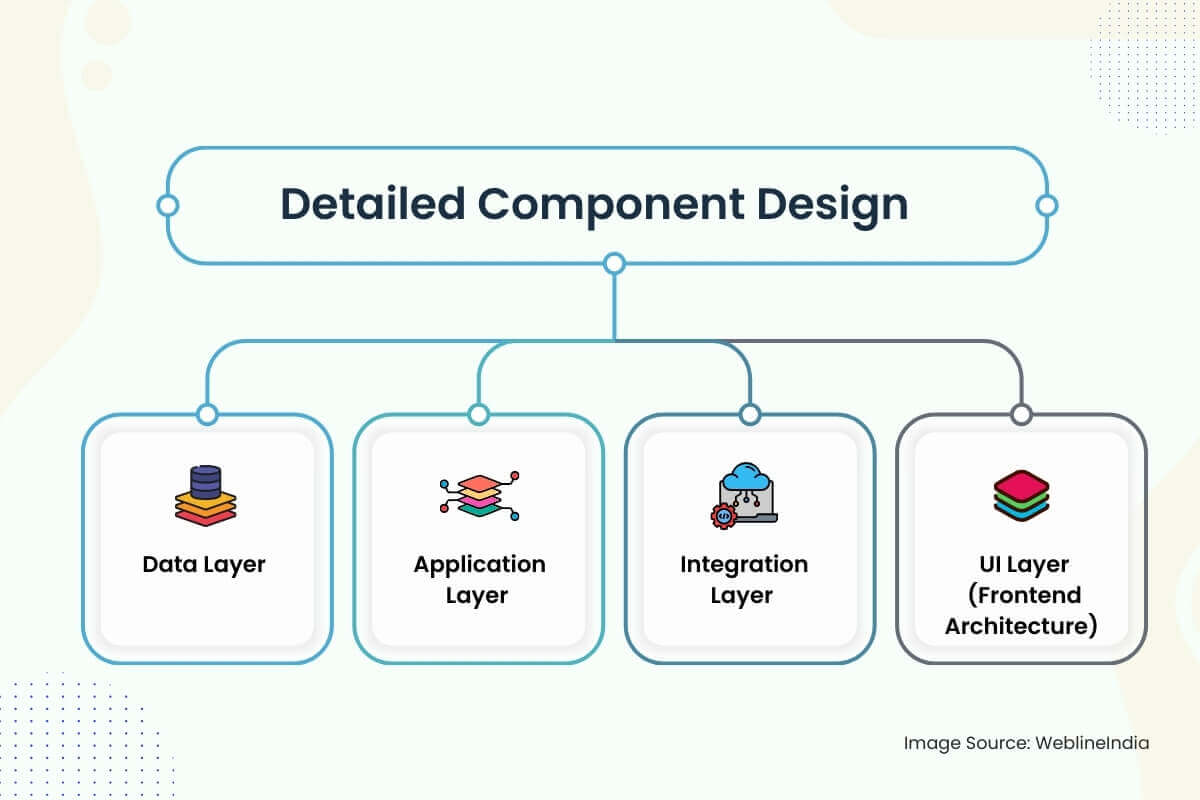

Conception détaillée des composants

1. Couche de données

- Stratégie de schéma: Les schémas sont conçus autour des limites claires du domaine: utilisateurs, activités, flux, graphiques sociaux et défis. Des colonnes comme «Visibilité», «Status» et «Activity_Type» utilisent des types énumérés pour l’indexation de l’efficacité. Les UUID sont préférés aux entiers auto-ondulés pour éviter les problèmes de clés de chaleur dans les magasins distribués.

- Accès aux données: L’accès aux données de base passe par des référentiels minces de services de service qui appliquent les politiques de contrôle d’accès (par exemple, les vérifications de visibilité des activités). Les opérations de lecture sont optimisées via des vues matérialisées et des instantanés d’alimentation pré-joints. Des chemins lourds en écriture comme l’ingestion d’activité utilisent des files d’attente d’écriture et des pipelines d’insertion en vrac pour lisser les pointes d’ingestion.

- Validation: La validation d’entrée se produit à plusieurs niveaux – Edge Schema Enforcement via OpenAPI ou GraphQL, Validation profonde dans les couches de service (par exemple, points GPS valides, horodatage non chevauchant) et vérification de la santé mentale asynchrone sur les données de télémétrie via des travaux d’arrière-plan.

2. Couche d’application

Conception de service: Chaque domaine majeur (utilisateur, activité, flux, notification, graphique social) est implémenté en microservice isolé. Les services exposent à la fois les points de terminaison GRPC et REST – REST pour les API publiques, GRPC pour la communication interservice. Principes d’architecture propre séparez la logique du domaine du code de transport et d’infrastructure.

Frameworks:

- Go ou Rust pour les services critiques de performance (activité, flux, classement)

- Node.js ou Python pour le code de colle, les intégrations et les workflows asynchrones

- GraphQL Server (Apollo ou Hasura) pour l’agrégation frontale et la requête déclarative

Authentification: Les jetons JWT sont émis via des flux OAuth2. Les appels de service à service utilisent des jetons internes signés avec des lunettes basées sur des rôles.

Limitation de taux: Implémenté via des seaux de jetons soutenus par redis à la passerelle et une granularité au niveau de l’utilisateur (en particulier pour les téléchargements d’activité).

3. Couche d’intégration

Message Queues: Kafka ou Nats est utilisé pour les flux de travail asynchronisés – traitement de l’activité, éventail de flux, correspondance des segments et publication de notification. Les gestionnaires d’iDEmpotents avec de solides garanties de livraison sont utilisés pour empêcher des poteaux en double ou des entrées de classement.

Synchronisation tierce: Les intégrations OAuth avec Garmin, Fitbit, Apple Health, etc., exécutent via un combo Poller de fond + Webhook. De nouvelles données sont en file d’attente et traitées via le pipeline d’ingestion d’activité.

Types d’événements:

activité.→ Fan-out pour assurer le service, informer les abonnésdéfi.joined→ Vérifier l’admissibilité, déclencher un insert de classementuser.→ Mettre à jour le graphique, rafraîchir les aliments, la notification de bienvenue en file d’attente

4. Couche d’interface utilisateur (architecture frontend)

Pile d’applications: React natif pour les applications mobiles multiplateforme, avec TypeScript et Redux Toolkit pour la gestion de l’État. L’application Web utilise Next.js pour SSR / ISR avec le style utilitaire de Tailwind et les requêtes GraphQL à backend.

Présentations de sécurité:

- Les secrets des clients ne sont jamais intégrés – OAuth PKCE Le flux est obligatoire

- Tous les appels API nécessitent des jetons signés, et les points de terminaison orientés publics sont filtrés par taux, origine et rôle

- Geo Data est en sable par réglage par visibilité – les activités privées sont exclues des cartes thermiques, des aliments et des calculs du segment

Fonctionnalités en temps réel: WebSockets ou SSE sont utilisés pour pousser les notifications, le statut de défi et les mises à jour de flux. Fallback à un long sondage sur les réseaux contraints. Le frontend maintient un cache SQLite local pour la journalisation des activités hors ligne.

Architerner quelque chose de similaire?

La conception de plates-formes en temps réel, Geo-Aware, socialement interactives prend précision à travers le flux de données, la gestion des événements et l’architecture mobile.

Si vous construisez quelque chose d’ambitieux – comme une plate-forme de remise en forme sociale, une intégration portable ou un flux en temps réel – nous serions ravis de vous aider à le faire dès le début.

Considérations d’évolutivité

1. Échelle de couche d’application

- Services apatrides: Tous les services de base (activité, flux, défi, etc.) sont apatrides et évolutifs horizontalement. Chaque instance est jetable et face à un équilibreur de charge. Les principes partagés garantissent que les instances ne reposent pas sur l’État local.

- Échelle automatique: L’automate (HPA) basé sur K8S (HPA) est utilisé pour les services basés sur les métriques CPU, mémoire et profondeur de file d’attente. Pour les services sensibles à la latence (comme le flux ou la notification), les mesures personnalisées (par exemple, le retard de l’événement) peuvent déclencher des échecs plus rapides.

- API Gateway Astraque: Les limites de taux basées sur les clients et IP empêchent les inondations d’API. La tolérance à la rafale est prise en charge à l’aide de la fenêtre coulissante à dos de redis ou des algorithmes de seau qui fuites.

2. Échelle de couche de données

Lire l’optimisation: Les données fréquemment consultées (par exemple, les activités récentes, les instantanés de classement) sont mises en cache de manière agressive dans Redis avec TTLS et l’expulsion du LRU. Les répliques de lecture postgresql sont mises à l’échelle en fonction du trafic pour décharger l’analyse et les requêtes d’interface utilisateur.

Stratégies de rupture:

- Données d’activité: Escapé par l’ID utilisateur sur les partitions ou les grappes logiques (par exemple, Activity_01, Activity_02, …)

- Feed Items: Partitionné par ID de l’acteur et ID du destinataire avec des index composites pour des recherches rapides

- Geostore: Utilise le préfixe de clé S3 par région et horodat

3. Feed and Social Graph Fan-out

La génération des aliments est un défi d’évolutivité majeur sur les plateformes sociales. Le système utilise une approche de fan-out hybride:

- Fan-out-on-écrite (primaire): Lorsqu’un utilisateur affiche une activité, le service de flux le pousse dans les lignes de flux précomputées pour les abonnés.

- Fan-out-on-lecture (secours): Pour les utilisateurs à grande envergure (célébrités, influenceurs), les flux sont construits au moment de la requête avec pagination de journaux d’événements à souci de Kafka ou de tables d’index pour aliments.

Stockage des aliments: Implémenté via des tableaux ou des magasins-famille à colonne (par exemple, des magasins Scylladb ou Cassandra) avec des TTL pour les événements éphémères et JSON pré-rendu pour l’hydratation rapide.

4. Challenge et traitement des classements

- Calcul par lots: Les classements sont calculés par lots à l’aide d’un moteur de traitement de flux (par exemple, Apache Flink, Spark Streaming). Les correspondances du segment et les validations de défi se déroulent de manière asynchrone à partir de l’ingestion d’activité à l’aide de sujets Kafka durables.

- Agrégation fendue: Les statistiques de défi sont fenêtrées (quotidiennes, hebdomadaires) pour éviter les analyses complètes de l’historique et réduire la pression de stockage. Les vues de matériel agrégées sont indexées par défi et segment.

5. Ingestion de données géo et capteurs

- Ingestion à haute fréquence: Les points GPS sont écrits par lots aux magasins de séries chronologiques (ou les fichiers S3 avec indexation) et à vérification pour éviter le débordement de la mémoire. Le lot réduit l’amplification de l’écriture sur la base de données et accélère la manipulation de la contrefaçon.

- Compression: Les coordonnées GPS sont codées en delta et gziées avant le stockage. La réhydratation se produit au moment du rendu de la carte ou de l’exportation, pas lors de l’affichage d’alimentation en temps réel.

6. Éclaties de la circulation tierces

Les pointes des synchronisations Garmin ou Apple sont absorbées à l’aide de files d’attente d’ingestion découplée et de pipelines ETL contrôlés par le taux. Chaque intégration a un disjoncteur et une politique de réessayer pour empêcher les abus en amont ou les tempêtes de fan-out.

Architecture de sécurité

1. Authentification et autorisation

- Authentification: Toutes les interactions du client utilisent OAuth 2.0 avec PKCE pour les flux mobiles. Les JWT sont émis et signés par le service AUTH, contenant l’ID utilisateur, la portée et l’expiration. Les jetons de rafraîchissement sont tournés et cryptés au repos.

- Connexion fédérée: Google, Apple et Facebook Sign-ins sont pris en charge, mais toujours liés à une identité utilisateur native. Les jetons de connexion sociale sont validés côté serveur, pas directement de confiance.

- Autorisation: Chaque service valide le jeton JWT et applique des règles au niveau de la portée (par exemple, «lire: feed», «post: activité»). La RBAC (contrôle d’accès basé sur les rôles) est utilisée pour les outils internes (par exemple, admin, rôles modératrices).

2. Protection des données

- Au repos:

- Les magasins postgresql, redis et objets sont chiffrés à l’aide du cryptage AES-256 avec des clés (CMKS) gérées par le client.

- Les champs sensibles (par exemple, e-mail, métriques de santé) sont chiffrés au niveau de la couche d’application avant l’écriture de DB.

- En transit: Tout le trafic inter-services et client-serveur est protégé par TLS 1.2+. Mutual TLS est utilisé pour la communication GRPC entre les services backend de confiance.

- Masquage au niveau du terrain: Les champs sensibles sont masqués ou expurgés dans les journaux et les tableaux de bord. L’outillage d’observabilité applique le marquage du champ et la numérisation automatisée des PII avant l’ingestion.

- Geo Confidentialité: Les activités marquées comme privées ou «abonnés uniquement» sont complètement exclues des flux, des classements et des indices de recherche. Les données de la carte thermique sont anonymisées et échantillonnées à partir d’activités publiques uniquement, avec des zones géo-gonflantes près de la zone d’accueil.

3. IAM Design & Secrets Management

- Secrets: Toutes les clés API, les informations d’identification DB et les tokens WebHook sont stockées dans un coffre-fort centralisé (par exemple, Hashicorp Vault ou AWS Secrets Manager) et injectés via l’environnement au moment de l’exécution. Les politiques de rotation sont automatisées pour les références de courte durée.

- JE SUIS: Chaque microservice a une identité et un ensemble de rôles uniques. Les politiques IAM sont portée aux autorisations minimales requises (par exemple, un accès en lecture seule au stockage d’objets, un accès en écriture uniquement aux sujets Kafka). Les agents CI / CD assument des rôles temporaires à l’aide de la confiance OIDC.

4. Codage sécurisé et protection API

- Validation d’entrée: Toute entrée externe est validée par schéma à l’aide du schéma OpenAPI ou JSON. Frontend et backend appliquer la longueur, le format et les vérifications des limites.

- Limitation du taux: Les limites de débit par utilisateur et per-IP sont appliquées via Redis ou des plugins de passerelle API. Les modèles de détection des abus (par exemple, le comportement de la tempête de connexion ou du spam) alimentent les politiques dynamiques de l’exécution.

- Protection de rediffusion: Toutes les demandes signées incluent les non-obstacles ou les horodatages. Les téléchargements d’activité et les webhooks utilisent les signatures HMAC pour valider l’origine et empêcher la falsification.

- Sécurité du code: L’analyse statique (SAST) et le balayage de dépendance sont intégrées dans les pipelines CI. La détection des secrets (par exemple, Gitleaks) bloque une exposition accidentelle. Tous les flux critiques passent par des demandes de traction évaluées par des pairs et auditées.

Extensibilité et maintenabilité

1. Limites de service modulaires

Chaque domaine majeur – utilisateurs, activités, flux, notifications, défis – est encapsulé dans son propre service, avec son propre schéma, API et son runtime déployable. Ces services communiquent de manière asynchrone via des files d’attente de messages ou de manière synchrone via GRPC / REST, en fonction de la sensibilité à la latence.

Cette isolation permet une mise à l’échelle indépendante, des cycles de libération et l’intégration de nouveaux ingénieurs sans risque de dommages collatéraux aux caractéristiques non liées. Par exemple, l’expédition d’un nouveau format de classement ou d’un déclencheur de notification ne touche pas la logique d’activité ou les profils d’utilisateur.

2. Modèles orientés vers le plugin

- Écouteurs d’événements: De nouvelles fonctionnalités (par exemple, les réalisations, les alertes de coaching en direct ou les badges basés sur l’appareil) sont introduits en abonnement à des événements de noyau comme

activity.createdorchallenge.completed.Cela permet l’innovation sans réécrire la logique en amont. - Fonctionnalités de caractéristiques: Toutes les fonctionnalités destinées aux utilisateurs sont contrôlées par des drapeaux dynamiques (par exemple, des systèmes de basculement lancés ou internes), ce qui permet les déploiements canariens, les tests A / B ou les versions en cours basées sur la région, le niveau utilisateur ou la plate-forme.

- Logique du défi personnalisé: Le moteur de défi est extensible via des moteurs de règle ou des scripts intégrés (par exemple, Lua ou CEL). Cela permet aux gestionnaires de marketing ou de club de créer de nouveaux types de défis (par exemple, “grimper 2k mètres en 3 jours”) sans la logique de codage rigide dans le backend.

3. Code propre et motifs

- Conception axée sur le domaine (DDD): Les services utilisent le DDD pour organiser la logique par contexte limité – agrégation d’activités, notation des segments, gestion des suiveurs – plutôt que par couche technique. Cela réduit la logique et l’étalement du code croisé.

- Tests et libellés: CI applique un libellé strict, des seuils de couverture de code et des tests contractuels pour toutes les API. La vitesse du développeur reste élevée car les configurations de développement locales utilisent des conteneurs avec des bases de données graines et des files d’attente simulées pour une itération rapide.

- Monorepo vs polyrepo: Le backend est généralement polyrepo (un par service), tandis que l’application mobile peut vivre dans un monorepo avec des packages modulaires. Les définitions de schémas protobufs ou graphQL partagées sont contrôlées par version dans un récompense de contrat distinct.

4. Service Verseging & Backward Compatibilité

- Versioning API: Toutes les API publiques sont versées (par exemple, `/ v1 / activités`). Les critères d’évaluation obsolètes sont maintenus pour une période de coucher du soleil définie, avec observabilité pour surveiller l’utilisation.

- Évolution du schéma: Les schémas PostgreSQL utilisent des migrations additives (ajoutant des colonnes, ne les supprimant pas) et ne renomment jamais les énumérations ou les contraintes sans les bascules à double lecture / écriture en place. Pour les magasins NoSQL, chaque objet est étiqueté avec une version de schéma pour la désérialisation compatible en arrière.

- Compatibilité du protocole: Les contrats GRPC et Protobuf sont conçus pour éviter de briser les changements – les champs ne sont jamais supprimés et les ID de champ ne sont pas réutilisés. Pour GraphQL, les champs obsolètes restent disponibles avec des en-têtes d’avertissement et des libellés dans le frontend.

Vous pensez à long terme pour votre plateforme?

Besoin d’aide pour concevoir une architecture modulaire à l’épreuve du futur qui ne s’effondrera pas sous le versioning des goulots d’étranglement de l’enfer ou de la croissance?

Que vous élargiez une application sociale ou que vous étendiez une plate-forme de fitness, nous sommes là pour aider l’architecte à long terme.

Optimisation des performances

1. Tunage de la requête de la base de données

- Indexation des requêtes: Chaque colonne de haute codinalité utilisée dans les filtres ou les jointures – telles que `User_id`,` Activity_id`, `Created_at`, ou` Challenge_id` – est soutenue par des index BTREE ou GIN. Les index composites sont créés pour des requêtes fréquentes comme `follower_id + créé_at desc` dans les flux ou` user_id + challenge_id` dans les recherches de classement.

- Vues matérialisées: Les rouleaux quotidiens (par exemple, “Distance totale de cette semaine”) sont stockés comme des vues matérialisées et rafraîchis via des travaux asynchrones. Cela évite les analyses d’agrégation répétitives et accélère les mesures de tableau de bord mobiles.

- Cache de requête: Les classements, les profils publics et les pages de défi statiques utilisent Redis comme couche de mise en cache avec des TTL intelligents et une invalidation explicite lors des événements pertinents.

2. Traitement asynchrone

- Charges de travail différées: Les tâches lourdes telles que la correspondance des segments, la génération de la carte thermique, l’évaluation des badges et le fan-out des aliments suiveurs sont tous reportés aux travailleurs de fond consommant des sujets Kafka / Nats. Cela maintient le chemin de soumission d’activité réactif (~ 100–200 ms p99).

- Chemins d’ingestion en vrac: Les téléchargements de Garmin ou d’Apple Health sont lancés et traités en parallèle, avec une déduplication et l’isolement des erreurs pour éviter de bloquer les synchronisation complète des périphériques en raison de fichiers corrompus uniques.

3. Contrôles de limitation des taux et d’abus

- Contrôle des taux: Chaque point de terminaison de l’API a des limites de taux de niveau de l’utilisateur et de niveau IP appliquées à la passerelle. Les opérations à coût élevé (par exemple, les activités de publication avec les médias) sont encore limitées via la limitation adaptative liée à la latence et au décalage de la file d’attente.

- Détection des abus: Les modèles appris à machine marquent des actions comme suivre le spam, des commentaires de commentaires ou des géositumations abusives. Ceux-ci sont liés à des filtres en temps réel qui ralentissent automatiquement ou des clients malveillants sandbox.

4. Cachers de cache

- Cache de bord: Les cartes d’itinéraire, les avatars de profil, les pages de défi et les carreaux de carte thermique sont tous servis via des nœuds CDN Edge (CloudFlare, rapidement). Les touches de cache sont taguées avec des hachages de version pour permettre une invalidation globale rapide.

- Mise en cache côté client: L’application mobile utilise SQLite local pour le mode hors ligne, avec l’hydratation des blobs JSON mis à jour de Delta reçus au démarrage ou post-login. Cela permet un rendu d’alimentation instantané et des démarrages à froid plus lisses.

5. Performance du frontend

- Charge incrémentielle: Les parchemins de flux, les vues de profil et les listes de défis implémentent tous un défilement infini ou une pagination fendue à l’aide de jetons basés sur le curseur. Cela minimise la taille de la charge utile et la pression de la mémoire sur les clients mobiles.

- Optimisation d’image: Toutes les images téléchargées sont redimensionnées, compressées et converti au format (par exemple, WebP) par le service multimédia avant la livraison CDN. Les variantes d’actifs spécifiques à l’appareil sont sélectionnées à l’aide d’en-têtes de négociation de contenu.

- JS Bundling & Tree Shaking: Les clients Web utilisent des bundlers modernes (par exemple, VITE ou WebPack 5) avec une division dynamique d’importation et des tremblements d’arbres. Le chargement paresseux est utilisé pour des composants d’interface utilisateur non critiques comme les graphiques, les cartes ou l’analyse.

Stratégie de test

1. Types de tests

- Tests unitaires: Chaque couche de service a des tests unitaires étendus couvrant la logique du domaine, la validation d’entrée et les fonctions utilitaires. Ce sont des courses rapides et isolées – aucune dépendance externe autorisée. Les bibliothèques moqueuses (par exemple, Gomock, Pytest-Mock, JEST) sont utilisées pour isoler les effets secondaires.

- Test d’intégration: Les interactions clés du service – telles que la soumission d’activité déclenchant des vérifications de génération d’alimentation ou d’éligibilité de défi – sont couvertes d’environnements de test basés sur Docker. Ces tests révèlent des dépendances réelles (PostgreSQL, Redis, Kafka) et valident le comportement dans des conditions réalistes.

- Test de contrat: Pour les API GRPC et REST, les tests contractuels (par exemple, à l’aide de PACT ou BUF pour Protobuf), valident que les services producteurs et consommateurs adhèrent à des schémas contenus, en particulier dans les bosses de version de service ou pendant les déploiements parallèles.

- Test de bout en bout (E2E): Les flux d’utilisateurs critiques – inscription, connexion, suivi des activités, commentaires – sont testés à l’aide de cyprès ou de désintoxication (pour React natif). Ces tests fonctionnent sur des émulateurs et des appareils réels en IC contre les environnements de mise en scène.

2. Stratégie de couverture de test CI

- Application de la couverture du code: Les seuils minimums sont appliqués pour les PR à l’aide d’outils comme CodeCov ou Sonarqube. Les portes de couverture du bloc fusion si un nouveau code manque de cas de test appropriés – en particulier pour la logique de service ou les fonctions de transformation des données.

- Pipelines CI parallélisés: Les tests sont regroupés par service et exécutés en parallèle via des actions GitHub, Circleci ou BuildKite. La matrice de test comprend des permutations environnementales (par exemple, différentes versions DB, versions API).

- Test des luminaires et semis: Les données de test partagées sont provisionnées via des instantanés conteneurisés ou des appareils YAML / JSON déclaratifs. Tous les services prennent en charge le mode de test Bootstrap pour les environnements de test locaux et CI.

3. Test de chargement et de résilience

- Test de charge: Les scripts de crique, d’artillerie ou de K6 simulent les schémas de trafic de pointe – grand ventilateur, téléchargements d’activité en vrac, défier les rafraîchissements de classement – pour tester la réponse du système sous contrainte. Les tests de chargement sont effectués chaque semaine et pendant les grandes versions.

- Ingénierie du chaos: Des outils tels que Gremlin ou Litmuschaos injectent des échecs sur le service, la base de données ou la couche de réseau (par exemple, les pointes de latence, les partitions Kafka abandonnées, les camelières DB). L’objectif est de valider les politiques de réessayer, la logique de secours et la couverture de l’alerte.

- Assertions de résilience: Les disjoncteurs, les cloisons et les retombées de temps mort sont explicitement testés. Les déploiements canariens incluent les tests d’injection de défaut avant le débuage complet.

DevOps et CI/CD

1. Présentation du pipeline CI / CD

L’ensemble du système est construit sur des workflows basés sur GIT (GitHub, GitLab ou Bitbucket) avec des pipelines automatisés déclenchés sur les demandes de traction, les fusions et les versions basées sur des balises. CI / CD est traité comme un produit de première classe avec des performances, de l’isolement et de la visibilité comme principes fondamentaux.

Étapes du pipeline:

- Construire: Les images de conteneurs sont construites par service à l’aide de Dockerfiles docker en plusieurs étapes. Les images de base communes sont mises en cache et réutilisées. Pour les applications de frontend, les étapes de construction incluent les tremblements d’arbres, la transpilation et l’analyse du faisceau.

- Test: Les tests d’unité, d’intégration et de contrat s’exécutent dans des travaux isolés avec un téléchargement d’artefact (par exemple, des rapports de couverture, des journaux de test). Les emplois ratés sont annotés en ligne dans PRS pour le triage rapide.

- Analyse de sécurité: Sast (par exemple, Sonarqube, SNYK) et les scans de vulnérabilité de dépendance sont appliqués avant la promotion des artefacts. Les outils de numérisation des secrets bloquent l’exposition accidentelle.

- Signer d’image: Les images de conteneurs sont signées et stockées dans un registre sécurisé (par exemple, AWS ECR, GCP Artifact Registry) avec des balises immuables et des métadonnées de provenance.

- Staging Déploiement: Les builds tagués sont automatiquement déployés dans un cluster de stadification. Les tests canariens, les tests de fumée et les contrôles de santé synthétiques se déroulent contre cet environnement avec des TTL courts.

- Promotion de la production: Les déploiements à prod sont soit déclenchés manuellement (avec des portes d’approbation) ou automatiquement après avoir réussi les conditions de l’AQ. Les outils Gitops (par exemple, Argocd, Flux) appliquent des manifestes à partir d’un dépôt d’état versé.

2. Infrastructure comme code (IAC)

- Terraform: Toutes les infrastructures – VPCS, grappes K8S, instances DB, rôles IAM, files d’attente – est gérée via des modules Terraform. Les modifications sont examinées et prévisualisées en utilisant

plan de terreen PRS. La détection de dérive se déroule tous les soirs pour détecter les changements manuels. - Personnaliser et casques: Les manifestes K8S sont modèles via Helm et gérés dans les environnements à l’aide de superpositions Kustomze. Cela facilite la remplacement des répliques, des configurations et des secrets par environnement.

- Gestion des secrets: Les secrets et les cartes de configuration sont injectés via des secrets scellés (par exemple, Mozilla SOPS, Bitnami Seled Secrets) ou synchronisés à partir des injecteurs Sidecar. Tous les secrets sont tournés et vérifiés régulièrement.

3. Stratégie de déploiement

- Déploiements bleu-vert: Pour les services de chemin critique comme l’authentification ou l’activité, des stratégies bleu-vert sont utilisées. Le trafic est décalé progressivement en utilisant des règles d’entrée, avec un recul automatisé si les contrôles de santé échouent.

- Sormes canaries: Les services non critiques (par exemple, les notifications, les classements) utilisent les déploiements canariens – déploiement à 5%, puis 25%, puis 100% au fil du temps. Les métriques (latence, taux d’erreur, CPU) sont comparées aux lignes de base avant de continuer.

- Fonctionnalités de caractéristiques: Tous les nouveaux chemins de code sont gardés par des bascules de fonctionnalité. Cela permet une exposition progressive, des lancements sombres et des commutateurs de mise à mort instantanés lors des incidents.

4. Hygiène des artefacts et de l’environnement

- Cycle de vie de l’image: Les constructions anciennes sont automatiquement élaquées en fonction des politiques de rétention d’âge ou de SHA. Les images inutilisées ne sont jamais maintenues au-delà de 30 jours, sauf tagués en LTS ou en versions en arrière.

- Aperçu des environnements: Les environnements de stadification éphémère sont créés par PR en utilisant des espaces de noms dynamiques dans Kubernetes. Ces environnements imitent les topologies de production et sont détruites après la fusion ou la fermeture des relations publiques.

- Mécanisme en arrière: Chaque déploiement est atomique et pénétré par la version. Rollbacks peut être déclenché via Git Revert, History Rollback ou Argocd UI Click – en quelques secondes.

Besoin d’aide pour expédier plus rapidement sans casser les choses?

Vous voulez construire un pipeline d’ingénierie à grande vitesse avec des rétroviseurs à l’épreuve des balles, des flux de travail GITOPS et un CI / CD de qualité de production?

Que vous stimuliez un backend de microservices ou que vous lanciez une nouvelle fonctionnalité mobile, Architecs un système DevOps qui fonctionne sous pression.

Surveillance et observabilité

1. L’exploitation

- Journalisation structurée: Chaque service se connecte au format JSON à l’aide de champs structurés comme `request_id`,` user_id`, `activité_id` et` durée_ms`. Les journaux sont diffusés via un bit fluide ou un bit de file dans un pipeline central (par exemple, Elasticsearch, Loki) pour la requête et l’analyse indexées.

- ID de corrélation: Chaque demande génère un ID de corrélation unique qui se propage à travers les limites de service via les en-têtes et le contexte du journal. Cela permet une traçabilité complète de bout en bout de l’application mobile aux files d’attente backend à DB.

- Hygiène de journal: Les règles de masquage PII sont appliquées au niveau du pipeline de journaux. Les secrets, les jetons d’accès, les coordonnées GPS et la télémétrie brute sont exclues ou expurgées automatiquement avant que les journaux n’atteignent le stockage.

2. Métriques

- Métriques du système: L’utilisation du CPU, de la mémoire, du disque et du réseau est exportée à partir de chaque nœud et pod via des exportateurs de Prometheus. Les seuils d’alerte sont définis pour la saturation, la pression des ressources et le désabonnement inhabituel.

- Métriques commerciales:

- Activités par minute, Feed Events par seconde

- Challenge rejoint, Writs Leadboard, Matches de segment

- Latence par point final, taux d’erreur du 99e centile

- Instrumentation personnalisée: Les services utilisent les bibliothèques clients de Prometheus pour exporter des compteurs, des histogrammes et des jauges pour la logique personnalisée – tels que «évaluations de badges traitées» ou «points GPS par téléchargement».

3. Traçage distribué

- Système de traçage: L’OpenTelemetry est utilisée pour instrument des services avec des plans pour les appels HTTP / GRPC, les requêtes DB et la manipulation de la file d’attente asynchrone. Les traces sont exportées vers des backends comme Jaeger, Honeycomb ou Tempo.

- Échantillonnage de trace: L’échantillonnage basé sur la tête (avec des taux réglables) garantit que des transactions à grande valeur telles que l’ingestion d’activité ou le fan-out alimentaire sont toujours capturées, tandis que les travaux de fond à faible priorité sont échantillonnés de manière probabiliste.

- Lien de trace: Toutes les traces se rattachent aux ID utilisateur et demandent des métadonnées, permettant le débogage des soumissions d’activités individuelles, des bogues de classement ou une génération d’alimentation des suiveurs lents avec des chaînes de causalité exactes.

4. Alerte et tableaux de bord

- Gestion des alertes: Prometheus Alertmanager ou Opsgenie gère la déduplication, les fenêtres de silence, les rotations de garde et les politiques d’escalade. Les alertes incluent les crochets Slack / Teams, SMS et PagerDuty lorsque des seuils critiques sont franchis.

- Tableaux de bord: Les tableaux de bord Grafana sont prédéfinis par service avec des capacités de forage pour la latence, les taux d’erreur, le débit de base de données, les arriérés de file d’attente et les défaillances externes d’API. Les parties prenantes de l’entreprise obtiennent également des vues KPI (par exemple, les utilisateurs actifs, les taux d’achèvement des défis).

- Slos et budgets d’erreur: Les principaux points de terminaison (par exemple, soumission d’activité, chargement des aliments, se joignant au défi) sont liés à des SLO formels avec des seuils de latence / erreur. Les taux de brûlure sont calculés pour éclairer la déclenchement du drapeau et la stimulation de déploiement.

5. CHECKS DE SANTÉ ET PRODUITES DE PROFESSION

- Lipivité et préparation: Tous les services exposent des points de terminaison «/ Healthz» pour la vivacité de base (par exemple, l’état du pool de threads, la mémoire) et la préparation (par exemple, la connectivité DB, le décalage de la file d’attente). Kubernetes les utilise pour l’orchestration de l’automate et du déploiement.

- Contrôles profonds: Les tâches d’arrière-plan périodiques effectuent des transactions synthétiques (par exemple, insert d’activité de test + lecture de flux) pour valider la santé de la logique commerciale – pas seulement la disponibilité du système.

Compromis et décisions de conception

1. Fan-Out-on-Write vs fan-out-on-read

- Décision: Un modèle hybride a été choisi. Pour les utilisateurs moyens, le système utilise le fan-out-on-write pour pré-populer les flux. Pour les utilisateurs à haut fan (par exemple, les influenceurs), il passe à la lecture de Fan-Out-Out.

- Pourquoi: Les entrées de flux précompossé minimisent la latence et décharge le chemin de lecture, mais c’est cher lorsqu’un utilisateur a des milliers d’adeptes. La conception hybride optimise le cas de 95% tout en protégeant les infrastructures des tempêtes de ventilateur.

- Compromis: Plus de complexité opérationnelle. Le système doit acheminer dynamiquement les écritures / lit via différents chemins de code en fonction du niveau utilisateur ou du nombre de suiveurs. Augmente également la surface de test.

2. Persésistance polyglotte

- Décision: PostgreSQL, Redis, Kafka et S3 ont été choisis comme pile de base. L’utilisation facultative de NEO4J pour la traversée du graphique social a été différée.

- Pourquoi: Ces outils s’alignent bien avec les modèles d’accès: PostgreSQL pour l’intégrité, Redis pour l’accès à faible latence, Kafka pour l’échelle pilotée par des événements et S3 pour le stockage blob. Éviter un graphique spécialisé DB OPS simplifié et intégration.

- Compromis: Certaines requêtes graphiques (par exemple, «Les abonnés mutuels dans un club») sont moins efficaces sans moteur graphique dédié. La mise en cache basée sur Redis atténue cela mais ajoute une complexité de cohérence du cache.

3. Synchronisation GPS en temps réel vs téléchargement post-entraînement

- Décision: Le téléchargement post-entraînement est la valeur par défaut; La synchronisation en temps réel est facultative et opt-in (par exemple, pour le suivi en direct ou les races virtuelles).

- Pourquoi: Le streaming GPS en temps réel crée une charge backend constante, introduit des défis de cohérence pour les activités partielles et augmente le drain de puissance sur les appareils mobiles. Pour la plupart des utilisateurs, le téléchargement par lots est suffisant.

- Compromis: Capacité réduite à alimenter les fonctionnalités comme les applaudissements en direct, le match de rythme ou les mises à jour de classement en cours. Les versions futures peuvent étendre le support en temps réel derrière les drapeaux de fonctionnalité.

4. Microservices vs Monolith

- Décision: Les microservices ont été choisis tôt, avec des limites claires du domaine: activité, flux, utilisateur, défi, média, etc.

- Pourquoi: Permet la mise à l’échelle indépendante, le développement parallèle et la propriété spécifique au domaine. L’ingestion d’alimentation et d’activité a des profils de performance extrêmement différents – les séparer permet une optimisation ciblée.

- Compromis: Nécessite un outillage robuste: découverte de services, traçage, isolation CI / CD et maturité de l’ingénierie de la plate-forme. Pour les petites équipes, cela ajoute une complexité initiale, mais l’agilité à long terme l’emporte sur la douleur à court terme.

5. Flux de travail basés sur des événements vs synchrones

- Décision: Tous les chemins non critiques (éventail de flux, mises à jour de classement, notifications) sont asynchrones via Kafka / Nats. Seules les requêtes AUTH et orientées vers les utilisateurs utilisent les flux de demande / réponse.

- Pourquoi: Les systèmes asynchrones évoluent mieux et découplent les flux de travail. Ils permettent également des lots, des tentatives et de la hiérarchisation des files d’attente – essentiels pour les modèles d’ingestion variable comme les synchronisation tiers ou les pointes de défi.

- Compromis: Cohérence éventuelle et complexité de débogage. Nécessite DLQS (files d’attente de lettres de mort), des rediffusions d’événements et une logique de déduplication minutieuse. La surveillance et l’observabilité sont essentielles à la sécurité ici.

Dette architecturale et atténuations

- Certains chemins d’alimentation plus anciens supposent toujours des écritures synchrones – refactorisé dans les services de fan-out basés à Kafka.

- Le moteur initial de défi avait des règles codées en dur – remplacées par un moteur de règle pour la flexibilité.

- Logique d’autorisation dispersée sur les services – étant centralisée dans un service de politique d’accès pour appliquer la cohérence.

Les principaux plats et zones pour améliorer

1. Ce que cette architecture va bien

- Évolutivité par conception: Les services apatrides, le traitement basé sur des événements et les bases de données fragiles maintiennent le système réactif même à des millions d’utilisateurs et à des taux d’ingestion élevés.

- Limites modulaires: La séparation claire entre l’activité, le social, les médias et la logique analytique permet une optimisation ciblée et un développement parallèle sûr.

- Async d’abord: La génération d’aliments pour découplage, la notation des défis et les notifications du chemin de l’ingestion de base fournissent des performances et une isolation des défauts là où il est important.

- Sécurité et confidentialité: Les contrôles d’accès à grains fins, le stockage crypté et les pratiques d’observabilité strictes s’alignent sur la responsabilité des données au niveau du RGPD.

- Vitesse du développeur: Les pipelines CI / CD, les drapeaux de caractéristiques et les tests contractuels prennent en charge l’itération rapide et sûre – sans compromettre la stabilité de la production.

2. Opportunités d’amélioration

- Requêtes de graphique dynamique: Réévaluer l’utilisation de DBS de graphe Redis vs spécialement conçu (par exemple, dgraph, nébuleuse) pour la détection des suiveurs mutuels ou les caractéristiques avancées du club.

- Contrôle d’accès unifié: Centraliser toutes les vérifications d’autorisation dans un service de politique (OPA ou Custom) pour éviter la duplication et la dérivation à travers les services.

- Caractéristiques en direct: L’élargissement des capacités en temps réel (par exemple, les segments en direct, les pacers, les courses de groupe) avec des protocoles de streaming fiables et un déploiement contrôlé.

- Mobile Offline Sync: Améliorer la première ligne UX pour les utilisateurs dans les zones rurales ou pendant les longues activités de plein air avec de meilleures stratégies de résolution des conflits.

- Analyse avancée: Construire des pipelines d’athlète dédiés à l’athlète (par exemple, estimation VO2 MAX, charge d’entraînement) à l’aide de lacs de données pré-agrégés et de modèles ML.

Cette conception de plate-forme équilibre les performances, la flexibilité et l’expérience utilisateur dans un contexte social + fitness exigeant. Il est prêt pour la production, testé au combat et construit pour la croissance – mais avec de la place pour évoluer en un écosystème de fitness plus intelligent, en temps réel et personnalisé.

Construire quelque chose d’ambitieux?

La conception de plates-formes évolutives, sécurisées et socialement engageantes ne consiste pas seulement à choisir la bonne pile – il s’agit de prendre les bonnes décisions au bon moment.

Que vous lanciez une application de fitness, améliorez l’engagement des utilisateurs ou que vous vous motivez votre backend, nous sommes prêts à vous aider à l’architer en toute confiance.

Les gens demandent également (FAQ)

Comment développer une application de tracker de fitness?

Commencez par définir les caractéristiques principales: suivi de l’activité GPS, ingestion de données sur la santé (fréquence cardiaque, étapes), profils d’utilisateurs et journalisation hors ligne. À partir de là, concevez une expérience mobile d’abord en utilisant React Native ou Swift / Kotlin, implémentez l’authentification sécurisée de l’utilisateur (OAuth2) et se connectez à un backend qui peut ingérer, traiter et analyser les données des capteurs en temps réel. L’infrastructure native du cloud, les magasins de données évolutives et le traitement axé sur les événements seront essentiels pour maintenir les performances et la réactivité.

Combien cela coûte-t-il pour créer une application de fitness?

Cela dépend de la portée, mais une application de fitness de qualité de production avec suivi GPS, authentification utilisateur, synchronisation en temps réel, stockage cloud et fonctionnalités sociales 50 000 $ à 500 000 $ + pour construire et lancer. Cela comprend l’interface utilisateur / UX, le développement mobile, l’architecture backend, DevOps et QA. Échelle de coûts basée sur la complexité – le suivi en direct, les graphiques sociaux, les intégrations et l’analyse augmentent tous les efforts d’ingénierie.

Comment créer une application Strava?

Pour créer une application de type Strava, vous aurez besoin d’un client mobile pour l’enregistrement d’activités basé sur GPS, d’un backend pour stocker et analyser les entraînements des utilisateurs, et une couche de graphique sociale pour les flux, les suit et les interactions. Les composants principaux comprennent un pipeline de localisation en temps réel, un service d’alimentation évolutif et un moteur axé sur les événements pour les défis et les classements. L’architecture de l’évolutivité, de la faible latence et des limites de service modulaire est essentielle.

Combien cela coûte-t-il de créer une application comme Strava?

Une plate-forme de style Strava complet peut facilement dépasser 500 000 $ à 1 M $ + En cours de développement, en fonction de votre ensemble de fonctionnalités, de votre structure d’équipe et de votre délai de marché. Les coûts incluent le développement mobile et backend, les infrastructures cloud, l’optimisation des performances et la prise en charge de choses comme les téléchargements des médias, les paramètres de confidentialité et les intégrations de l’appareil tiers.

Quelle base de données Strava utilise-t-elle?

Strava n’a pas détaillé publiquement leur pile complète, mais sur la base de modèles communs aux systèmes d’échelle similaire, ils utilisent probablement un mélange de bases de données relationnelles (par exemple, PostgreSQL), de magasins de données distribués pour la télémétrie (par exemple, Cassandra ou DBS de la série temporelle) et des systèmes de type redis pour la mise en cache. Leur architecture est axée sur les événements et basée sur les microservices, avec des infrastructures cloud qui s’occupaient de millions d’activités par jour.

Pourquoi Strava est-elle si populaire?

Strava a cloué le mélange du suivi de la forme physique et de l’engagement social. Il ne s’agit pas seulement d’enregistrer des courses – il s’agit de les partager, de concurrencer les segments, de gagner des badges et de s’engager avec une communauté. Les aliments sociaux, les caractéristiques de la gamification et l’écosystème défier rendent la plate-forme collante et formant des habitudes, ce qui entraîne à la fois la rétention et la viralité.

Une application de fitness est-elle rentable?

Oui – si bien exécuté. Les applications de fitness basées sur l’abonnement (comme Strava Premium, MyFitnessPal, etc.) se sont révélées très rentables. Les revenus peuvent provenir d’analyses premium, d’outils de coaching, de défis de marque ou de marchés de matériel. Mais la rentabilité nécessite une stratégie de rétention solide, une efficacité des infrastructures et une croissance des utilisateurs au-delà de la MVP.

Comment monétiser mon application de fitness?

Les stratégies de monétisation courantes comprennent: les abonnements à freemium (par exemple, déverrouiller des analyses ou un coaching plus profonds), des achats intégrés (par exemple, des plans de formation), des partenariats de marque (par exemple, des défis parrainés) et des marchés affiliés (par exemple, des chaussures, des vêtements). Les annonces sont possibles mais dégradent souvent l’expérience utilisateur. Concentrez-vous sur la confiance des utilisateurs et la valeur à long terme lors de la conception des chemins de monétisation.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.