Introduction

Les systèmes de gestion des stocks sont passés de simples feuilles de calcul en plates-formes complexes et intégrées qui gèrent le suivi des stocks en temps réel, la coordination des fournisseurs, l’automatisation des entrepôts et l’analyse. Dans le monde numérique-premier actuel, les plates-formes d’inventaire basées sur le SaaS doivent non seulement évoluer pour soutenir des milliers de clients, mais également maintenir une isolation stricte des données, une sécurité et une disponibilité. C’est là que la multi-location devient un changeur de jeu.

Ce guide d’architecture explore comment concevoir un robuste, évolutif et sécurisé Plateforme de gestion des stocks multi-locataires sur AWS. Le système est conçu pour les fournisseurs SaaS desservant plusieurs entreprises de vente au détail, de fabrication ou de logistique, chacune avec ses propres utilisateurs, entrepôts, catalogues et flux de travail.

Demande des entreprises modernes Visibilité en temps réel, haute disponibilité et agilité opérationnelle. Cela signifie que le backend doit évoluer de manière transparente, prendre en charge la logique personnalisée par locataire et s’intégrer aux systèmes externes de l’ERP, de l’expédition et de la paiement. Les locataires s’attendent à des règles commerciales configurables, à l’accès basé sur les rôles et à l’analyse d’utilisation – le tout sans compromettre les performances.

La multi-location ajoute une autre couche de complexité. Il nécessite une conception minutieuse autour des modèles de location (regroupés vs isolés), d’infrastructure partagée, de limites de sécurité et de politiques de mise à l’échelle. Et lorsque vous mélangez cela avec des exigences spécifiques aux stocks – comme les seuils de stock, le versioning SKU, les bons de commande et la cartographie des zones d’entrepôt – les choses peuvent devenir poilues rapidement.

Ce guide décompose comment construire une telle plate-forme à partir de zéro à l’aide de services natifs AWS et de principes de conception testés au combat. Nous plongerons profondément dans les modèles de location, le partitionnement des données, l’architecture API, les stratégies de déploiement et les leviers d’évolutivité – avec des scénarios réels et des informations d’implémentation cuites.

Si vous construisez un système d’inventaire SaaS, la migration d’une plate-forme héritée, ou simplement la recherche pour l’échelle, c’est le playbook.

Exigences du système

Exigences fonctionnelles

- Multi-location: Prise en charge de plusieurs organisations de locataires avec isolement de données logiques et fonctionnalités configurables.

- Gestion des stocks: Suivez les produits, les réseaux de bourse, les niveaux de stock, les numéros de lots, les dates d’expiration et les emplacements (entrepôt, zone, bac).

- Logistique entrante et sortante: Gérez les bons de commande, la réception, les commandes de vente et les workflows de réalisation.

- Contrôle d’accès basé sur les rôles (RBAC): Définissez les autorisations granulaires pour les utilisateurs (par exemple, gestionnaire d’entrepôt, agent d’achat, administrateur).

- Autorisation d’audit: Capturez et stockez un historique complet des mouvements de stock, des actions des utilisateurs et des appels d’API.

- API-First: Exposez toutes les opérations via des API REST / GraphQL pour l’intégration avec les ERP, les fournisseurs d’expédition et les fronts de commerce électronique.

- Notifications en temps réel: Déclencher des alertes pour les seuils de stock, les modifications de l’état de commande et les événements système.

- Rapports et analyses: Fournir des tableaux de bord, des KPI (par exemple, des virages en actions, un taux de remplissage) et des rapports exportables pour chaque locataire.

Exigences non fonctionnelles

- Évolutivité: Doit évoluer horizontalement pour gérer les charges de travail des locataires variables, les pointes saisonnières et la croissance du volume de données.

- Haute disponibilité: Cibler 99,99% de SLA de disponibilité avec basculement, sauvegardes et architecture résiliente.

- Sécurité: Appliquer l’isolement strict des données des locataires, le stockage chiffré, les API sécurisées et les politiques d’accès par location.

- Observabilité: Fournir une journalisation centralisée, des mesures et un traçage distribué à travers les limites des locataires.

- Configurabilité: Permettez aux locataires de personnaliser les workflows, les règles métier et les configurations au niveau du champ sans affecter les autres.

- Rentabilité: Optimiser l’utilisation des ressources grâce à des services partagés dans la mesure du possible sans compromettre l’isolement ou les performances.

- Reach global: Prise en charge des déploiements multi-régions pour les clients mondiaux avec des considérations de résidence de données.

Contraintes

- Cloud-Native: Doit utiliser des services gérés par AWS où il est possible de réduire les frais généraux opérationnels.

- Déploiements de temps d’arrêt zéro: Toutes les mises à jour doivent prendre en charge les stratégies roulantes ou bleu-vert pour éviter les perturbations.

- Aucune limite de locataire dur: L’architecture ne doit pas supposer un nombre fixe de locataires ou d’identifiants codés en dur.

Hypothèses clés

- Chaque locataire a des données commerciales isolées, mais partage les services de plate-forme de base (Auth, messagerie, moteur de workflow).

- Certains locataires peuvent avoir des exigences personnalisées (par exemple, les formats de code-barres, les mappages ERP), que le système doit prendre en charge via des points d’extension.

- La majorité des interactions seront axées sur l’API, soit par des applications de frontend ou des systèmes externes.

- Les locataires varient en taille – des startups gérant un seul petit entrepôt à des clients d’entreprise avec des dizaines d’installations.

Cas d’utilisation / scénario

Contexte commercial

Une entreprise SaaS construit une plate-forme de gestion des stocks pour desservir plusieurs clients dans les secteurs de la distribution, de la distribution et de la fabrication. Ces clients – les locataires – ont besoin d’un système unifié pour gérer les stocks entre les entrepôts, la suivi des mouvements de stock et rationaliser la réalisation des commandes. Chaque locataire fonctionne indépendamment, souvent avec des flux de travail uniques, des catalogues de produits et des exigences de conformité. Par exemple:

- Locataire A est une marque de vêtements DTC avec deux entrepôts et une intégration Shopify. Ils ont besoin de synchronisation des stocks en temps réel et de mesures de réalisation rapide.

- Locataire B est un grossiste régional gérant des milliers de références avec des dates d’expiration, nécessitant des stratégies FIFO / FEFO et l’automatisation du bon de commande.

- Locataire C est un distributeur mondial d’électronique avec des dizaines d’entrepôts, un balayage de code-barres et une intégration serrée avec les API ERP et FedEx NetSuite et FedEx.

La plate-forme doit s’adapter à cette diversité sans duplication de code ou d’infrastructure. Chaque locataire obtient une isolation logique des données, une personnalisation de l’image de marque et un accès à un écosystème partagé d’API, des intégrations et des composants de l’interface utilisateur.

Utilisateurs et rôles

Les utilisateurs s’étendent sur plusieurs fonctions de travail au sein de l’organisation de chaque locataire:

- Opérateurs d’entrepôt: Effectuez la réception des stocks, les transferts, la cueillette et le comptage du cycle via une tablette ou un scanner de code-barres.

- Agents d’achat: Créez et suivez les points de vente, surveillez les SLA du fournisseur et gérez les seuils de réorganisation.

- Équipes de vente: Afficher la disponibilité des stocks en temps réel et coordonner la réalisation des commandes du client.

- Admins: Gérez les utilisateurs, les autorisations, les clés API et les flux de travail personnalisés dans leur portée du locataire.

Modèles d’utilisation

- Trafic API: Trafic à lutte contre l’écriture en lecture pendant les heures d’ouverture; Les intégrations en temps réel avec les vitrines et les ERP conduisent la concurrence à API élevée.

- OPS d’entrepôt: Les scanners et les dispositifs portables émettent des commandes de mouvement des stocks rapides avec des attentes de latence inférieure à la seconde.

- Emplois par lots: Emplois nocturnes pour concilier l’inventaire, synchroniser avec des systèmes externes et générer des rapports de reconstitution.

- Utilisation multi-régions: Certains locataires opèrent dans l’APAC, d’autres en Amérique du Nord ou en Europe – nécessitant une manipulation du fuseau horaire et un support de localité des données.

Ce niveau de multi-tenues combiné à des profils de charge de travail variables exige une conception à la fois élastique et tolérante aux pannes, tout en donnant aux locataires la sensation d’une instance isolée sans les frais généraux de la duplication réelle de l’infrastructure.

Besoin d’une plate-forme similaire?

La construction d’une plate-forme SaaS conscient de locataires avec logique configurable et performances de qualité industrielle n’est pas triviale.

Si vous cherchez à concevoir ou à mettre à l’échelle un système d’inventaire multi-locataire comme celui-ci, Parlons. Nous avons construit des plates-formes similaires dans la logistique, le commerce de détail et la fabrication – nous pouvons vous aider à architeser le vôtre.

Architecture de haut niveau

Aperçu

Au cœur de cette conception se trouve un Modèle d’infrastructure partagé logiquement isolé – Les locataires partagent des services de calcul, de stockage et de plate-forme, mais l’accès est portée aux données spécifiques aux locataires. Nous utilisons des composants natifs AWS pour maintenir l’architecture agnostique dans le nuage, autosculable et résilient.

Les locataires interagissent avec le système via une passerelle API unifiée, qui achemine les demandes des services aux locataires. L’authentification est centralisée, tandis que la logique métier et les services de données sont évolutives horizontalement, apatrides et axés sur les événements, le cas échéant.

Conception de la base de données

Modèle de location

Cette plate-forme utilise un Modèle multi-locataire regroupé avec schéma partagé Dans PostgreSQL pour les données opérationnelles et DynamoDB pour un accès rapide aux métadonnées spécifiques aux locataires ou à la configuration dynamique. Chaque enregistrement des tables partagées comprend unlocataire_id Dans le cadre de sa clé primaire ou composite, assurant une isolation logique des données.

Ce modèle permet la mise à l’échelle horizontale, simplifie les opérations et réduit les coûts d’infrastructure par location – tout en préservant le contrôle d’accès au niveau du locataire, la sauvegarde et l’auditabilité.

Aperçu de la relation de l’entité

Vous trouverez ci-dessous un ERD conceptuel de haut niveau des entités centrales:

- Locataire: Stocke les métadonnées pour chaque client (par exemple, nom, plan, limites).

- Utilisateur: Lié à un locataire, avec des rôles et préférences RBAC.

- Entrepôt: Un locataire peut avoir de nombreux entrepôts, chacun avec des zones et des bacs.

- Produit: Entités au niveau SKU, avec des attributs comme le code-barres, le poids, la politique d’expiration.

- Inventaire: Entrées de stock avec quantité, ID de lot, emplacement (zone / bac) et sentier d’audit.

- Commande d’achat et Commande client: Document Flows Suivre la logistique entrante et sortante.

- Mouvement de stock: Journaux chaque modification de l’État boursier – transférer, choisir, recevoir, etc.

Voici un diagramme ER simplifié:

Locataire ─────┐

├───< Utilisatrice

├───< Entrepôt ──< Zone ──< Bin

├───< Produit

├───< Bon de commande ──< PurchaseOrderItem

├───< Commande de vente ─────< SalesOrderItem

└───< Inventaire ───────< StockMovement

Schémas de table clés (postgresql)

Créer un locataire de table (id uUId Clé primaire, nom de nom non nul, texte de plan, création_at horodatage par défaut maintenant ()); Créer un produit de table (id UUID Clé primaire, locataire_id uuid non nul, texte sku non nulle, nom de nom non nul, attributs JSONB, is_active booléen par défaut true, clé étrangère (Tenant_id) références locataires (id)); Créer une inventaire de table (id uuid Clé primaire, locant_id uuid not null, product_id uuid not null, warehouse_id uuid not null, bin_id uuid, quantité entière non null, batch_id text, expiration_date date, updated_at timestamp defautel (), touche étrangère (tenant_id) références à l'id); id);DynamoDB complète cela en stockant les paramètres par location, les limites de débit API, les mappages de champ personnalisés et la configuration dynamique. Exemple de schéma clé:

PK: locataire # SK: ParamètresStratégies multi-location

- Isolement des données: Appliqué à la couche de demande et de requête – toutes les clauses incluent

locataire_id. Les requêtes sont protégées via un ORM ou un constructeur de requêtes appliquant un accès portée. - Poolage de connexion: RDS PROXY GANDES PERS CONNECTION CONNECTION CALING avec l’authentification basée sur IAM; Aucune connexion spécifique aux locataires n’est maintenue.

- Optimisation des requêtes: Toutes les tables fréquemment consultées ont des index composites comme

(locataire_id, sku)ou(locataire_id, warehouse_id).

Partitionnement et réplication

PostgreSQL utilise le partitionnement déclaratif (par locataire ou entrepôt, selon le modèle d’accès) pour des tables à volume élevé commeinventaireet Stock_movement. Cela maintient les partitions petites et accélère les analyses de portée et la suppression.

Pour l’analyse, le décalage vers le rouge ou l’Athéna peuvent être utilisés pour exécuter des requêtes croisées ou par location sur les exportations S3 synchronisées de l’entrepôt.

La réplication (Read-Replicas via RDS) prend en charge la sélection de lecture et la séparation d’analyse. Les sauvegardes sont effectuées par cluster, mais les exportations conscientes des locataires peuvent être déclenchées tous les soirs pour les politiques de rétention spécifiques au client.

Conception détaillée des composants

1. Couche de données

La couche d’accès aux données est consciente du locataire par conception. Chaque requête comprend lelocataire_idFiltre, appliqué par middleware ou abstraction du référentiel (selon le cadre).

- Stratégie ORM: Les services soutenus par Postgres utilisent la séquelle (Node.js) ou Sqlalchemy (Python) avec des séances dans le contexte par locataire.

- Validation: La validation du schéma (par exemple, avec le schéma ZOD, JOI ou JSON) se produit avant que les données n’atteignent la base de données – importante pour garantir que la configuration par location n’est pas violée.

- Emballage d’accès aux données: Toutes les requêtes passent par un DAL commun qui injecte des filtres à locataires et du RBAC au niveau de la colonne le cas échéant.

2. Couche d’application

L’application est divisée en microservices par domaine – par exemple, service d'inventaire,commandes,service de catalogue, etc. Chaque service est apatride et déployable indépendamment.

- Exécution: ECS Fargate ou Lambda, selon le profil de charge de travail. Les opérations avec état (par exemple, la synchronisation grande lot) préfèrent les ECS; Les API en temps réel se penchent vers Lambda.

- Cadre: Fastify (Node.js) ou Flask (Python) pour les services HTTP légers; NESTJS ou Spring Boot pour les services structurés axés sur le domaine.

- Style API: Repos pour les services internes, GraphQL pour les API orientées locataires nécessitant des requêtes flexibles.

- Sécurité: Toutes les demandes d’API portent un JWT signé avec

locataire_iddans les réclamations. La limitation des taux est appliquée par locataire via des plans d’utilisation de la passerelle API.

Diagramme de dépendance au service

+------------------+

| Passerelle API |

+--------+---------+

|

+--------------+--------------+

| |

+---------------+ +------------------+

| Auth Service | | Tenant Resolver |

+---------------+ +--------+---------+

|

+--------------------------+-----------------------------+

| | |

+--------------+ +------------------+ +-------------------+

| Catalog Svc |<----->| Inventory Svc |<------->| Order Svc |

+--------------+ +------------------+ +-------------------+

|

+--------------------+

| Stock Movement Svc |

+--------------------+

Chaque service communique via HTTPS REST ou GRPC léger, avec SNS + SQS ou Eventbridge pour les déclencheurs asynchrones comme les mises à jour de stock, les modifications d’état de commande ou les alertes de stock faibles.

3. Couche d’intégration

- Messagerie asynchrone: EventBridge pour les événements de plate-forme interne (par exemple, Stock_Moved, Order_Placed). SNS / SQS pour les workflows déclenchés par les locataires comme la livraison Webhook ou les synchronisation ERP.

- API externes: Stripe (pour la facturation), Shopify / Magento (pour la synchronisation des stocks), NetSuite (pour la fusion financière / inventaire). Chacun est enveloppé dans un adaptateur et limité par le locataire.

- Webhooks: Les URL Webhook par locataire stockées dans les tables de configuration. Les livraisons sont réactivées avec un revers exponentiel via des files d’attente SQS Dead-Letter.

4. Couche d’interface utilisateur (frontage SaaS en option)

Si la plate-forme est expédiée avec une interface utilisateur hébergée, il s’agit d’une application React / Next.js déployée via Amplify ou S3 + CloudFront, en flèche avec la marque du locataire au moment de l’exécution.

- Auth: Utilise la connexion hébergée par cognito ou l’intégre dans le spa.

- RBAC: Contrôle les écrans et les champs que les utilisateurs peuvent accéder. Autorisations stockées dans les réclamations JWT.

- Vues multi-warehouse: Prend en charge le basculement entre les installations, les zones ou les hiérarchies de bacs.

Besoin d’une architecture personnalisée comme celle-ci?

Si vous concevez un produit SaaS avec des services conscients des locataires, des flux axés sur les événements ou une complexité au niveau des entrepôts – nous pouvons aider l’architecte, l’échelle ou la modernisation de votre backend.

Contactez-vous pour discuter des objectifs de conception de votre système.

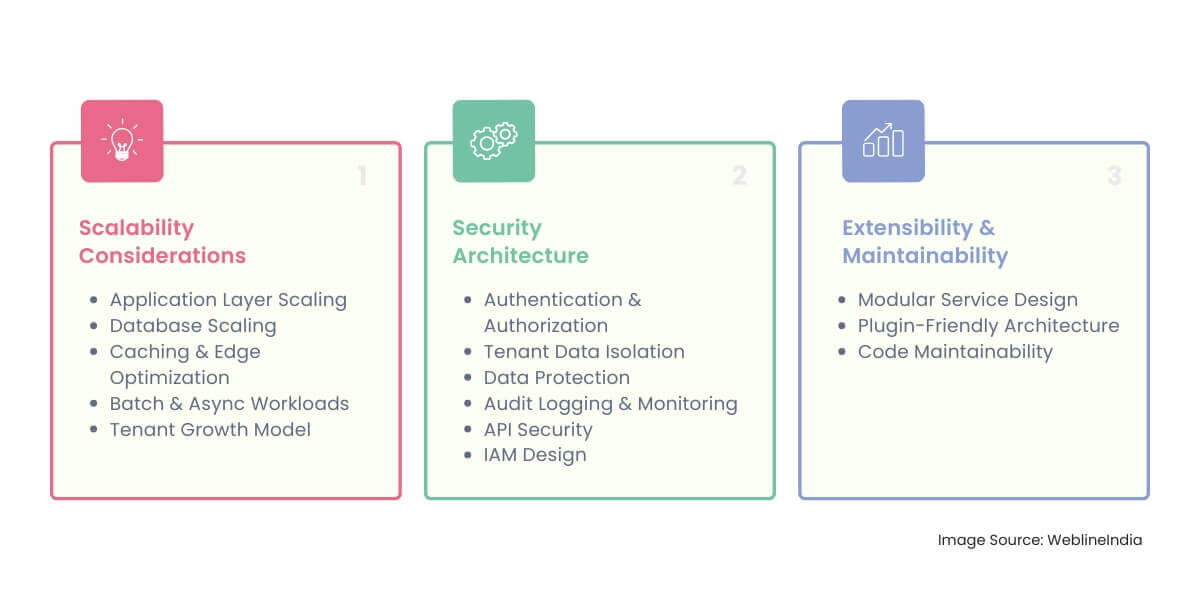

Considérations d’évolutivité

Échelle de couche d’application

- Services apatrides: Tous les services de base sont apatrides et évolutifs horizontalement. ECS Fargate Services Auto-échelle en fonction des seuils de CPU ou de mémoire. Lambda Services Scale par concurrence avec les limites spécifiques aux locataires mous et dures.

- Per-locataire étrangle: L’API Gateway applique les limites de taux spécifiques aux locataires à l’aide de plans d’utilisation. Cela protège les infrastructures partagées contre les voisins bruyants.

- Fanout axé sur les événements: Les mises à jour des stocks et les événements de commande sont émises à EventBridge, permettant à plusieurs services en aval (par exemple, les rapports, la journalisation d’audit, les intégrations) pour consommer des événements indépendamment sans couplage.

Échelle de base de données

- Lire les répliques: RDS utilise des répliques de lecture pour décharger les requêtes d’analyse et de rapport. Services Route les requêtes vers les répliques à l’aide de la logique de division de lecture / écriture.

- Partitionnement: Des tables à volume élevé comme

inventaireetStock_movementsont partitionnés parlocataire_idouwarehouse_id, selon les modèles d’accès. - Poolage de connexion: Le proxy RDS est utilisé pour gérer les limites de connexion, particulièrement importantes dans les environnements à base de Lambda avec des invocations rapides de dopage.

- Sharding (facultatif): Pour les grands locataires d’entreprise, le fragment croisé peut être introduit plus tard – distribuant certains locataires à volume élevé à des grappes de schéma dédiées.

Cache et optimisation des bords

- Redis Caching: AWS Elasticache (Redis) est utilisé pour mettre en cache la configuration statique ou fréquemment accessible (par exemple, les catalogues de produits, les zones d’entrepôt). Les clés sont préfixées avec

locataire_idpour empêcher les collisions. - CloudFront: Pour les actifs de l’interface utilisateur et les réponses API qui sont sûres à cache (par exemple, la recherche de produits), CloudFront améliore le temps de réponse et réduit la charge d’origine.

Tastes de travail par lots et asynchrones

- Découpler les travaux lourds: La réconciliation des stocks, les téléchargements en vrac et les exportations nocturnes sont traités de manière asynchrone via des travailleurs Lambda ou Fargate déclenchés par SQS.

- Files d’attente consacrées aux locataires: Les locataires à volume élevé peuvent se voir attribuer des files d’attente dédiées avec des paramètres de réessayer et de concurrence personnalisés pour isoler l’impact de la charge de travail.

Modèle de croissance des locataires

La plate-forme est conçue pour gérer un mélange de:

- Petits locataires: Données minimales, trafic léger, entrepôt unique – Utilisez des pools partagés avec des limites de taux de base.

- Mid-Market: Des dizaines d’utilisateurs, des intégrations API, des installations multiples – nécessitent des seuils accordés et des travailleurs asynchrones isolés.

- Entreprise: Charge lourde, flux de travail complexes, volumes de données dédiés – candidats à l’isolement aux niveaux de file d’attente DB ou de charge de travail.

La mise à l’échelle élastique est motivée par les mesures, mais la logique de provisioning peut également être motivée par niveaux de plan des locataires (par exemple, gratuit vs premium vs entreprise), qui déterminent les seuils de quota, l’allocation des ressources et les priorités de basculement.

Architecture de sécurité

Authentification et autorisation

- Authentification: AWS Cognito gère l’identité de l’utilisateur, les flux de connexion, les politiques de mot de passe et l’authentification multi-facteurs (MFA). Tous les JWT incluent un signé

locataire_idréclamer les demandes de portée. - Autorisation: Les services appliquent les deux Contrôle d’accès basé sur les rôles (RBAC) et Application de la politique au niveau du locataire. Les utilisateurs d’administration peuvent configurer des autorisations à grain fin par rôle (par exemple, restreindre la création de PO ou les mouvements de stock).

- AUTHER DE SERVICE-CAS DE SERVICE: Les services backend utilisent des rôles IAM ou des jetons STS de courte durée pour authentifier les appels interservices, en évitant les informations d’identification statiques.

Isolement des données du locataire

- Au niveau de l’application: Chaque parcours de requête, de mutation et de logique métier est portée à l’aide de l’appelant

locataire_id. Les gardes de middleware ou de stratégie de l’application garantissent qu’aucun accès inter-locataire n’est possible, même via des relations indirectes. - À la couche DB: L’isolement au niveau des lignes est appliqué via le

locataire_idcolonne sur chaque table partagée. Des politiques supplémentaires de sécurité (RLS) de niveau postgresql (RLS) peuvent être ajoutées si nécessaire pour une double application.

Protection des données

- Cryptage en transit: Toutes les API et connexions de base de données utilisent TLS 1.2+ appliquée par défaut.

- Cryptage au repos: RDS, S3, DynamoDB et Elasticache utilisent des clés de chiffrement gérées par KMS. Les fichiers sensibles de chaque locataire (par exemple, PO PDFS) peuvent utiliser des touches KMS séparées via les paramètres de chiffrement des objets de seau S3.

- Gestion des secrets: Les secrets ne sont jamais codés en dur – tous les jetons, les clés d’API et les informations d’identification sont stockés dans AWS Secrets Manager avec des contrôles d’accès IAM serrés.

Audit journalisation et surveillance

- Journaux d’activité des utilisateurs: Chaque action de l’utilisateur (par exemple, créant un PO, ajustement du stock) est enregistrée avec

ID de l'utilisateur,locataire_idet horodatage dans une table de journal d’audit centralisé. - Journaux API: Cloudtrail et API Gateway Access Journaux Capture IP, Méthode AUTH et Demandez les métadonnées. Les journaux sont filtrés et acheminés vers CloudWatch et S3.

- Détection d’anomalies: GuardDuty et AWS Config Rules Monitor pour une activité suspecte – par exemple, réutilisation des informations d’identification, abus de région ou escalade de privilèges.

Sécurité de l’API

- Étranglement: API Gateway s’applique à la limite du taux de location pour empêcher les tentatives DOS ou de force brute.

- Validation du schéma: Les demandes sont validées par schéma au bord pour empêcher les charges utiles mal formées ou les vecteurs d’injection.

- CORS & EN-TIRE: Seuls les domaines des locataires à la liste blanche sont autorisés pour l’accès à l’origine croisée; Les en-têtes stricts (HSTS, CSP, etc.) sont appliqués via une passerelle API et un cloudfront.

Déjà concevoir

- Principe du moindre privilège: Chaque lambda, la tâche ECS ou le service a un rôle étroitement portée – aucun accès large aux locataires non liés ou aux ressources mondiales.

- Isolement par locataire (facultatif): Pour les locataires à haut risque ou réglementés, vous pouvez éventuellement isoler les charges de travail dans des comptes AWS ou des VPC distincts à l’aide d’organisations AWS et de politiques SCP.

Extensibilité et maintenabilité

Conception de services modulaires

Le système suit une architecture modulaire basée sur le domaine avec des limites de service isolées. Chaque service possède ses données, sa logique commerciale et ses contrats. Cela facilite l’intégration de nouveaux membres de l’équipe, change de composants indépendamment ou étend des fonctionnalités sans régressions.

- Isolement du domaine: Les services sont regroupés par des domaines fonctionnels (inventaire, catalogue, commandes) – pas de logique métier partagée ou d’accès à DB à service croisé.

- Bibliothèques partagées: Les services publics communs (journalisation, analyse des autheurs, validation du schéma) sont abstraites en bibliothèques partagées versées par runtime (par exemple,

@ Inventaire / Common). - API bien définies: Toutes les limites de service sont exposées via OpenAPI (REST) ou SDL (GraphQL). Cela découple la mise en œuvre interne des contrats externes.

Architecture conviviale

Les locataires ont souvent besoin de personnalisation – qu’il s’agisse d’une prise en charge d’une norme régionale de code-barres, d’une mise en forme PO spécifique à l’ERP ou de règles d’entrepôt. Au lieu de codage rigide par logique, la plate-forme expose les points d’extension:

- Crochets de flux de travail: Les points de déclenchement définis (par exemple, «After Stock Rece reçoivent», «avant la soumission de PO») peut appeler des webhooks enregistrés par les locataires ou des gestionnaires de plug-in internes.

- Champs personnalisés: Les tables de métadonnées permettent des champs personnalisés dynamiques par entité (par exemple, ajouter «couleur» aux SKU pour les locataires de mode). Ceux-ci sont stockés comme JSONB avec des schémas par location.

- Moteur de configuration du locataire: Un service Sidecar ou un cache en mémoire fournit des paramètres spécifiques aux locataires, des drapeaux à bascule et des préférences injectées dans les services lors de l’exécution.

Maintenabilité du code

- Libellé et formatage: Tous les dépôts appliquent une analyse statique plus jolie, Eslint ou équivalente. La construction de pipelines échoue sur les violations.

- Propriété du code: Chaque service a une équipe ou un propriétaire dédié. Le code partagé est évalué par PR par les responsables de base pour éviter les régressions entre les domaines.

- Norme des normes de code: Les services suivent des principes solides, une responsabilité unique et une injection de dépendance partoutable.

Versegs de service

- API internes: Tous les appels de service à service internes utilisent des points de terminaison vers le version sémantique (

/ V1 /,/ V2 /), avec une compatibilité arrière pour au moins une version. - Schéma GraphQL: Utilise la dépréciation au niveau du champ, pas des changements de rupture difficiles. Les clients sont alertés avant qu’un champ ou un type ne soit supprimé.

- Contrats de webhook: Les modifications principales des versions de la version Webhook sont opt-in par locataire et versées explicitement dans les en-têtes de livraison.

Cette approche garantit que la plate-forme peut évoluer – en ajoutant de nouvelles fonctionnalités, en intégrant de nouveaux secteurs verticaux ou en s’adaptant à la technologie émergente – sans réécriture douloureuse ni complexité tentaculaire.

Conception pour une flexibilité à long terme?

Si vous planifiez une plate-forme multi-locataires qui doit évoluer entre les industries, les ensembles de fonctionnalités et les workflows spécifiques aux locataires – nous pouvons vous aider à le sauvegarder.

Contactez les conseils d’architecture ou le support pratique.

Optimisation des performances

Réglage de la requête de la base de données

- Indexation des locataires: Toutes les tables de trafic élevé (par exemple,

inventaire,ordres) sont indexés à l’aide de clés composites qui commencent parlocataire_id. Cela garantit un accès rapide tout en préservant l’isolement logique. - Vues matérialisées: Les agrégats fréquemment calculés (par exemple, le stock total par SKU par entrepôt) sont précomposés et rafraîchis progressivement.

- Analyse du plan de requête: Postgresql

EXPLIQUERLa sortie est utilisée régulièrement dans les environnements CI pour capter des régressions dans les plans de requête lors des changements de schéma.

Cache en mémoire

- Lookups chauds: Redis (via Elasticache) cache des éléments couramment accessibles comme les métadonnées du produit, les cartes de zone ou les paramètres du locataire. Les TTL varient en fonction de la mutabilité.

- Perspoir de noms par le locataire: Toutes les touches de cache sont préfixées avec

locataire_idpour éviter les saignements croisés. - Stratégie en écriture: Pour l’évolution rapide des données (par exemple, les quantités d’inventaire), Redis est mis à jour en parallèle avec les écritures de DB pour garder les lectures flambées rapidement.

Traitement et lots asynchrones

- Emplois d’importation en vrac: Les importations CSV ou JSON (produits, comptes de stocks) sont en file d’attente et traitées par lots par les travailleurs – réduisant la pression sur les API en direct.

- Webhook Fanout: Les intégrations sortantes sont gérées de manière asynchrone avec la logique de réessayer et les DLQS pour éviter de bloquer les flux de travail des commandes sur des échecs tiers.

- Réconciliation par lots: Les travaux planifiés comparent les actions attendues par rapport aux actions réelles dans les entrepôts et les écarts de journal pour l’examen des utilisateurs – pas d’impact d’exécution.

Limitation des taux et hygiène API

- Per-locataire étrangle: Les plans d’utilisation de la passerelle API appliquent une utilisation équitable et empêchent les locataires hyperactifs de dégrader les performances pour d’autres.

- Optimisation de la réponse: Seuls les champs requis sont retournés par point de terminaison; GraphQL permet aux clients de récupérer des charges utiles de données minimales.

- Pagination partout: Tous les points de terminaison de liste utilisent une pagination basée sur le curseur avec une commande cohérente pour empêcher les analyses et les délais d’expiration profonds.

Considérations de performance frontale

- Chargement de données paresseux: Évitez le chargement impatient des ensembles de données entiers – Frontend extrait les données paginées et demande les détails à la demande.

- Cache de contenu statique: Les actifs de l’interface utilisateur sont versés et mis en cache aux emplacements des bords CloudFront. Les buts sont invalidés uniquement lors du déploiement.

- Brandage des locataires au moment de l’exécution: Le frontend tire les logos, les couleurs et la configuration spécifiques aux locataires à partir d’un point de terminaison de l’API en cache pour éviter les versions par location.

UX en temps réel sans coût en temps réel

- Pollage vs WebSockets: La plupart des mises à jour en actions et en commandes sont gérées via un sondage à intervalle à intervalle, qui évolue mieux que WebSocket Infra persistant.

- Notifications push (facultative): Pour les événements critiques (par exemple, les stocks), SNS peut déclencher des alertes push sur le mobile ou les e-mails – déchargement de l’urgence de l’interface utilisateur.

L’objectif: UX rapide, charges de travail prévisibles, pas de pointes inattendues – et pas d’exercices d’incendie à 2 heures du matin lorsqu’un gros locataire inonde votre système avec des synchronisation SKU 10K.

Stratégie de test

Types de tests

- Tests unitaires: Tous les services maintiennent une couverture de test unitaire élevée, en particulier autour de la logique métier (par exemple, les règles d’ajustement des stocks, les transitions d’état de commande).

- Tests d’intégration: Les contrats de service à service, les interactions DB et le traitement de file d’attente / événement sont testés à l’aide d’infrastructures réelles dans des environnements de test isolés.

- De bout en bout (e2e): Les workflows clés du locataire (recevoir des actions → allocation → combler la commande) sont couverts via l’automatisation du navigateur (par exemple, dramaturge ou cyprès).

- Suites de régression: Les cas de test basés sur des instantanés protègent contre les modifications des charges utiles de webhook, du schéma GraphQL ou de la génération de rapports.

Tests de locataires

- Appareils à portée: Toutes les données de test sont générées avec Unique

locataire_idS pour valider l’isolement entre les requêtes, les API et les couches de mise en cache. - Scénarios multi-locataires: CI exécute des suites de test sur différentes configurations de locataires – plan gratuit, premium, multi-warehouse, etc.

- Tests des limites de sécurité: Les tests négatifs valident que les utilisateurs ne peuvent pas accéder ou muter les données d’un autre locataire – appliqués à la fois dans les couches de service et de DB.

Test de pipeline CI

Chaque service a son propre pipeline CI (actions GitHub, Gitlab CI ou CodePipeline) qui comprend:

- Lint → Unité → Intégration → Build séquence

- Validation du schéma contre les contrats OpenAPI / GraphQL

- Analyse d’image Docker pour les vulnérabilités (par exemple, TRIVY)

- Tagged builds déclenchez des exécutions E2E avant le déploiement vers la mise en scène

Test de chargement et de résilience

- Tests de chargement: Simuler les opérations d’entrepôt simultanées, les importations de PO en vrac et les tubes API en temps réel à l’aide de K6 ou du crique. Concentrez-vous sur la passerelle API, le débit d’écriture DB et le traitement des files d’attente.

- Test du chaos: Injectez l’échec dans les systèmes en aval (par exemple, la panne de l’API ERP) pour valider le comportement de réessayer, de secours et d’alerte.

- Test de saturation en file d’attente: Pipelines SNS / SQS de stress avec des milliers d’événements simultanés par locataire pour valider le découplage et la sécurité de la concurrence.

Stratégie d’environnement de test

- Environnements éphémères: Les demandes de traction font tourner les environnements d’aperçu isolés par branche avec des données de locataire grève. Utilisé pour les démos et la QA manuelle.

- Stadification partagée: La mise en scène multi-locataires reflète la production, avec une surveillance synthétique et des tests de contrat fonctionnant en continu.

Les tests dans un système multi-locataire ne sont pas seulement une question d’exactitude – il s’agit d’appliquer les limites, de valider les hypothèses d’échelle et de prouver que la diversité des locataires ne brisera pas l’infra partagée.

DevOps & CI / CD

Structure du pipeline CI / CD

Chaque microservice et le frontend (le cas échéant) est soutenu par son propre pipeline CI / CD, généralement implémenté avec des actions GitHub, GitLab CI ou AWS Codepiline. Les étapes de base ressemblent à ceci:

Git Push ↓ [CI] Lint & Static Analysis ↓ [CI] Unit & Integration Tests ↓ [CI] Docker Build & Scan ↓ [CD] Push to ECR ↓ [CD] Deploy to Staging (ephemeral env or shared) ↓ (Manual or Automated Gate) [CD] Deploy to Production (blue-green or canary)

- Artefacts: Toutes les builds génèrent des images Docker versionnées, des fichiers statiques (pour SPA) et des spécifications OpenAPI / GraphQL pour le suivi des modifications.

- Stratégie de recul: Les versions taguées sont réversibles en quelques minutes à l’aide de la version de déploiement Pinning ou Rollback de révision des tâches ECS.

Infrastructure comme code (IAC)

- Outillage: Terraform est utilisé pour provisionner les ressources AWS, organisées par module (par exemple,

api_gateway.tf,rds.tf,

eventbridge.tf). - État: L’état distant est stocké dans S3 avec le verrouillage d’état via DynamoDB. Chaque environnement (Dev, Staging, Prod) a des fichiers d’état isolés.

- Per-Renant Overrides: Pour les locataires d’entreprise nécessitant une infra isolée, les variables spécifiques à l’environnement (par exemple, cluster de base de données dédié) sont injectées via

terraform.tfvars.

Stratégies de déploiement

- Déploiements bleu-vert: Méthode par défaut pour les services backend. De nouvelles versions sont déployées dans un groupe cible de mise en scène et le trafic n’est réduit qu’après le passage des contrôles de santé.

- Sormes canaries: Utilisé pour les changements à fort impact ou expérimentaux – par exemple, la nouvelle logique de réconciliation des stocks – déployé d’abord sur un sous-ensemble de locataires.

- Fonctionnalités de caractéristiques: Le déploiement des fonctionnalités est conscient du locataire à l’aide de LaunchDarkly ou d’un moteur à bascule personnalisé. Permet les déploiements contrôlés, les tests A / B ou la déclenchement des fonctionnalités basée sur le plan.

Secrets et gestion de la configuration

- Secrets: Géré avec AWS Secrets Manager. Les jetons de courte durée (par exemple, STS) sont générés au moment de l’exécution dans la mesure du possible pour éviter les secrets à long terme.

- Config: La configuration par locataire est stockée dans DynamoDB et mise en cache dans Redis à l’exécution. La configuration au niveau de l’environnement est injectée via des définitions de tâches de magasin de paramètres ou d’ECS.

Expérience du développeur

- Dev local: Docker Compose Files Mimic Core Services (API, DB, files d’attente) avec des locataires de test à tête de série. Frontend AutoConfigures basée sur les paramètres locaux ou distants des locataires.

- Outillage: Les outils CLI permettent aux ingénieurs de tourner les locataires de test, de simuler des événements ou des données de semences – réduisant le temps de préparation des tests manuels.

- Aperçu des environnements: Chaque PR se déploie dans un environnement de courte durée accessible via une URL unique, avec des données de locataires prédéfinies. Utilisé pour les avis de conception et QA.

Le pipeline DevOps de la plate-forme est conçu pour hiérarchiser la vitesse, la sécurité et la simplicité en arrière. Les ingénieurs sont expédiés rapidement, sans casser les locataires ni se réveiller à 3 heures du matin.

Nous avons aidé les équipes à passer des scripts fragiles aux pipelines de qualité de production en toute confiance.

Surveillance et observabilité

Enregistrement

- Journalisation structurée: Tous les services émettent des journaux JSON structurés avec des champs standard comme

locataire_id,

request_id,service, etgravité. Cela permet un filtrage au niveau du locataire et un débogage rapide. - Agrégation centralisée: Les journaux à partir de la passerelle ECS, Lambda et API sont diffusés vers des journaux CloudWatch et éventuellement transmis à une pile de wapiti (Elasticsearch / Kibana) ou à la société de données pour le stockage et la visualisation à long terme.

- PII GRUPS: Le middleware désinfecte les champs sensibles avant la journalisation (par exemple, les e-mails d’utilisateur, les adresses, les données de paiement) – appliqué par un wrapper de journalisation partagé.

Métrique

- Métriques d’application: Des mesures commerciales personnalisées comme «commandes par locataire par heure», «latence de mouvement des actions» et «synchronisation PO défaillance» sont exposées via des exportateurs de Prométhée intégrés ou du format métrique intégré (EMF).

- Métriques d’infrastructure: Tous les services gérés par AWS (RDS, ECS, SQS) émettent des métriques CloudWatch natives. Les alertes sont définies pour les seuils sur CPU, la mémoire, les IOPS et la longueur de file d’attente.

- Signaux d’isolement des locataires: Les mesures sont étiquetées avec

locataire_idoulocataire_planpour détecter des voisins bruyants, des modèles de saturation ou des SLA dégradés à un niveau granulaire.

Tracé

- Traçage distribué: AWS X-Ray (ou Datadog APM, si préféré) requiert de bout en bout entre les services, les files d’attente et les appels de base de données. Chaque trace comprend

locataire_idetID de l'utilisateuren annotations pour la traçabilité. - ID de corrélation: UN

x-request-idL’en-tête est passé par tous les houblons de service, ce qui facilite le suivi du cycle de vie d’une demande sur les journaux et les traces.

Tableaux de bord

- Tableaux de bord mondiaux: Afficher la santé à l’échelle du système, les centiles de latence des API, les arriérés de file d’attente, le débit de base de données et les taux d’erreur.

- Tableaux de bord par locataire: Générer éventuellement les vues spécifiques aux locataires (en particulier pour les clients d’entreprise) qui mettent en évidence leurs modèles d’utilisation, leur volume d’erreur et leurs performances système.

Alerte

- Alertes de service: Les alarmes de cloudwatch ou les moniteurs deograves déclenchent des taux d’erreur élevés, des délais d’expiration ou une saturation des ressources. Les alertes sont acheminées vers les canaux Slack, PagerDuty ou Opsgenie.

- Détection de violation SLO: Objectifs au niveau du service prédéfinis (par exemple,

99,9% Disponibilité de l'API de commande) sont suivis et signalés. Les violations génèrent des billets ou des déclencheurs post-mortem. - Détection d’anomalies: La détection des anomalies CloudWatch surveille les courbes d’utilisation et les drapeaux des pics inhabituels dans le trafic, les erreurs ou la consommation de ressources par locataire.

Contrôles de santé et surveillance de la disponibilité

- Problèmes de Lipity & Readiness: Les services ECS exposent

/ HealthzPoints de terminaison pour la gestion de la santé au niveau des conteneurs. Les équilibreurs de chargement et les stratégies de déploiement reposent sur ceux-ci pour les déploiements sûrs. - Surveillance des tiers: Les points de fin de robot de disponibilité, Pingdom ou Statuscake Monitor, y compris les sous-domaines et les API de marque des locataires.

- Pages d’état: La page d’état du public (par exemple, hébergé sur statuspage.io) affiche une disponibilité en temps réel, des incidents et des métriques système – utile pour la transparence d’entreprise.

Dans un système multi-locataire partagé, l’observabilité n’est pas facultative. C’est votre seule défense contre les insectes latents, les régressions croisées et la dégradation silencieuse.

Compromis et décisions de conception

Schéma partagé vs schéma isolé

- Décision: Utiliser un schéma partagé, base de données unique modéliser avec

locataire_idappliqué à la couche d’application et de requête. - Pourquoi: Cela permet une gestion du schéma plus simple, évite la duplication des migrations et facilite l’analyse des locataires croisés. Il est rentable et maigre sur le plan opérationnel à grande échelle.

- Compromis: Nécessite une discipline extrême dans la portée des requêtes et le filtrage des locataires. Les erreurs peuvent entraîner des fuites de données. Les locataires lourds peuvent encore nécessiter une isolation des performances (manipulée via le partitionnement ou les répliques).

Hybride PostgreSQL + DynamoDB

- Décision: Utilisez PostgreSQL pour la cohérence relationnelle et les jointures complexes; DynamoDB pour les métadonnées à grande vitesse / l’accès à la configuration et les paramètres des locataires distribués.

- Pourquoi: De nombreuses entités (par exemple, SKUS, Ordres) exigent une logique relationnelle. Mais les paramètres spécifiques aux locataires, les drapeaux à bascule et les préférences des utilisateurs sont mieux servis par des lectures de valeur clé.

- Compromis: Offres opérationnelles dans la gestion de deux moteurs de persistance. Risque de désynchronisation si l’orchestration d’écriture est bâclée.

Architecture axée sur l’événement

- Décision: Utilisez Eventbridge + SNS / SQS pour le traitement asynchronisé des événements tels que les modifications d’inventaire, les reçus PO et les webhooks de commande.

- Pourquoi: Garde les services de manière lâche. Permet des tentatives indépendantes, une mise à l’échelle horizontale des consommateurs et une extension plus facile via des auditeurs d’événements.

- Compromis: Cohérence éventuelle. L’observabilité devient plus difficile – Besoin des ID de traçage et de corrélation distribués pour déboguer les flux multi-HOP.

Isolement multi-locataire vs par locataire

- Décision: Tous les locataires partagent l’infra par défaut; Les locataires à haut débit peuvent être éventuellement isolés dans la base de données ou la couche de file d’attente.

- Pourquoi: Cela équilibre le coût et la simplicité. La plupart des locataires ne justifient pas leur propre infra. Les locataires d’entreprise qui le font peuvent toujours être sculptés via des remplacements pilotés par la configuration.

- Compromis: Ajoute de la complexité dans l’approvisionnement et le déploiement de la logique. Tous les services ne sont pas conscients de l’isolement – il faut de meilleurs outils pour gérer proprement les exceptions.

GraphQL vs repos

- Décision: Utiliser le repos pour les appels de service internes; GraphQL pour les API externes consommées par les fronts ou les systèmes de locataires.

- Pourquoi: Le reste simplifie la décomposition et la documentation du service. GraphQL offre aux locataires la flexibilité de l’interrogation des formes de données complexes (par exemple, des vues de stock imbriquées).

- Compromis: GraphQL ajoute la courbe d’apprentissage et la complexité autour des autorisations, de la pagination et de l’évolution du schéma. Nécessite une orchestration de passerelle et des gardes stricts au niveau du terrain.

Crochets du plugin vs logique codée en dur

- Décision: Ajoutez la prise en charge de WEBHook / Plugin Hook aux workflows clés au lieu de codage rigide Per-Renant Logic.

- Pourquoi: Donne une flexibilité sans créer d’échelles IF-Else par locataire. Gardez le noyau propre et permet à la logique personnalisée d’évoluer indépendamment.

- Compromis: Les plugins peuvent échouer ou introduire la latence. Vous avez besoin de garde-corps – limites de délai d’expiration, de tentatives et logique de secours sûre.

Ce qui a été délibérément évité

- Par défaut par défaut par défaut: Trop coûteux, lent à provisionner, difficile à maintenir à grande échelle. Réservé aux clients VIP uniquement.

- WebSockets en temps réel: Différé pour V2 – Les notifications de sondage et de push couvrent la plupart des besoins sans nécessiter une socket persistante infra et une complexité de mise à l’échelle.

- Multi-région dure: Démarré avec des sauvegardes HA + à une seule région. Les écritures multi-régions et le routage de résidence de données nécessitent une segmentation des locataires plus forte – différée jusqu’à nécessaire.

Chaque décision a été prise avec l’échelle, la vitesse de l’équipe et la diversité des locataires à l’esprit. Le système est intentionnellement flexible mais non sur la réception.

Ce que cette architecture va bien

La conception d’une plate-forme de gestion des stocks multi-locataires ne consiste pas seulement à cocher des boîtes sur l’utilisation des services AWS – il s’agit d’orchestrer l’échelle, la flexibilité et la sécurité pour un ensemble diversifié de clients, tous traversant une infrastructure partagée.

Cette architecture touche l’équilibre entre rentabilité et isolement des locataires. Il permet aux petits et moyens clients de coexister avec les géants de l’entreprise, sans friction. Il fournit une structure si nécessaire – limites de service, RBAC, contrats d’événements – mais maintient la place pour la croissance organique via des plugins, des remplacements de configuration et des travailleurs asynchrones.

Certains des aspects les plus forts de la conception:

- Strict, appliqué Isolement des données du locataire À chaque couche – de la base de données à l’API aux journaux.

- Robuste épine dorsale motivée par des événements pour l’extensibilité et le découplage.

- Architecture de service modulaire avec des limites de déploiement et du versioning propres.

- Modèle de location flexible – partagé par défaut, isolé en cas de besoin.

- Pipeline CI / CD pour les développeurs avec des environnements de test et des indicateurs de fonction.

Bien sûr, aucun système n’est statique. Ce qui est solide aujourd’hui pourrait se casser sous une échelle 10x ou un nouveau cas d’utilisation demain. Zones à surveiller à mesure que vous grandissez:

- Blood d’événement: Trop d’auditeurs ou des contrats peu clairs entraîneront éventuellement une dérive ou un couplage involontaire.

- Échelle d’analyse: Plus de locataires signifie plus de bruit de requête – charges de travail analytiques de segment des premiers opérationnels.

- Expansion globale: Vous devrez éventuellement faire face aux locataires multi-régions et sensibles à la latence et aux lois sur la souveraineté des données.

La fondation, cependant? Rock solide. Cette architecture évolue linéairement, soutient l’agilité et permet à votre équipe de construire en toute confiance – tout en donnant aux locataires la sensation d’un système construit juste pour eux.

Besoin d’aide architeser quelque chose de similaire?

Que vous lanciez un nouveau produit SaaS, que vous modernisez un monolithe hérité ou que vous fassiez la mise à l’échelle pour soutenir des milliers de locataires – nous pouvons aider à la concevoir correctement.

Tendez la main pour discuter de la multi-location, de l’AWS et de l’architecture propre qui dure.

Questions fréquemment posées (FAQ)

1. Comment construire un SaaS multi-locataire?

Pour construire une plate-forme SaaS multi-locataires, commencez par un modèle de location clair (DB partagé, DB isolé ou hybride), implémentez l’authentification et l’autorisation conscientes des locataires et concevez vos services pour appliquer des limites strictes de locataires. Utiliser une infrastructure comme AWS Cognito, API Gateway et IAM pour le contrôle de l’identité et les données de partition à l’aide d’unlocataire_idà travers votre schéma. Une architecture modulaire bien structurée assure l’évolutivité et l’extensibilité au niveau du locataire.

2. Comment créer une base de données multi-locataires?

Une base de données multi-locataires peut être créée en utilisant l’un des trois modèles: le schéma partagé (tous les locataires dans les mêmes tables, étendus parlocataire_id), schéma par locataire (chaque locataire a son propre schéma), ou la base de données par locataire. Pour le SaaS à grande échelle, le modèle de schéma partagé est souvent préféré pour la rentabilité et la simplicité opérationnelle. Utilisez des index composites, la sécurité au niveau des lignes (RLS) et l’accès de la requête dans l’application de l’isolement des locataires.

3. Comment créer une application basée sur le SaaS multitinnant en microservice?

Pour créer une application SaaS multi-locataire à l’aide de microservices, définissez des limites de service claires (inventaire, commandes, facturation), rendez les services sans état et appliquez l’isolement des locataires à la couche de données et de service. Chaque microservice doit valider

locataire_idà partir du contexte de la demande et évitez l’accès croisé. Utilisez un fournisseur d’authentification partagé (par exemple, AWS Cognito), le routage du locataire et la messagerie asynchrone (comme SNS / SQS) pour découpler les flux.

4. Quels sont les 4 types de système de gestion des stocks?

Les quatre principaux types de systèmes de gestion des stocks sont les suivants: (1) l’inventaire perpétuel, qui se met à jour en temps réel; (2) l’inventaire périodique, mis à jour à intervalles; (3) des systèmes à base de codes à barres, utilisés dans le commerce de détail et l’entreposage; et (4) les systèmes basés sur RFID, qui utilisent des balises et des capteurs. Les plates-formes SaaS modernes mélangent souvent plusieurs types, selon les besoins de l’industrie.

5. Pouvez-vous construire le SaaS sans codage?

Oui, il est possible de créer un produit SaaS de base sans codage à l’aide de plates-formes sans code comme Bubble, Glide ou OutSystems. Cependant, pour les SaaS évolutifs, sécurisés et multi-locataires (en particulier impliquant des workflows d’inventaire, ERP ou logistique), le code personnalisé est essentiel. Le non-code est idéal pour les MVP, mais les systèmes de qualité de production nécessitent un contrôle architectural.

6. Quelle est la meilleure architecture pour le SaaS multi-locataire sur AWS?

La meilleure architecture AWS pour les SaaS multi-locataires comprend une combinaison d’API Gateway, AWS Cognito, ECS / Lambda Services, RDS pour les données structurées, DynamoDB pour les métadonnées et S3 pour le stockage d’objets – tous dans la portée par locataire. Utilisez Eventbridge et SNS / SQS pour le traitement asynchrone et CloudWatch pour l’observabilité.

7. Comment isolez-vous les données des locataires dans une base de données partagée?

Les données des locataires sont isolées dans un schéma partagé en utilisant un locataire_idColonne sur chaque ligne, appliquée via des gardes au niveau de l’application, des index de base de données et une sécurité (RLS) au niveau des lignes postgresql éventuellement. Les API et les services doivent toujours étendre les requêtes au locataire authentifié.

8. Comment gérez-vous la configuration spécifique au locataire en SaaS?

Stocker les configurations spécifiques aux locataires (comme les workflows, les drapeaux d’interface utilisateur, les seuils) dans un magasin de métadonnées tels que DynamoDB ou PostgreSQL JSONB. Utilisez un service de configuration ou un cache en mémoire pour injecter cela lors des services entre les services. Cela permet les personnalisations par location sans code de code.

9. Quel pipeline CI / CD est le meilleur pour les plates-formes multi-locataires?

Le meilleur pipeline CI / CD pour les SaaS multi-locataires comprend des workflows de construction / test isolés par service, des environnements de test de locataire, des déploiements canariés et des drapeaux de fonctionnalité. Des outils comme GitHub Actions + Terraform + ECR + ECS fournissent une base robuste.

10. Comment évoluez-vous une application SaaS multi-locataire?

Échelle horizontalement en gardant les services sans état, bases de données partitionnées et charges de travail découplées via des modèles axés sur les événements. Utilisez des limites de taux par location, des couches de mise en cache et des répliques de lecture. Pour les locataires lourds, isolez au niveau de la base de données ou de la file d’attente.

Testimonials: Hear It Straight From Our Customers

Our development processes delivers dynamic solutions to tackle business challenges, optimize costs, and drive digital transformation. Expert-backed solutions enhance client retention and online presence, with proven success stories highlighting real-world problem-solving through innovative applications. Our esteemed clients just experienced it.